BERT的逆袭:揭秘如何在无需额外训练下释放语言模型的生成能力

BERT的逆袭:揭秘如何在无需额外训练下释放语言模型的生成能力

zenRRan

发布于 2024-06-18 17:00:44

发布于 2024-06-18 17:00:44

论文:BERTs are Generative In-Context Learners链接:https://arxiv.org/pdf/2406.04823

1. 这篇文章想解决什么问题?

文章探讨了掩码语言模型(MLMs,例如BERT和DeBERTa)在上下文学习(in-context learning)方面的能力,挑战了普遍观点,即这种能力在这些模型中不会“显现”。作者意图证明,即使没有额外的训练,MLMs也能够展现出与著名的GPT-3相当的生成能力。

2. 论文用什么方法解决什么问题?

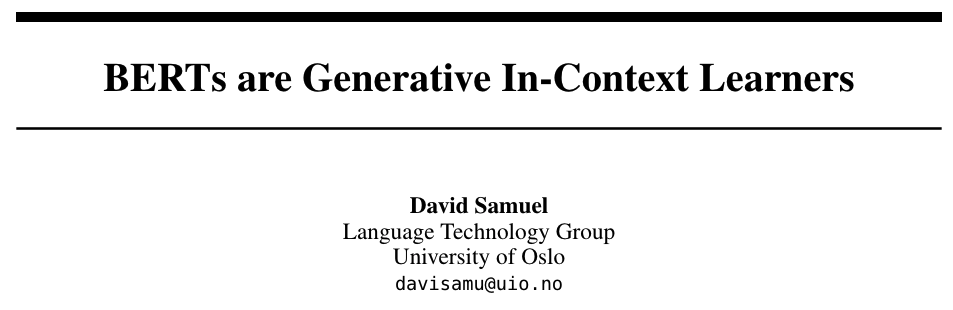

- 论文提出了一种简单的推理技术,使得DeBERTa能够在没有任何额外训练的情况下作为生成模型运行。

- 通过修改输入令牌序列的方式,使得预训练的掩码语言模型能够用于文本生成和文本排名任务,而不需要进行额外的训练或微调。

- 论文还探讨了掩码语言模型和因果语言模型在不同任务类别上的表现差异,并提出了混合训练方法的潜力。

3. 论文做了哪些实验?

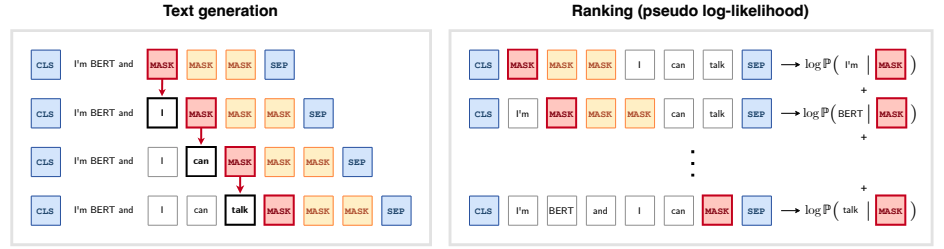

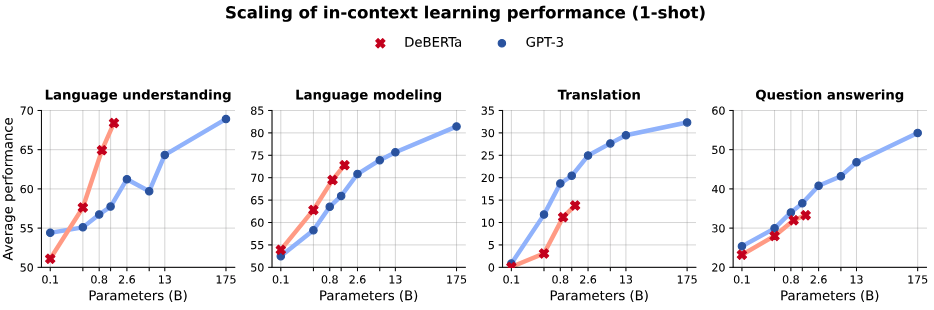

- 作者使用DeBERTa模型,并将其与GPT-3进行了比较分析,涵盖了多种自然语言处理(NLP)任务,包括语言理解、语言建模、机器翻译和问答。

- 实验包括了对不同规模的DeBERTa模型(从0.1B到1.4B参数)在单次(1-shot)学习情况下的表现进行了评估。

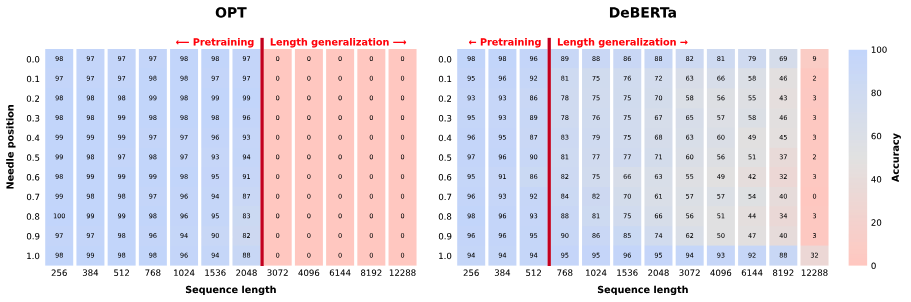

- 还包括了“针堆中找针”(needle in a haystack)的测试,以评估模型对长序列的泛化能力。

4. 论文或者方法有哪些局限性,未来工作是什么?

- 局限性包括:

- MLMs在实际应用中由于不能缓存中间自注意力的键和值向量,因此在时间复杂度和内存复杂度上存在限制。

- 在机器翻译任务中,DeBERTa的表现不如GPT-3,部分原因可能是由于其训练语料库相对较小且干净,缺乏多语言数据。

- 在闭卷问答任务中,MLMs的表现较差,这可能与它们在训练期间能够从丰富的上下文中检索世界知识有关,而不需要将知识存储在学到的权重中。

- 未来工作可能包括:

- 通过在更大和更多样化的文本语料库上预训练、增加模型参数数量和使用更长的上下文长度来提高DeBERTa的结果。

- 探索将因果语言建模与掩码语言建模的优势结合起来的混合模型,以实现更好的上下文学习能力。

> kimi+人工共同完成。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-06-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录