如何在使用Q-Learning时使用theano计算神经网络的梯度

如何在使用Q-Learning时使用theano计算神经网络的梯度

提问于 2016-04-01 20:09:03

我正在尝试使用一个标准的全连接神经网络作为Q-Learning中动作值的基础。我使用http://deeplearning.net/tutorial/mlp.html#mlp作为参考,特别是这一行:

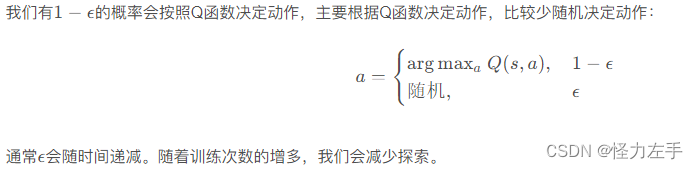

gparams = [T.grad(cost, param) for param in classifier.params]我想使用Q-Learning策略控制方法(如http://webdocs.cs.ualberta.ca/~sutton/book/ebook/node65.html中所述)计算与最后一个操作相关联的输出单元的误差,并将其他输出误差设置为零。

如何使用Theano的grad函数将误差反向传播到神经网络的其余部分?

回答 1

Stack Overflow用户

发布于 2016-04-09 13:24:18

神经网络只是Q函数参数化的一种可能方式。在这种情况下执行梯度下降的方式在Sutton和Barto的这本书的section中进行了解释。只需将神经网络的权重视为参数的向量。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/36365013

复制相关文章

点击加载更多

相似问题