使用rtrim()时Spark中的字符串连接问题

提问于 2016-11-15 22:38:40

在PySpark SQL查询过程中,我面临一个特殊的或未知的连接问题。

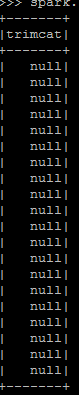

spark.sql("select *,rtrim(IncomeCat)+' '+IncomeCatDesc as trimcat from Dim_CMIncomeCat_handled").show() 在这个查询中,IncomeCat和IncomeCatDesc字段都保持字符串类型值,所以从逻辑上说,我认为它会连接起来,但我得到的结果字段为null。

其中可实现的结果将是‘14100 abcd’,其中14100是IncomeCat部分和IncomeCatdesc部分。我也在IncomeCat字段上尝试过显式转换。

spark.sql("select *,cast(rtrim(IncomeCat) as string)+' '+IncomeCatDesc as IncomeCatAndDesc from Dim_CMIncomeCat_handled").show() 但我也得到了同样的结果。我是不是缺了点什么。请帮我解决这个问题

回答 1

Stack Overflow用户

回答已采纳

发布于 2016-11-15 22:48:01

Spark不会覆盖字符串的+操作符,因此您使用的查询不会表示连接。如果您看一下基本的示例,您将看到正在发生的事情:

spark.sql("SELECT 'a' + 'b'").explain()== Physical Plan ==

*Project [null AS (CAST(a AS DOUBLE) + CAST(b AS DOUBLE))#48]

+- Scan OneRowRelation[]假设这两个参数都是数字的,通常情况下,结果将是未定义的。当然,它适用于可以转换成数字的字符串:

spark.sql("SELECT '1' + '2'").show()+---------------------------------------+

|(CAST(1 AS DOUBLE) + CAST(2 AS DOUBLE))|

+---------------------------------------+

| 3.0|

+---------------------------------------+要连接字符串,可以使用concat

spark.sql("SELECT CONCAT('a', 'b')").show()+------------+

|concat(a, b)|

+------------+

| ab|

+------------+或concat_ws

spark.sql("SELECT CONCAT_WS('*', 'a', 'b')").show()+------------------+

|concat_ws(*, a, b)|

+------------------+

| a*b|

+------------------+页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/40625576

复制相关文章

相似问题