一个人就是一支整编剧组!首个“统一导演”模型发布:字节UniMAGE,让脑洞原地变大片

一个人就是一支整编剧组!首个“统一导演”模型发布:字节UniMAGE,让脑洞原地变大片

AI生成未来

发布于 2026-01-13 16:24:46

发布于 2026-01-13 16:24:46

作者:Jiaxu Zhang等

解读:AI生成未来

论文链接:https://arxiv.org/pdf/2512.23222 项目链接:https://kebii.github.io/UniMAGE/

亮点直击

- 概念:UniMAGE体现了“统一导演模型” 的概念,整体协调叙事逻辑和视觉构图,将用户意图与多模态剧本联系起来,实现创意音视频生成。

- 技术:UniMAGE 采用交错概念学习和解耦专家学习,结合情境中 ID 提示和预上下文剧本拆分策略,以增强长上下文序列中的视觉一致性和叙事连贯性。

- 性能:UniMAGE 在长篇、多场景剧本创作中展现出强大的能力和泛化性,与现有基于代理和统一模型相比,实现了卓越的叙事连贯性、角色稳定性和图像一致性。

总结速览

解决的问题

- 现有的 AI 驱动视频创作系统通常将剧本起草和关键镜头设计视为两个独立任务,前者依赖大型语言模型,后者依赖图像生成模型,导致叙事逻辑和视觉一致性有限。

- 当前模型主要关注短单镜头视频的视觉保真度和时间连贯性,限制了它们传达长篇叙事的能力。

- 即使是先进的商业系统,如 Veo 3 和 Sora 2,也高度依赖结构化的提示,并且通常局限于短单镜头视频。它们缺乏规划和维护多镜头、叙事驱动序列连贯性的能力。

提出的方案

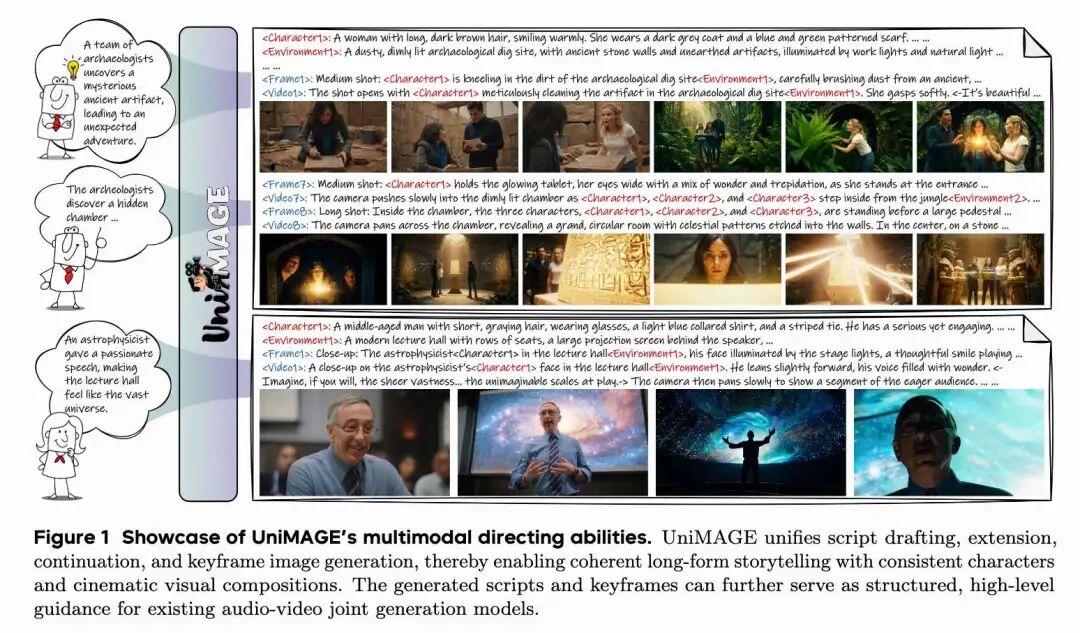

- 本文提出了 UniMAGE,一个统一的导演模型,旨在将剧本起草和关键镜头设计这两个任务统一在一个框架内,因为逻辑推理和想象力思维都是电影导演的基本素质。

- UniMAGE 旨在弥合用户提示与结构化剧本之间的鸿沟,从而使非专业用户能够利用现有的音视频生成模型,制作出长文本、多镜头影片。

- UniMAGE 作为一个统一的导演模型,通过多模态剧本生成,将用户的想象力与长文本、电影般的音视频创作联系起来。

应用的技术

- Mixture-of-Transformers (MoT) 架构:UniMAGE 采用 MoT 架构来统一文本和图像生成。

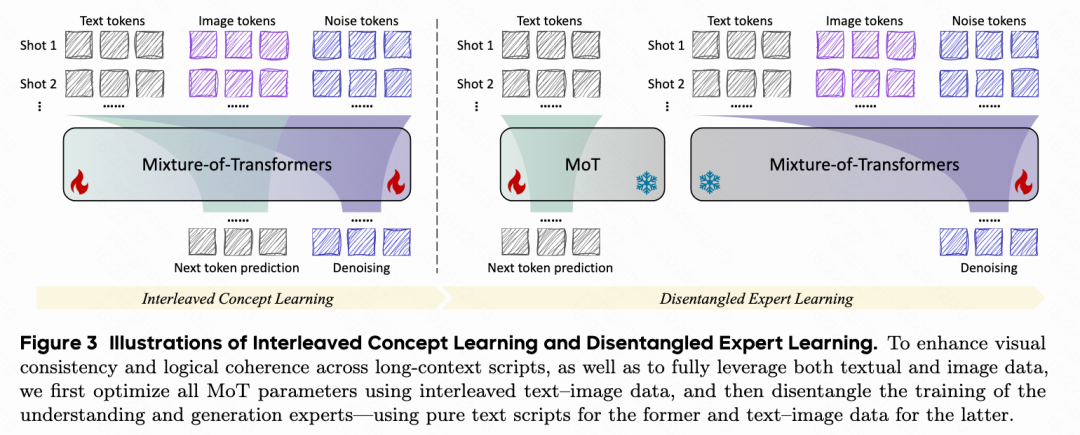

- “先交错,后解耦”训练范式:为了增强叙事逻辑和关键帧一致性,本文引入了这种范式。

- 交错概念学习 (Interleaved Concept Learning):利用交错的文本-图像数据,促进模型对剧本更深层次的理解和富有想象力的解释。

- 解耦专家学习 (Disentangled Expert Learning):将剧本编写与关键帧生成解耦,从而在故事讲述中实现更大的灵活性和创造力。

达到的效果

- UniMAGE 在开源模型中取得了SOTA性能。

- 它能够生成逻辑连贯的视频剧本和视觉一致的关键帧图像。

- 模型能够处理长文本、多镜头影片的制作。

架构方法

UniMAGE 采用了一种新颖的 Mixture-of-Transformers (MoT) 架构,它将文本和图像生成统一在一个框架中。该模型由两个 Transformer 专家组成:一个用于多模态理解,另一个用于图像生成。相应地,它使用两种类型的视觉编码器,一个面向理解的编码器(ViT)和一个面向生成的编码器(VAE)。两个 Transformer 专家通过共享的自注意力层处理相同的 token 序列。对于文本 token 预测,UniMAGE 遵循 Next Token Prediction (NTP) 范式,利用自回归建模的既定优势。对于视觉 token 预测,它采用 Rectified Flow,与视觉生成中的主流实践保持一致。

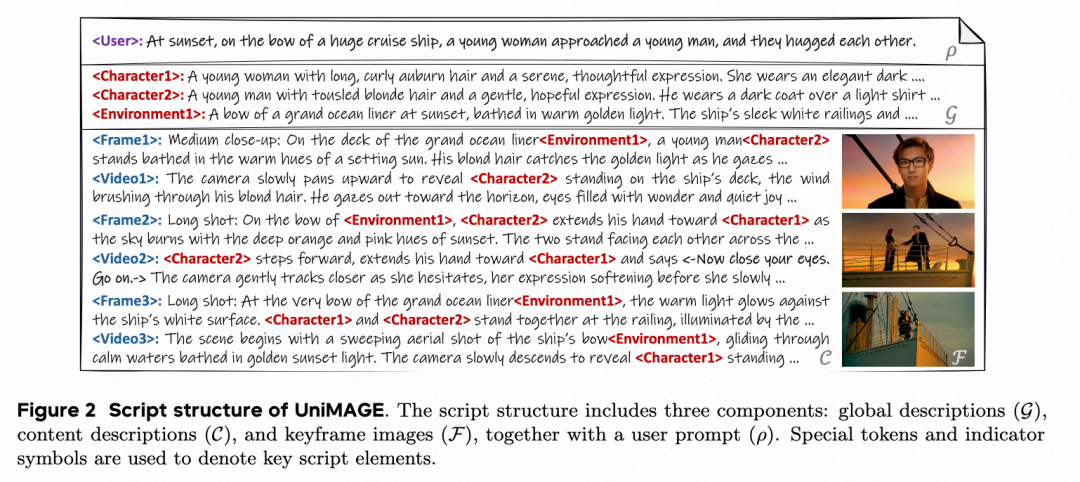

剧本结构

如下图2所示,UniMAGE 中使用的剧本结构由三个主要组件构成:全局描述 G、内容描述 C 和关键帧图像 F,以及用户提示 ρ。本文设计了一组特殊 token 来表示剧本中的每个元素,包括 <User>、<CharacterN>、<EnvironmentN>、<FrameN> 和 <VideoN>,其中 N 表示索引。当全局描述中定义的角色或环境出现在内容描述中时,使用相应的特殊 token 来指示主体在场景中的出现。例如,“在豪华邮轮的甲板上<Environment1>,一个年轻人<Character2> . . . ”。这些特殊 token 有助于模型准确识别角色和环境,同时保持剧本的简洁和结构一致性。内容描述进一步分为两个互补的层次。帧描述捕捉关键时刻的静态视觉布局,例如摄像机位置、灯光和角色布局。视频描述则侧重于时间性和叙事性方面,包括对话、情节发展和动作。此外,本文引入了指示符 <- -> 来表示角色对话和环境音效,使得相应的音频内容可以在后续阶段轻松检索。例如,“<-现在闭上眼睛。继续。->”。为了适应不同的用户输入格式,本文定义了四种不同的用户提示风格,在训练过程中随机采样。

交错概念学习

本文使用 Bagel 中预训练的权重初始化 UniMAGE 的 MoT 模型,这为统一多模态理解和生成提供了强大的基础能力。然而,与 Bagel 侧重于多步图像编辑的训练格式不同,UniMAGE 需要在理解前置叙事的基础上生成图像和剧本文本。此外,剧本数据的长文本特性超出了基础模型的容量,因此需要交错概念学习策略来实现连贯的叙事和视觉生成。

如下图3左侧所示,通过上述定义的剧本结构,剧本可以组织为交错的文本-图像数据。首先执行交错概念学习,使 MoT 模型能够以交错的方式生成文本和图像,从而促进对冗长、上下文丰富的剧本的更深入理解。这个训练阶段在概念上类似于 Chain-of-Thought 策略,其中文本内容作为模型的推理过程,随后根据前置叙事上下文生成图像。在此阶段,两个 Transformer 专家的所有参数都联合优化,允许生成结果影响模型的文本理解,反之亦然。

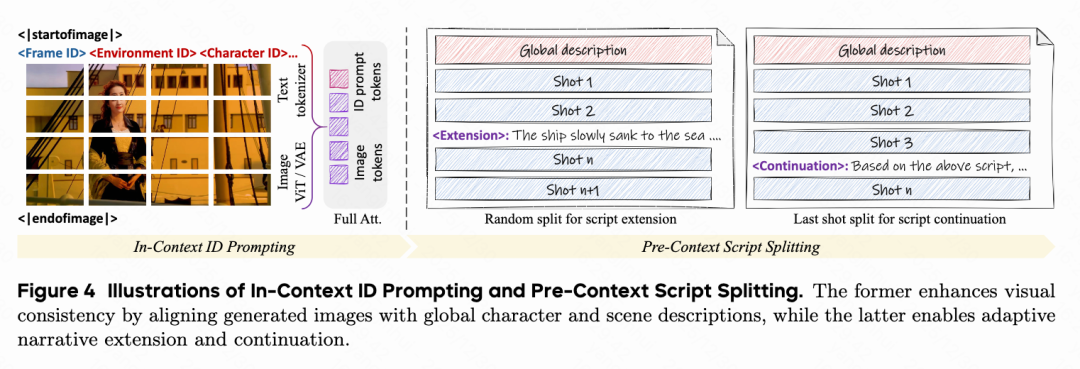

为了解决多角色和多场景的视觉一致性问题,本文提出了情境中 ID 提示 (In-Context ID Prompting) 方法。如下图4左侧所示,在用于理解的 ViT token 和用于图像引用的 VAE token 中,插入特殊的文本 token 来指示帧 ID,以及图像中出现的角色和环境 ID。在每个图像的 ViT 或 VAE token 及其相应的特殊 token 之间应用完全注意力。这种情境中 ID 提示策略,结合剧本结构中定义的特殊 token,有效地保留了剧本文本和生成图像之间的长程关联,确保了整个叙事中一致的视觉身份和场景连续性。

解耦专家学习

交错概念学习阶段赋予了 UniMAGE 对整体剧本的全面而连贯的理解。然而,这种交错生成策略不可避免地限制了模型在内容创作方面的灵活性,特别是对于剧本扩展和续写等任务,模型必须动态适应新的用户提示或无缝扩展现有叙事上下文。此外,获取逻辑一致的多镜头文本-图像数据本身就具有挑战性,这限制了模型从交错数据中充分学习长篇叙事逻辑的能力。因此,本文引入了解耦专家学习策略。

如上图3右侧所示,在这个训练阶段,本文将剧本内容生成与交错关键帧生成解耦,并使用纯文本剧本优化理解 Transformer 专家。同时,生成 Transformer 专家使用交错文本-图像数据进一步优化,其中理解分支通过停止梯度冻结。此外,本文将文本-图像对纳入训练过程,以进一步提高视觉保真度。通过这种策略,剧本逻辑和图像质量都得到了有效提升,因为模型可以充分利用超越交错剧本数据的异构多模态训练数据。最后,为了实现剧本扩展和续写,本文引入了预上下文剧本拆分策略。

预上下文剧本拆分:基于纯文本剧本,本文随机插入新的用户或系统提示来模拟两种类型的创作需求。第一种是基于提示的剧本扩展,如上图4中间部分所示。具体来说,本文将一个完整剧本分成两部分,并在剧本中插入指示 token <Extension>,后跟一个新的用户提示,让模型学习如何从给定提示中连贯地扩展现有叙事。新的用户提示通过使用 Qwen 2.5 总结剧本的第二部分生成。第二种是情境中剧本续写,如上图4右侧所示。在这种情况下,本文在剧本的最后一镜头之前插入指示 token <Continuation>,后跟一个系统提示,使模型能够在推理过程中无限期地续写剧本。

UniMAGE 的推理

在推理过程中,本文保持文本和图像的解耦生成过程。具体来说,UniMAGE 首先根据用户提示生成多镜头文本剧本。然后,用户可以使用新的提示扩展叙事,或根据之前生成的内容连续生成后续镜头。最后,完整的剧本被分割成单独的镜头,并以交错的方式生成相应的关键帧图像。这种统一而解耦的策略——单个模型处理两种模态,同时分离文本和图像的生成过程——有效地确保了剧本的逻辑连贯性和生成图像的视觉一致性。因此,UniMAGE 可以生成更长、更连贯的叙事,同时缓解情节重复和图像失真等问题。

实验

本文进行了广泛的实验,以验证 UniMAGE 的有效性,包括定性评估和定量评估。

数据集

为了支持 UniMAGE 的统一多模态训练范式,本文构建了一个大规模且多样化的数据集,其中整合了多镜头剧本、长文本叙事和高质量的文本-图像对。该数据集由三个互补的子集组成,每个子集都与 UniMAGE 中的特定学习目标对齐:

- 多镜头文本-图像剧本(450k 序列):本文从广泛的开源电影内容、短片和纪录片中收集了多镜头视频。每个视频都使用视觉场景过渡检测分割成连贯的镜头。对于每个镜头,本文采用 Gemini 2.5 Pro 来生成详细的文本注释。该子集构成了交错概念学习的骨干,使 UniMAGE 能够建模多模态推理并维护文本-图像交错序列的全局一致性。

- 多镜头文本剧本(250k 样本):为了进一步增强超越视觉基础数据的长篇叙事能力,本文整理了一个大型文本剧本语料库。这些剧本使用 Qwen 2.5 重新组织和结构化,以适应 UniMAGE 的分层剧本格式。这个纯文本子集对于解耦专家学习至关重要,使理解专家能够学习丰富的叙事逻辑、镜头过渡和对话惯例。

- 单镜头文本-图像对(250k 样本):为了提高图像质量和保真度,特别是对于角色渲染和场景构图,本文整理了一组大型单镜头图像。每张图像都使用 Gemini 2.5 Pro 重新标注,以获得详细的、剧本结构化的描述。该子集在解耦专家学习阶段用于生成专家的训练,以提高视觉精度、多样性和可控性。

实施细节

UniMAGE 是基于 BAGEL 的开源框架实现的,该框架提供了统一的 MoT 架构作为多模态理解和生成的基础。所有实验都遵循 BAGEL 的标准化训练流程和并行策略。在交错概念学习阶段,仅使用多镜头文本-图像剧本数据,学习率为 1e-5,总训练步数为 30,000。在随后的解耦专家学习阶段,使用整个数据集,学习率相同为 1e-5,训练步数为 10,000。值得注意的是,在此阶段,仅使用纯文本样本来优化理解分支,而在优化生成分支期间,文本 token 与计算图分离,以防止梯度传播并确保解耦学习。

评估指标

本文进行了定性和定量评估,以全面评估 UniMAGE 在叙事连贯性、角色一致性和视觉质量方面的性能。定性结果侧重于长篇故事讲述场景,展示了从不同用户提示生成的多个镜头剧本和相应的关键帧。定量结果在公共基准 ViStoryBench 上获得,该基准评估了各种叙事结构、视觉风格和角色设置下的故事可视化模型。本文报告了六项指标:风格相似性 (CSD)、角色识别相似性 (CIDS)、提示依从性 (Alignment)、舞台角色计数匹配 (OCCM)、图像质量 (Inception) 和美学。

定性结果

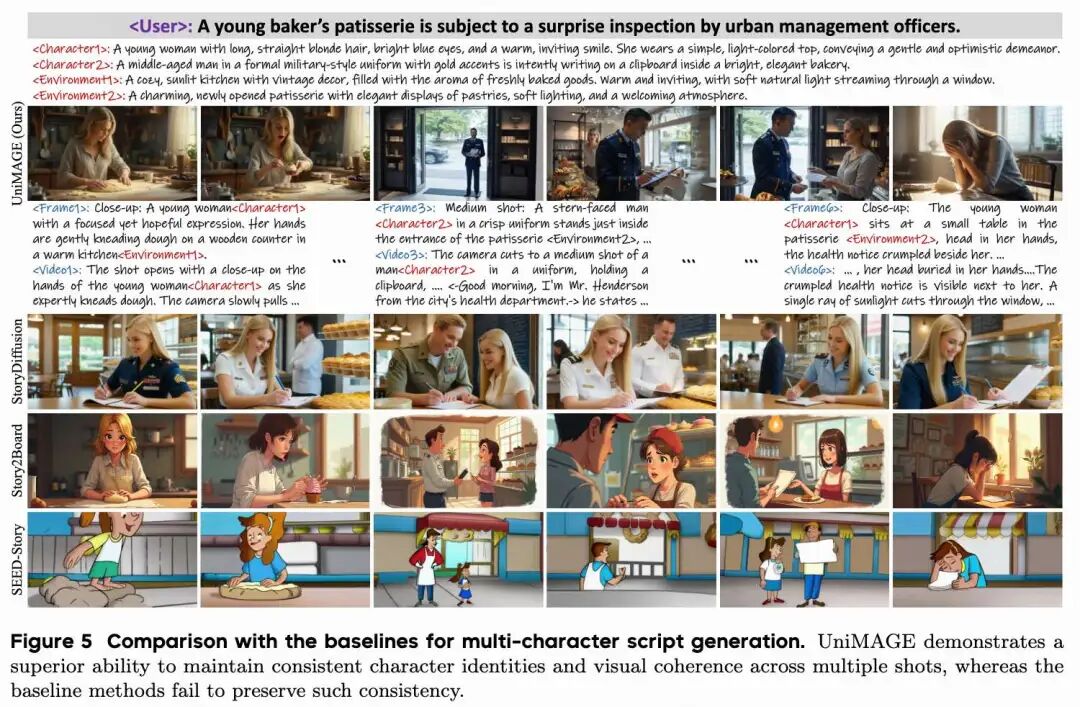

如下图5所示,本文将 UniMAGE 与最近的剧本可视化方法(包括 StoryDiffusion 和 Story2Board)以及多模态剧本生成模型 SEED-Story 进行了比较。UniMAGE 在多角色剧本生成方面表现出卓越的能力,能够跨多个镜头保持一致的角色身份和视觉连贯性。相比之下,基线方法在叙事转向新场景或摄像机角度时,通常会在面部结构、发型或服装方面产生明显的差异,导致角色外观不稳定和不匹配。UniMAGE 通过其统一的导演架构和提出的情境中 ID 提示,能够可靠地将图像中的每个角色与剧本中定义的相应文本身份相关联,从而实现了稳定的身份保持。

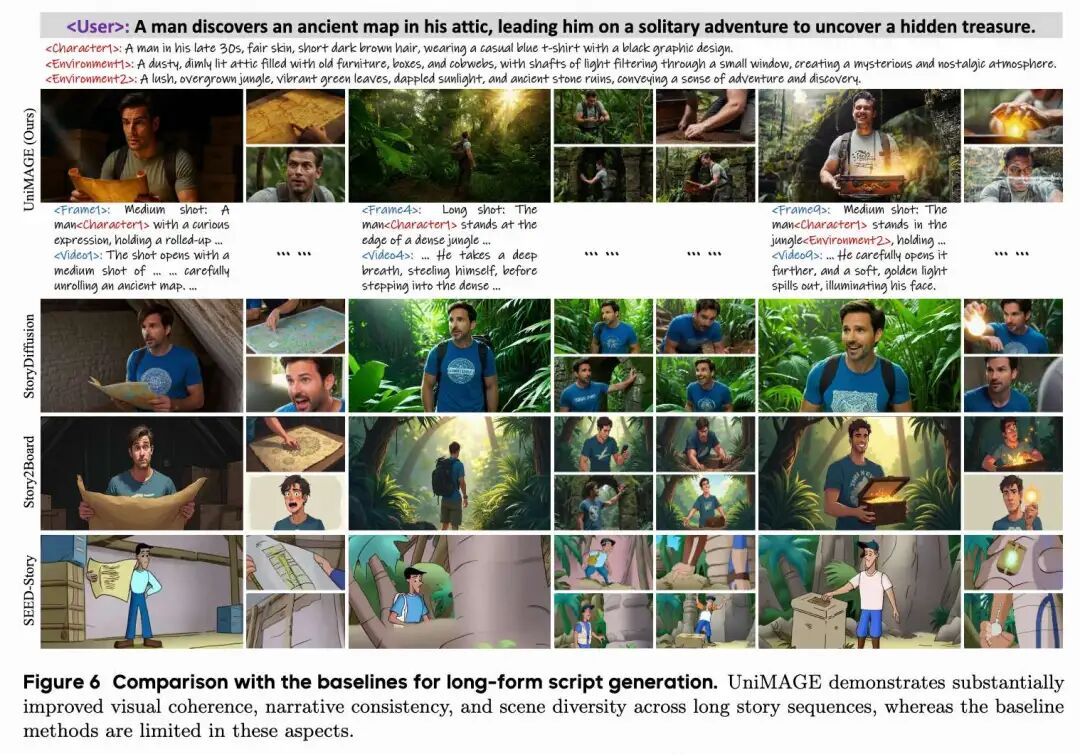

如下图6所示,在长篇剧本生成方面,StoryDiffusion 保持了基本的角色一致性,但场景变化有限,导致视觉模式重复和跨镜头的复制粘贴伪影。Story2Board 和 SEED-Story 表现出更大的不一致性,并且在保持稳定的视觉风格或角色身份方面都存在困难,产生了碎片化的过渡并削弱了叙事连贯性。相比之下,UniMAGE 有效地建模了长程时间结构,并以更高的保真度遵循了情节发展。

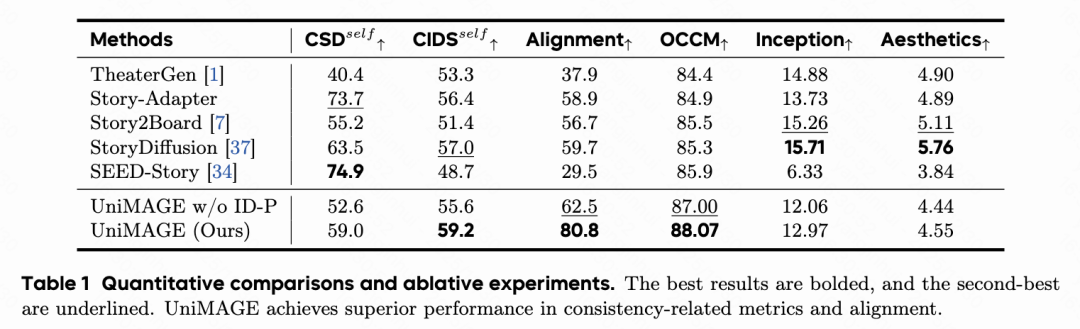

定量结果

如下表1所示,UniMAGE 在 ViStoryBench 上取得了最佳的整体性能,特别是在与一致性相关的指标方面。它获得了最高的 CIDS(59.2)和 OCCM(88.07),表明跨镜头的强大角色身份保留。UniMAGE 在 Alignment(80.8)方面也取得了显著改进,明显优于现有方法,表明其对叙事提示的依从性显著提高。虽然一些基线在独立指标上表现出竞争力(例如,SEED-Story 在 CSD 上或 StoryDiffusion 在图像质量和美学上),但没有一个能像 UniMAGE 那样在一致性、叙事对齐和视觉质量之间提供平衡的性能。

“UniMAGE w/o ID-P”和完整 UniMAGE 之间的比较证实了情境中 ID 提示策略的重要性。去除 ID-P 会显著降低 CSD、CIDS 和 OCCM,表明身份稳定性和场景连贯性较弱。这表明明确的 ID 条件对于在长篇故事讲述中保持一致的多角色表示至关重要。

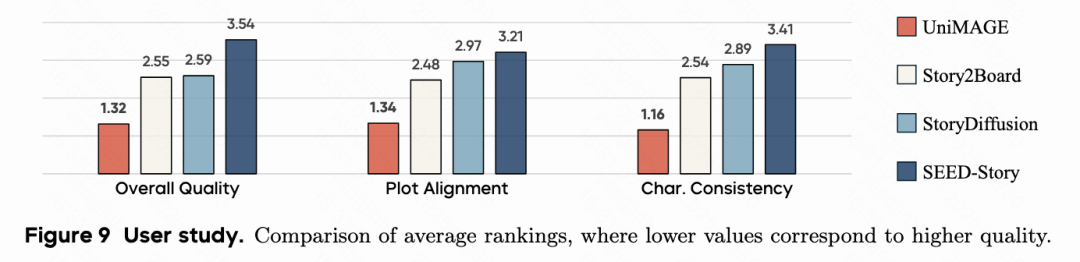

用户研究

如下图9所示,用户研究表明,UniMAGE 在所有标准中都获得了最高的偏好,包括叙事逻辑的 GSB 分数为 0.72,这表明在长篇故事连贯性方面具有明显优势。这些结果证实,大多数参与者更喜欢 UniMAGE 生成的剧本,而不是现有基线生成的剧本。

结论

UniMAGE,一个统一的导演模型,它将传统上分离的剧本起草和关键帧生成过程集成到一个单一、连贯的框架中。通过利用 Mixture-of-Transformers 架构,UniMAGE 弥合了文本推理和视觉想象之间的鸿沟,从而使用户能够制作出具有逻辑和视觉连贯性的长文本、多镜头叙事。本文方法的核心是两个协同的训练范式:交错概念学习,它通过文本-图像交错促进对叙事概念的联合理解;以及解耦专家学习,它将剧本和关键帧生成解耦,以增强创造力和结构一致性。在情境中 ID 提示和预上下文剧本拆分的进一步支持下,UniMAGE 在维护角色身份、故事情节连续性和跨扩展序列的视觉对齐方面表现出强大的能力。实验评估证实,UniMAGE 在开源系统中取得了最先进的结果,为下一代 AI 驱动的电影创作奠定了基础。

局限性 UniMAGE 主要旨在增强叙事连贯性并保持长剧本的强大视觉一致性。然而,电影制作的几个更高层次的维度——例如情感节奏、风格化电影摄影以及对导演意图的细粒度控制——尚未完全解决。将 UniMAGE 扩展到更丰富的电影理解和更具表现力的叙事控制仍然是未来工作的重要方向。

参考文献

[1] Bridging Your Imagination with Audio-Video Generation via a Unified Director

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2026-01-08,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录