31.3K star!开源免费本地AI神器,一键部署多模态大模型!

原创31.3K star!开源免费本地AI神器,一键部署多模态大模型!

原创

小华同学ai

发布于 2025-03-31 14:54:32

发布于 2025-03-31 14:54:32

嗨,大家好,我是小华同学,关注我们获得“最新、最全、最优质”开源项目和高效工作学习方法

"🤖 完全开源、本地优先的AI解决方案,支持文本/语音/图像/视频生成,消费级硬件即可运行!"

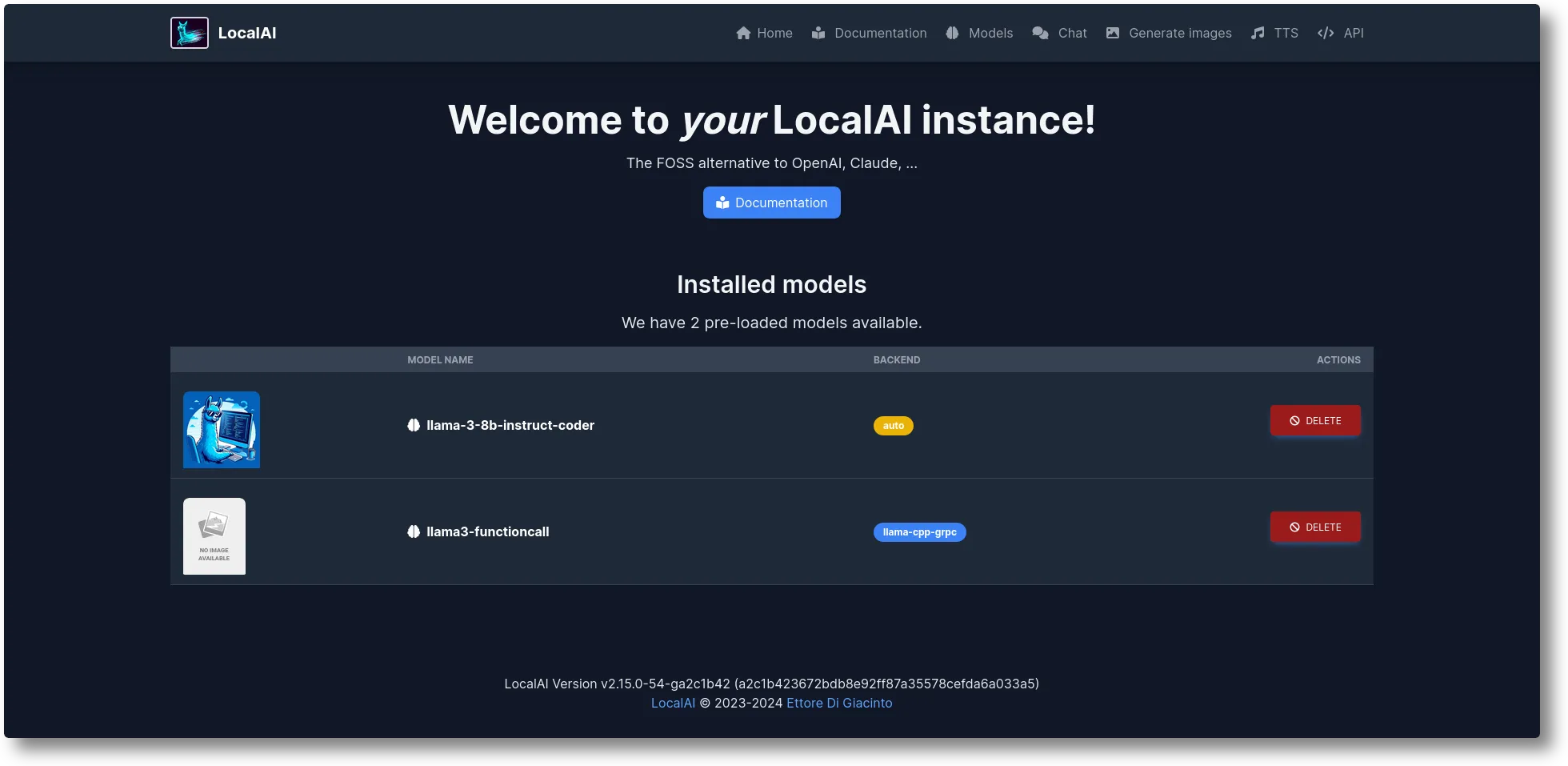

LocalAI 是一款革命性的开源AI框架,专为本地化部署设计。它完美复现了OpenAI的API接口,支持运行各类开源大模型(如LLaMA3、Phi-2、Stable Diffusion等),无需GPU即可在普通电脑上实现:

- 📝 智能文本生成

- 🎙️ 语音克隆与转换

- 🖼️ 图像/视频创作

- 🔍 语义检索与重排序

- 🤖 智能体开发

核心功能亮点

1. 全栈AI能力支持

功能类型 | 实现方式 | 应用场景示例 |

|---|---|---|

文本生成 | LLaMA3/Phi-2/Mistral | 智能客服/代码生成 |

语音处理 | Whisper.cpp/Bark.cpp | 会议记录/语音克隆 |

图像创作 | StableDiffusion.cpp | 营销素材生成/艺术创作 |

视频理解 | vLLM多模态模型 | 视频内容分析/自动剪辑 |

语义检索 | BERT系列模型 | 知识库问答/文档检索 |

2. 零门槛模型管理

# 从HuggingFace直接部署模型

local-ai run huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf

# 使用Ollama模型库

local-ai run ollama://gemma:2b

# 查看已安装模型

local-ai models list3. 企业级扩展能力

- 分布式推理:支持P2P网络构建AI集群

- 联邦学习:多节点协同训练模型

- 实时API:毫秒级响应请求

- 语音活性检测:集成Silero-VAD技术

技术架构解析

技术组件 | 功能说明 | 优势特性 |

|---|---|---|

Go语言核心 | 提供REST API服务 | 高并发/低内存占用 |

ggml架构 | 量化模型运行环境 | 消费级硬件支持 |

Transformers | 深度学习模型框架 | 支持最新模型架构 |

libp2p | 分布式网络协议 | 构建去中心化AI集群 |

Vulkan后端 | GPU加速支持 | 提升图像生成效率 |

五分钟快速上手

# 启动全功能容器(自动下载常用模型)

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu

# 调用OpenAI兼容API

curl http://localhost:8080/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "llama-3.2-1b-instruct:q4_k_m",

"messages": [{"role": "user", "content": "用Python写个快速排序"}]

}'同类项目对比

项目名称 | 部署难度 | 功能丰富度 | 硬件要求 | 社区生态 |

|---|---|---|---|---|

LocalAI | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐⭐ |

Ollama | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ |

LM Studio | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐ |

GPT4All | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ |

产品优势:

- 唯一支持多模态的本地化方案

- 无需GPU加速的量化模型支持

- 完整的OpenAI API兼容性

- 活跃的开源社区(每月10+次版本更新)

- 企业级功能:联邦学习/P2P网络

应用场景实例

案例1:智能文档助手

from langchain_community.llms import LocalAI

llm = LocalAI(endpoint="http://localhost:8080")

response = llm.invoke("总结这篇技术文档的核心要点:",

document=open("spec.pdf").read())案例2:AI绘画工作流

# 生成产品概念图

curl http://localhost:8080/v1/images/generations \

-H "Content-Type: application/json" \

-d '{

"model": "stablediffusion-v2.1",

"prompt": "赛博朋克风格咖啡机,4K高清",

"n": 2,

"size": "1024x1024"

}'同类项目推荐

- Ollama - 专注LLM的本地运行方案

- 特色:极简模型管理

- 局限:仅支持文本生成

- Stable Diffusion WebUI - 专业图像生成工具

- 特色:丰富插件生态

- 局限:单任务解决方案

- Whisper-asr - 语音识别专家

- 特色:高精度语音转写

- 局限:功能单一

- LangChain - AI应用开发框架

- 特色:工作流编排能力

- 局限:依赖外部API

总结

LocalAI 三大核心优势:

- 🚀 零门槛部署:普通笔记本电脑即可运行百亿参数大模型

- 🔄 全功能覆盖:文本/语音/图像/视频处理一应俱全

- 🔧 高度可扩展:支持自定义模型和分布式集群

适用人群:

- 需要私有化部署AI能力的企业开发者

- 对数据安全有严格要求的金融/医疗行业

- 想要学习大模型技术的AI爱好者

项目地址

https://github.com/mudler/LocalAI

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录