A-BDD:面向恶劣天气和照明条件的分类器欺骗与语义分割 !

高度自主化的车辆功能依赖于机器学习(ML)算法来理解环境。尽管在晴朗天气场景中表现出非凡的性能,感知算法受到恶劣天气和光线条件的影响很大。为了克服这些困难,ML工程师主要依赖全面的真实世界数据集。 然而,操作设计领域(ODD)的关键区域的实际数据收集困难,通常需要合成数据进行感知训练和安全性验证。因此,作者提出A-BDD+,这是一个基于BDD100K合成增强的超过60,000张图像的集合,配备了语义分割和边界框标注(继承自BDD100K数据集)。该数据集包含各种强度 Level (如雨、雾、阴天和日冕/阴影)的增强数据。 作者进一步引入使用基于特征的图像质量指标(如FID和CMMD)的全新策略,这些指标有助于识别对ML训练和测试有用的合成和实际数据。通过在A-BDD上进行实验,作者提供了证据,表明在恶劣天气和光线条件下,数据增强在缩小性能差距方面可以发挥关键作用。

1 Introduction

自动驾驶(AD)的实际实现,特别是高阶全自动驾驶(L4&5级),依赖于健壮的基于机器学习的感知算法。最近的部委报告表明,感知失败仍然是高级驾驶员辅助系统(ADAS)断开的核心驱动因素[8]。

过去几年,开发行人通过在机器学习组件的训练和测试过程中集成不断增长的、多样化的图像数据集来应对这些性能缺陷。然而,现有的标注真实世界数据集缺乏足够的数据用于关键的Odd(错误发生)场景。传统的数据收集方法由于无法控制自身车辆的环境,难以捕捉数据的'长尾'部分[5,15]。

因此,研究行人和实践者越来越依赖合成数据来训练、测试和验证感知模型[2,26,40]。完全人工合成数据由模拟引擎生成,已成为软件在环(SiL)和硬件在环(HiL)测试的不可或缺部分。这种数据类型将在ML训练中进一步发挥重要作用,其利用率预计将显著提高[30]。然而,在安全关键应用的背景下,对合成数据方法的有效性进行全面论证仍具挑战性。

在这两个极端之间,存在着第三种数据类型,即尚未充分利用的数据类型。数据增强技术通过将图像变换应用于实际世界数据点来扩展数据集的大小和多样性。像添加高斯噪声、旋转和裁剪这样简单的数据增强在ML模型训练中极为常见,它作为正则化机制发挥作用,帮助模型更好地泛化到未见过的数据[7,24]。

与这些简单的增强方法部分相关的是对抗性鲁棒性(adversarial robustness)的研究领域[1,23,39]。在这里,研究行人开发对抗性攻击,这是基于优化的增强技术,以利用现有神经网络的脆弱性。总的来说,对抗性攻击在汽车行业中受到了有限关注,主要是因为人们认为对抗性例子不一定源于现实的威胁模型。当前标准化和法规发展,如欧盟人工智能法案[9,10]和ISO PAS 8800[21],预示了这一特定的ML robustness(健壮性)领域的兴趣将在各种行业领域中迎来新的、理应受到关注的新浪潮。

更复杂的图像增强方式[29,33],模仿了诸如恶劣天气和光线条件等具有挑战性的安全相关Odd(错误发生)场景,在感知开发中尚未得到广泛应用。作者认为这有几个原因:首先,光学模型(或越来越常见的是基于生成AI)的图像增强技术的研究仍在初级阶段,这意味着ML工程师只能接触到这些技术和相关增强数据集的有限资源。其次,类似于模拟引擎的情况,现有增强方法往往缺乏确凿的证据表明它们可以在实际场景中有效缩小性能差距,同时也不能作为安全性论据的一部分。

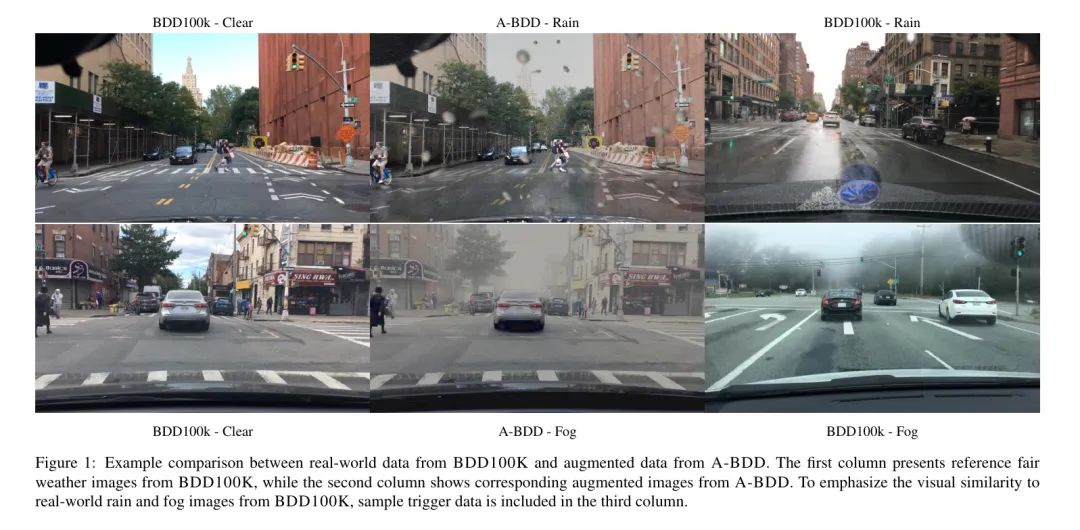

针对这些限制,作者提出A-BDD,BDD100K [44]数据集的一个扩展版(参见图1)。BDD100K 是最广泛和最多样化的多任务学习图像识别数据集之一。然而,在进行语义分割这一关键任务时,BDD100K 缺乏必要的天气和闪电条件变化。例如,作者在语义分割数据中发现了不到100张下雨图像和不到20张雾天图像。

用于生成A-BDD的主要增强技术不会显著改变或模糊物体,使作者能够保留未修改的数据集中的原始标注。这是第一个大规模、公开的增强数据集,它提供了各种天气和闪电效果的数据,以及每个触发条件不同强度水平的数据。

为了强调增强在感知发育背景下的潜力,并指导如何为合成数据的有效性进行说明,作者在 A-BDD 上进行了实验。A-BDD在视觉真实度的程度很高,能够欺骗天气分类器,该分类器在增强和真实世界恶劣天气数据中检测到相似的天气特征。此外,作者将A-BDD纳入训练过程,提高了语义分割模型的性能。

必须牢记特定增强数据集对ML培训和测试的有效性将始终取决于给定的计算机视觉使用案例和数据分布。仅仅 incorporating现有的增强数据集而没有进行全面的分析是不可能获得令人满意的成果。因此,作者利用和扩展了现有的图像质量指标,如FID [20]和CMMD [22],并展示了有助于确定 A-BDD 子集的有价值的关联。在作者的实验研究中,作者观察到这些基于特征的图像质量指标,通常用于GAN评估,可以对训练/测试数据集设计提供宝贵的指导。

总之,作者的主要贡献如下:

- 作者发布了A-BDD,包括35个增强版的1,820个BDD100K [44]图像(即总共63,700个图像),带有语义分割和目标检测标签。这个增强数据集具有多种恶劣天气和闪电条件,包括雨、雾、多云、以及太阳镜/阴影。

- 作者计算了A-BDD与BDD100K和ACDC [34]的实时天气数据之间的FID和CMMD距离。这些距离随后用于通过比较增强数据的得分来衡量A-BDD与Albumentations工具箱 [3]之间的基准。

- 作者在互联网上抓取的现实世界恶劣天气图像上训练一个多天气分类器。然后作者在A-BDD以及Albumentations的数据上欺骗分类器。

- 作者引入了叫做C-FID和C-CMMD的FID和CMMD的“对比”版本,能够预测使用A-BDD中的子集欺骗多天气分类器的可能性。

- 作者使用A-BDD微调BDD100K预训练分割模型并演示在ACDC的真实世界雨水数据上的性能改进。

- 作者发现FID/CMMD分数和微调性能之间存在显著的负相关。这个洞察允许根据特征图像质量指标的分析来选择(重新)训练数据。

作者需要强调的是,本发行的目的并不是提出新的图像变换算法,而是为大量增强图像提供访问途径。这些增强图像可以在严格的气象和光线条件下用于衡量和提升语义分割和目标检测模型的性能。此外,本文展开的实验应激发未来旨在从感知发展中提取实际或合成数据的理论方法研究。

2 Related Work

在本节中,作者首先回顾用于驱动场景理解的 dataset,然后简要介绍与图像增强和图像质量指标相关的研究所。

Image Datasets

近年来,深度学习在计算机视觉任务中的成功在一定程度上取决于大型图像数据集的数量和质量。现有的数据集在大小、环境条件、标注和传感器模态等方面存在显著差异。在自动驾驶领域的重要里程碑包括KITTI [12]和Cityscapes [6]。KITTI是第一个开源数据集,包含激光雷达点云、立体相机的数据以及GPS定位数据。然而,它并没有提供语义分割标注,这部分解释了稍后发布的Cityscapes数据集的成功。 Cityscapes为德国50个不同城市的驾驶场景提供了像素级、实例级和多视角语义标注。这两个流行的数据集在大部分情况下包含在良好天气条件下拍摄的图像。

为解决环境多样性不足的问题,研究团队开始发布受天气影响的图像数据集。BDD100K [44],拥有100,000个视频和多种支持的计算机视觉任务,被认为是最大和最具多样性的驾驶场景数据集。特别值得一提的是,包括雨雪天气条件的图像和边界框标注,允许对目标检测模型进行全面基准测试。但是,在像素级语义标注方面,BDD100K数据集存在明显的局限性,其中包括仅仅10,000张图像,其中大约1000张描绘了如夜间场景、雪、雾和雨等具有挑战性的环境条件。

类似于BDD100K数据集,ZOD [45]数据集推动了多模态感知开发的最先进状态。ZOD涵盖了在14个欧洲国家的驾驶场景,同时提供反映各种天气条件和光照场景的图像数据。但是,ZOD仅包括车道标记、道路绘画和自车道路等像素级标注,这限制了其在分割模型训练中的潜力。

最近一个专注于为语义分割评估而设计的不利天气条件的数据集是ACDC [34]。该数据集包含约4000张图像,其中四种不同的触发条件(雾、夜、雨和雪)平均分配。每种不利的天气图像都附有相同场景在良好天气条件下拍摄的参考图像,但参考图像本身并未标注。这使得在ACDC上训练模型和应用增强技术具有挑战性,但ACDC数据集仍然是评估天气和光照效果是否降低语义分割性能的最佳手段。

Image Augmentations

计算机视觉模型在实际的分布转移方面存在困难[17,32]。数据增强可以帮助提高模型的泛化能力,因此已成为模型训练 Pipeline 的一个重要组成部分[43,37]。大多数机器学习框架都提供简单的图像增强(或腐蚀),如旋转、翻转和缩放。此外,研究社区已经开发了几款有用的增强库[28,3]和数据集[18,33],它们可以帮助测试视觉模型的鲁棒性[16]。一些现有的工具,如Albumentations[3]和imaug[28],通过提供更多样化的公共恶化(如高斯噪声、模糊、低光噪声、压缩)扩展了机器学习框架。

腐化和对抗性鲁棒性之间存在密切关系[11],即一种鲁棒性的改进可以转移到另一种鲁棒性。在过去的几年中,已经有很多研究致力于各种针对性攻击的探索。基于梯度的攻击,如FGSM和PGD,已经证明能够按所需任何方式更改分类输出[27,14]。

将污染和对抗性数据纳入模型训练,仍然被认为是减轻这些鲁棒性漏洞的最有前景的方法[19]。然而,目前还没有已知增强方法能够一致提高不同数据分布和超分布现象的鲁棒性。

因此,作者观察到与特定实际场景(如雨、雪和雾)相关的更复杂的数据转换方法的开发。这些方法要么基于风格转移,要么利用物理/光学模型。由于GAN和CycleGAN性能的最近进步[29],风格转移可以实现感知上的高保真度,但缺乏可追踪性和可控性[47]。例如,调整天气和照明条件的强度等级对于更深入地理解现有机器学习性能的差距至关重要,然而这对于常见的风格转移方法来说是无法实现的。此外,GAN的黑色盒性质需要生成合成数据进行彻底的质量保证。对于风格转移方法,重要的是确保在 fair-weather 图像转换后,现有物体保持存在并保持局部一致性。

基于物理的增强相对于风格转移,在可追踪性和可控性方面具有优势,但代价是增强 Pipeline 非常复杂。例如,作者在[41]中提出了一种雨产生渲染 Pipeline ,该 Pipeline 使用粒子模拟器和雨滴外观数据库。每一条雨痕都将其个别地投影到图像上,这引入了显著的计算开销。尽管论文提出了一种复杂的多种步骤方法来处理雨的各种影响,但仍然缺少的元素如乌云天空、镜片上的水滴、湿润的表面和积水等。

类似地,Sakaridis等人[33]将雾增强应用于基于清晰天气图像的雾霾图像,该模型已经应用于图像去雾。提出的方法被用来创建Foggy Cityscapes,这是一个增强数据集,它包含550张雨天图像和语义标注。提出的雾增强 Pipeline 可以生成视觉上令人愉悦的结果,但仍然错过了添加乌云效果、自适应晕影和光源周围的光环效果等细节。

总之,根据各种实际场景开发对应的数据增强方法可以提高机器学习模型的鲁棒性,特别是在面临数据分布转移的情况下。但这些方法仍然存在一些局限性,未来需要进一步研究和改进。

Image Quality Metrics

随着生成模型的成功,生成图像的质量评估需求大大增加。在他们的关于生成对抗网络(GANs)的开创性论文[13]中,Goodfellow等人使用Parzen窗口基的对数似然估计作为评估生成数据的质量的方法。然而,他们指出了该指标对高方差和维度问题的脆弱性,并提倡探索其他方法来解决这个问题。

近年来,Inception Score(IS)[35]和Frechet Inception Distance(FID)[20]已经成为图像质量评估的默认标准。这两个指标都是基于预训练的Inceptionv3模型,但在算法方法上有所不同。

IS仅在生成的或增强的数据上计算,评估图像数据集的质量和多样性。这个指标基于预期的边缘和条件分布之间的大KL散度,这些分布通过基础的Inceptionv3模型的输出来计算。因此,IS指标受到Inceptionv3模型1,000个输出类的影响显著。如果相关的输出分布在Inceptionv3模型下明显集中在特定的ImageNet类别,那么一个生成的图像可以被认为是“高质量”的。这种属性,加上IS没有考虑实际世界数据,使得这个得分不如作者的实验适用。

另一方面,基于特征的FID分数假定Inceptionv3模型的最后几层为多元正态分布,并计算了真实世界和合成数据的平方Frechet距离,相对于这些Inception特征嵌入。最近的研究指出,FID分数具有样本低效性和其基础的常态性假设问题。Jayasumana等人[22]也显示FID可能与人类对图像质量的判断存在分歧。因此,本文引入了CMMD,一个样本高效且分布无关的图像质量指标,该指标估计了两个数据集的CLIP[31]嵌入的最大均值差异。

在作者的工作中,作者利用FID和CMMD来分析A-BDD。这两个指标在大多数增强集上生成了类似的结果,但在所需的数据集大小上有差异。作者的关注点在于,使用图像质量指标来选择增强数据,以帮助解决感知算法中的性能缺陷。为此,衡量增强数据的视觉逼真度仅是一个次要目标。反过来,更重要的是,所给的图像质量指标能够区分增强数据是否创造了与相关实际世界恶劣天气条件相当的可比激活模式。因此,FID与人类评价者存在的分歧对作者实验来说并不重要。

3 Augmented-BDD (A-BDD)

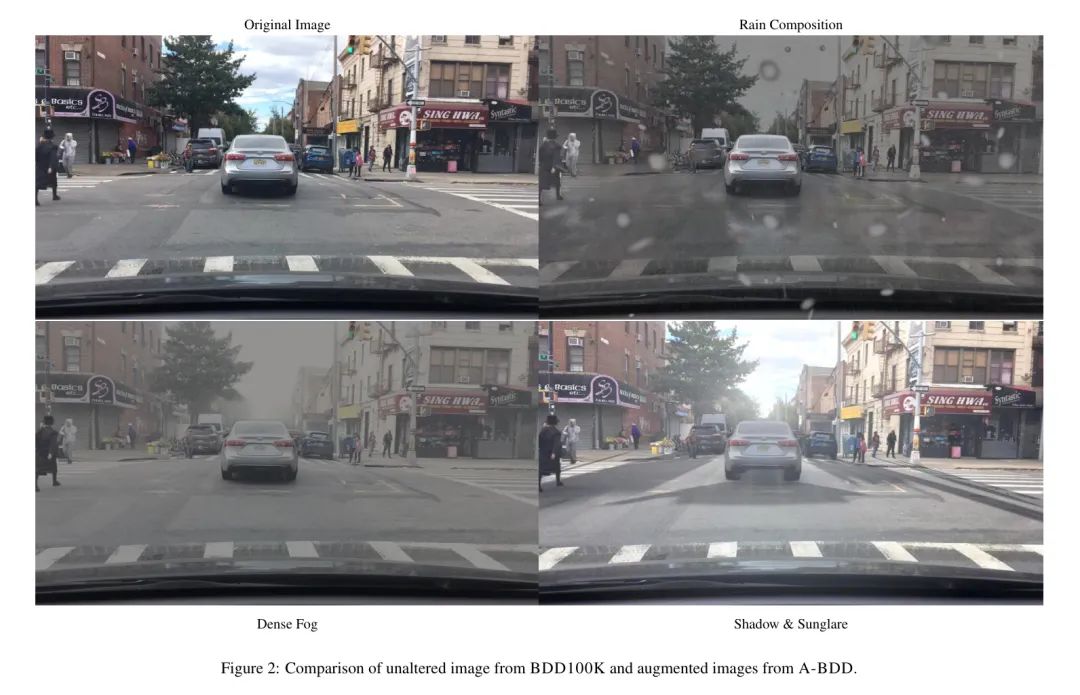

数据集包括35个子集,它们模拟了多种恶劣的天气条件和不同强度的水平。作者提供了增加的数据,包括雨天、阴天和大雾天气,以及具有额外阴影效果的日间耀斑天气。在雨天的情况下,数据集包括多个子集,每个子集都代表不同雨水天气的方面,如路面反射、镜头上的水滴、雨痕和这些现象的组合。

增强数据是从BDD100K的图像中获得的,这些图像具有语义分割和框标记。BDD100K的分割训练和验证数据共有8000张图像。然而,作者确保仅增强白天、晴天的图像,排除具有不可用的相机对焦或挡风玻璃上反射的图像。白天限制主要源自作者的增强技术尚未优化夜间设置,可能会在这种情况下生成令人不满意的视觉结果。

由于只有BDD100K的检测数据带有属性标签,作者交叉合并框标记和分割标注,并筛选出白天、晴天的图像。然后,作者进行额外的视觉质量保证,以消除错误的标签和不使用的图像,最终形成A-BDD的1,820张图像基础。这个图像基础也用于所有增强,允许在不同的天气条件下比较不同的驾驶场景(见图2)。

作者的增强方法是定制的实现,建立在现有技术基础上并扩展了当前最先进的状态。对于某些增强技术,深度图也是必需的。作者使用DepthAnything [42]模型为其中1,820张图像生成深度图。

增强方法分为以下几类,每类结合不同的技术模拟特定的恶劣天气和闪电条件。名称中的数字分别表示各自增强的强度等级。这7类,每类5个强度等级,最终形成了35个子集的A-BDD:

- Overcast (overcast_<1-5>):在图像上添加去饱和效果,并使用分割图调整天空以呈现出灰色的效果。

- Dense Fog (dense_fog_<1-5>):结合了Overcast效果与使用场景深度图的雾效果,自适应雾的透明度和模糊度,考虑与每个物体的距离。

- Shadow & Sunglare (shadow_sunglare_<1-5>):使用分割图在天空放置太阳,增加饱和度,为道路添加阴影,并为每个物体添加阴影。阴影的生成借助于每个物体的分割。分割形状使用基于边界框的逆透视以及其在街道上的投影(由深度图 提供)进行变形。

- Rain Streaks (rain_streaks_<1-5>):使用粒子系统与Overcast效果一起生成雨滴轨迹。

- Wet Street & Lens Droplets (wet_street_lens_droplets_<1-5>):结合Overcast效果与街道反射效果,使用深度图计算反射点。反射强度和地面粗糙度/反射系数进行参数化。这些增强子集中,最后两个强度还包括镜头滴。

- Puddles (puddles_<1-5>):为模拟雨滴,将Overcast和深度反射效果应用于模拟雨滴。雨滴形状使用Perlin噪声生成,并使用分割和街道的深度图进行投影。

- Rain Composition (rain_composition_<1-5>):结合Overcast、雨滴轨迹、Wet Street和镜头滴效果与雾效应。在眼镜或风挡上具有特定透明度的镜头滴包括在内。灵感来源于BDD100K的视觉效果检查。

该数据集是由迭代选择每个增强模块参数,对较小子集进行视觉检查,并最终将增强应用于所有1,820张图像而创建的。作者并没有优化增强参数以实现特定的图像质量指标或模型微调结果。除了依赖视觉效果检查之外,智能选择增强参数是未来研究的领域。

除了ABDD,作者还使用开源工具Albumentations生成了增强版本图像,这些增强集用于第4节中的基准测试。在本研究中,作者不详细阐述应用的增强算法。所使用的技术主要来自光学模型方法的高级版本(参见第2.3节),并结合额外的增强 Pipeline 步骤以包括与天气相关的伪数据,例如阴天、镜头上的水滴、街道反射、水坑和阴影。作者认为,这一领域的主要复杂性并不在于开发新的有前景的增强算法,而在于识别并使用给定感知用例的正确 - 真实或合成 - 数据。

4 Experimental Study

在作者的实验研究中,作者阐述了A-BDD的价值,同时也激发了利用基于特征的图像质量指标来评估和选择增强数据的创新策略,以用于ML训练和测试。

作者将探讨源于真实恶劣天气和经过天气增强的图像所生成特征嵌入之间的差异。作者希望这些表示的高度相似性转化为增强数据对感知模型训练和测试的高度价值的增加。

作者的实验研究也可以作为在安全论点中发展合成数据适宜性的证据来源。作者认为,通过解决三个主要 Pillar ,可以建立合成数据的有力主张:

- 视觉外观:合成数据是否从人类视角与相应的真实世界触发数据紧密相似?

- 算法相似性:合成数据是否从ML算法的角度与相应的真实世界触发数据紧密相似?

- 性能提升:合成数据能否通过帮助提高ML算法在真实世界触发数据上的性能而产生有利影响?

针对 "视觉外观" 这一 Pillar 进行用户研究相对简单。因此,作者将此 Pillar 的工作限制在这种情况下呈现说明性示例,如图2和附录A部分所示。

为了解决 "算法相似性",作者进行了(1)在4.1节中分析FID和CMMD得分的分析,并在(2)在4.2节中对增强数据在多天气分类器上的评估。

最后,为了为 "性能提升" 提供证据,作者使用A-BDD微调语义分割模型,以提高在真实世界雨数据(来自ACDC)上的性能,如在4.3节中进行阐述。

Fid & CMMD Analysis

在将合成不良天气数据纳入训练和测试过程中之前,了解现有真实世界天气和光线条件是否对感知算法产生显著的分布式 shift 是很 helpful 的。如果不良天气条件导致了特征嵌入的显著分布式 shift,未来的模型候选可能会以不同于良好天气数据的方式处理不良天气数据,这可能会导致 ODD 中的这些领域的性能较弱。作者的目标是使用 BDD100K 和 ACDC 感知数据集分析这个问题。通常情况下,工程师可以获得一些真实世界数据,对应于具有挑战性的天气和光线条件,但这些数据足够在模型训练中使用的有限。以 BDD100K 和 ACDC 为例,它们的情况都一样。在这两个数据集中,作者发现了不良天气数据,但相应的数据集大小却相当有限。

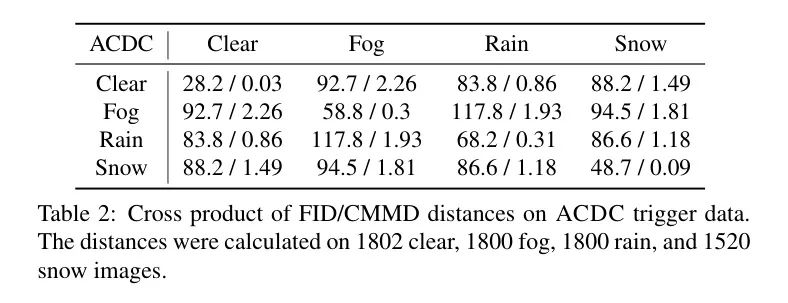

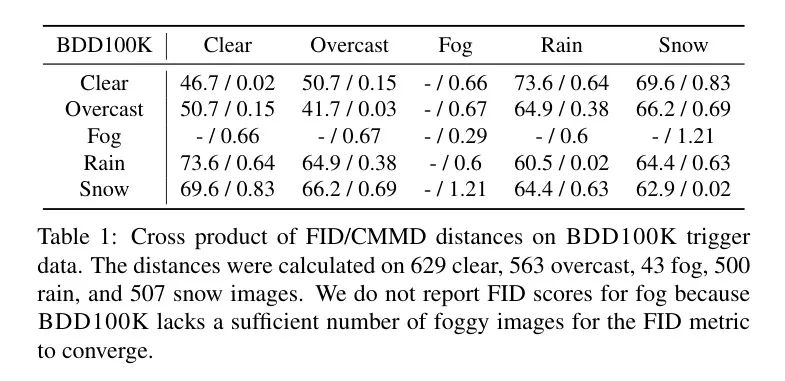

为了评估存在具有挑战性的分布式 shift 的情况,作者可以利用基于特征的图像质量指标 FID 和 CMMD。虽然这些分数通常用于比较真实世界和合成数据,但是它们没有理由不能帮助作者在不同的真实世界触发条件下检测分布式 shift。因此,作者计算了这两个指标在两个数据集中不同天气条件下的相关性。结果汇总在表1 和表2 中。不幸的是,由于 BDD100K 中雾数据的真实世界雾图像数不足(大约 50 张图像),作者无法报告雾数据的 FID 分数。因此,部分地推动了使用第二个更样本效率更高的图像质量指标,CMMD。

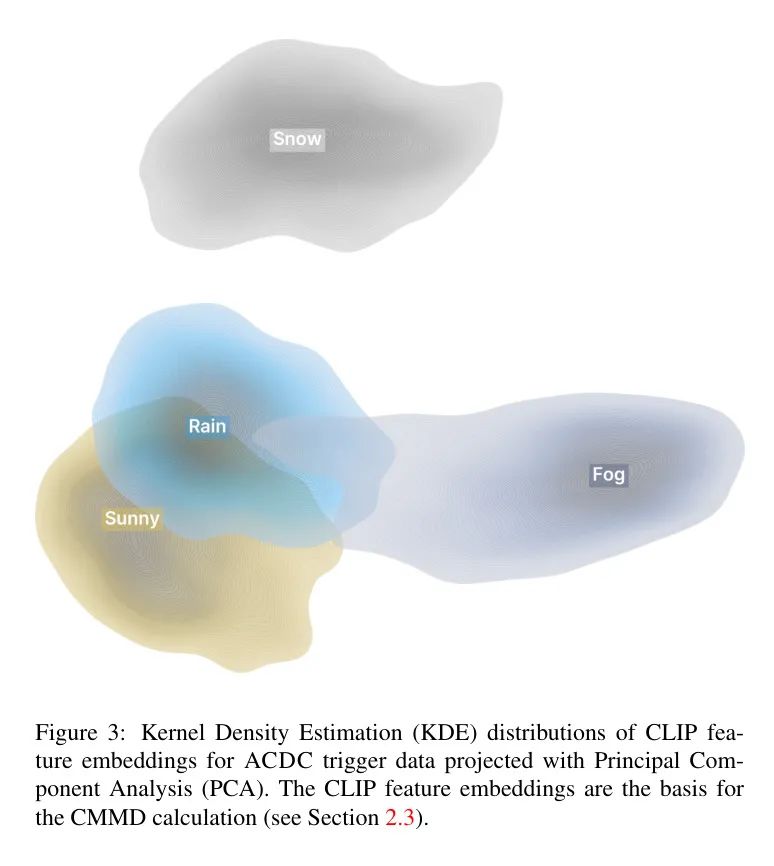

不同触发器之间存在明显的距离,这表明对应的恶劣天气条件会在最先进的 ML 模型中产生不同的激活模式。作者在图3 中通过绘制 ACDC 触发器的底层 CLIP [31] 特征嵌入的投影版本来证明这个直觉。

总的来说,这些激活差异在 ACDC 相对于 BDD100K 中更明显,这是与作者准备和清理数据观察到的相一致的。BDD100K 中的不良天气数据通常很难与清晰/良好天气(如街道上的小水坑、雨数据,或道路边的薄雪堆、雪数据)进行区分。特别是,BDD100K 中‘积云’和‘晴朗’这两个属性之间的分离似乎有些任意,而且在视觉检查时,将这些图像明确分配给其中任何一个类别是有挑战的。对于 FID 分数为 ,CMMD 分数为 的这两个触发器,这两个属性的距离非常接近。因此,积云图像的略微 darker、更 cloudy 的天空似乎并不会对 ML 模型中的激活模式产生明显的影响。

总的来说,这些观察到的差异表明,ACDC 中的触发条件“雨”、“雪”和“雾”与 fair weather 数据之间的距离较高,同时这些恶劣的触发条件之间也没有很高的距离分数。这表明它们会在 ML 模型中产生不同的激活模式,并代表不同的分布式 shift。

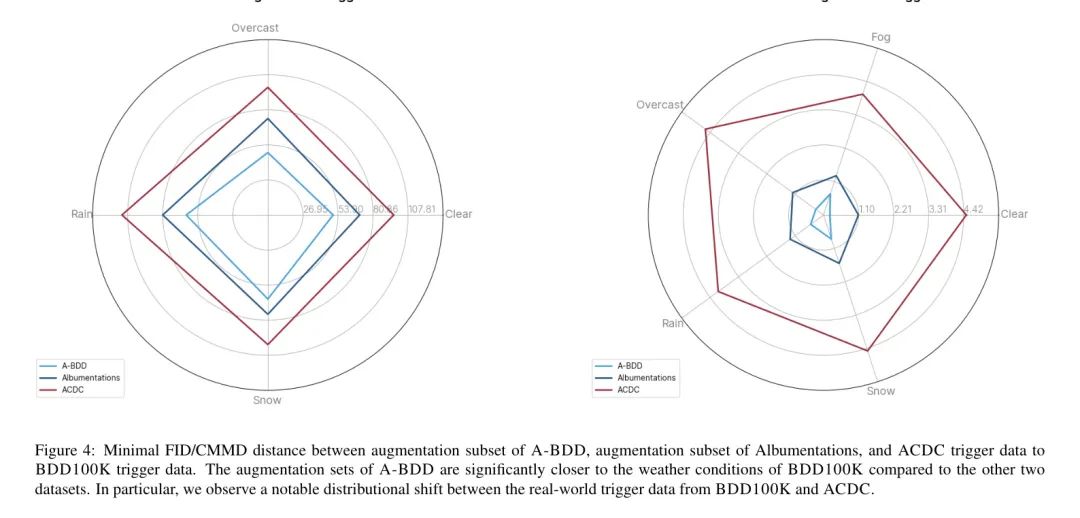

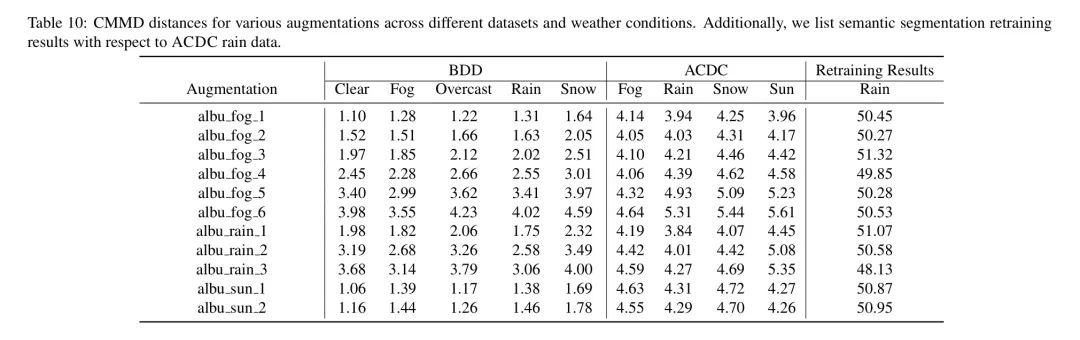

在确定了实际天气数据之间的有意义距离之后,作者计算了比较 A-BDD 增强数据和用开源工具 Albumentations 生成的增强数据(与 BDD100K 和 ACDC 的未增强数据相比)的 FID 和 CMMD 分数。在附录的表9 和表10 中,作者列出了所有计算出的距离。此外,作者用蜘蛛图(spider chart)对这些结果进行了总结,见图4。

Albumentations 提供的增强是基于与 A-BDD 相同的原始 张未修改的图像(见第 3 节)。使用 Albumentations 根据各种参数配置和触发条件(如晴、雨、雾等)为这些 张图像生成了 15 种不同的版本。

图4 中的结果表明,A-BDD 与 BDD100K 具有较近的距离。A-BDD 的增强集能够比未修改的晴空和阴天数据更接近恶劣天气条件。例如,作者可以看到,增加了天空的阴天和街道的反射的增强 "wet_street_lens_droplets_4" 得到 FID 距离实际 BDD100K 雨数据为 62.02,明显低于晴空和阴天的 BDD100K 数据对应的 73.6 和 64.9。

与此同时,Albumentations 生成的增强数据无法达到类似接近度水平。以雨天为恶劣天气条件的例子,作者没有找到任何增强和参数配置的 Albumentations 会使 FID 距离实际 BDD100K 雨数据低于 80.9,这在 A-BDD 中是相当高的。在 35 个 A-BDD 提供的增强集中,有 27 个低于这个值,即距离实际雨数据更远。

FID 和 CMMD 这两个指标并不总是相互协调地估计相对距离。因此,可以在某些增强数据集中找到,FID 分数表明接近最贴近实际触发器的一个真实世界场景,而 CMMD 分数表明实际情况相反。这似乎特别适用于 A-BDD 的 "puddles"、"shadow" 和 "overcast" 增强,其中相对于阴天数据,FID 分数最小,而相对于 BDD100K 的晴天气数据,CMMD 分数最小。然而,如前所述,BDD100K 这两个图像属性的视觉相似度极高,因此图像质量指标在评估这些属性时可能会有所不同。

在表9 和表10 中,作者还将 A-BDD 与 ACDC 的距离进行了列表。作者观察到,在这种情境下,FID 和 CMMD 得分显著较高,并且无法与表2 中真实世界数据的交叉产品中的得分相匹配。所有 35 个 A-BDD 增强集中,计算的雨天数据 FID 平均距离为 ACDC 的 129.32,而 BDD100K 的仅为 74.27。这表明这两个数据集之间存在显著的分布差距。这个差距也体现在图4 的蜘蛛图(spider chart)中,其中作者报告了两个未修改的实际世界数据集之间的最小距离。

作者关心的问题是,来自BDD100K的增强数据在ADC相关的感知任务中是否仍具有帮助性。在接下来的部分中,作者会对此进行更详细的分析。总体而言,作者观察到真实的气象数据与实际场景中的图像质量指标之间的特征嵌入存在显著差异,这增加了在感知训练过程中采取保护措施的需要。由于与来源于Albumentations的增强数据相比,其指标较低,作者首次得到了A-BDD潜在价值的指示。根据给出的图像质量指标,A-BDD的增强数据能够接近真实的恶劣天气数据。在接下来的部分中,作者将提供更多的证据,说明这些计算出的分数可以在感知训练和测试中用于数据选择。

Adverse Weather Classifier

多天气分类器可以学习到对应不同天气条件的特征,例如雨、雾、雪以及阳光/眩光等。当面临增强/合成的不利天气数据时,天气分类器是否感知到相似的特征还不确定。

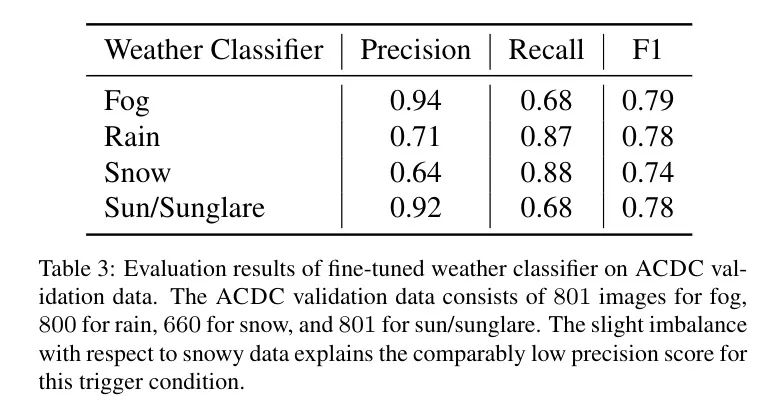

为了调查这个问题,作者首先在真实世界数据上训练一个天气分类器。然后,作者使用训练好的分类器来预测各种增强数据集上的天气。高分类准确性将进一步表明增强数据有效地模拟了真实世界的不利天气数据。

作者从ImageNet预训练的VGG16模型开始。只训练最后一全连接层的参数,确保输出类别与期望的天气条件(即雨、雾、雪)的数量相同。使用公开的包含4,310张图像的数据进行微调,这些数据来源于互联网(非ADAS/AD的重点),并在四个天气条件下均匀分布。

为了验证,作者关注ACDC的数据,因为该数据集具有更大的视觉差异,并且不同天气条件之间的图像质量距离较大(参见第4.1节)。这些特性预计将在ACDC上使多天气分类器表现出强大的性能。作者从ACDC训练和验证数据集中获取图像,但去除了无法轻易映射到四个天气条件之一的图像。

作者用5个周期,批处理大小为16,Adam优化器的VGG16模型进行了微调。在抓取的训练数据上训练得训练准确率为81%,在清洗过的ACDC数据集上进行验证得验证准确率为78.5%。有关天气分类器在验证集上的详细性能,请参阅表3。对于作者数据集的相关触发条件(如“雾”、“雨”和“阳眩光”),模型在相应的ACDC触发数据上达到至少76%的准确性。

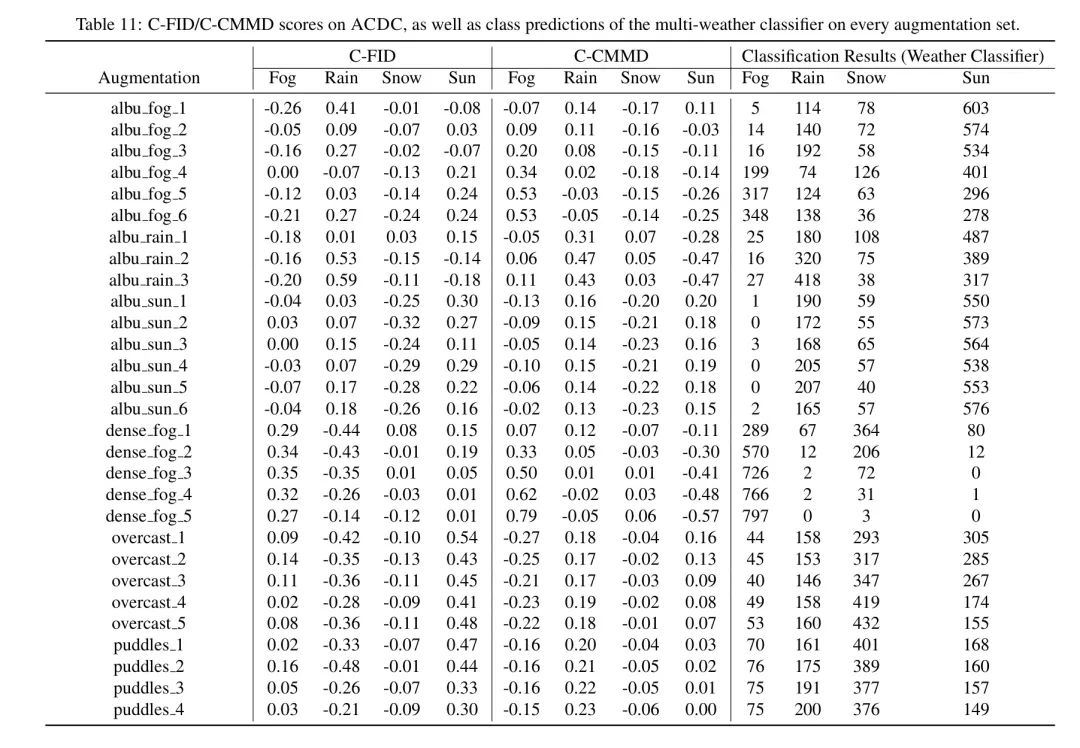

训练好天气分类器后,作者在增强数据上测试模型。作者在所有A-BDD的35个子集上进行推理,以及所有15个生成的Albumentations集的数据。每个子集作者都从1,820个增强图像中样本800个进行评估(参见附录11表11)。

由于A-BDD经常将雾和雨的天气特性结合(例如,反射、水坑和多云),对于每个增强集,并没有总是可以明确地判断图像应被分类为雾还是雨。换句话说,使用多天气分类器很难判断一个图像是否应该被分类为一种天气条件。

然而,天气分类器在所有35个子集的12个集合上表现出相当大的信心。这表明它在感知到真实世界不利天气数据时的特征相似。在这些12个集合上,它将超过70%的增强图像分配给一个特定的天气类别。对于雾来说,增强的强烈程度(即≥3)被正确地分类为雾,准确率达到91%以上。

总的来说,在A-BDD涵盖的雨、雾和阳光等三种天气和光照条件下,作者找到了一个增强的A-BDD子集,其中超过52%的图像被分配给相应条件。

将A-BDD的推理结果与Albumentations的结果进行比较,在天气条件雨和阳光上,作者没有看到明显差异。两个增强的数据集都包含相似分类结果的子集。然而,在雾这个条件上,结果有显著差异。在这里,没有一个Albumentations集合能获得超过43%的图像被分类为雾,而最好的A-BDD集合的分类率为99%。

最后,作者还希望将天气分类器的推理结果与计算得到的FID/CMMD分数相联系。在这里,可以看出距离触发条件越近,并不一定意味着天气分类器会将增强的数据集分配给特定的天气现象。例如,对于雨_composition的最低强度 Level ,天气分类器将46%的图像分配给雾,只有大约10%的图像分配给雨,即使CMMD分数表明数据更接近雨而不是雾(CMMD: 雨为4.03,雾为4.09)。这使作者得出了一个假设,即要欺骗天气分类器,不仅需要使增强的数据集接近所需的触发条件,同时也需要保持与其他天气类一定的距离。

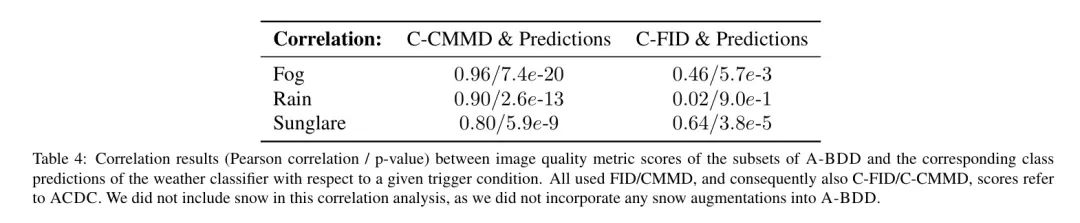

这种相当定性的直觉激励了Contrastive-FID(C-FID)和Contrastive-CMMD(C-CMMD)的定义。令表示现实世界数据集(即,对于ACDC,)的不同天气和光照触发器。作者定义

其中表示一个真实世界或合成数据集,它应该与感兴趣的触发条件和对应的触发数据进行比较。C-FID和C-CMMD的设计使得它们的值在接近时增加,同时保持与其它触发器(其中)一定的距离。

表4: A-BDD子集与相应类别预测之间的图像质量指标得分相关性结果(皮尔逊相关系数/ p值)。所有使用的FID/CMMD, 因此也包含C-FID/C-CMMD分数,都指ACDC。作者没有包括雪进行相关性分析,因为作者没有将雪增强集成到A-BDD中。

作者根据对 A-BDD 的各个子集(见附录表11)的 FID 和 CMMD 值,计算了 C-FID 和 C-CMMD。然后,作者计算了 C-FID/C-CMMD 得分与被分类为特定天气现象的图像数量之间的皮尔逊相关系数。相关系数结果如图4 所示。由于作者在 A-BDD 中没有集成任何雪增强,因此没有对 snow 进行相关性分析。正如预料之中,所有天气触发器之间存在正相关性。特别是,C-CMMD 导致的相关系数高于 ,且 p 值低于 ,表明对比度得分增加与分类器将数据分配为相应天气状况之间存在强烈关联。换句话说,某个天气条件的 C-CMMD 可以作为判断天气分类器是否将数据分配为相应天气类的指标。

总的来说,A-BDD 的合成数据成功地欺骗了多种天气类别分类器,导致了与来自 ACDC 的真实世界天气和光线数据的类似分类结果。除了视觉外观和有前途的图像质量分数(见第 4.1 节),这进一步证明了所提供数据集的有用性。通过检查 FID 和 CMMD 的适应性版本,作者发现为了欺骗天气分类器,使其推理特定天气类别,不仅需要最小化与目标触发器的距离,还需要保持与其他天气现象的明显距离。

Semantic Segmentation Fine-Tuning

最终,对于感知开发团队来说,增强数据的关联性取决于其在将增广数据纳入(重新)训练集时能否提高模型性能。因此,作者使用增强数据来微调语义分割模型,以提高其性能。

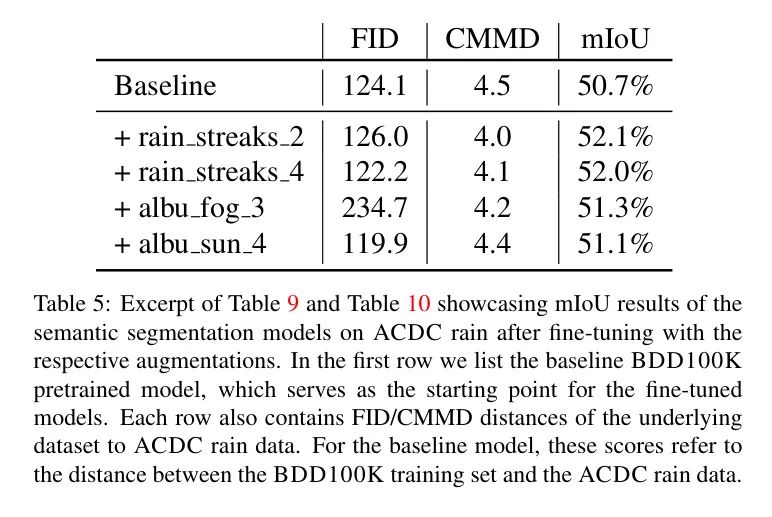

作者从BDD100K上训练的具有R-50-D8 Backbone 的DeepLabv3模型开始。在没有进一步微调的情况下,该模型在BDD100K的验证集上获得了61.43的mIoU。然而,当面对尚未见过的ACDC降雨训练数据时,该模型的性能下降到50.67的mIoU,这突显了这两个数据集之间的分布不连续。

开放的问题是BDD100K的增强数据是否可以帮助减少这个性能差距。

所描述的实验设置与汽车感知开发团队面对情况非常相似。这些团队通常拥有用于模型训练的收集的车辆数据,并且必须确保开发的感知功能在终端用户的驾驶环境中保持足够的性能水平,而终端用户的驾驶环境具有严酷的恶劣天气条件。然而,现有的车辆数据可能无法充分捕捉终端用户的驾驶环境,这种限制也可能延伸到从其衍生出来的增广数据。

作者在每个增强和强度 Level 上分别训练DeepLabv3基础模型30个周期。作者使用每个增广子集的1820个增广图像,而没有将额外的BDD100K或ACDC数据添加到微调数据集中。对于分析,作者选择在ACDC降雨训练数据上训练30个周期的最佳表现模型。为了确保增广数据集之间的可比较性,作者在所有训练运行中保持训练配置和超参数固定(即使用学习率0.005和动量0.9的SGD优化器)。

最终作者得到了50个微调的DeepLabv3模型,其中35个基于A-BDD,15个基于Albumentations数据。

大多数增强数据集对ACDC降雨数据产生了积极影响,即模型微调稍微降低了现有性能差距。所有微调结果都可在附录的表9和表10中找到。对于表现最好的两个A-BDD模型和两个Albumentations模型,作者进行了简单的直接比较,具体见表5。

最佳的微调模型在mIoU指标上比DeepLabv3 Baseline 模型(微调雨迹_2)高2.8%。mIoU指标的平均性质掩盖了更显著的每个类别的改进。例如,2.8%的提升意味着对19个目标类别(类:墙、交通信号灯、公交和摩托车等)中有4个类别的改进超过了10%。

总的来说,通过微调,有7个 out of 35 A-BDD 微调模型相对于 Baseline 模型提高了1.4%以上的性能。

另一方面, Baseline 的 Albumentations 微调模型没有在1.28%以上超越 Baseline (最好表现的Albumentations模型:albu_fog_3)。因此,A-BDD的增强在降低性能差距方面更为成功,这可能是由于距离#### ACDC恶劣天气数据(参见第4.1节)较低的结果。

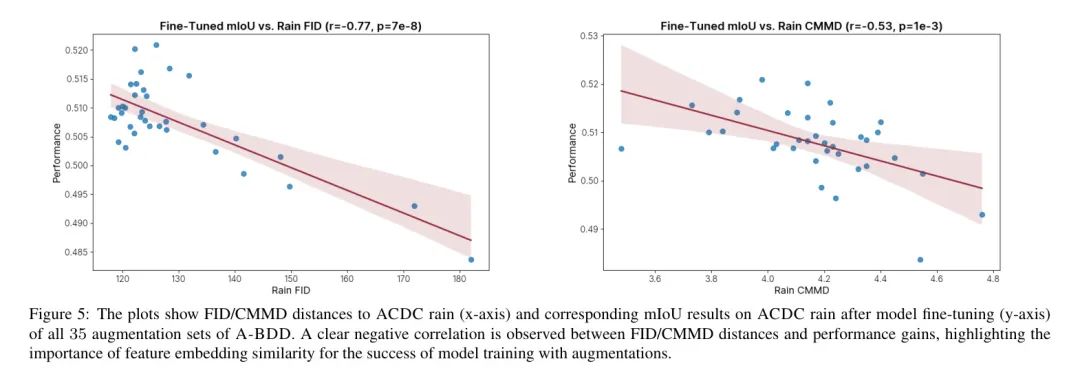

与第4.2节中的实验类似,作者希望证明基于特征的图像质量指标对于数据选择的可用性。作者将微调模型的mIoU和相应于ACDC雨数据对应的FID/CMMD距离之间的皮尔逊相关系数进行计算(参见图5)。在此背景下,作者没有使用FID/CMMD的对比版本,因为在天气分类任务中,目标模型需要区分不同的天气条件。

作者得到的FID和CMMD相关性分数分别为-0.77和-0.53(在p值0.05以下)。因此,A-BDD中距离与微调结果之间的明显负相关关系。换句话说,当增强数据与相关的雨特征分布紧密相当时,微调模型在现实世界雨数据上的性能倾向于提高,这表明图像质量指标,特别是FID在这种情况下,可以作为感知训练中合成数据价值的良好预测器。

这一洞察力甚至可以应用于合成数据的评估之外。观察到的相关性指向了一个更结构化的数据选择过程,这是一种围绕基于特征的图像质量指标建立的过程。在ADAS/AD开发中,常常面临大量的累积车辆数据以及相对任意化的数据标注和选择决策。很难确定哪些收集到的场景将有效地改善模型在ODD关键区域的性能。所给出的图像质量指标可以作为不需要任何昂贵标注的早期指示器。这些指标可以有助于选择累积车辆数据的子集,然后对这些子集进行标注,并随后用于机器学习训练过程。

5 Conclusion

在这篇论文中,作者介绍了A-BDD,这是作者设计用于在各种恶劣天气和照明条件下进行语义分割和目标检测训练和测试的最大的公开增强数据集。该数据集包括BDD100K的35个版本,分别是与不同恶劣触发条件和强度水平(即雨、雾和逆光)相关的一千八百张图像。作者展示了A-BDD的潜力,通过欺骗天气分类器,以及通过在ACDC恶劣天气数据上提高最先进语义分割模型的性能。

作者提出使用基于特征的图像质量指标,如FID和CMMD,来识别给定图像识别用例中的有前途的合成数据。特别地,作者观察到图像质量指标分数和模型细调与增强数据的成功之间存在很强的相关性。这一相关性开启了更复杂的数据选择过程的大门,并最终导致了更有效的训练过程,从而在ODD上训练出具有令人满意性能结果的模型候选人。

总的来说,作者希望能有更多研究行人关注利用在GAN开发之外的图像质量指标,这些指标利用神经网络的特征嵌入。FID和CMMD的一个缺点是它们依赖于与AD/ADAS任务无关的感知模型,特别是Inceptionv3和CLIP。未来的工作应该研究如何将更多与汽车相关的感知模型集成到图像质量指标对数据选择的有效性中。

参考

[1].A-BDD: Leveraging Data Augmentations for Safe Autonomous Driving in Adverse Weather and Lighting.

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-08-24,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录