Google TPU前世今生:从AlphaGo到9216卡Ironwood超节点,媲美英伟达

Google TPU前世今生:从AlphaGo到9216卡Ironwood超节点,媲美英伟达

AGI小咖

发布于 2025-12-22 11:47:27

发布于 2025-12-22 11:47:27

AGI小咖

从 AlphaGo 背后 TPUv1 演进至 OCS + ICI + 3D Torus 加持、媲美 GB200/GB300的 TPUv7(9216卡Ironwood超节点),对比阿里和英伟达,马太效应和正向飞轮下谁才是AI时代既租售铲子又挖金子的主。

据SemiAnalysis 最新发布的深度分析报告 , OpenAI 已将 Google TPU作为潜在的替代选项, 借此在大规模GPU算力集群采购中争取到 约 30% 的折扣。 报告进一步指出,一旦Gemini、Claude 或未来的 GPT 迭代版本被证明在 TPU 上运行得比在 H100 或 Blackwell 平台上更高效、更具成本优势 , NVIDIA 的定价主导权将面临迅速瓦解的风险。市场分析认为, 如果Google能通过TPU抢占10%的高端算力市场,将导致Nvidia的股价估值逻辑发生根本性 变化 。

这一趋势已有现实印证——在 Anthropic 与 Google 达成的超百亿美元级合作中,双方采用了“租买结合”的创新模式:Anthropic 通过 Broadcom 直接购买首批 40 万颗 TPU v7(Ironwood) ,同时向 Google 租赁剩余的 60 万颗TPUv7 Ironwood, 共同构建起一个总功耗超1GW 的 TPU 集群。

即便 Google 从外部客户租赁 TPU 中获取利润,其每小时的总拥有成本(TCO)仍显著低于 NVIDIA 方案:相比 GB200 低约 30%,相比尚未量产的 GB300 更是低达 41%。这也印证了一个核心逻辑:TPU 采购量越大,企业所节省的GPU资本支出 就越多。

1

什么是 TPU?

那么,TPU 到底是什么?为何能挑战英伟达GPU的“硬通货”地位?

简单来说, TPU(Tensor Processing Unit) 是 Google 专为人工智能机器学习定制设计的芯片,与通用型 GPU 不同,TPU 从架构层面优化了张量运算——张量可以理解为一个多维的数组,大语言模型(LLM)的参数本质上是上千维的张量,人工智能深度学习训练和推理 的 核心是对海量张量进行高频的矩阵乘法、卷积、加法、减法 。

2

演进史:从AlphaGo 到TPUv7 (Ironwood)

Google于2013 年启动 TPU 研发项目,2014 年收购 DeepMind,2016 年 正式推出 第一代TPU 芯片——为了彻底解决摩尔定律放缓下的推理效率瓶颈,Google 在设计之初就大胆移除了所有与训练相关的硬件单元 , 仅动用 48 个 28nm 工艺 TPU v1 组成的 分布式集群AlphaGo(AlphaGo Lee版本) 在围棋人机大战中以4:1 击败了韩国传奇棋手李世石(Lee Sedol)一鸣惊人。

图 1: 2016年首尔 李世石 DeepMind团队

2017 年 5 月,升级版 AlphaGo(即 AlphaGo Master)在乌镇以 3:0 完胜当时世界排名第一的中国棋手柯洁 , 围棋人机大战的告捷背后仅仅只是依赖于一台 内置了4个TPUv2芯片 服务器,推理性能强悍升级的TPUv2背后是 首次集成高带宽内存(HBM),还具备原生 大 模型训练能力。随后推出的AlphaGo Zero更是彻底摆脱了对人类棋谱的依赖,同样仅使用4个TPUv2就在三天内以100:0击败了AlphaGo Lee 。

图 2:2017年乌镇柯洁 与DeepMind 团队

随后推出的TPU v3是 Google 数据中心历史上第一款引入液冷技术的芯片,TPUv3 Pod的算力突破了100 Petaflops(单个Pod可横向扩展至2048个芯片)。

紧随其后 对标英伟达A100芯片 的 TPU v4 , 不仅是同期 Google云的核心产品, 也 是Google算力架构的分水岭 , 即引入源自电信领域的 OCS(Optical Circuit Switching,光路交换) 技术——基于MEMS(微机电系统)反射镜的物理层交换网络 彻底革新了数据中心级机器学习基础设施 。 得益于OCS,TPUv4构建了独特的3D Torus互联拓扑 容纳高达4096个TPUv4芯片 : 故障芯片可以无缝地绕过,而无需关闭整个机架。最值得注意的是,位于不同数据中心位置的物理距离较远的TPU可以在网络拓扑中逻辑相邻,从而完全 物理布局和逻辑拓扑的解耦,至此,Google TPU芯片家族中的OCS和3D Torus 两大核心技术杀手锏迭代更新沿用至今。

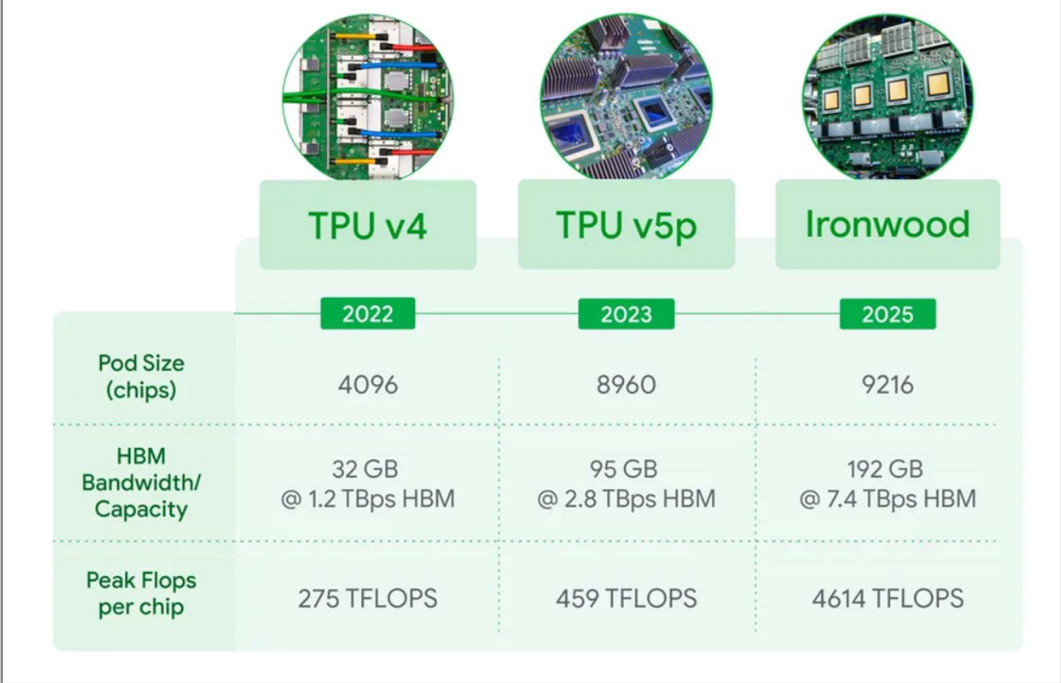

面对NVIDIA H100 的强势竞争,Google 在 TPU v5采用了专业化和规模化的双线并行的产品策略。其中,TPU v5p作为对标 H100和支撑 Gemini Ultra而生的期间产品,单个 TPU v5p Pod 可扩展至 8,960 个芯片,更重要的TPU v5p是首款针对 MoE(混合专家模型)通信模式深度优化的 TPU,其片间互联(ICI)带宽足以高效处理稀疏模型中频繁的专家路由请求,显著减少因通信瓶颈导致的算力空转。

与此同时,Google 推出了主打性价比的 TPU v5e,采用2 D Torus 组网,针对成本和效益较高的推理和中小型训练场景任务核心进行单位能效比和投入产出比的优化,对于绝大多数企业级微调和扐任务的性价比远超英伟达 A100/H100,这也是 Google Cloud 能吸引大量独角兽客户的核心原因。

图 3: TPU v4 / v5p / Ironwood 的参数对比

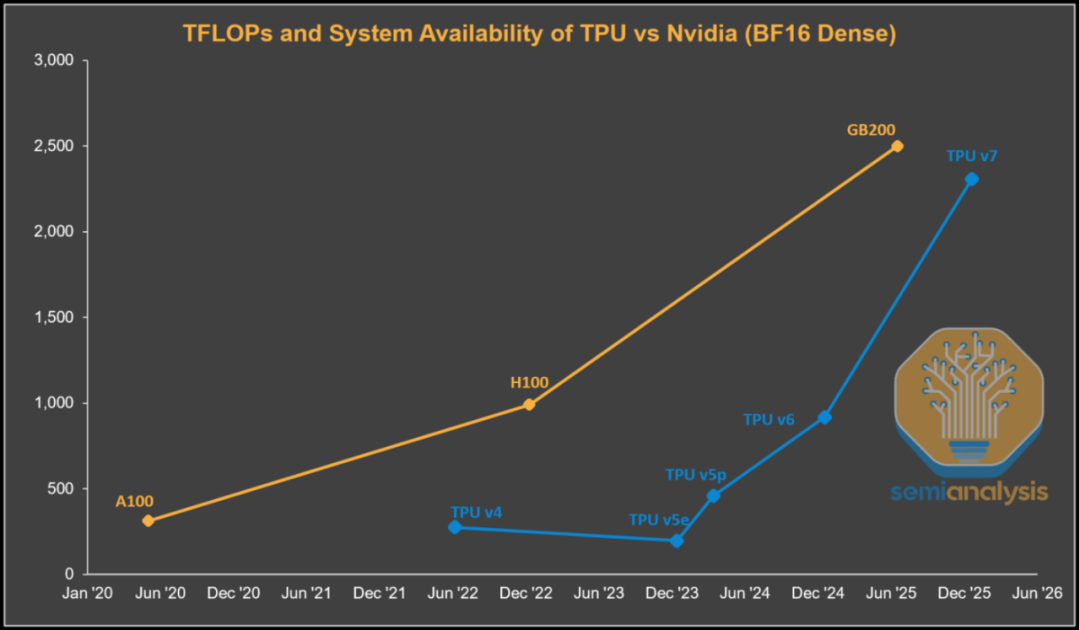

2024年推出的TPU v6 (Trillium)是当下的主力产品之一,采用了第三代 SparseCore 加速器,专门增强处理推荐系统、排名模型和具有海量词汇嵌入的大型语言模型中日常使用的超大嵌入的能力。TPU v6 (Trillium)将矩阵乘法单元从 128×128 扩展到 256×256 个乘法累加器,标志着另一个架构拐点的到来。从下图可以看出,TPUv4和 TPU v5的计算吞吐量远低于当时的英伟达旗舰产品,TPUv6的FLOPs性能非常接近H100/H200 。

图4:Google TPU代际演进与英伟达旗舰产品对比

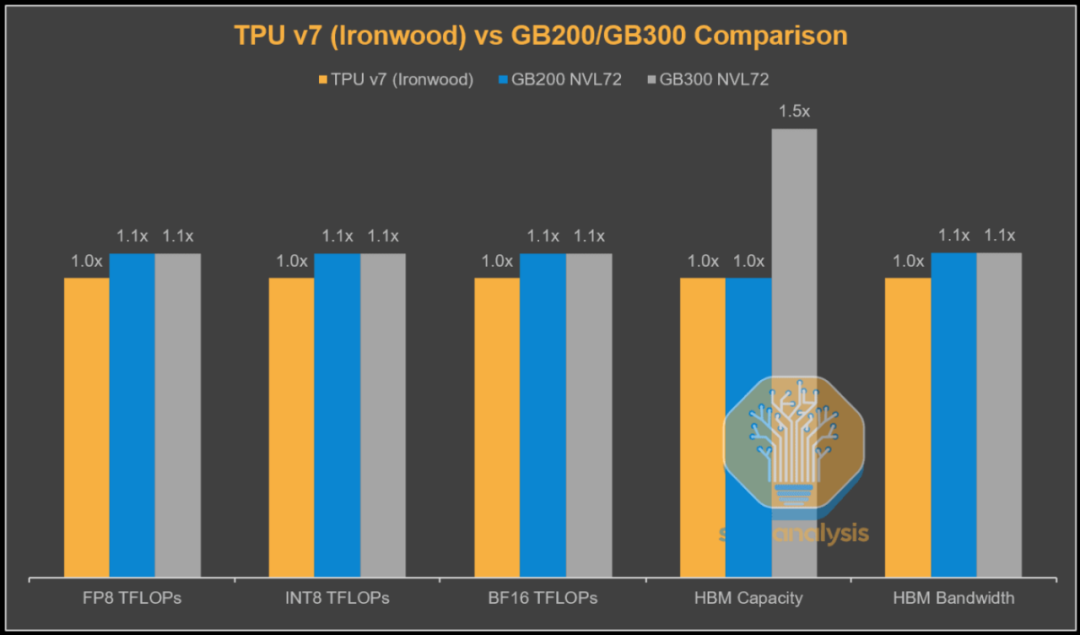

而Google 最近推出的面向智能体互联时代的下一代旗舰产品 TPU v7 (Ironwood) , 如下图 在浮点运算性能、显存容量和带宽方面与英伟达的旗舰产品如GB200和GB300的差距已经非常小了,但由于TPU v7 (Ironwood)采用8芯HBM3E 显存,与配备288GB 12芯HBM3E 显存的GB300相比,容量差距仍然很大 , 而采用完整3D Torus配置的Ironwood芯片的总拥有成本(TCO)比GB200/GB300服务器的TCO至少低约40%,况且采用ICI 3D Torus和OCS 技术可以实现单POD最高9,216 颗TPU芯片,远超英伟达GB200/GB300 NV72、NV144,国内曙光ScaleX640、昇腾384、阿里磐久AL128。

图 5 : TPU v7 (Ironwood) VS GB200/GB300

3

软硬一体全栈体系化护城河

市场上有一种声音认为 Google TPU 是在跟 Nvidia GPU“抢地盘” , 个人有一点点不认可,本质上两者是在不同维度上的产生的竞争。如果说英伟达是卖铲子的,那么Google既自己造铲子,也自己挖金子,也是全世界少数拥有 芯片、编译器、框架、模型以及应用 的 全产业链 一条龙 服务 的公司 , 利用“训推一体 TPU 芯片 + PyTorch XLA/JAX 原生编译器 + TensorFlow/JAX 框架 + Gemini 模型 + Search/YouTube/Workspace 应用入口” 等软硬件全栈体系对英伟达的“GPU + CUDA”发起全方位的挑战。

而国内有类似 从底层物理到上层应用完全打通的 全栈生态闭环的公司如阿里巴巴:平头哥含光NPU / 倚天 CPU 系列 + 飞天云计算平台 + 通义千问(Qwen) + 钉钉/夸克等应用入口。与Google的苹果闭环生态不同,阿里巴巴走的是安卓开放路线,通义千问(Qwen) 目前已成为全球最具影响力的开源大模型之一 , 根据 Hugging Face 官方统计及阿里云披露信息, 当前 Hugging Face 平台上基于 Qwen 系列(含 Qwen2.5、Qwen3 等)开发的衍生模型(Derivative Models)已超过 68,000 个,稳居全球开源模型生态第二位,仅次于 Meta 的 Llama 系列;此外,为了适应国内复杂的算力环境, 通义千问(Qwen) 全面支持 MindSpore、PyTorch、TensorFlow 等主流深度学习框架 以及兼容 NVIDIA GPU、昇腾 NPU、寒武纪 MLU等异构算力平台。

以下为三大科技巨头从基础设施到上层应用的全栈架构横向对比:

架构层级 | Nvidia | Alibaba | |

|---|---|---|---|

生态位类比 | 苹果iOS | Windows + Intel | 安卓Android |

商业模式 | 造铲子也挖金子 | 卖铲子 | 出租万能铲子也挖金子 |

云基础架构OS | Borg /Jupiter | DGX Cloud /Base Command | 飞天云操作系统 |

核心算力芯片 | TPU v5p/v6/v7 | A100/H100/GB200/GB300 | 含光NPU/兼容异构算力 |

互联与网络 | OCS+ ICI + 3D Torus | NVLink + InfiniBand | 洛神HPN高性能网络 |

AI工程化平台 | Vertex AI | NVIDIA NIM | PAI (Platform for AI) |

编译器/框架 | XLA /JAX /TensorFlow | CUDA / CuDNN | PAI / 兼容MindSpore |

核心大模型 | Gemini | Nemotron / Megatron | 通义千问(Qwen) |

上层应用入口 | 搜索/YouTube /Android | Omniverse(B端) | 钉钉 /夸克 /淘宝 |

4

思考:AI时代的马太效应

面向AGI时代,单纯依靠堆砌GPU/TPU算力大力出奇迹的时代已经过去,未来的竞争是“ AI 基础设施 + 模型平台 + 应用生态 ”的全方位、体系化作战。

我们即将见证AI时代的马太效应:极致的算力底座加速了模型的摩尔定律式迭代,从而催生出具有市场统治力的现象级应用,而卓越的产品体验增强了用户粘性和社交裂变效应,由此沉淀的海量高价值数据要素, 背后的数据挖掘和商业变现效果又能进一步反哺底层算力需求和模型迭代开发,形成一个正向飞轮 。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-12-06,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读