DeepSeek-V3.2四大颠覆性亮点

原创DeepSeek-V3.2四大颠覆性亮点

原创

走向未来

发布于 2025-12-06 20:33:50

发布于 2025-12-06 20:33:50

DeepSeek-V3.2四大颠覆性亮点

DeepSeek-V3.2不仅仅是一次常规的模型迭代,更是颠覆性地挑战了顶尖闭源模型。本文将深入其技术论文,为您提炼出四个最具影响力的突破。

本报告的PDF版本以及更多DeepSeek大模型相关的资料都已收录到“走向未来”知识星球中,推荐这个极具价值知识星球“走向未来”,获取生成式人工智能、大模型、AIGC、AI芯片和机器人等的产品、技术和应用实践的资料。

053.jpg

1.性能顶尖

第一个核心亮点是: DeepSeek-V3.2 作为一款开源模型,在多项关键的推理基准测试中,其性能表现已能与 GPT-5 等顶尖闭源模型相媲美。

这一结果的关键在于,它标志着开源模型首次在公认的复杂推理基准上,与最顶尖的闭源模型实现了性能对等,而非简单的追赶。论文中的结论清晰明确:

"DeepSeek-V3.2 achieves similar performance with Kimi-k2-thinking and GPT-5 across multiple reasoning benchmarks."

为了更直观地展示这一点,我们从论文的推理能力图表中提取了关键数据进行对比:

推理基准测试 (Reasoning Benchmark) | DeepSeek-V3.2-Thinking (Pass@1) | GPT-5-High (Pass@1) |

|---|---|---|

AIME 2025 | 93.1 | 94.6 |

HMMT 2025 (Feb)* | 92.5 | 88.3 |

*注:HMMT 2025 数据为二月份竞赛成绩。 | ||

重要性分析: 这一成就意义非凡。它标志着开源社区在追赶最前沿技术方面取得了里程碑式的进展,有力地打破了顶级性能被少数科技巨头垄断的局面。开发者和研究者现在可以基于一个性能与顶级闭源模型相当的开源基础,进行更多的创新和应用探索。

2. 在国际顶尖奥赛中斩获金牌的“Speciale”版大模型

如果说与 GPT-5 性能相当还不够震撼,那么 DeepSeek-V3.2 推出的实验性高算力变体 DeepSeek-V3.2-Speciale,则将模型的推理极限推向了新的高度。

其惊人成就在于: 该模型在国际顶级的数学与信息学竞赛中,均取得了金牌水平的表现。值得注意的是,其在编程竞赛中的优异成绩是在未针对这些特定赛事进行训练的情况下取得的,而其数学证明能力则通过融合专门的数据与方法得到了增强。这种精准的能力塑造展示了其架构的强大潜力。

论文对此的描述毫不掩饰其突破性:

Notably, our high-compute variant, DeepSeek-V3.2-Speciale, surpasses GPT-5 and exhibits reasoning proficiency on par with Gemini-3.0-Pro, achieving gold-medal performance in both the 2025 International Mathematical Olympiad (IMO) and the International Olympiad in Informatics (IOI).

具体战绩如下:

- IMO 2025 (国际数学奥林匹克): 获得 35/42 分,达到金牌水平。

- IOI 2025 (国际信息学奥林匹克): 获得 492/600 分,达到金牌水平。

- ICPC WF 2025 (国际大学生程序设计竞赛世界总决赛): 解决 10/12 个问题,达到金牌水平。

意义解读: 这已远不止是跑分上的胜利。它代表了模型在极其复杂的抽象推理、逻辑演绎和问题解决能力上,真正达到了人类顶尖选手的水平。这是开源模型前所未有的高度,证明了其架构和训练方法的巨大潜力。

3. 更强大且更高效:DSA 稀疏注意力机制

强大的性能背后往往是高昂的计算成本,尤其是在处理长文本时。传统注意力机制(vanilla attention)的 O(L²) 计算复杂度一直是限制模型处理长序列效率的“严重制约 (severely constrains efficiency)”。

DeepSeek-V3.2 的核心创新之一就是引入了 DeepSeek Sparse Attention (DSA) 机制来解决这个问题。 DSA 并非简单地进行近似计算,而是一种结构性的优化,其主要由两个组件构成:一个“闪电索引器 (lightning indexer)”和一个“细粒度令牌选择机制 (fine-grained token selection mechanism)”。索引器高效地计算出每个查询令牌(query token)与先前所有令牌的关联分数,然后选择机制仅检索得分最高的 k 个键值对(key-value pairs)进行核心注意力计算。这使得注意力复杂度从 O(L²) 戏剧性地降低到 O(Lk),其中 k 远小于序列长度 L。

实际收益是显而易见的。 从论文的成本对比图(Figure 3)可以看出,在处理 128K 的长文本时,DeepSeek-V3.2 的推理成本(每百万 Token 的成本)相比于前代 V3.1 有了显著下降,尤其是在处理序列的后半部分时,成本优势更加明显。

影响力分析: 这一架构创新使得在长上下文场景中部署和使用高性能大模型变得更加经济和可行。它极大地降低了先进 AI 技术的应用门槛,对于需要处理海量文档、代码库或进行长时间对话的实际应用场景来说,意义重大。

4. AI 训练 AI:大规模“智能体任务合成”流水线的威力

如何让模型学会像一个智能体(Agent)一样,在复杂的交互环境中理解指令、使用工具并完成任务?这是当前 AI 领域的一大核心挑战,其关键瓶颈在于高质量、多样化且足够复杂的智能体训练数据极其稀缺。

DeepSeek 团队为此开发了一套创新的“大规模智能体任务合成流水线 (large-scale agentic task synthesis pipeline)”。 这套系统能够自动化地生成海量的、高质量的智能体训练任务,从而系统性地解决数据稀缺问题。

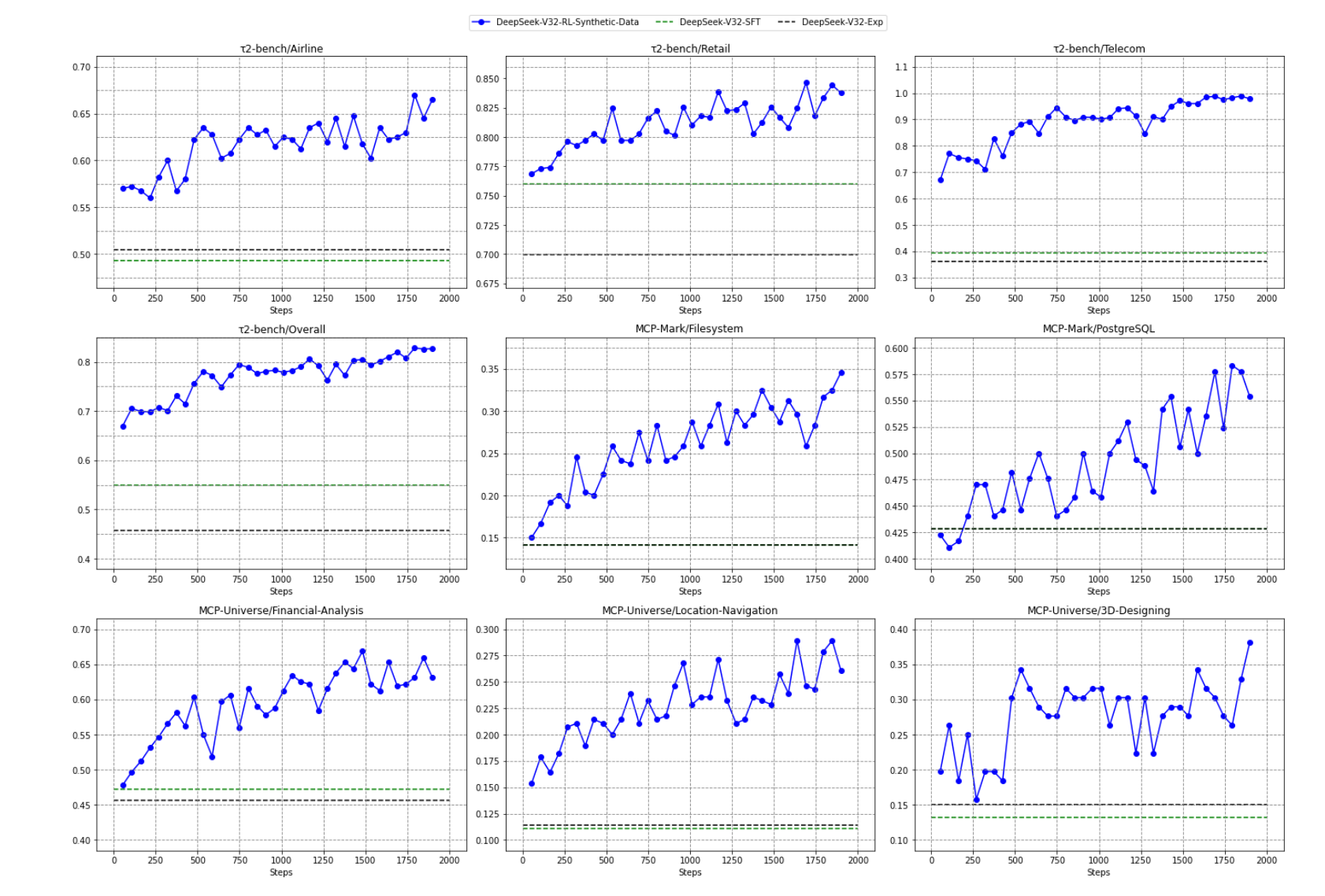

其规模令人印象深刻: 他们通过这种方法生成了超过 1,800 个不同的模拟环境和 85,000 个复杂任务提示,用于驱动模型的强化学习(RL)过程。这些任务涵盖了行程规划、代码调试、网络搜索等多种复杂场景。

../c/007.jpg

其有效性也得到了验证。 论文中的实验结果显示,仅仅在这些合成数据上进行强化学习训练,模型在多个真实的智能体基准测试(如 τ2-bench, MCP-Mark)上就取得了“实质性的提升 (substantial improvements)”。这证明了这种“AI 生成数据”的方法具有强大的泛化能力,模型学到的技能可以成功迁移到从未见过的真实世界任务中。

前瞻性解读: 这种“用 AI 创造数据来训练更强 AI”的模式,代表了未来模型能力扩展的一个关键战略方向。它不仅是一种新颖的训练方法,更是解决 AI 发展核心瓶颈——高质量、大规模、多样化训练数据稀缺性——的潜在方案。通过自动化和规模化的方式,它为训练出更强大、更通用的 AI 智能体铺平了道路。

结论

DeepSeek-V3.2的四大突破——顶尖性能、在世界顶尖竞赛中夺金的卓越能力、大幅提升效率的 DSA 稀疏架构,以及创新的“AI 训练 AI”范式。随着 DeepSeek-V3.2 的出现,开源与闭源 AI 之间的界限变得前所未有的模糊。这个由强大且易于获取的模型开启的新时代,下一步将为我们解锁怎样的未来?

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读