020_具身人工智能的人机协作安全与信任机制:从协同感知到责任共担的安全框架

020_具身人工智能的人机协作安全与信任机制:从协同感知到责任共担的安全框架

安全风信子

发布于 2025-11-19 13:50:40

发布于 2025-11-19 13:50:40

引言

随着具身人工智能(Embodied AI)系统在2025年的广泛应用,人机协作已成为具身AI技术价值实现的核心模式。与传统的人机交互不同,具身AI通过物理实体与人类进行直接、动态的协作,在医疗、制造业、服务业等领域展现出巨大潜力。然而,这种深度的物理协作也带来了前所未有的安全挑战和信任问题。本章将全面探讨具身AI人机协作的安全框架和信任机制,从协同感知、意图理解到责任共担,构建一个完整的安全保障体系,为人机协作的安全实践提供理论指导和技术参考。

人机协作的理论基础

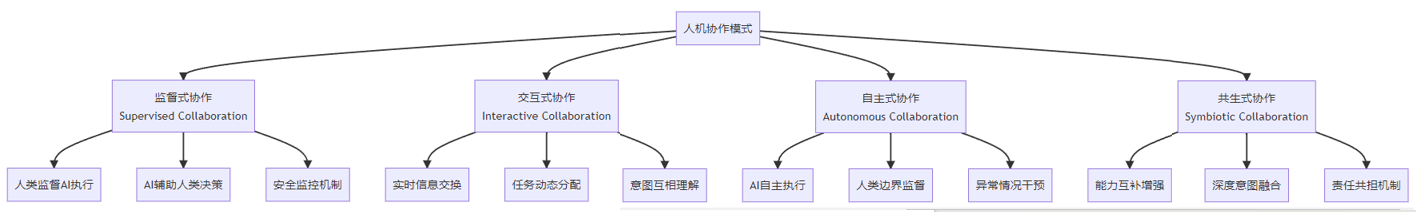

1. 协作模型分类

具身AI与人类协作的主要模式分类:

2. 协作认知理论

支撑人机有效协作的认知理论基础:

- 共同意图理论:人类与AI形成共同目标的认知机制

- 心理理论扩展:AI对人类心理状态的理解能力

- 情境认知:基于情境的协作理解和适应

- 分布式认知:认知负载在人类和AI之间的合理分配

- 预测性认知:预测协作伙伴行为的能力

3. 协作安全原则

人机协作安全的核心原则:

- 安全性优先:安全永远是首要考虑因素

- 可预测性:AI行为应保持可预测性

- 可解释性:AI决策和行为应可被人类理解

- 可控性:人类应能有效控制和干预AI行为

- 适应性:系统应能适应不同的协作情境和用户需求

- 透明性:系统状态和能力应当透明

人机协同感知机制

1. 共享感知空间

构建人机共享的感知理解:

- 多模态信息融合:整合人类和AI的感知信息

- 情境构建:共同构建对当前情境的理解

- 注意力同步:确保人类和AI关注相同的重要信息

- 意图推测:互相推测对方的意图和目标

- 不确定性管理:共同处理感知和理解中的不确定性

2. 意图理解与表达

有效理解和表达协作意图:

意图类型 | AI理解方法 | 人类表达方式 | 验证机制 | 安全考量 |

|---|---|---|---|---|

指令意图 | 自然语言处理、手势识别 | 语言指令、手势信号 | 指令确认机制 | 防止误解和误执行 |

目标意图 | 意图推理、目标识别 | 任务描述、目标指示 | 目标一致性检查 | 确保目标安全合法 |

协作意图 | 行为模式识别、上下文理解 | 协作信号、交互行为 | 协作协议验证 | 防止协作冲突 |

反馈意图 | 情绪识别、行为分析 | 表情反馈、行为反馈 | 反馈有效性评估 | 确保反馈被正确理解 |

边界意图 | 规则理解、限制识别 | 边界设定、约束说明 | 边界一致性确认 | 防止越界行为 |

3. 协同感知安全挑战

协同感知中的安全挑战:

- 感知偏差:人类和AI的感知差异导致的协作偏差

- 意图误解:对协作伙伴意图的错误理解

- 信息不对称:协作双方信息获取和理解的不平衡

- 情境误判:对当前情境的错误判断

- 注意力分散:协作过程中的注意力管理问题

人机信任机制构建

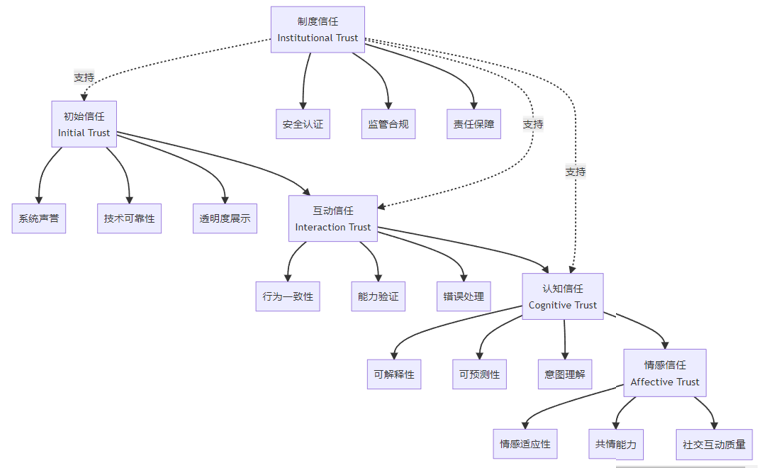

1. 信任建立模型

人机协作中的信任建立过程:

2. 信任评估框架

量化和评估人机信任的框架:

- 信任度量指标:多维度的信任评估指标体系

- 信任动态建模:信任随时间和交互变化的动态模型

- 信任阈值设定:基于任务风险的信任阈值设定

- 信任恢复机制:信任受损后的恢复机制

- 自适应信任调整:根据协作表现自动调整信任水平

3. 信任管理策略

有效管理和维护人机信任的策略:

- 透明沟通:AI状态和决策的透明沟通

- 能力诚实:如实展示AI能力边界

- 错误公开:坦诚承认和处理错误

- 持续学习:基于交互不断改进

- 用户反馈:重视和响应用户反馈

人机协作安全架构

1. 多层次安全防护

具身AI人机协作的多层次安全架构:

# 具身AI人机协作安全架构框架示例

class HumanRobotCollaborationSecurityFramework:

def __init__(self, system_config):

"""

初始化人机协作安全框架

参数:

system_config: 系统配置信息,包含各安全层级的设置

"""

self.system_id = system_config.get("system_id", "hrcs_framework")

self.collaboration_mode = system_config.get("collaboration_mode", "supervised")

# 初始化各安全层级

self.physical_security = PhysicalSecurityLayer(system_config.get("physical_security", {}))

self.perception_security = PerceptionSecurityLayer(system_config.get("perception_security", {}))

self.decision_security = DecisionSecurityLayer(system_config.get("decision_security", {}))

self.communication_security = CommunicationSecurityLayer(system_config.get("communication_security", {}))

self.supervision_security = SupervisionSecurityLayer(system_config.get("supervision_security", {}))

# 安全状态管理

self.security_state = {

"overall_level": "unknown",

"layer_states": {},

"risk_assessment": {},

"safety_measures": {}

}

# 协作安全规则

self.collaboration_rules = system_config.get("collaboration_rules", [])

# 安全日志

self.security_logs = []

def initialize_security(self):

"""

初始化各安全层级

"""

# 初始化物理安全层

self.physical_security.initialize()

# 初始化感知安全层

self.perception_security.initialize()

# 初始化决策安全层

self.decision_security.initialize()

# 初始化通信安全层

self.communication_security.initialize()

# 初始化监督安全层

self.supervision_security.initialize()

# 更新系统安全状态

self.update_security_state()

self._log_security_event("system_initialized", {

"system_id": self.system_id,

"collaboration_mode": self.collaboration_mode,

"timestamp": self._get_current_timestamp()

})

def update_security_state(self):

"""

更新系统整体安全状态

"""

# 收集各层安全状态

physical_state = self.physical_security.get_security_state()

perception_state = self.perception_security.get_security_state()

decision_state = self.decision_security.get_security_state()

communication_state = self.communication_security.get_security_state()

supervision_state = self.supervision_security.get_security_state()

# 更新层状态

self.security_state["layer_states"] = {

"physical": physical_state,

"perception": perception_state,

"decision": decision_state,

"communication": communication_state,

"supervision": supervision_state

}

# 评估整体风险

risk_level = self._assess_overall_risk()

self.security_state["risk_assessment"] = {

"level": risk_level,

"timestamp": self._get_current_timestamp(),

"contributing_factors": self._identify_risk_factors()

}

# 确定安全措施

safety_measures = self._determine_safety_measures(risk_level)

self.security_state["safety_measures"] = safety_measures

# 设置整体安全级别

self.security_state["overall_level"] = self._determine_security_level(risk_level)

return self.security_state

def _assess_overall_risk(self):

"""

评估系统整体风险级别

返回:

风险级别: "low", "medium", "high", "critical"

"""

# 获取各层风险级别

physical_risk = self.security_state["layer_states"]["physical"].get("risk_level", "medium")

perception_risk = self.security_state["layer_states"]["perception"].get("risk_level", "medium")

decision_risk = self.security_state["layer_states"]["decision"].get("risk_level", "medium")

communication_risk = self.security_state["layer_states"]["communication"].get("risk_level", "medium")

supervision_risk = self.security_state["layer_states"]["supervision"].get("risk_level", "medium")

# 风险级别映射到数值

risk_values = {

"low": 1,

"medium": 2,

"high": 3,

"critical": 4

}

# 计算风险值

risk_scores = [

risk_values.get(physical_risk, 2),

risk_values.get(perception_risk, 2),

risk_values.get(decision_risk, 2),

risk_values.get(communication_risk, 2),

risk_values.get(supervision_risk, 2)

]

# 计算加权平均风险值(物理安全权重更高)

weights = [1.5, 1.0, 1.0, 1.0, 1.2]

weighted_score = sum(r * w for r, w in zip(risk_scores, weights)) / sum(weights)

# 根据加权分数确定风险级别

if weighted_score <= 1.3:

return "low"

elif weighted_score <= 2.0:

return "medium"

elif weighted_score <= 3.0:

return "high"

else:

return "critical"

def _identify_risk_factors(self):

"""

识别主要风险因素

返回:

风险因素列表

"""

risk_factors = []

# 从各层收集风险因素

for layer_name, layer_state in self.security_state["layer_states"].items():

layer_factors = layer_state.get("risk_factors", [])

for factor in layer_factors:

risk_factors.append({

"layer": layer_name,

"factor": factor,

"severity": layer_state.get("risk_level", "medium")

})

return risk_factors

def _determine_safety_measures(self, risk_level):

"""

根据风险级别确定安全措施

参数:

risk_level: 风险级别

返回:

安全措施字典

"""

safety_measures = {

"required": [],

"recommended": []

}

# 基础安全措施(所有风险级别都需要)

base_measures = [

"continuous_monitoring",

"emergency_stop_capability",

"collision_detection"

]

safety_measures["required"].extend(base_measures)

# 根据风险级别添加额外措施

if risk_level == "low":

safety_measures["recommended"].extend([

"periodic_system_checks",

"user_awareness_reminders"

])

elif risk_level == "medium":

safety_measures["required"].extend([

"enhanced_supervision",

"slower_operation_speed"

])

safety_measures["recommended"].extend([

"additional_sensor_verification"

])

elif risk_level == "high":

safety_measures["required"].extend([

"human_in_the_loop",

"reduced_operational_space",

"mandatory_verification_steps",

"slowest_operation_speed"

])

elif risk_level == "critical":

safety_measures["required"].extend([

"immediate_system_pause",

"full_human_control",

"safety_inspection_required"

])

return safety_measures

def _determine_security_level(self, risk_level):

"""

根据风险级别确定整体安全级别

参数:

risk_level: 风险级别

返回:

安全级别

"""

security_mapping = {

"low": "safe",

"medium": "caution",

"high": "warning",

"critical": "unsafe"

}

return security_mapping.get(risk_level, "unknown")

def validate_collaboration_request(self, request):

"""

验证协作请求的安全性

参数:

request: 协作请求对象,包含任务、环境、参与者信息

返回:

验证结果和安全建议

"""

# 首先更新安全状态

self.update_security_state()

# 检查系统整体安全状态

if self.security_state["overall_level"] == "unsafe":

return {

"valid": False,

"reason": "系统当前处于不安全状态",

"required_actions": self.security_state["safety_measures"]["required"],

"risk_level": self.security_state["risk_assessment"]["level"]

}

# 验证协作规则合规性

rule_violations = self._check_rule_compliance(request)

if rule_violations:

return {

"valid": False,

"reason": "协作请求违反安全规则",

"rule_violations": rule_violations,

"risk_level": "high"

}

# 执行任务风险评估

task_risk = self._assess_task_risk(request.get("task", {}))

if task_risk["level"] == "critical":

return {

"valid": False,

"reason": "任务风险过高",

"risk_details": task_risk,

"risk_level": "critical"

}

# 生成协作安全建议

safety_recommendations = self._generate_safety_recommendations(request, task_risk)

return {

"valid": True,

"risk_level": max(self.security_state["risk_assessment"]["level"], task_risk["level"]),

"safety_measures": self.security_state["safety_measures"],

"recommendations": safety_recommendations,

"timestamp": self._get_current_timestamp()

}

def _check_rule_compliance(self, request):

"""

检查协作请求是否违反安全规则

返回:

规则违反列表

"""

violations = []

# 简化实现,实际应根据具体规则进行检查

task_type = request.get("task", {}).get("type", "unknown")

required_certification = request.get("task", {}).get("required_certification", None)

# 示例规则检查

if task_type == "high_risk" and not required_certification:

violations.append({

"rule_id": "task_001",

"rule_desc": "高风险任务需要认证",

"violation_type": "missing_requirement"

})

return violations

def _assess_task_risk(self, task):

"""

评估特定任务的风险

返回:

任务风险评估结果

"""

# 简化实现,实际应考虑更多因素

task_type = task.get("type", "unknown")

complexity = task.get("complexity", "medium")

precision_required = task.get("precision_required", "medium")

environment_hazards = task.get("environment_hazards", [])

# 基于任务属性评估风险

risk_factors = []

if task_type == "high_risk":

risk_factors.append("high_risk_task_type")

if complexity == "high":

risk_factors.append("high_complexity")

if precision_required == "high":

risk_factors.append("high_precision_required")

if len(environment_hazards) > 0:

risk_factors.append(f"{len(environment_hazards)}_environmental_hazards")

# 确定风险级别

if len(risk_factors) >= 3 or task_type == "high_risk" and complexity == "high":

risk_level = "critical"

elif len(risk_factors) == 2 or task_type == "high_risk":

risk_level = "high"

elif len(risk_factors) == 1 or complexity == "high":

risk_level = "medium"

else:

risk_level = "low"

return {

"level": risk_level,

"factors": risk_factors,

"timestamp": self._get_current_timestamp()

}

def _generate_safety_recommendations(self, request, task_risk):

"""

生成协作安全建议

参数:

request: 协作请求

task_risk: 任务风险评估

返回:

安全建议列表

"""

recommendations = []

# 基于风险级别生成建议

if task_risk["level"] == "high" or task_risk["level"] == "critical":

recommendations.append({

"type": "supervision",

"detail": "建议增加人工监督频率",

"priority": "high"

})

recommendations.append({

"type": "verification",

"detail": "建议增加中间结果验证步骤",

"priority": "high"

})

# 检查特定风险因素

if "high_precision_required" in task_risk["factors"]:

recommendations.append({

"type": "calibration",

"detail": "建议在任务开始前进行精度校准",

"priority": "medium"

})

if "environmental_hazards" in str(task_risk["factors"]):

recommendations.append({

"type": "awareness",

"detail": "建议对环境危险进行额外的感知监控",

"priority": "medium"

})

return recommendations

def monitor_collaboration(self, collaboration_state):

"""

监控协作过程的安全性

参数:

collaboration_state: 当前协作状态信息

返回:

监控结果和安全警报(如有)

"""

# 更新安全状态

self.update_security_state()

# 检查各层安全状态

alerts = []

# 物理安全监控

physical_alerts = self.physical_security.monitor_state(collaboration_state.get("physical_state", {}))

alerts.extend(physical_alerts)

# 感知安全监控

perception_alerts = self.perception_security.monitor_state(collaboration_state.get("perception_state", {}))

alerts.extend(perception_alerts)

# 决策安全监控

decision_alerts = self.decision_security.monitor_state(collaboration_state.get("decision_state", {}))

alerts.extend(decision_alerts)

# 通信安全监控

communication_alerts = self.communication_security.monitor_state(collaboration_state.get("communication_state", {}))

alerts.extend(communication_alerts)

# 监督安全监控

supervision_alerts = self.supervision_security.monitor_state(collaboration_state.get("supervision_state", {}))

alerts.extend(supervision_alerts)

# 评估整体监控结果

critical_alerts = [a for a in alerts if a["severity"] == "critical"]

high_alerts = [a for a in alerts if a["severity"] == "high"]

# 确定响应级别

if critical_alerts:

response_level = "emergency"

required_actions = ["immediate_stop", "human_intervention"]

elif high_alerts:

response_level = "warning"

required_actions = ["reduce_speed", "enhanced_monitoring"]

else:

response_level = "normal"

required_actions = []

# 记录监控事件

self._log_security_event("collaboration_monitor", {

"response_level": response_level,

"alerts_count": len(alerts),

"collaboration_id": collaboration_state.get("collaboration_id", "unknown"),

"timestamp": self._get_current_timestamp()

})

return {

"status": "safe" if response_level == "normal" else "unsafe",

"response_level": response_level,

"alerts": alerts,

"required_actions": required_actions,

"security_state": self.security_state,

"timestamp": self._get_current_timestamp()

}

def handle_safety_incident(self, incident):

"""

处理安全事件

参数:

incident: 安全事件信息

返回:

处理结果和恢复建议

"""

# 记录安全事件

self._log_security_event("safety_incident", incident)

# 评估事件严重程度

severity = incident.get("severity", "unknown")

# 根据严重程度采取措施

if severity == "critical":

# 启动紧急响应

emergency_response = self._initiate_emergency_response(incident)

return {

"status": "emergency_response_active",

"response": emergency_response,

"recommendations": ["系统全面检查", "人工接管控制", "安全审计"]

}

elif severity == "high":

# 启动高级响应

high_response = self._initiate_high_response(incident)

return {

"status": "high_response_active",

"response": high_response,

"recommendations": ["受影响子系统检查", "操作参数调整"]

}

else:

# 普通响应

normal_response = self._initiate_normal_response(incident)

return {

"status": "normal_response_active",

"response": normal_response,

"recommendations": ["监控事件发展", "预防类似事件"]

}

def _initiate_emergency_response(self, incident):

"""

启动紧急响应措施

"""

return {

"actions": [

"immediate_system_shutdown",

"notification_to_safety_personnel",

"incident_logging",

"evidence_preservation"

],

"timestamp": self._get_current_timestamp()

}

def _initiate_high_response(self, incident):

"""

启动高级响应措施

"""

return {

"actions": [

"affected_subsystem_isolation",

"reduced_operation_mode",

"enhanced_monitoring",

"maintenance_notification"

],

"timestamp": self._get_current_timestamp()

}

def _initiate_normal_response(self, incident):

"""

启动普通响应措施

"""

return {

"actions": [

"incident_documentation",

"preventive_measures_review",

"system_status_check"

],

"timestamp": self._get_current_timestamp()

}

def generate_safety_report(self, time_range=None):

"""

生成安全报告

参数:

time_range: 可选的时间范围过滤

返回:

安全报告对象

"""

# 更新最新安全状态

self.update_security_state()

# 过滤日志(如果提供了时间范围)

if time_range:

filtered_logs = [log for log in self.security_logs

if time_range["start"] <= log["timestamp"] <= time_range["end"]]

else:

filtered_logs = self.security_logs

# 统计安全事件

incidents = [log for log in filtered_logs if log["event_type"] == "safety_incident"]

monitor_events = [log for log in filtered_logs if log["event_type"] == "collaboration_monitor"]

# 生成报告

report = {

"system_id": self.system_id,

"generated_at": self._get_current_timestamp(),

"current_security_state": self.security_state,

"incident_statistics": {

"total_incidents": len(incidents),

"critical_incidents": len([i for i in incidents if i["details"].get("severity") == "critical"]),

"high_incidents": len([i for i in incidents if i["details"].get("severity") == "high"])

},

"monitoring_summary": {

"total_monitoring_events": len(monitor_events),

"warning_triggers": len([m for m in monitor_events if m["details"].get("response_level") == "warning"]),

"emergency_triggers": len([m for m in monitor_events if m["details"].get("response_level") == "emergency"])

},

"recommendations": self._generate_improvement_recommendations()

}

return report

def _generate_improvement_recommendations(self):

"""

生成安全改进建议

"""

recommendations = []

# 基于当前安全状态生成建议

if self.security_state["overall_level"] != "safe":

recommendations.append({

"area": "overall_security",

"detail": "提高系统整体安全状态",

"priority": "high"

})

# 检查各层安全状态

for layer_name, layer_state in self.security_state["layer_states"].items():

if layer_state.get("risk_level") == "high" or layer_state.get("risk_level") == "critical":

recommendations.append({

"area": layer_name,

"detail": f"降低{layer_name}层的风险级别",

"priority": "high"

})

# 添加常规改进建议

recommendations.append({

"area": "training",

"detail": "定期进行人机协作安全培训",

"priority": "medium"

})

recommendations.append({

"area": "testing",

"detail": "加强安全场景测试覆盖",

"priority": "medium"

})

return recommendations

def _log_security_event(self, event_type, details):

"""

记录安全事件

"""

event = {

"timestamp": self._get_current_timestamp(),

"event_type": event_type,

"details": details

}

self.security_logs.append(event)

def _get_current_timestamp(self):

"""

获取当前时间戳

"""

import datetime

return datetime.datetime.now().isoformat()

# 各安全层级的简化实现

class PhysicalSecurityLayer:

def __init__(self, config):

self.config = config

def initialize(self):

pass

def get_security_state(self):

return {"risk_level": "low", "risk_factors": []}

def monitor_state(self, state):

return []

class PerceptionSecurityLayer:

def __init__(self, config):

self.config = config

def initialize(self):

pass

def get_security_state(self):

return {"risk_level": "medium", "risk_factors": []}

def monitor_state(self, state):

return []

class DecisionSecurityLayer:

def __init__(self, config):

self.config = config

def initialize(self):

pass

def get_security_state(self):

return {"risk_level": "medium", "risk_factors": []}

def monitor_state(self, state):

return []

class CommunicationSecurityLayer:

def __init__(self, config):

self.config = config

def initialize(self):

pass

def get_security_state(self):

return {"risk_level": "low", "risk_factors": []}

def monitor_state(self, state):

return []

class SupervisionSecurityLayer:

def __init__(self, config):

self.config = config

def initialize(self):

pass

def get_security_state(self):

return {"risk_level": "low", "risk_factors": []}

def monitor_state(self, state):

return []

# 使用示例

def example_hrcs_framework():

# 定义系统配置

system_config = {

"system_id": "collaborative_robot_001",

"collaboration_mode": "interactive",

"physical_security": {

"emergency_stop": True,

"collision_detection": True,

"speed_limits": "enabled"

},

"perception_security": {

"human_detection": True,

"environment_monitoring": True

},

"collaboration_rules": [

{"rule_id": "task_001", "description": "高风险任务需要认证"},

{"rule_id": "interaction_001", "description": "保持安全距离"}

]

}

# 创建安全框架实例

security_framework = HumanRobotCollaborationSecurityFramework(system_config)

# 初始化安全系统

security_framework.initialize_security()

# 验证协作请求

collaboration_request = {

"task": {

"type": "assembly",

"complexity": "medium",

"precision_required": "high",

"environment_hazards": [],

"required_certification": True

},

"participants": ["human_001", "robot_001"],

"environment": "factory_floor"

}

validation_result = security_framework.validate_collaboration_request(collaboration_request)

print(f"协作请求验证结果: {'有效' if validation_result['valid'] else '无效'}")

print(f"风险级别: {validation_result['risk_level']}")

print(f"安全措施: {validation_result.get('safety_measures', {})}")

# 监控协作状态

collaboration_state = {

"collaboration_id": "collab_001",

"physical_state": {"distance": 0.5, "speed": 0.2},

"perception_state": {"human_detected": True, "obstacles": []},

"decision_state": {"current_action": "assembly", "next_action": "verification"},

"communication_state": {"signal_strength": "good", "latency": 10},

"supervision_state": {"human_attention": "focused", "system_status": "normal"}

}

monitoring_result = security_framework.monitor_collaboration(collaboration_state)

print(f"监控状态: {monitoring_result['status']}")

print(f"响应级别: {monitoring_result['response_level']}")

# 生成安全报告

safety_report = security_framework.generate_safety_report()

print(f"报告生成时间: {safety_report['generated_at']}")

print(f"当前安全状态: {safety_report['current_security_state']['overall_level']}")

return safety_report2. 安全交互协议

确保人机安全交互的通信协议:

- 意图明确性:确保意图表达的明确性和无歧义

- 状态同步:保持双方状态信息的实时同步

- 反馈确认:关键操作的反馈和确认机制

- 异常处理:异常情况的处理和恢复协议

- 优先级机制:在冲突情况下的优先级规则

3. 故障安全设计

人机协作中的故障安全设计原则:

- 失效安全:系统故障时的安全状态保障

- 冗余设计:关键功能的冗余实现

- 快速响应:紧急情况下的快速响应机制

- 降级运行:故障情况下的安全降级运行模式

- 自动恢复:从故障状态的自动安全恢复

责任共担机制

1. 责任分配框架

人机协作中的责任分配模型:

2. 可问责性设计

确保系统可问责性的设计原则:

- 行为可追溯:完整记录系统行为和决策过程

- 状态透明性:保持系统状态的透明度

- 边界明确性:明确系统能力和责任边界

- 错误可分析:支持对错误进行深入分析

- 改进可验证:验证改进措施的有效性

3. 法律与伦理责任

人机协作中的法律和伦理责任考量:

- 法律框架适配:现有法律框架对AI责任的适配

- 伦理责任界定:基于伦理原则的责任界定

- 责任保险机制:适应AI时代的责任保险

- 国际标准协调:国际间责任标准的协调

- 用户知情同意:确保用户了解潜在风险和责任

人机协作安全评估与认证

1. 安全评估方法

具身AI人机协作安全的评估方法:

- 形式化验证:使用数学方法验证系统安全性

- 模拟测试:在模拟环境中进行安全测试

- 原型验证:基于原型的安全验证

- 现场测试:在实际环境中的安全测试

- 第三方评估:独立第三方的安全评估

2. 风险评估框架

人机协作风险评估的系统化框架:

风险维度 | 评估因素 | 影响范围 | 风险缓解策略 | 责任主体 |

|---|---|---|---|---|

物理安全 | 机械伤害、碰撞、能量危险 | 人员安全、设备安全 | 安全距离、限速、急停 | 设计者、操作者 |

操作安全 | 任务复杂度、精度要求、环境变化 | 任务执行、结果质量 | 任务分解、辅助功能 | 协作双方 |

认知安全 | 意图误解、注意力分散、疲劳 | 决策质量、协作效率 | 意图确认、状态反馈 | 协作双方 |

系统安全 | 传感器故障、通信中断、控制失效 | 系统可靠性、安全运行 | 冗余设计、监控告警 | 设计者、维护者 |

社会安全 | 隐私泄露、数据滥用、关系异化 | 个人权益、社会关系 | 数据保护、伦理设计 | 开发者、组织 |

3. 安全认证标准

推动具身AI人机协作的安全认证标准:

- 国际标准:ISO、IEC等国际标准组织的相关标准

- 行业标准:特定行业的安全标准和规范

- 认证流程:系统的安全认证流程和要求

- 持续认证:系统生命周期内的持续认证机制

- 区域差异:不同地区认证标准的差异和协调

应用案例与最佳实践

1. 医疗领域人机协作

医疗环境中的人机协作安全实践:

- 手术辅助机器人:严格的安全边界和操作限制

- 康复辅助系统:个性化的安全监控和适应

- 药物配送机器人:多重验证和安全协议

- 诊断辅助系统:决策透明度和医生监督

- 患者监护系统:异常检测和紧急响应

2. 工业制造人机协作

工业环境中的人机协作安全应用:

- 协作机器人:安全感知和自适应速度控制

- 装配辅助系统:任务分解和精度保障

- 质量检测协作:人机优势互补的质量检测

- 危险环境作业:远程操作和自主协作

- 维护和修理:指导和辅助的协作模式

3. 服务领域人机协作

服务环境中的人机协作安全实践:

- 老年人护理机器人:安全监控和紧急援助

- 酒店服务机器人:环境适应和安全导航

- 教育辅助机器人:内容安全和互动适当性

- 零售服务系统:客户识别和个性化服务

- 公共场所引导:人群安全和紧急疏散辅助

4. 安全最佳实践总结

人机协作安全的关键最佳实践:

- 持续风险评估:定期进行全面风险评估

- 分级安全策略:根据风险等级采取不同安全措施

- 培训与教育:对所有参与者进行安全培训

- 渐进式部署:从低风险场景开始,逐步扩展

- 持续改进:基于实际经验不断改进安全措施

未来发展趋势与挑战

1. 技术发展趋势

人机协作安全的未来技术发展方向:

- 增强现实协作:AR技术辅助的人机协作

- 脑机接口:直接的神经信号交互

- 情感计算:理解和适应人类情感状态

- 自主学习:持续学习和改进的协作能力

- 多智能体协作:多AI与多人的复杂协作

2. 研究挑战

当前面临的主要研究挑战:

- 共同意图建模:更精确的共同意图建模

- 责任形式化:责任分配的形式化表达

- 可解释性增强:提高复杂决策的可解释性

- 自适应安全:根据上下文自适应调整安全策略

- 文化适应性:适应不同文化背景的协作模式

3. 社会与伦理考量

人机协作带来的社会和伦理问题:

- 人类自主性:确保人类在协作中的自主性

- 技能退化:长期依赖可能导致的技能退化

- 社会不平等:技术获取和使用的不平等

- 人机关系异化:人机关系的潜在异化

- 就业影响:对就业市场的影响和应对

4. 标准与监管发展

推动人机协作安全的标准化和监管:

- 国际协调:加强国际间的标准协调

- 动态监管:建立适应技术发展的动态监管机制

- 行业自律:鼓励行业自律和最佳实践共享

- 公众参与:让公众参与标准制定和监管讨论

- 教育普及:提高公众对人机协作安全的认识

结论

具身人工智能的人机协作安全与信任机制是一个复杂而重要的研究领域,关系到具身AI技术能否安全、可靠地融入人类社会。本章从理论基础、技术架构、责任机制、评估认证等多个方面全面探讨了人机协作的安全框架和信任建立机制,为具身AI的安全应用提供了系统的指导。

随着技术的不断发展,人机协作将变得更加深度和广泛,安全挑战也将更加复杂多样。只有通过持续的技术创新、完善的安全架构设计、清晰的责任分配机制和严格的评估认证,才能确保人机协作的安全性和可持续性。

未来,人机协作的理想状态应该是一种互补增强的关系,AI系统通过物理实体与人类进行自然、高效、安全的协作,共同完成各种任务,同时保持适当的安全边界和责任共担。这需要技术开发者、政策制定者、伦理学者和用户的共同努力,构建一个安全、信任、包容的人机协作环境,推动具身AI技术真正造福人类社会。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-10-16,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录