告别“分数崇拜”,迈向“能力实证”:科学评测体系引领人工智能产业高质量发展

原创告别“分数崇拜”,迈向“能力实证”:科学评测体系引领人工智能产业高质量发展

原创

走向未来

发布于 2025-09-30 09:14:03

发布于 2025-09-30 09:14:03

麻省理工揭秘:你看到的大模型排行榜,可能错得离谱!

当前,生成式人工智能(AI)的发展速度令人瞩目,但我们用以衡量其“能力”的标尺——基准测试(Benchmark),正面临一场深刻的信任危机。行业普遍依赖的排行榜分数,如同一座建立在流沙之上的宏伟建筑,看似精确,实则脆弱不堪。一个微不足道的提示词改动,就可能导致模型性能的剧烈波动,使得排行榜上的名次瞬息万变。这种现象不仅误导了公众和科学界的认知,更给AI产品的研发和商业化带来了巨大的不确定性。

本文基于MIT的论文(MIT的论文全文可以从“走向未来”(https://t.zsxq.com/xpWzq)知识星球中获取),深入剖析当前AI评测范式的内在缺陷,并系统性地阐述一种全新的、基于稳健推断的评测框架。我们将探讨,为何必须将AI评测从简单的“测量”行为,转变为严谨的“统计推断”过程。本文将详细拆解该研究所借鉴的心理测量学理论(经典测试理论CTT与项目反应理论IRT),展示如何构建一个更能反映AI真实能力的理论模型,并介绍两种具体的、能够量化不确定性的高级推断策略:聚类自助法(Clustered Bootstrapping)和潜在能力自适应测试(Latent Ability Adaptive Test)。

最后,本文将超越技术细节,从产品战略、技术研发和市场竞争的宏观视角,深度分析这一评测范式革命所蕴含的巨大商业价值。我们将论证,拥抱这一新框架,不仅是技术上的精进,更是企业在未来AI竞争中构建核心护城河、实现可持续发展的关键战略抉择。这关乎我们如何定义真正的AI进步,以及如何构建一个更加成熟、可靠和值得信赖的AI生态。

第一章:精准的幻象——当前AI评测范式的系统性危机

人工智能领域,尤其是大语言模型(LLM)的竞赛,已经进入白热化阶段。各大公司发布的模型技术报告,以及Hugging Face等平台上的开源排行榜,都将基准测试得分作为衡量模型能力的核心指标。MMLU、BIG-Bench、AGIEval等基准测试的名字,成为了定义模型“智力”水平的权威代码。然而,在这场对小数点后几位的疯狂追逐中,我们可能忽略了一个根本性的问题:这些分数真的代表了模型的“能力”吗?

1.1 缺陷一:将“推断”简化为“测量”,忽视了不确定性

目前几乎所有的评测报告都以一个单一的点估计值(如准确率85.3%)来呈现模型性能。这种做法看似简洁明了,却掩盖了结果的全部真相。它给人的暗示是:评测如同用尺子量长度,是一个简单、确定的测量过程。

然而,事实远非如此。每一次评测都是一次统计推断(Inference)。我们试图通过一个有限的、特定的测试样本(基准数据集),去推断模型在更广泛、更自然的真实世界任务中的潜在能力。这个过程天然地充满了不确定性。论文指出,至少有两种不确定性被完全忽视了:

- 有限样本不确定性:任何基准测试都只是问题空间的一个微小采样。我们如何确定,模型在一个含有1000个问题的测试集上的表现,能够代表它在包含数百万个潜在问题领域中的真实水平?传统的机器学习评测会使用置信区间来量化这种不确定性,但这在当前的LLM评测中却被普遍省略。

- 模型内在随机性与敏感性不确定性:生成式模型,尤其是LLM,其输出受到多种因素影响。即使是同一个问题,不同的采样温度(temperature)、top-p等超参数设置,甚至仅仅是措辞、句式、标点的微小变化(即“扰动”),都可能导致输出结果的巨大差异。这种对输入的敏感性,是模型能力的一个重要维度,但现有的评测体系完全无法捕捉。

将一个复杂的、多维度的能力推断过程,简化为一个孤立的、看似精确的数字,是当前评测危机的核心根源。它导致了我们无法判断两个模型之间0.5%的得分差异究竟是本质能力的体现,还是仅仅是随机波动的产物。

欢迎加入“走向未来”知识星球,一起探讨生成式人工智能、大模型和AIGC的产品、技术和应用实践,探讨如何使用各种不同的人工智能大模型和智能体来为工作增效,为生活添彩。点击链接(https://t.zsxq.com/xpWzq)或扫码加入“走向未来”知识星球,一起走向AGI的未来。

1.2 缺陷二:缺乏坚实的“能力理论”作为评测根基

第二个缺陷更为隐蔽,也更为致命。当前的评测实践普遍缺乏一个关于“AI能力是什么”以及“它如何在一个测试中体现”的明确理论。我们理所当然地将“高准确率”等同于“高能力”,但这本身就是一个未经审视的、脆弱的假设。

该研究引入心理测量学(Psychometrics)的视角,为我们提供了一个强有力的对比。在心理测量学中,评估一个人的数学能力,绝不是简单地让他做100道题然后计算正确率。它背后有一套复杂的理论模型,比如经典测试理论(Classical Test Theory, CTT) 和 项目反应理论(Item Response Theory, IRT)。这些理论明确区分了“真实能力”(True Score/Ability)和“观测分数”(Observed Score),并对“误差”(Error)的构成有精细的建模。

反观AI评测,我们基本停留在了最原始的阶段。我们使用的,是一种隐性的、未经言明的、极其简化的“能力理论”,即:

ϕi=θi+ϵi

其中,ϕi 是模型在问题 i 上的观测分数(0或1),θi 是模型在该问题上的真实表现,而 ϵi 是一个均值为零的随机误差。这个模型的核心假设是:误差是纯粹随机的,与问题本身无关。

然而,大量的实证研究(包括该论文的实验)都表明,这个假设在LLM身上是完全错误的。LLM的“误差”并非纯粹随机,其中包含了由输入(如问题措辞)引起的系统性偏差(Systematic Bias)。例如,对于同一个逻辑推理问题,陈述句式的提问和疑问句式的提问,可能会系统性地导致模型表现一好一坏。这种偏差不是随机的,而是由输入的特定形式所决定的。

缺乏一个能够解释和容纳这种系统性偏差的能力理论,使得我们的评测从根基上就站不住脚。我们测量的,可能并非模型处理这个“概念”的真实能力,而仅仅是它处理这个“特定措辞”的能力。评测的这种脆弱性,实际上也深刻地反映了当前大模型技术范式自身的内在局限性。要真正理解并解决这一危机,我们不仅要革新评测方法,更要深入模型内部,直面其能力的根源性问题。

而当我们深入探究,便会发现,评测中暴露出的“系统性偏差”与模型在应用中广为人知的“幻觉”和“知识陈旧”两大顽疾,实则同根同源。它们都源于大模型本质上是一个基于统计的、从海量数据中学习语言模式的系统,而非一个真正理解并掌握知识的系统。因此,要构建真正可靠的AI,就必须双管齐下:一方面,我们需要本文探讨的科学评测框架来“量其体温”;另一方面,我们更需要从根本上增强模型的“免疫力”。在这一关键领域,资深大模型技术专家王文广先生在其力作灯塔书《知识增强大模型》一书中,便系统性地剖析了这些大模型与生俱来的“缺陷”,并深入探讨了如何通过检索增强生成(RAG)与图模互补等手段,为模型注入可信、可追溯、可更新的知识血液。对于希望从根源上解决模型可靠性问题的读者而言,该书提供了一个不可或缺的理论与实践蓝图。

第二章:奠定新基石——一个稳健的AI能力推断框架

面对上述危机,该研究提出了一个清晰而深刻的解决框架,包含两个核心步骤:

- 第一部分:建立一个更真实的AI能力理论模型。

- 第二部分:基于该理论,发展出能够稳健推断能力的具体策略。

2.1 第一部分:构建包含系统性偏差的AI能力理论

该研究的核心洞见在于,必须修正传统的能力模型,将由输入扰动引起的系统性偏差明确地纳入模型中。

2.1.1 修正经典测试理论(CTT)

在CTT的框架下,新的AI能力模型被修正为:

ϕi=θi+s(xi)+ϵi

- ϕi:依然是模型在问题 i 上的观测分数。

- θi:是模型对于问题 i 所蕴含的核心概念的“真实能力”。这是我们真正想测量的目标。

- s(xi):这是模型的关键创新。它代表由问题 i 的具体措辞 xi 所引起的系统性偏差项。例如,s("陈述句式") 可能为+0.1,而 s("疑问句式") 可能为-0.1。

- ϵi:是剩余的、不可解释的随机误差。

这个新模型有一个至关重要的假设:对于一个给定的核心概念 i,如果我们能够遍历所有自然的、合理的措辞方式 xi(构成一个分布 Pi),那么这些措辞所带来的系统性偏差的期望值应该为零。即:Exi∼Pi[s(xi)]=0。

这个假设的直观理解是:各种措辞方式带来的正面和负面影响,在足够多样化的表达下,应该会相互抵消,从而让我们能够分离出模型对核心概念的真实能力 θi。

2.1.2 基准测试 curation 的问题

这个新理论立即揭示了现有基准测试的根本问题。一个基准数据集 D={x1,x2,...,xn},其构建过程实际上只为每个核心概念 i 挑选了一个特定的措辞 xi。由于人类创建者的习惯或偏好,这些被挑选的 xi 往往是高度相关的(例如,都使用相似的句式结构)。这相当于在措辞分布 Pi 中进行了有偏的、非独立的采样。

在这种情况下,s(xi) 就不再是一个可以被期望掉的零均值项,而变成了一个固定的、未知的偏差常量。我们观测到的分数 ϕi 实际上是 (θi+s(xi)) 的一个体现,我们无法将真实能力 θi 从偏差项 s(xi) 中分离出来。这就是现有评测分数系统性偏高或偏低的根本原因。

2.1.3 恢复真实能力的途径:随机扰动

如何解决这个问题?理论给出了明确的指引:我们需要通过随机扰动来模拟对措辞分布 Pi 的独立采样。具体而言,对于每一个原始问题 xi,我们利用一个强大的LLM或预设的语法规则,生成 m 个意义相同但表达方式不同的新问题 {xi,1, xi,2, ..., xi,m}。

通过评估模型在这一系列扰动问题上的平均表现,我们就可以有效地将系统性偏差项 s(xij) 的影响平均掉,从而得到对真实能力 θi 的一个无偏估计 :

这为我们从理论上找到了解决评测脆弱性问题的路径。

2.2 第二部分:从理论到实践,两种稳健的能力推断策略

有了坚实的理论基础,我们便可以设计出具体的、可操作的评测方法。该研究提出了两种分别对应CTT和IRT框架的推断策略。

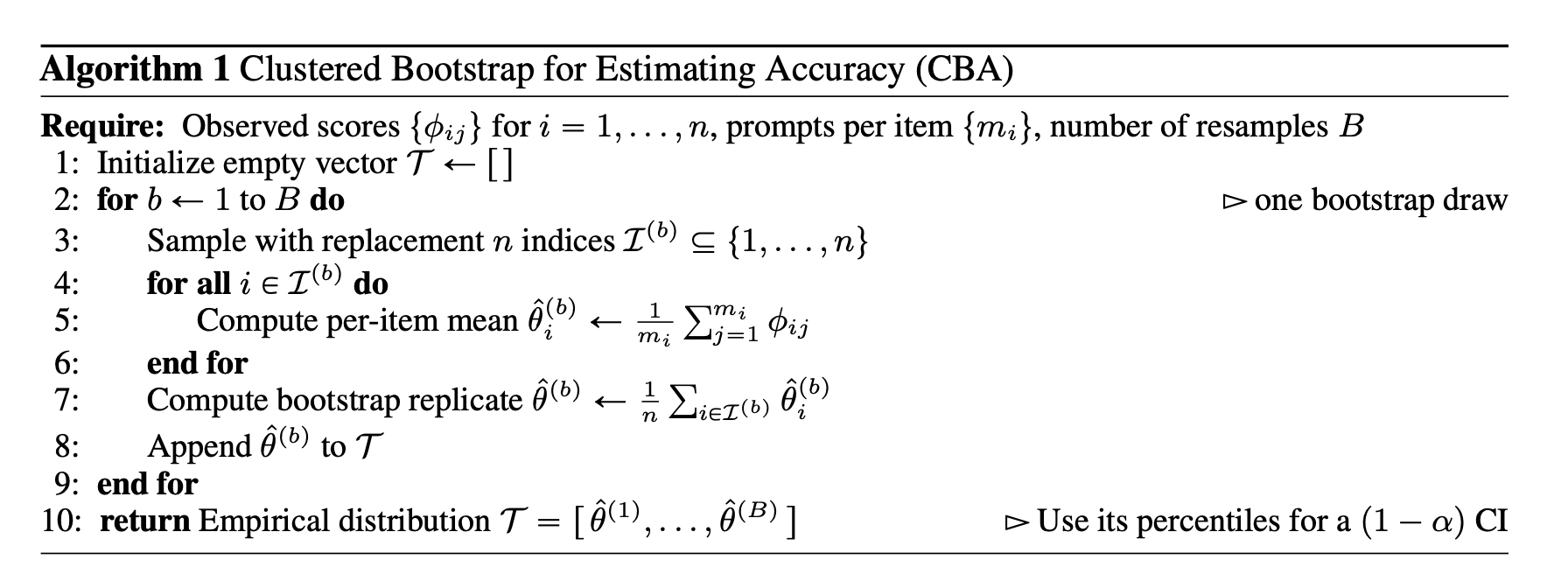

2.2.1 策略一:基于CTT的聚类自助法(Clustered Bootstrap for Accuracy, CBA)

这个方法旨在回答一个经典问题:“在考虑了措辞敏感性之后,模型的整体准确率到底是多少,其不确定性有多大?”

它将每个核心概念(即原始问题 i)视为一个“聚类”(cluster),该聚类内部包含了 m 个措辞扰动。CBA算法的步骤如下:

- 数据准备:对基准测试中的每个问题 i,生成 m 个扰动,并获得模型在所有 n×m 个问题上的得分 ϕij。

- 计算每个聚类的均值:对每个问题 i,计算其在 m 个扰动上的平均分,得到 。这是对该问题真实能力的估计。

- 自助法重采样:进行 B 次(例如 B=1000)循环。在每次循环 b 中:

- 从 n 个问题“聚类”中有放回地抽取 n 个聚类。

- 计算这次抽样得到的 n 个聚类的平均分 。

- 构建置信区间:将 B 次循环得到的所有 汇集起来,形成一个经验分布。通过取这个分布的百分位数(例如2.5%和97.5%),就可以构建出模型整体真实准确率 θ 的95%置信区间。

CBA方法的巨大价值在于:

- 它提供了一个区间,而不是一个点。 这个区间明确地告诉我们,模型的真实准确率可能在哪个范围内波动。

- 它同时考虑了两种不确定性。 通过对问题聚类的抽样,它捕捉了“有限样本”的不确定性;通过在每个聚类内部取平均,它平滑掉了“措辞敏感性”带来的不确定性。

- 它的结果更可靠。 经过CBA计算出的置信区间,让模型间的比较变得有意义。如果两个模型的置信区间有很大重叠,我们就没有充分的理由说一个模型比另一个好。

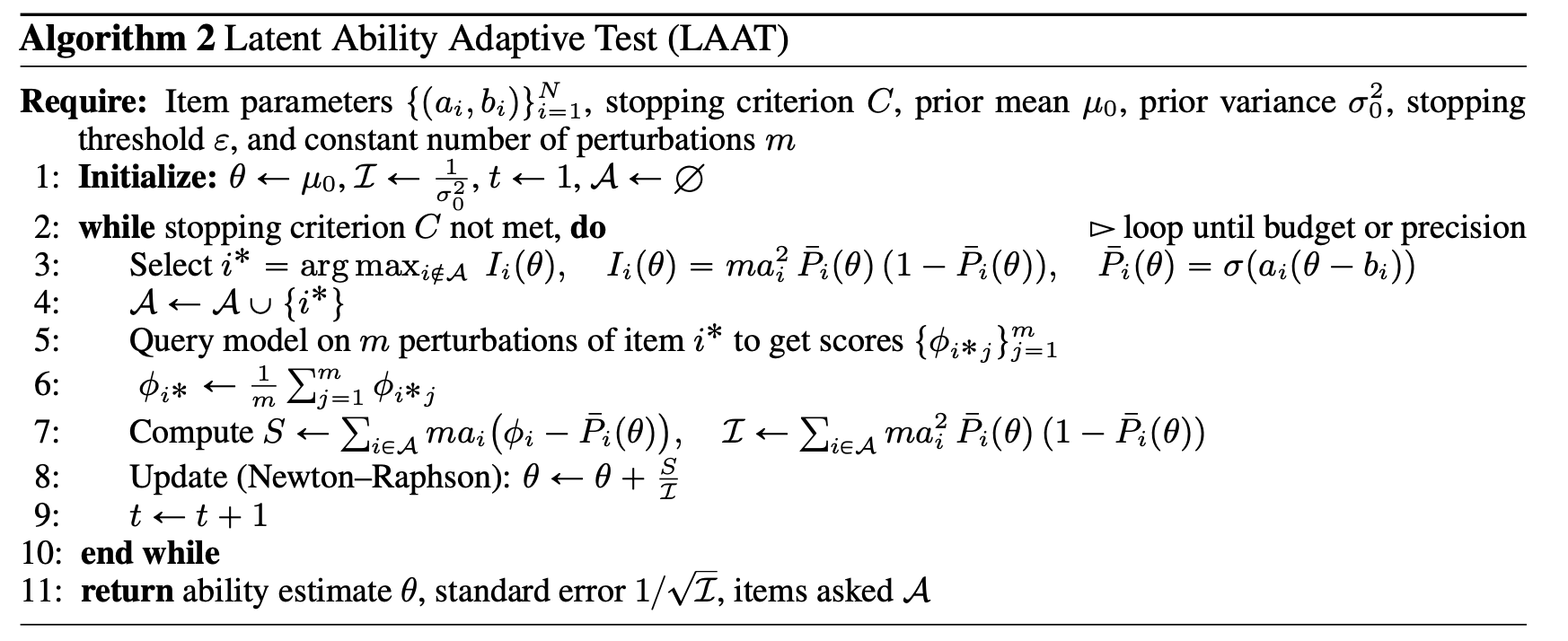

2.2.2 策略二:基于IRT的潜在能力自适应测试(Latent Ability Adaptive Test, LAAT)

CBA衡量的是“准确率”,而LAAT则试图衡量一个更深层次的概念——模型的**“潜在能力”(Latent Ability)**。IRT模型假设,存在一个一维的潜在能力值 θk 来描述模型 k 的整体水平。一个问题 i 能否被正确回答,取决于模型的能力 θk 与该问题的内在参数——难度(difficulty)bi 和 区分度(discrimination)ai——之间的相互作用。

修正后的IRT模型如下:

其中 σ 是logistic函数。同样,通过对扰动 xij 的平均,可以消除 s(xij) 的影响。

LAAT是一种更高效的评测策略(见论文Algorithm 2),其核心思想是:不要随机地问问题,而是智能地选择那些对当前能力估计最有信息量的问题来问。

- 预校准阶段:首先,需要一个包含多种模型的生态系统,对一个较大的问题池进行测试,从而预先估计出每个问题的难度 bi 和区分度 ai。高区分度的问题能很好地分开高能力和低能力的模型。

- 自适应测试阶段:

- 对一个新模型,从一个能力先验(例如,标准正态分布)开始。

- 在每一步,选择一个能够最大化费雪信息量(Fisher Information) 的问题来提问。直观地说,就是选择一个难度与模型当前能力估计最匹配的问题。

- 根据模型在该问题(及其 m 个扰动)上的表现,使用牛顿-拉弗森法等优化算法,更新对模型能力 θ 的估计及其标准误。

- 重复此过程,直到达到预设的预算或估计精度。

LAAT方法的优势是颠覆性的:

- 极高的评测效率:论文的实验表明,LAAT仅需使用原测试集4%-27%的问题,就能达到与全量测试相当的估计精度。这对于计算资源昂贵的大模型评测,具有无与伦比的市场价值。

- 更深层次的能力刻画:LAAT给出的不是一个简单的准确率,而是一个相对的能力标度。一个在LAAT中获得高分的模型,意味着它能解决那些高难度、高区分度的问题,这比在大量简单问题上获得高准确率更能说明其能力的本质。

- 动态与个性化:LAAT可以根据被测模型的水平,动态调整测试难度,实现“因材施测”。

两种策略的对比

特征 | 聚类自助法 (CBA) | 潜在能力自适应测试 (LAAT) |

|---|---|---|

衡量目标 | 准确率 (Accuracy) | 潜在能力 (Latent Ability) |

理论基础 | 经典测试理论 (CTT) | 项目反应理论 (IRT) |

数据需求 | 无需额外数据 | 需要预先校准问题的难度/区分度 |

评测效率 | 较低 (需全量测试) | 极高 (自适应选择少量问题) |

结果解读 | 绝对准确率的置信区间 | 相对的能力值与标准误 |

这两种方法并非互斥,而是互补的。CBA提供了一个对现有评测范式的直接、稳健的改进;而LAAT则为未来更高效、更深刻的AI能力评估指明了方向。

第三章:实证检验——让数据揭示评测的真相

理论的优雅需要数据的支撑。该研究通过一系列精心设计的实验,无可辩驳地证明了现有基准测试的系统性偏差,以及新框架的有效性。

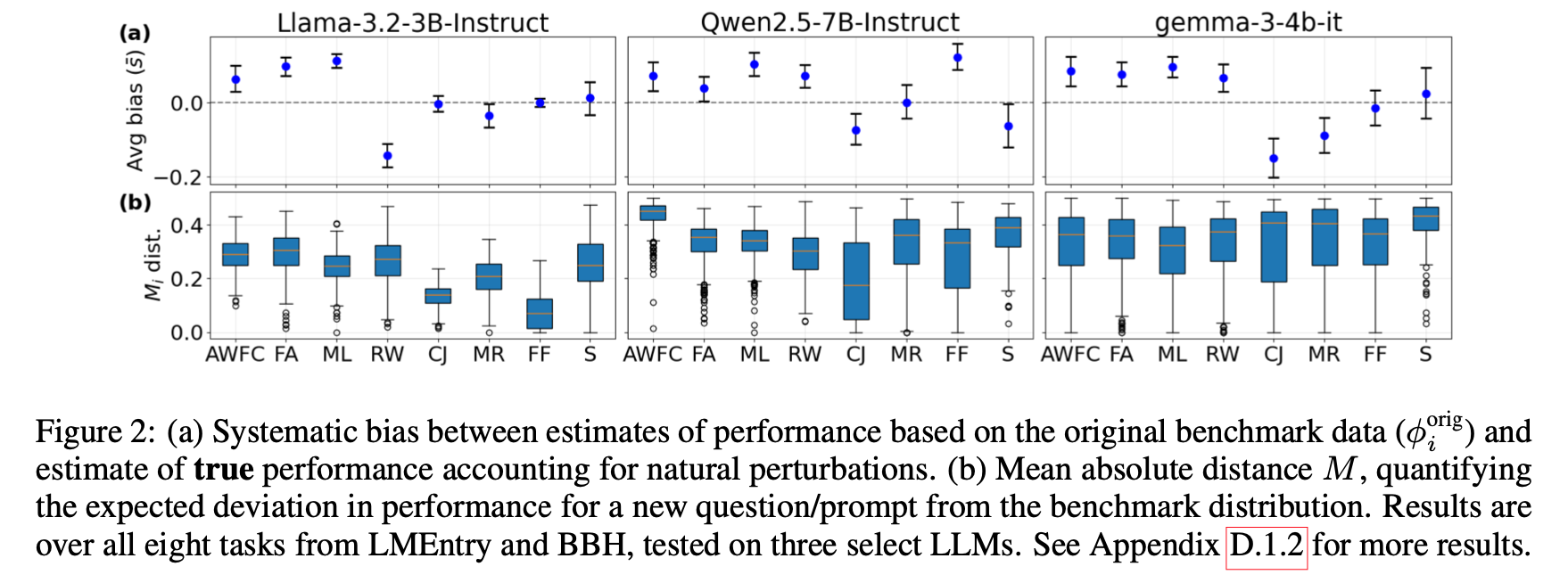

实验设计涵盖了多个开源模型(Llama-3.2, Qwen-2.5, Gemma)和顶尖的闭源模型(gpt-4.1, gpt-4.1-mini),以及多种不同类型的基准任务(如BBH, LMEntry, GPQA)。

3.1 发现一:系统性偏差普遍存在

实验的核心是比较原始基准测试得分与考虑了20个扰动后的真实能力估计。结果非常惊人:

- 在56组实验(7个模型 x 8个任务)中,有38组显示出统计上显著的系统性偏差。这意味着在超过三分之二的情况下,原始基准给出的分数都是对模型能力的错误估计。

- 偏差的方向不固定。在某些任务上,原始措辞可能恰好“迎合”了模型的偏好,导致分数虚高;而在另一些任务上,则可能“触碰”了模型的弱点,导致分数被不公正地压低。

- 偏差的幅度巨大。在最坏的情况下,原始分数与真实能力估计之间的差距可高达15个百分点。在竞争激烈的排行榜上,这种幅度的偏差足以完全颠覆模型的排名。

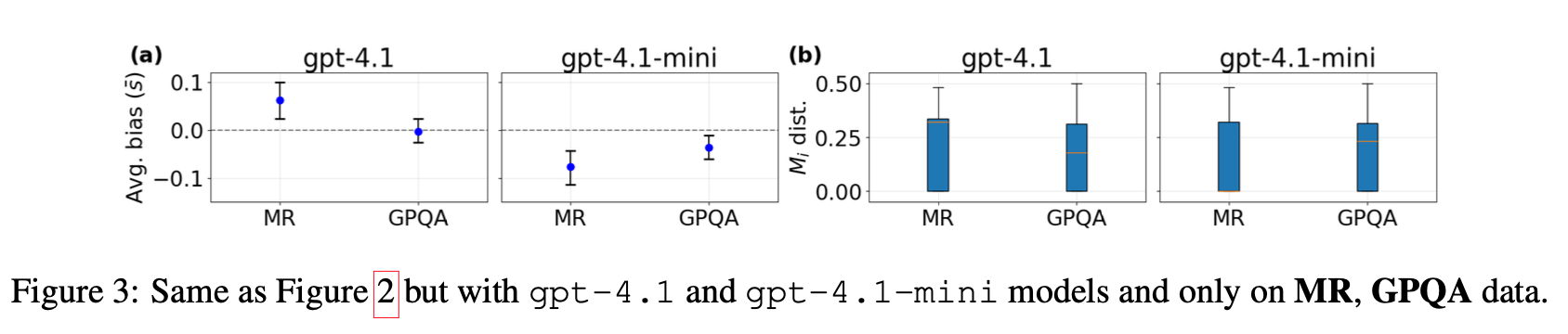

3.2 发现二:顶尖模型也无法幸免

一个自然的疑问是:这种敏感性问题是否只会出现在较小的开源模型上,而像GPT-4这样的大型模型是否已经足够稳健?

实验结果给出了否定的答案。即使是强大的gpt-4.1,在面对电影推荐(MR)和研究生水平的科学问答(GPQA)这类前沿任务时,依然表现出明显的系统性偏差(最高可达8个百分点)。这表明,只要任务足够困难,触及了模型能力的边界,措辞敏感性问题就会浮现。我们不能指望通过简单地“扩大模型规模”来一劳永逸地解决这个根本性的评测问题。

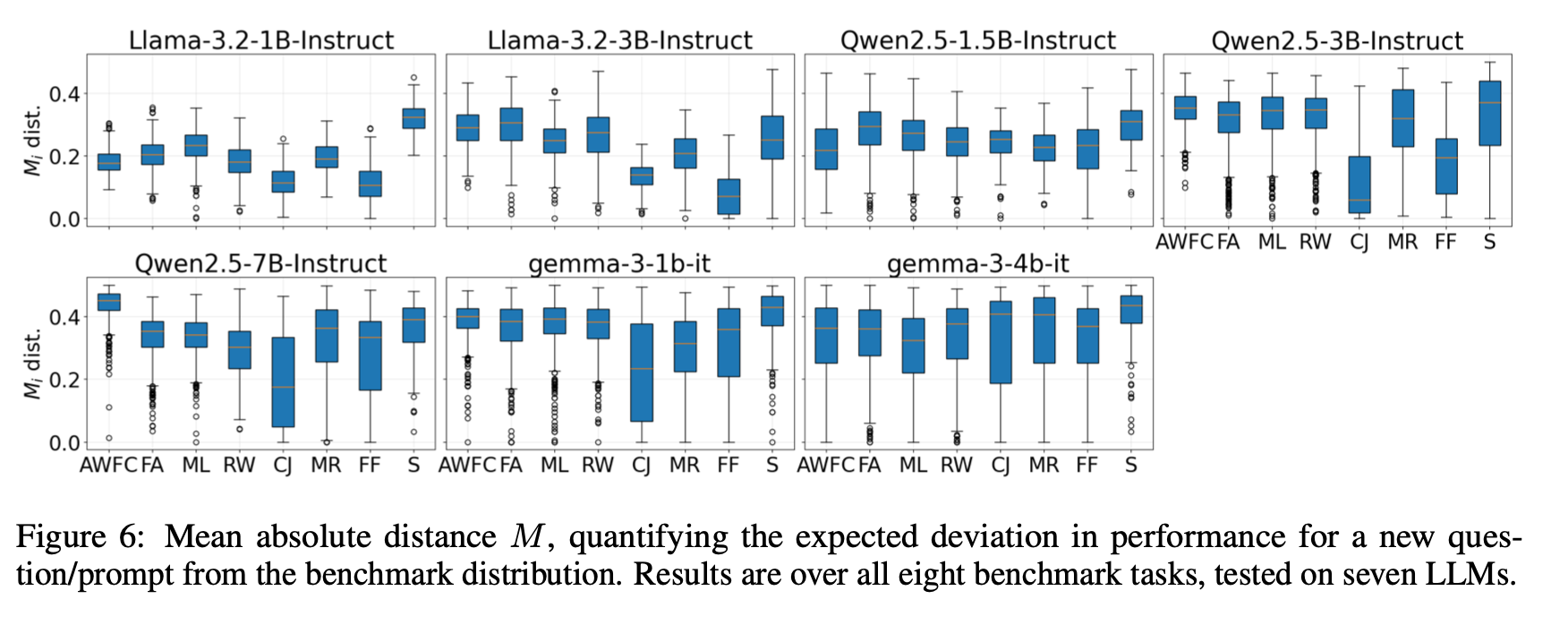

3.3 发现三:模型敏感度量化

研究还提出了一个名为“平均绝对距离”(Mean Absolute Distance, MAD)的指标,用以量化模型对措辞扰动的敏感程度。结果显示,对于一个给定的问题,不同措辞可能导致的模型准确率波动范围可以达到10到50个百分点。

这是一个对产品开发者极具警示性的数字。它意味着,即使用户提出的问题在语义上完全一致,仅仅因为表达方式的不同,他们从AI产品中得到的服务质量可能会有天壤之别。这直接关系到产品的可靠性和用户信任度。

第四章:战略价值与市场影响——从技术革新到商业护城河

这项研究提出的评测框架,远不止是一次学术上的方法论升级。它预示着AI产业的一次底层逻辑重塑,对产品、技术和市场竞争都将产生深远影响,蕴含着巨大的商业价值。

4.1 对AI产品开发的影响:从“刷榜”到“构建稳健性”

- 重新定义产品质量标准:当前,许多AI产品的迭代目标被简化为在某个或某几个公开基准上提升分数。新框架将迫使产品经理(PM)和工程师重新思考“好”的AI产品的定义。除了传统的准确率,稳健性(Robustness) 和 一致性(Consistency) 将成为核心质量指标。产品的内部仪表盘上,除了一个孤零零的准确率数字,还应该有基于CBA的置信区间和基于MAD的敏感性分布图。

- 驱动研发资源重新分配:企业将不得不投入更多资源来构建自动化的、大规模的扰动生成和评测流水线。专门负责“评测科学”(Evaluation Science)的团队将成为AI公司的核心部门。研发的重点会部分地从单纯追求模型参数的提升,转向研究如何提升模型对语义的深层理解,而非对表面句式的模式匹配。那么,如何具体地构建这种深层次的、基于知识的稳健性呢?这正是知识增强技术发挥核心作用的地方。浦东新区“明珠计划”菁英人才、高级工程师王文广先生,凭借其在AI芯片、大模型训练与产业应用领域的丰富实践,在其著作《知识增强大模型》中,为产品经理和工程师们提供了详尽的“施工图”。书中不仅深入浅出地讲解了向量数据库、检索增强生成(RAG)、知识图谱等核心技术(涵盖第3、4、5章),更重要的是,它从系统工程的角度,给出了如何将这些技术整合,构建出真正能够对抗“幻觉”、及时更新知识、并最终赢得用户信任的AI产品的最佳实践。对于致力于将“稳健性”从一个抽象理念落实为产品核心竞争力的团队来说,这本书无疑是一本案头必备的实战指南。

- 提升用户信任与产品价值:一个经过稳健性评测的AI产品,能够为用户提供更可预期的、可靠的服务。这在金融、医疗、法律等高风险领域尤为重要。能够在宣传中拿出有力的、包含置信区间的稳健性报告,将成为产品差异化的重要卖点,直接转化为用户信任和商业合同。

4.2 对技术路线与创新的影响:开辟“评测即服务”新赛道

- “评测即服务”(Evaluation-as-a-Service, EaaS)的兴起:构建和维护一个科学、全面、高效的评测系统,本身就是一个复杂的技术挑战。这为第三方专业评测机构的出现创造了巨大的市场机会。未来,可能会出现像“AI领域的穆迪/标普”这样的公司,专门为AI模型和产品提供权威的、基于稳健推断框架的第三方评测和认证服务。这本身就是一个价值数十亿甚至上百亿美元的潜在市场。

- 推动AI可解释性和安全性研究:对措辞敏感性的深入分析,为我们打开了一扇观察模型内部“思维”的窗户。通过系统性地研究哪些类型的扰动会对模型产生最大影响,我们可以更好地理解模型的决策逻辑,发现其知识的盲点和偏见的来源。这与AI可解释性(XAI)和AI安全(AI Safety)领域的研究紧密相连。

- IRT和自适应测试的商业化潜力:LAAT所展示的惊人评测效率,具有直接的商业化价值。对于需要频繁对大量模型进行评估的大型企业或云服务商来说,采用自适应测试可以节省数百万美元的计算成本。开发高效、精准的自-适应评测平台,将成为AI基础设施领域的一个新的增长点。

4.3 对市场竞争格局的影响:重塑“领导者”的定义

- 排行榜的“去魅”与重构:长期来看,基于新框架的评测体系将逐渐取代当前脆弱的排行榜。市场的焦点将从“谁的分数最高”转变为“谁的能力最稳健、最可靠”。这会给那些通过“过拟合”特定基准测试而获得虚高排名的模型带来巨大压力,同时为那些真正注重泛化和稳健能力研发的团队提供脱颖而出的机会。

- 构建新的竞争壁垒:在新的评测范式下,真正的技术领导者不仅要能训练出强大的模型,还要能证明其模型的稳健性。拥有一套先进的、私有的、大规模的稳健性评测体系,将成为顶级AI公司秘而不宣的核心竞争力。这将构成一个新的、难以被轻易模仿的竞争壁垒。

影响企业估值与投资决策:对于投资者而言,新框架提供了一套更科学的工具来评估AI公司的技术实力。一个仅有光鲜排行榜分数的初创公司,其技术价值可能会被重估。相反,一个能够提供详尽稳健性报告,并清晰阐述其如何解决能力评测问题的公司,其技术护城河将更受资本市场的认可,从而获得更高的估值。

欢迎加入“走向未来”知识星球,一起探讨生成式人工智能、大模型和AIGC的产品、技术和应用实践,探讨如何使用各种不同的人工智能大模型和智能体来为工作增效,为生活添彩。点击链接(https://t.zsxq.com/xpWzq)或扫码加入“走向未来”知识星球,一起走向AGI的未来。

第五章:未来展望与挑战

这项研究为AI评测领域开辟了一条充满希望的新道路,但前方的探索依然漫长。

- 超越措辞敏感性:本文的焦点在于输入措辞的扰动,但这只是冰山一角。如论文所述,模型的表现还受到超参数(如temperature)、系统提示(system prompt)、上下文环境等多种因素的影响。未来的能力理论模型需要将这些因素也整合进来,构建一个更全面的多维误差模型。

- 构造有效性(Construct Validity)的终极问题:本文主要解决了评测的信度(Reliability) 问题,即“我们是否稳定、一致地测量了某个东西”。但更深层次的问题是效度(Validity),即“我们测量的这个东西,真的是我们想要测量的那个‘能力’吗?” 当前的基准测试是否真正反映了真实世界的复杂任务需求?这需要AI领域与认知科学、心理学、社会学等学科进行更深度的交叉融合。

- “评测科学”的学科化:我们正处在一个“评测科学”(Science of Benchmarks)兴起的黎明。如何设计出信息量更大、偏差更小、效率更高的评测方案?如何定义和测量更高层次的“通用智能”?这些问题本身就构成了激动人心的前沿研究方向。

结论

我们正站在AI发展的关键十字路口。对模型能力的评估,是我们前进的指南针。如果指南针本身摇摆不定、指向错误,那么整个行业的努力都可能被引向歧途。

MIT的这项研究,为我们提供了一次校准指南针的宝贵机会。它清晰地告诉我们,必须告别那种将AI评测视为简单测量的天真时代,迈向一个以严谨理论为基础、以统计推断为核心的成熟阶段。从追求脆弱的排行榜数字,转向构建真正稳健、可靠的AI能力,这不仅是一场技术范式的革命,更是一场关乎产业成熟度和未来发展的深刻变革。

对于任何一个致力于在人工智能时代取得长远成功的企业和研究者来说,理解并采纳这一新框架,都将是其做出明智战略决策的基石。因为最终,市场和用户所奖励的,不是那些在特定考试中取得最高分的“偏科生”,而是那些能够在千变万化的真实世界中,持续稳定地创造价值的“全能者”。而要识别并培养出这样的“全能者”,我们首先需要一把值得信赖的、稳健的标尺。这项研究,正是为我们锻造这把标尺,提供了至关重要的理论蓝图和实践工具。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录