VLSI 2025 Alphawave短课:AI/HPC背后的连接技术革命

VLSI 2025 Alphawave短课:AI/HPC背后的连接技术革命

光芯

发布于 2025-08-02 12:48:40

发布于 2025-08-02 12:48:40

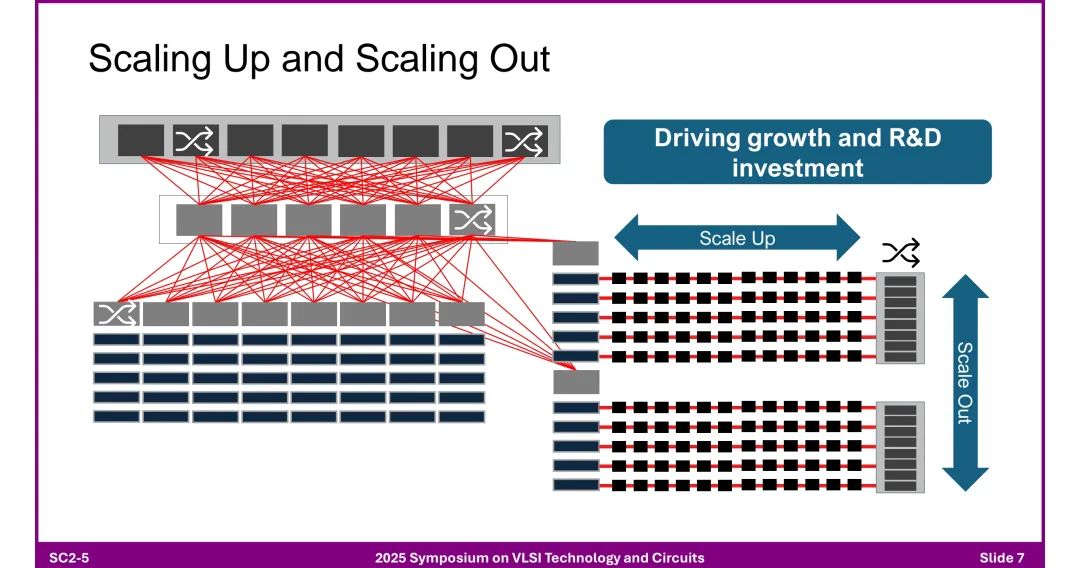

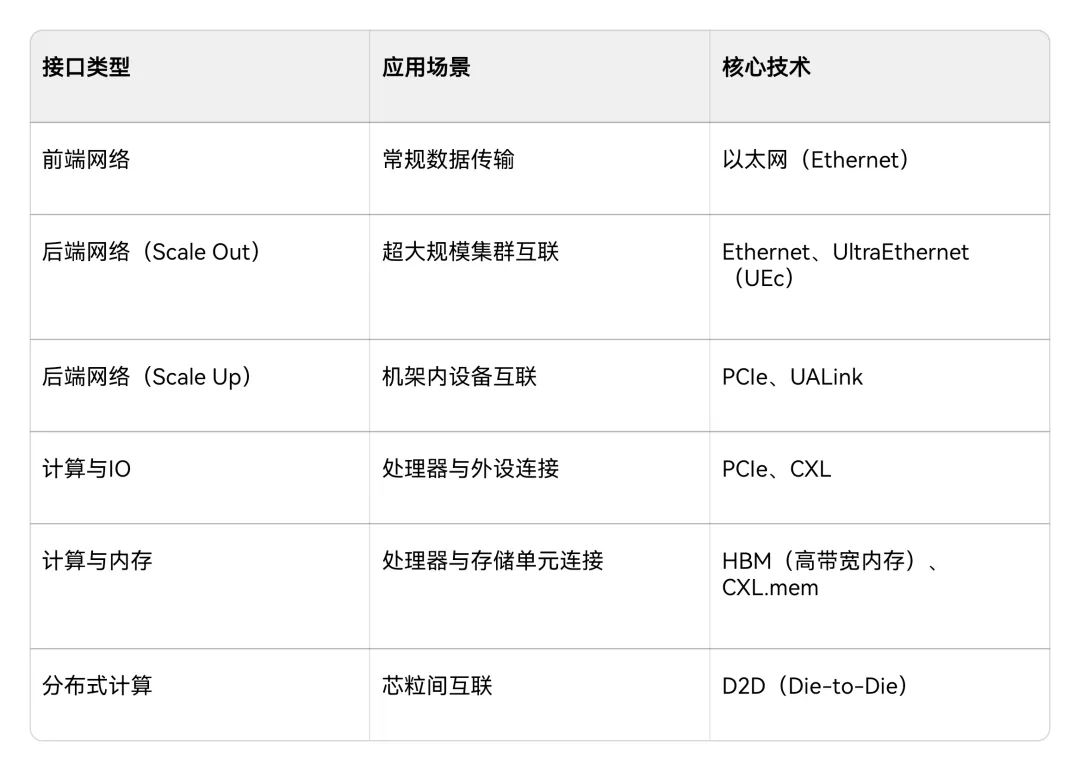

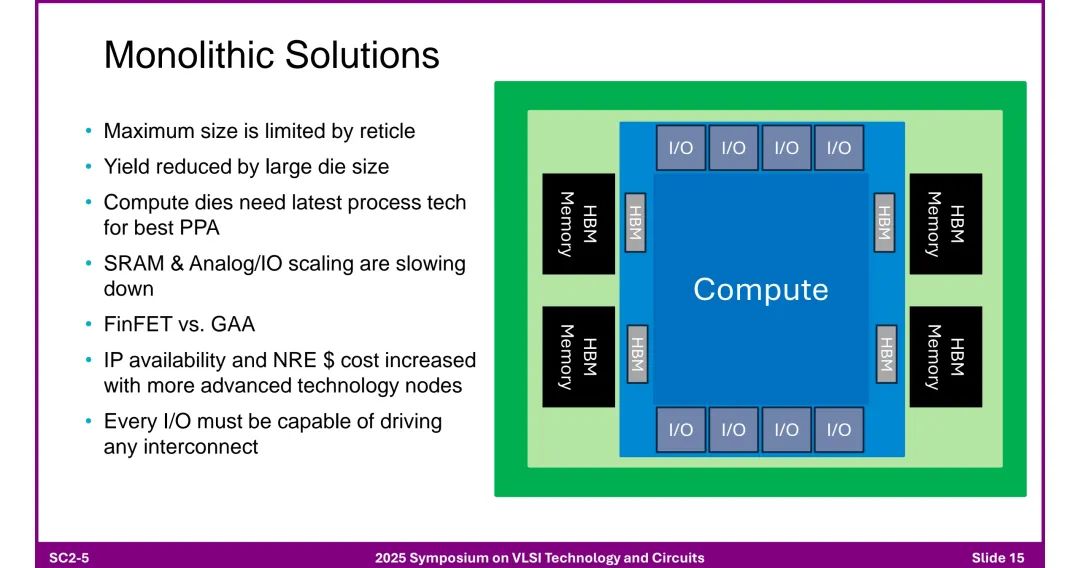

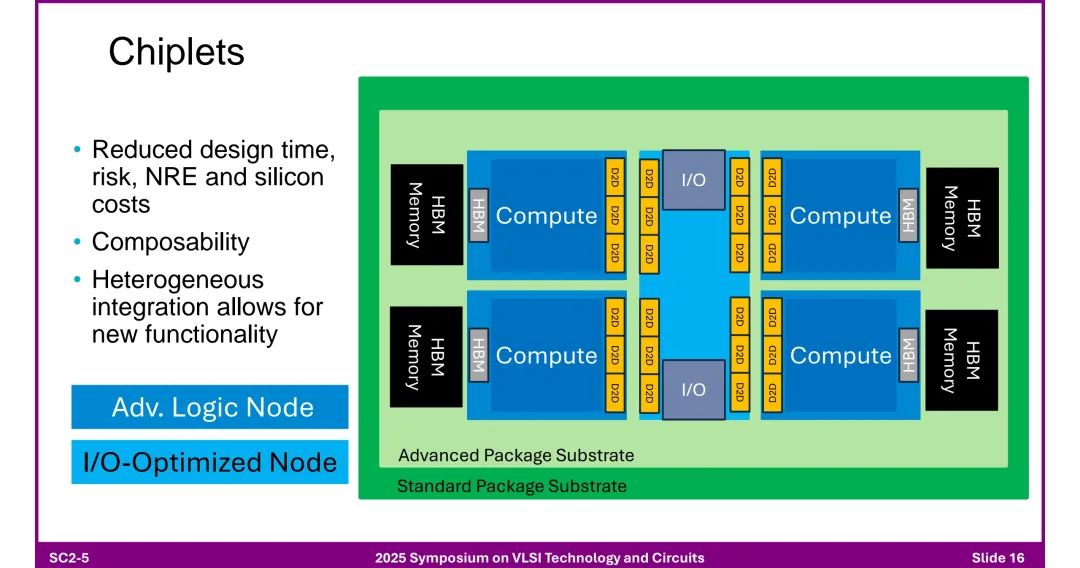

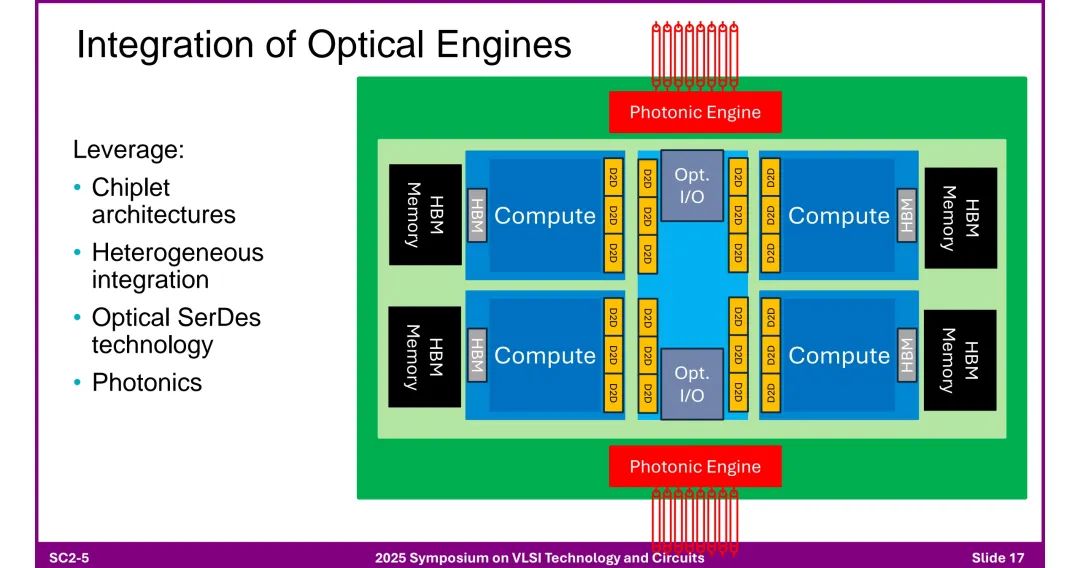

该报告是2025年VLSI会议上Alphawave关于加速AI的连接技术的短课内容,作者为Tony Chan Carsone。该报告指出AI领域呈现数据量与模型参数的爆发式增长,但算力增长远超内存与互连带宽,存在连接瓶颈。为突破瓶颈,AI数据中心采用分层网络架构:前端网络基于以太网,后端网络通过“Scale Up(纵向扩展)”和“Scale Out(横向扩展)”实现集群扩展。其中,机架内连接依赖铜缆及NVLink、PCIe等专用链路;机架间及更远距离(达10公里)则依赖光学技术,如以太网、Infiniband,且随着数据率提升,光学技术正逐步渗透到机架内甚至芯片级。 芯粒架构(Chiplet)成为关键解决方案:相比单片方案(受尺寸限制、良率低、成本高),芯粒架构通过异构集成(如先进逻辑节点与I/O优化节点结合),降低设计时间、风险及成本,支持灵活组合功能。3D芯粒架构进一步整合计算、内存(HBM)与光引擎,通过D2D(芯粒间)接口提升集成度。 高速I/O设计面临多重挑战:包括模拟前端的寄生电容、带宽限制,时钟抖动,以及芯粒实现中电感耦合、电磁仿真复杂度等问题。同时,光学收发器技术持续演进,从传统模块到集成DSP与硅光子技术的光引擎,共封装光学(CPO)虽能降低功耗、延迟,但存在散热集中、维护复杂等问题。 标准体系同步发展:以太网标准(如802.3系列)从40G演进至1.6T,PCIe从1.0升级至7.0,但其3年左右的开发周期需匹配AI硬件12个月的更新节奏。此外,铜互连通过共封装铜(CPC)连接器缓解阻抗不连续问题,400G以上电信号(如PAM-4/6)的可行性依赖FEC与均衡技术优化。 最终,报告强调,面对AI对低延迟、高吞吐量、大规模扩展的需求,需通过电气与光学技术融合、芯粒架构创新、标准协同及跨领域研发合作,推动连接技术突破。

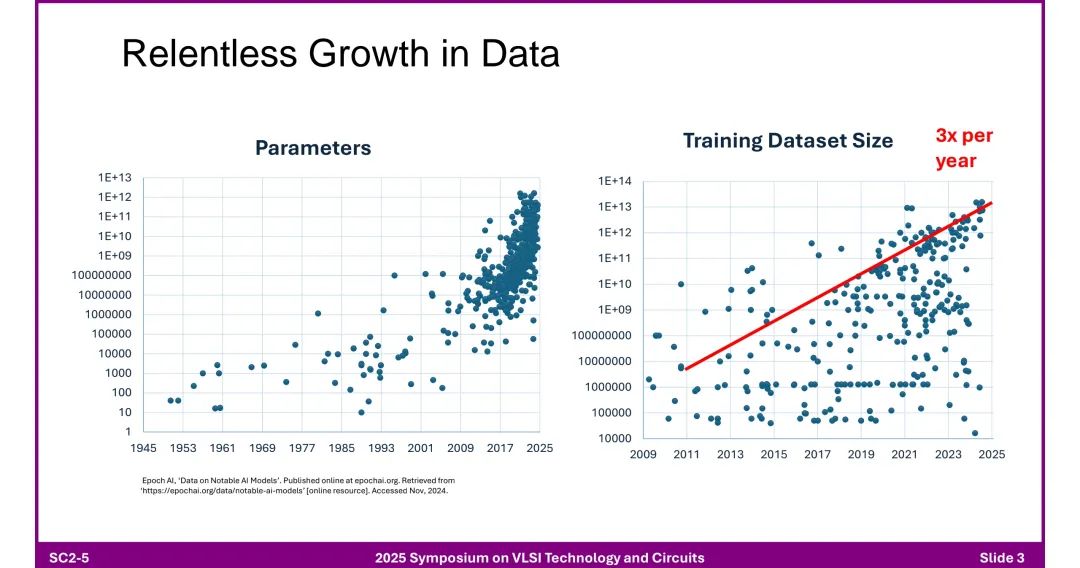

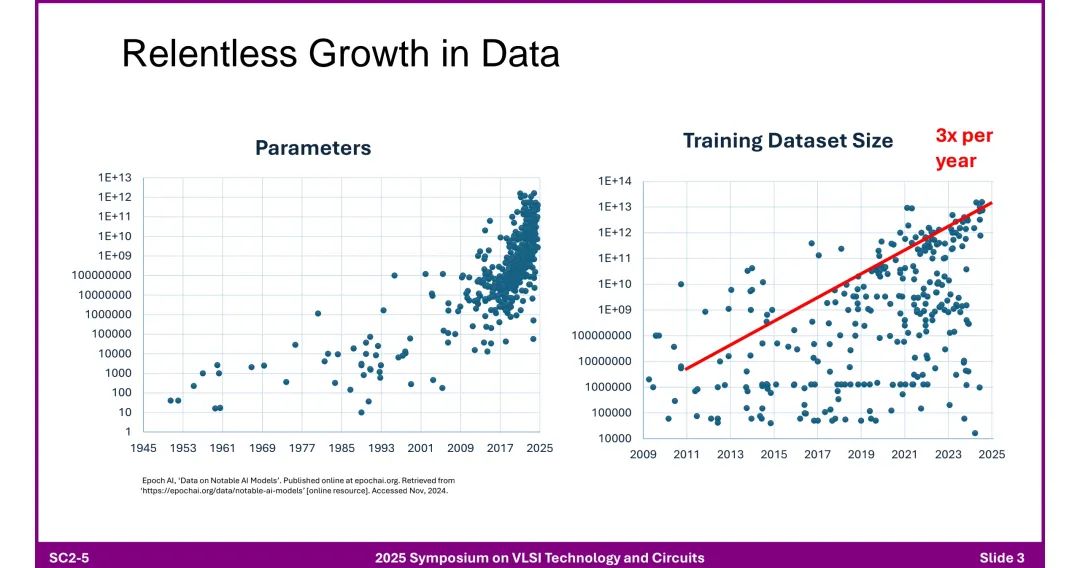

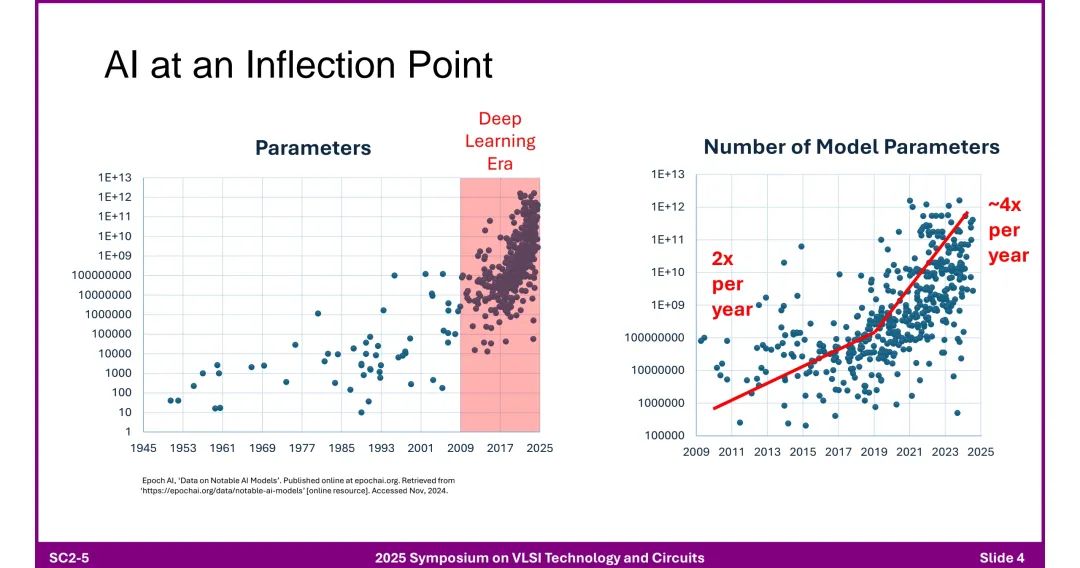

一、AI数据中心的核心趋势与挑战 1. 数据与模型参数的爆炸式增长 ◆ 训练数据集规模:从1945年到2025年呈现指数级增长,年均增长率达3倍,2025年规模接近1E+14(数据来源:Epoch AI)。 ◆ 模型参数增长:进入深度学习时代后(2009年后),参数数量增速显著提升,每2年约增长4倍,2025年突破1E+13,远超此前增速(此前约每2年增长2倍)。

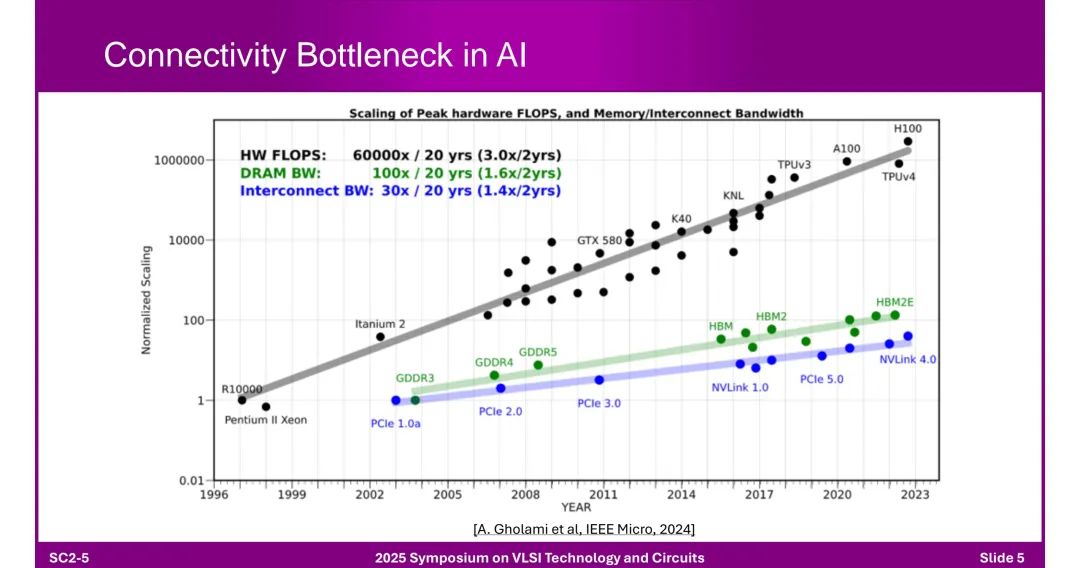

2. 连接瓶颈:硬件与带宽的失衡

◆ 性能增长对比: - 硬件FLOPS(峰值算力):过去20年增长60000倍(每2年增长3.0倍),典型产品如H100、A100、TPUv4等。 - DRAM带宽:同期仅增长100倍(每2年增长1.6倍),依赖HBM、GDDR等技术迭代(如HBM2E、GDDR5)。 - 互连带宽:增长30倍(每2年增长1.4倍),受限于PCIe(1.0a到5.0)、NVLink(1.0到4.0)等协议演进速度。 ◆ 核心矛盾:AI算力需求增速远超内存和互连带宽,形成“算力-带宽鸿沟”。 二、AI扩展的连接架构与技术路径 1. 数据中心网络结构

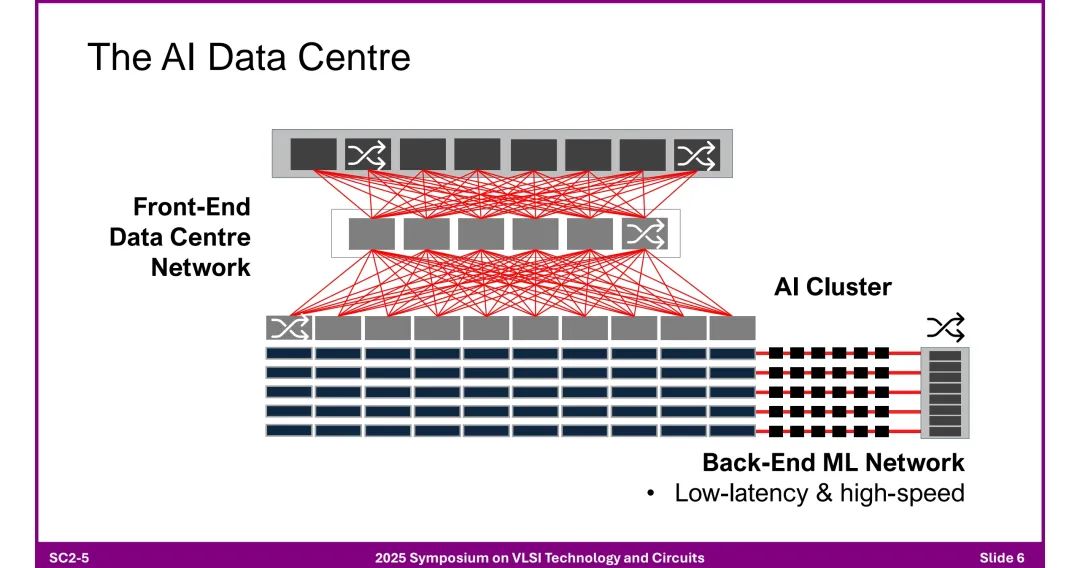

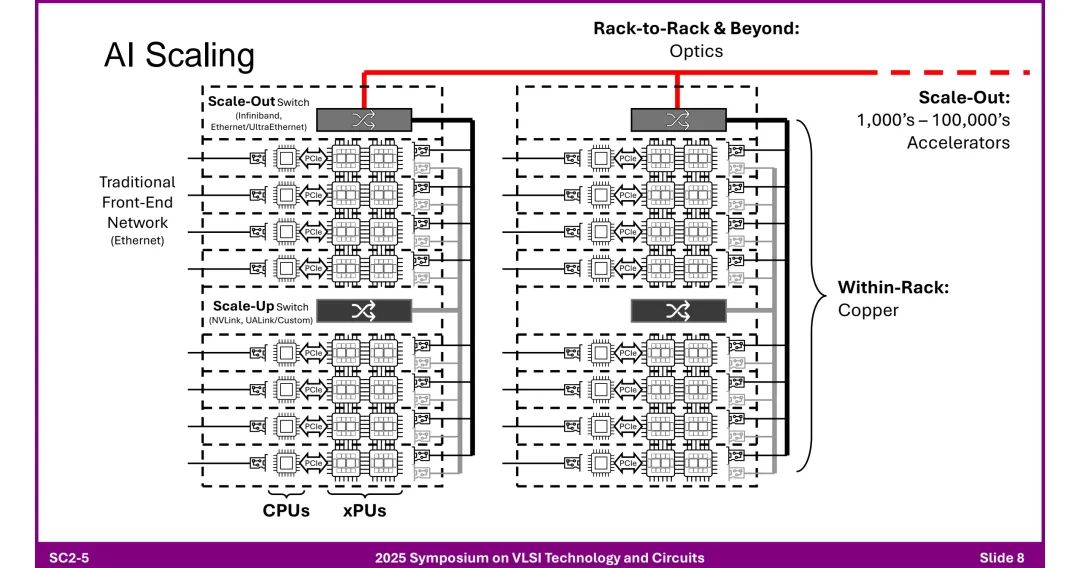

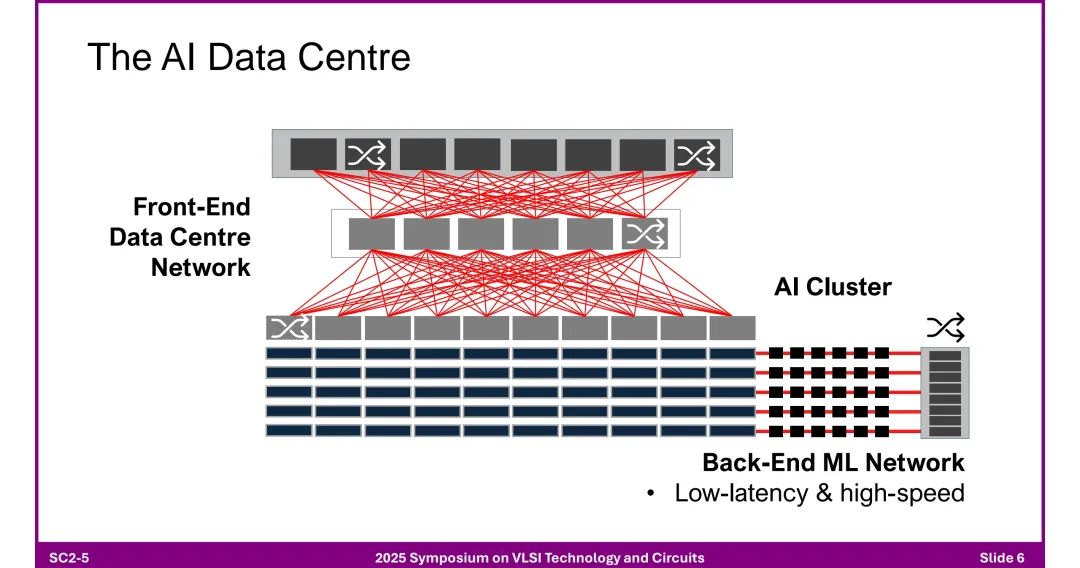

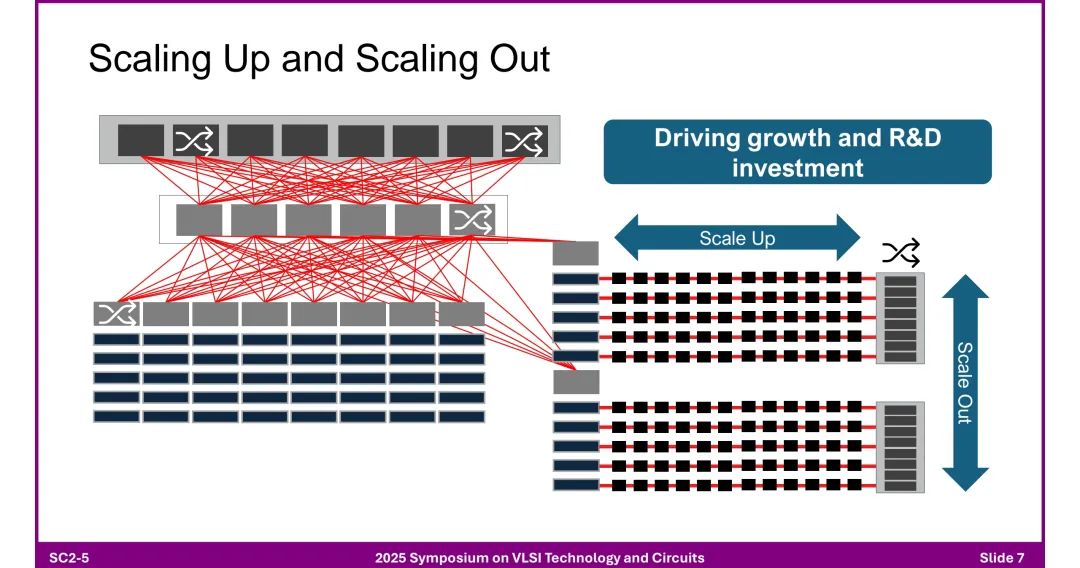

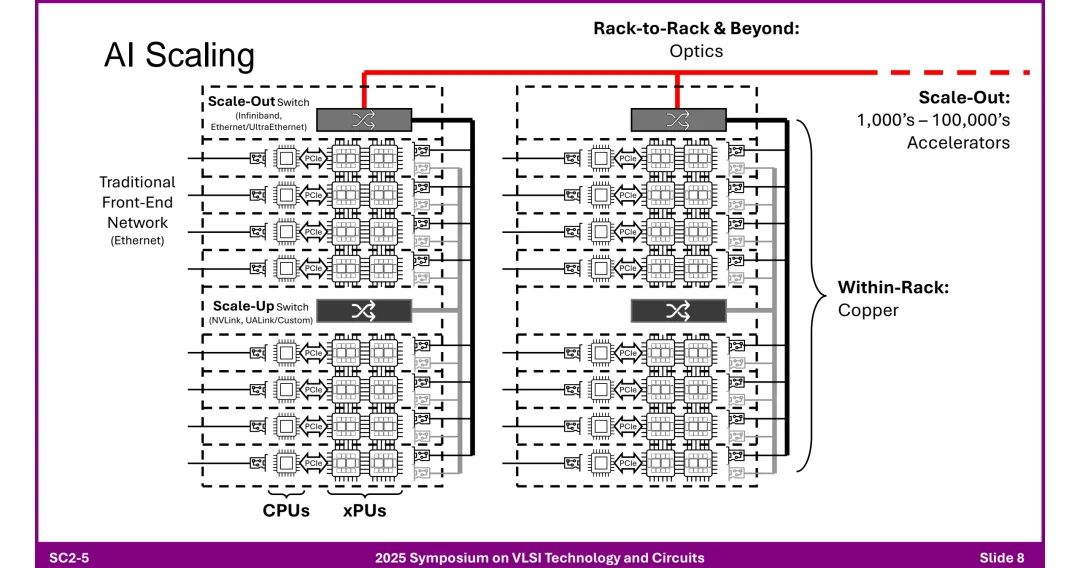

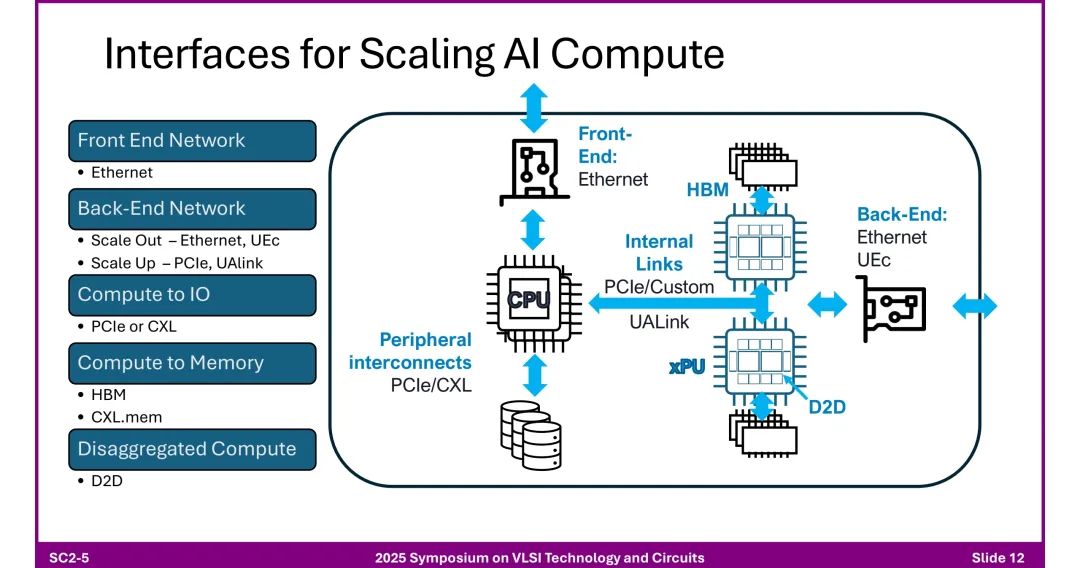

◆ 前端网络:基于以太网,负责常规数据传输,支持传统数据中心业务。 ◆ 后端ML网络:低延迟、高速率特性,专为AI集群设计,分为“Scale Up(向上扩展)”和“Scale Out(向外扩展)”两种模式。

2. 不同范围的连接技术 ◆ 机架内(Within-Rack):

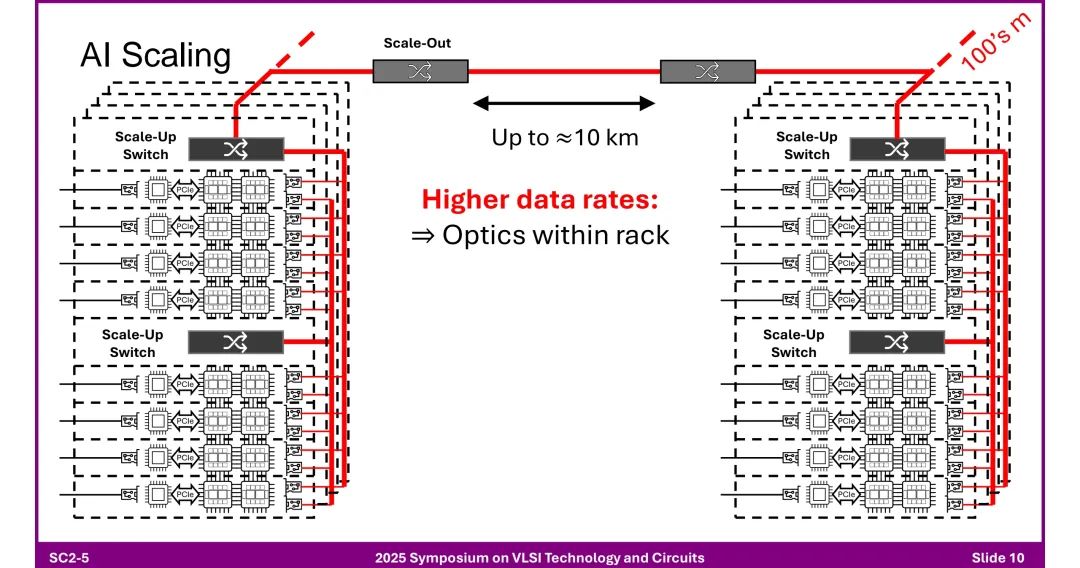

- 采用铜缆连接,依赖NVLink、UALink等定制协议,通过“Scale-Up Switch”实现加速器(xPUs)与CPU的高效互联。 ◆ 机架到机架及超大规模集群(Rack-to-Rack & Beyond):

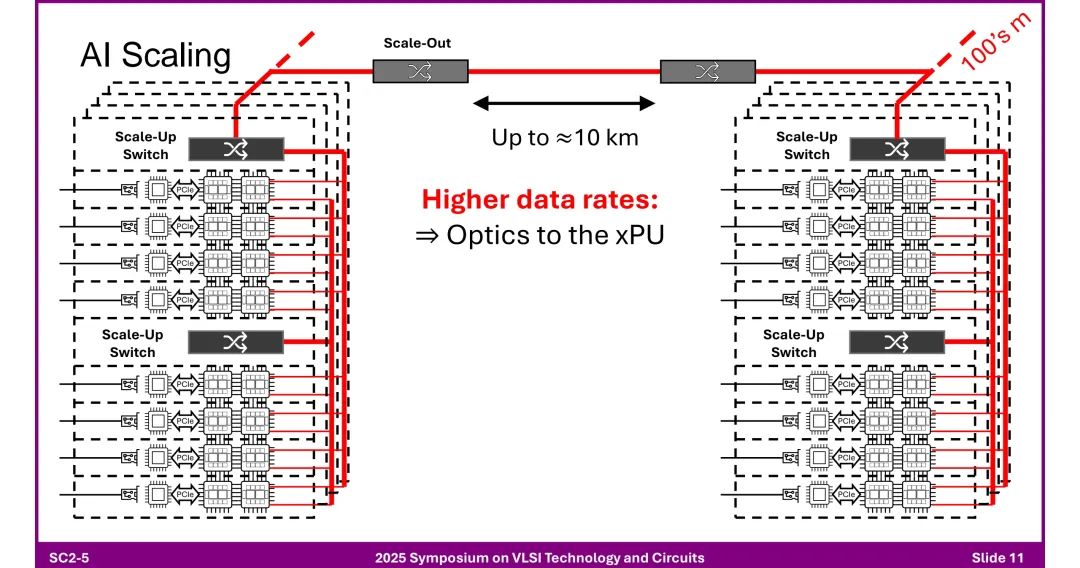

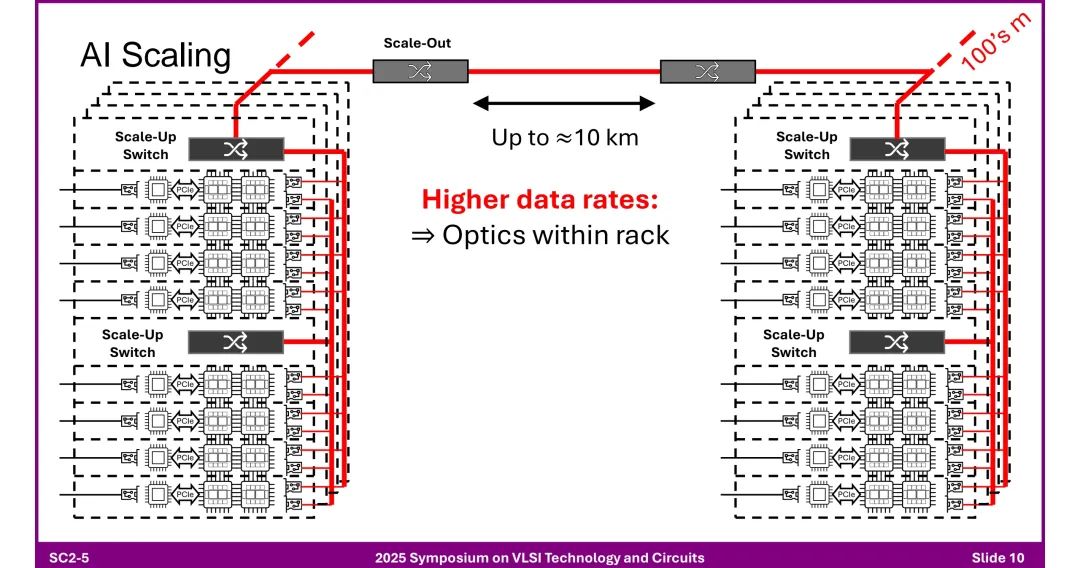

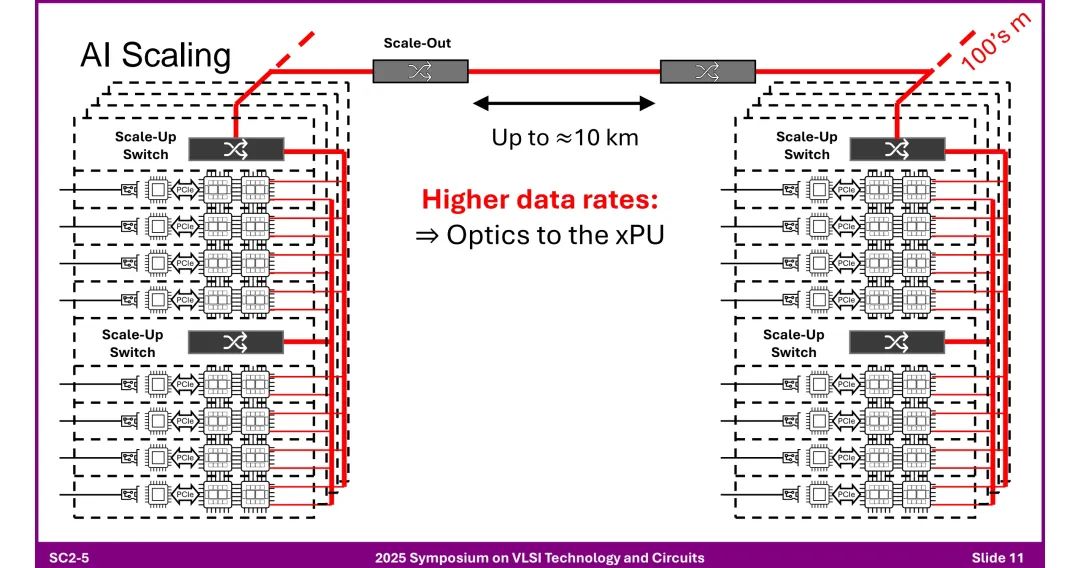

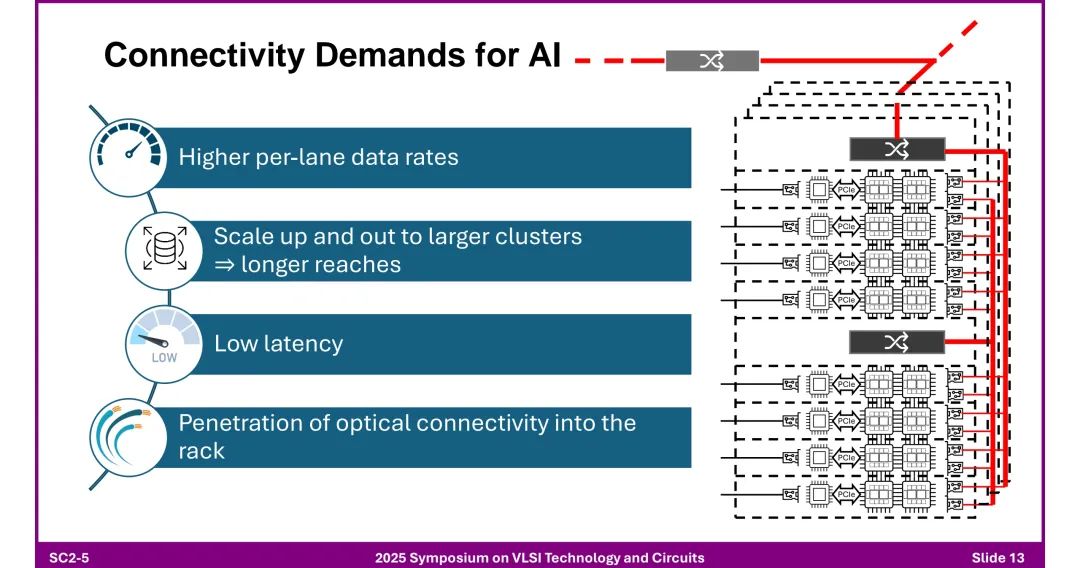

- 采用光学连接,支持数万至数十万节点(如Infiniband、Ethernet/UltraEthernet),通过“Scale-Out Switch”实现扩展。 ◆ 多机架及数据中心间: - 传输距离达10km,需引入光学元件,相干光学技术(Coherent Optics)开始应用于短距离场景(传统用于长距通信)。 ◆ 未来趋势:更高数据速率推动机架内光学渗透(“Optics within rack”),甚至直接连接到xPU(“Optics to the xPU”)。

三、AI计算的关键接口技术

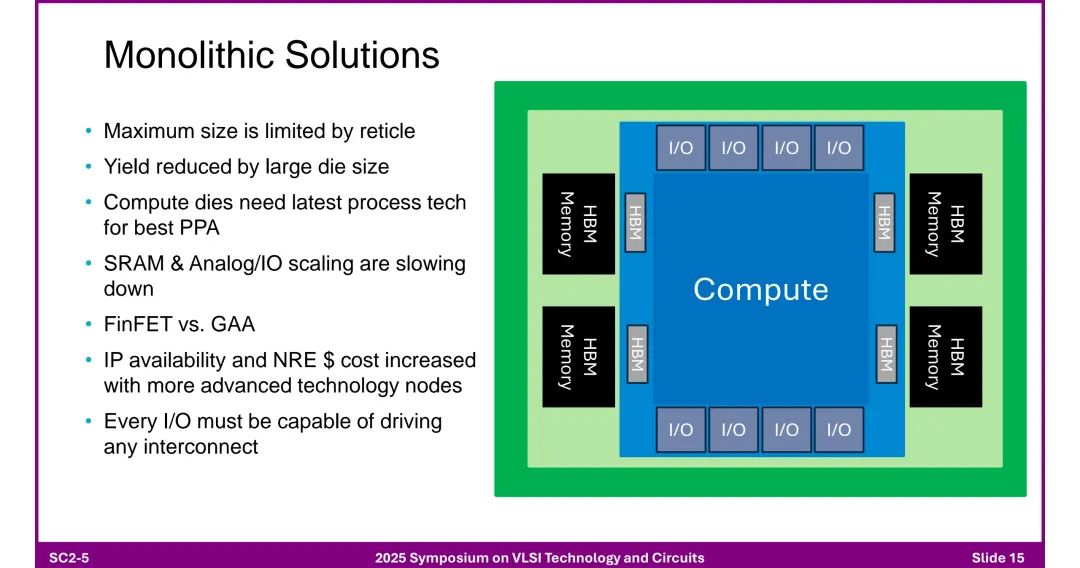

◆ 核心需求:更高每通道数据速率、更长传输距离、更低延迟,以及光学连接在机架内的普及。 四、芯粒架构:突破单芯片限制的关键 1. 单片解决方案的局限性 ◆ 物理限制:最大尺寸受掩模版(Reticle)限制,大芯片良率低。

◆ 技术瓶颈:SRAM和模拟/IO模块的缩放速度滞后于逻辑电路,FinFET向GAA(全环绕栅极)过渡中,IP可用性降低,NRE(非经常性工程)成本随工艺节点提升而激增。

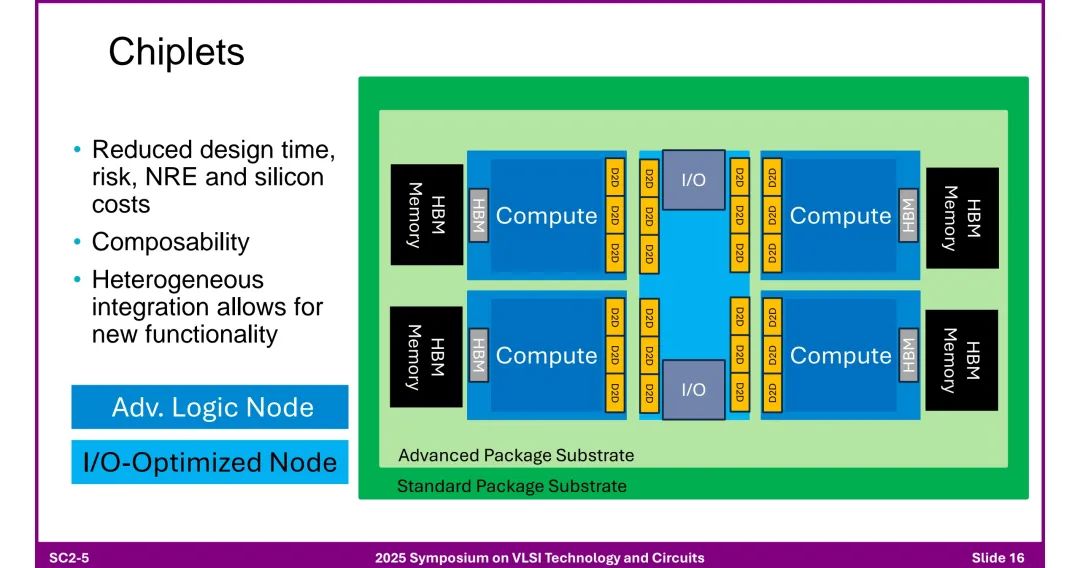

◆ 设计约束:所有I/O需兼容任意互连,灵活性差。 2. 芯粒(Chiplet)架构的优势 ◆ 成本与效率:降低设计时间、风险及硅成本,支持异构集成(如先进逻辑芯粒+IO优化芯粒)。

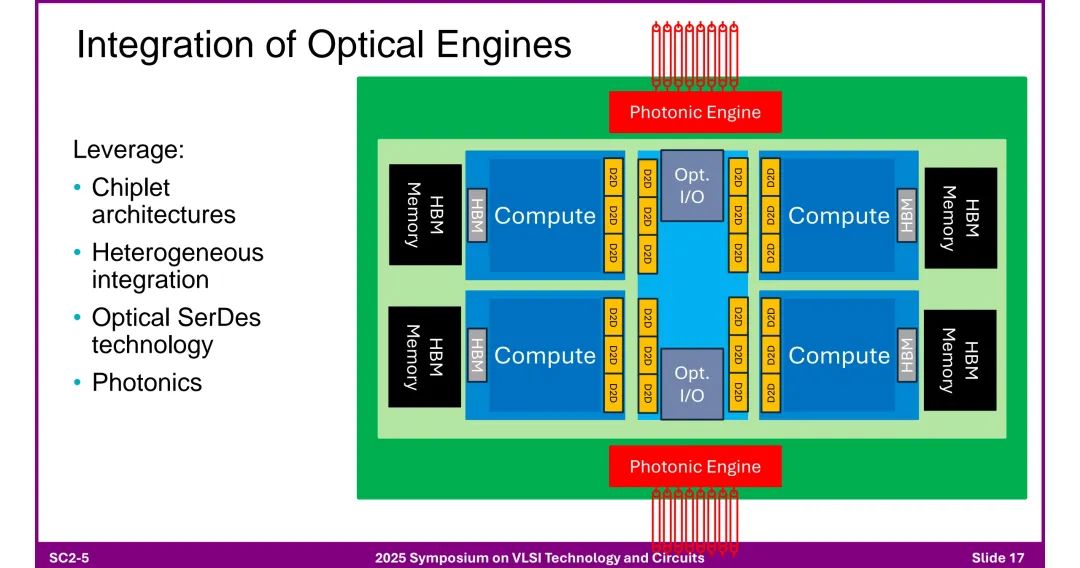

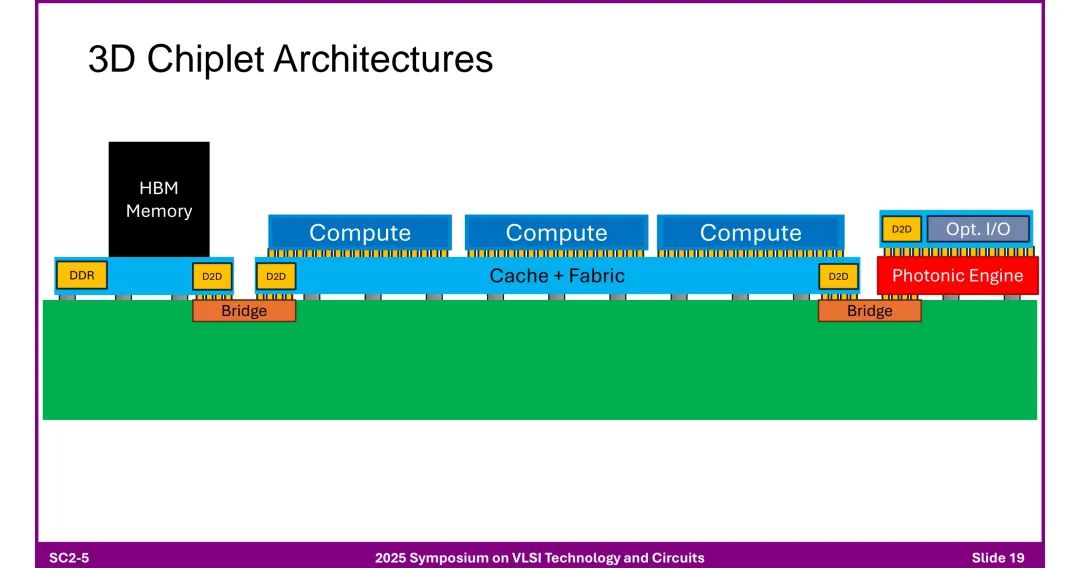

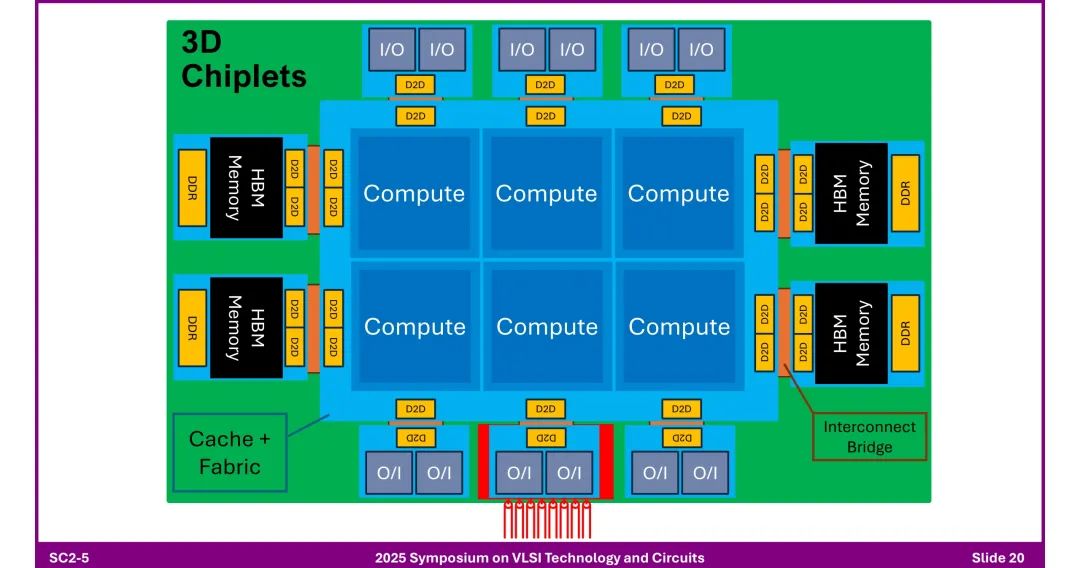

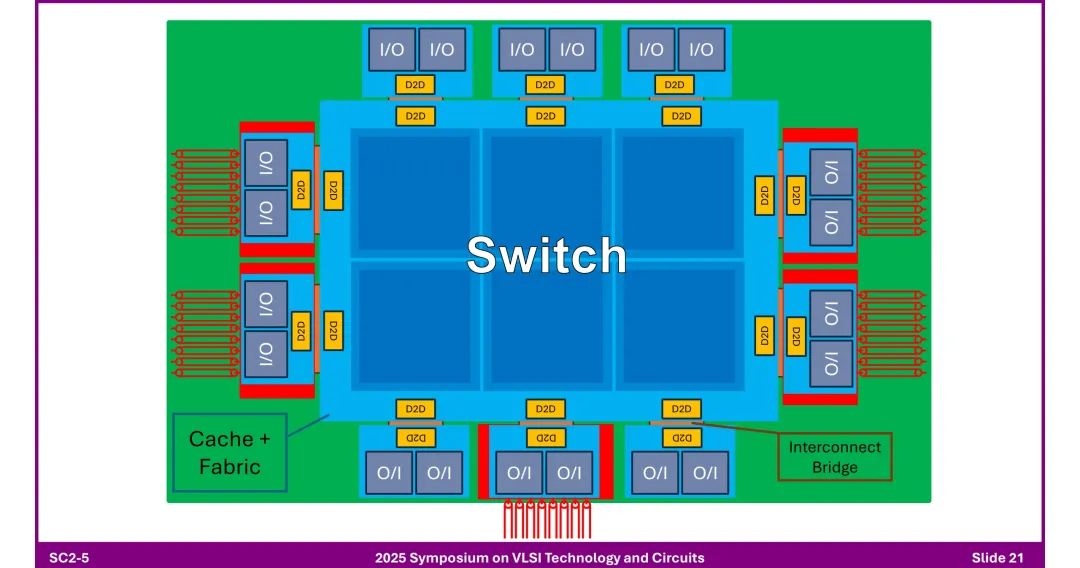

◆ 功能扩展:通过D2D接口组合不同功能芯粒(计算、内存、I/O),支持HBM内存高密度集成。 3. 3D芯粒架构 ◆ 堆叠计算层、内存层(HBM、DDR),通过D2D接口实现层间互联,集成“Cache + Fabric”提升数据调度效率。

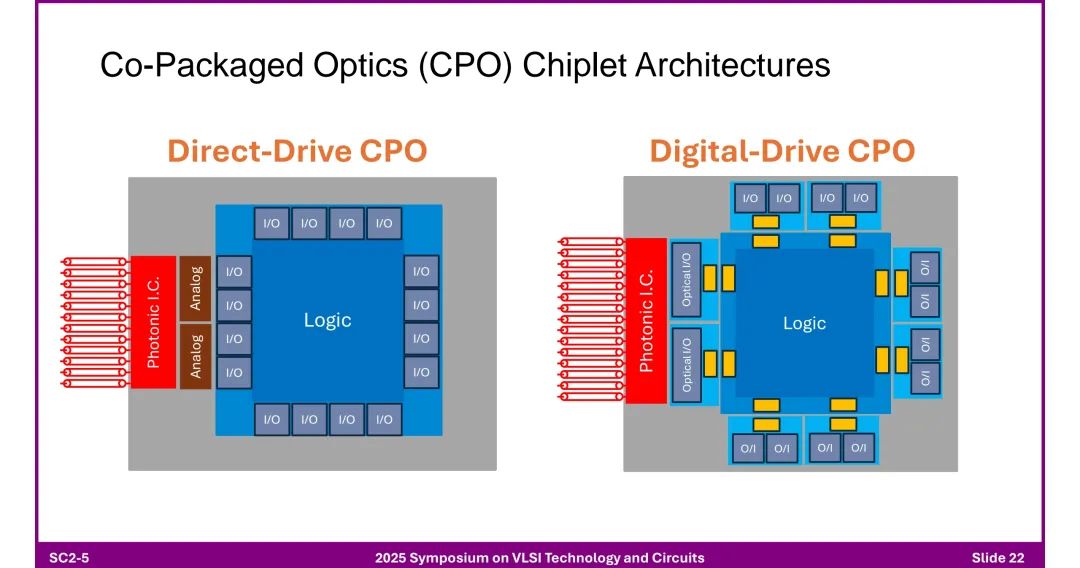

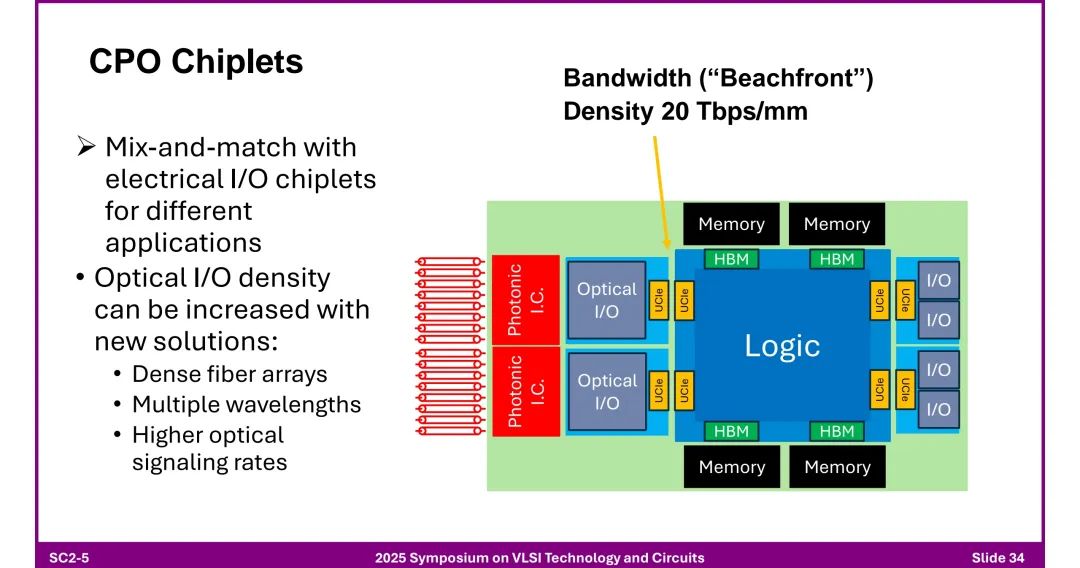

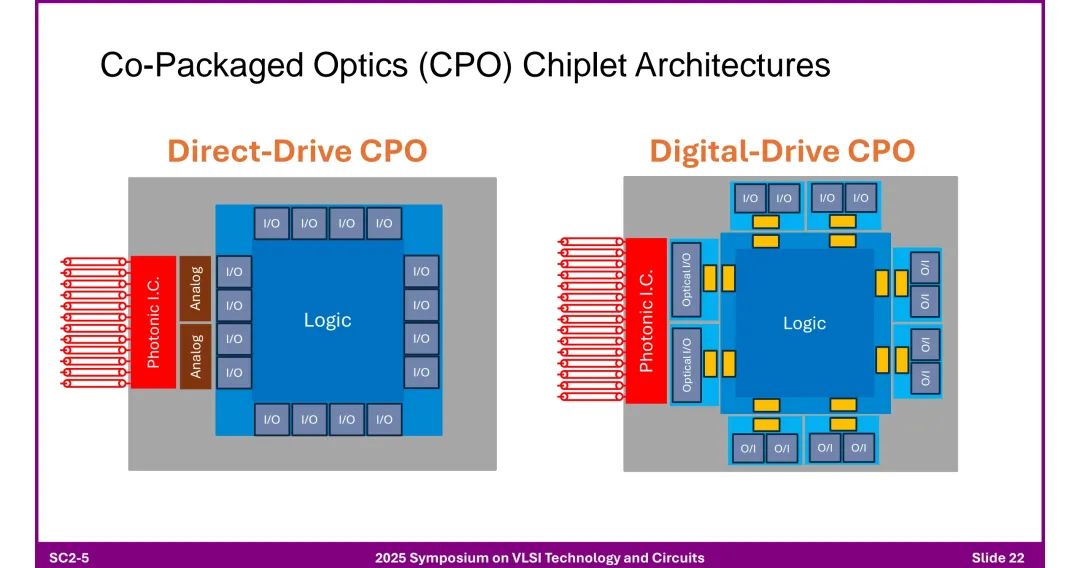

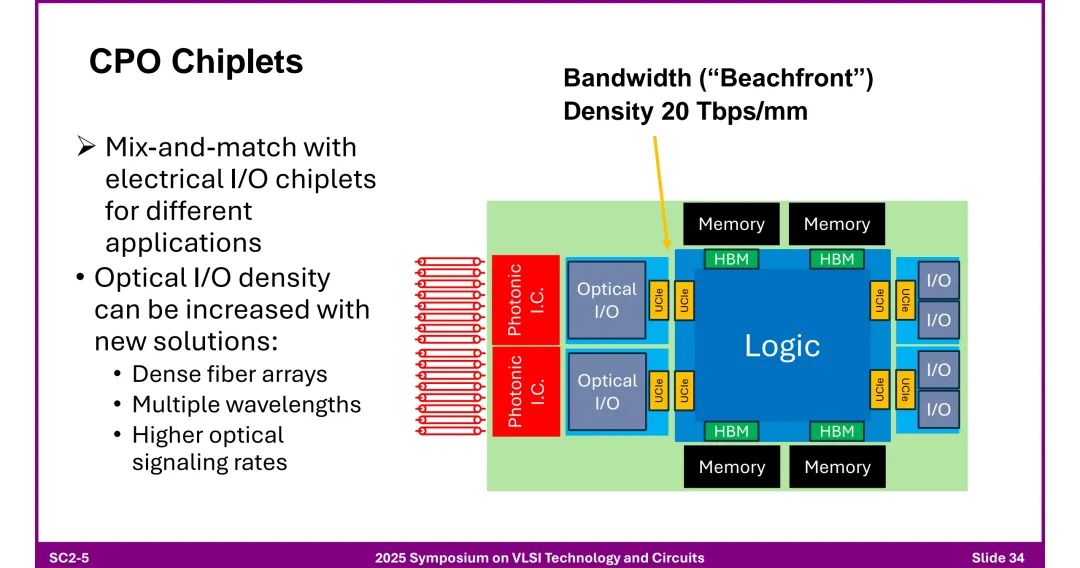

◆ 引入光引擎(Photonic Engine):将光学SerDes与芯粒结合,通过OIO实现高密度光互联。 4. 共封装光学(CPO)芯粒 ◆ 两种架构 - 直接驱动CPO(Direct-Drive CPO):模拟电路与光子IC直接连接。

- 数字驱动CPO(Digital-Drive CPO):逻辑电路通过数字接口控制光子IC。

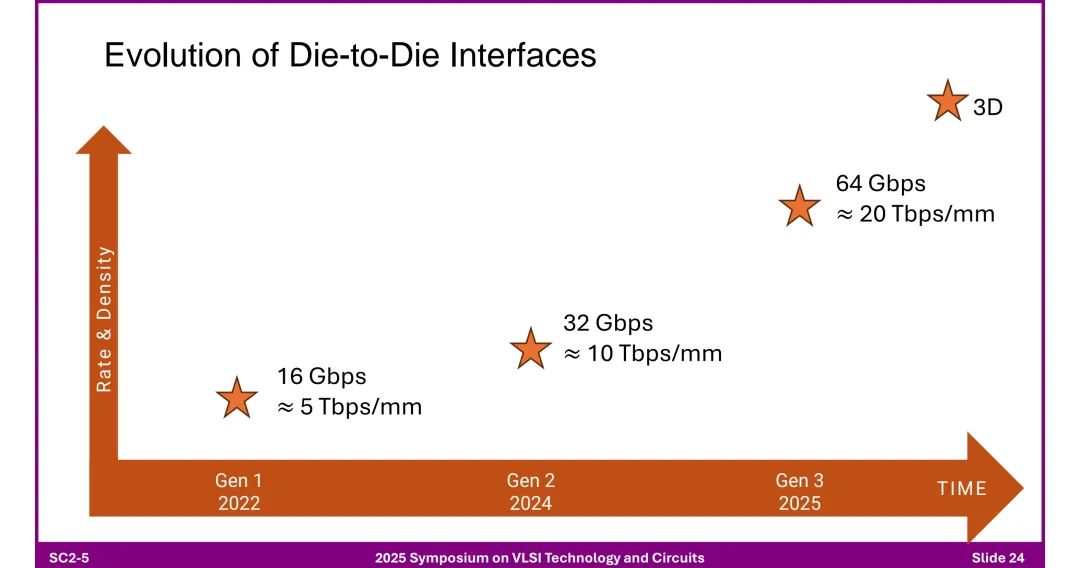

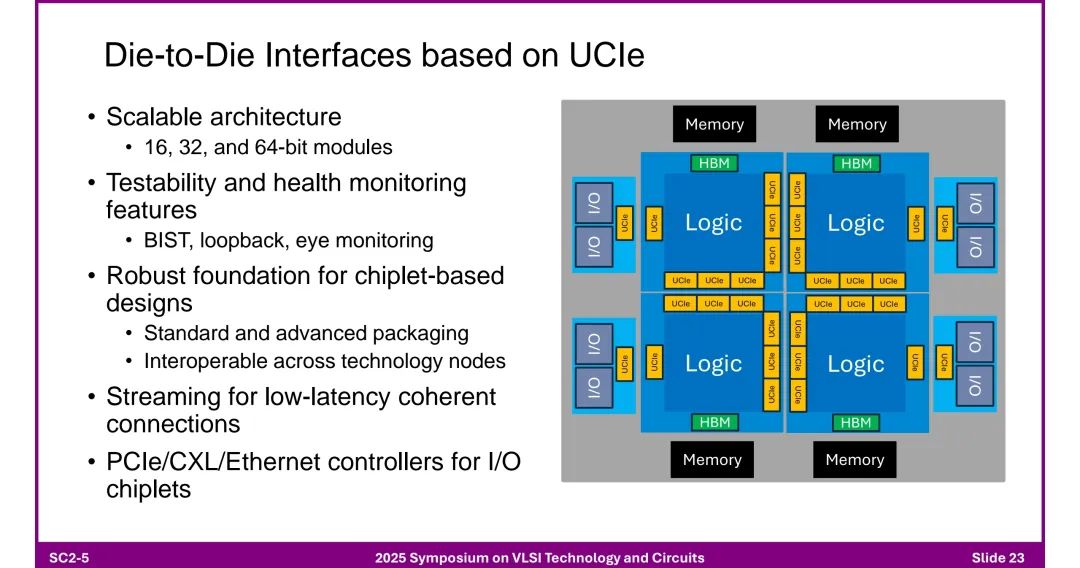

五、Die-to-Die接口的演进与标准 1. UCIe标准

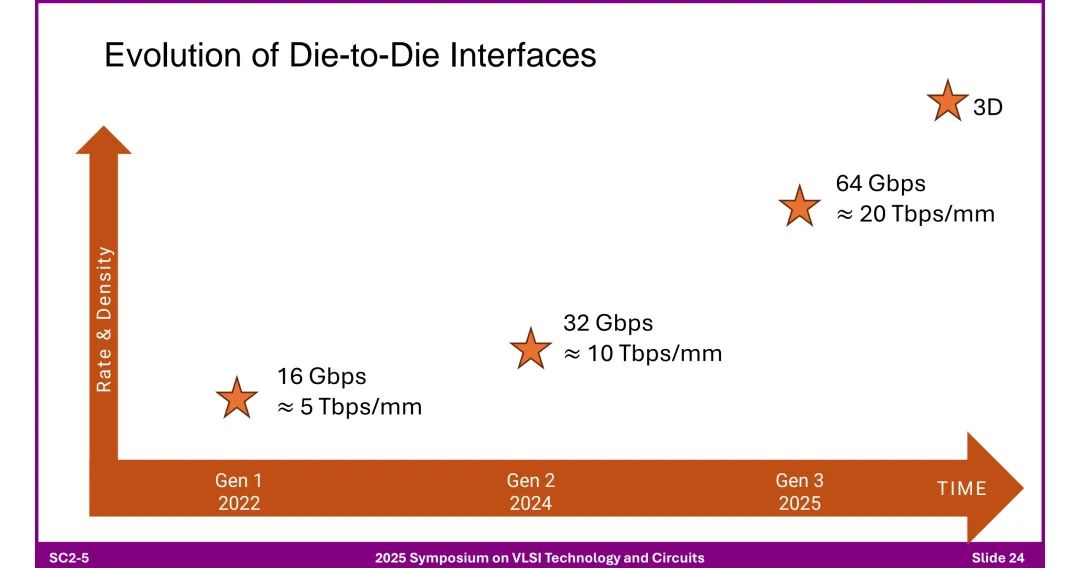

◆ 核心特性: - 可扩展架构(16/32/64位模块),支持测试性(BIST、环回、眼图监测)。 - 兼容标准与先进封装,跨工艺节点互操作,支持低延迟相干连接。 - 应用场景:连接计算芯粒、内存芯粒(HBM)、I/O芯粒,是芯粒设计的基础协议。 2. 性能演进路线

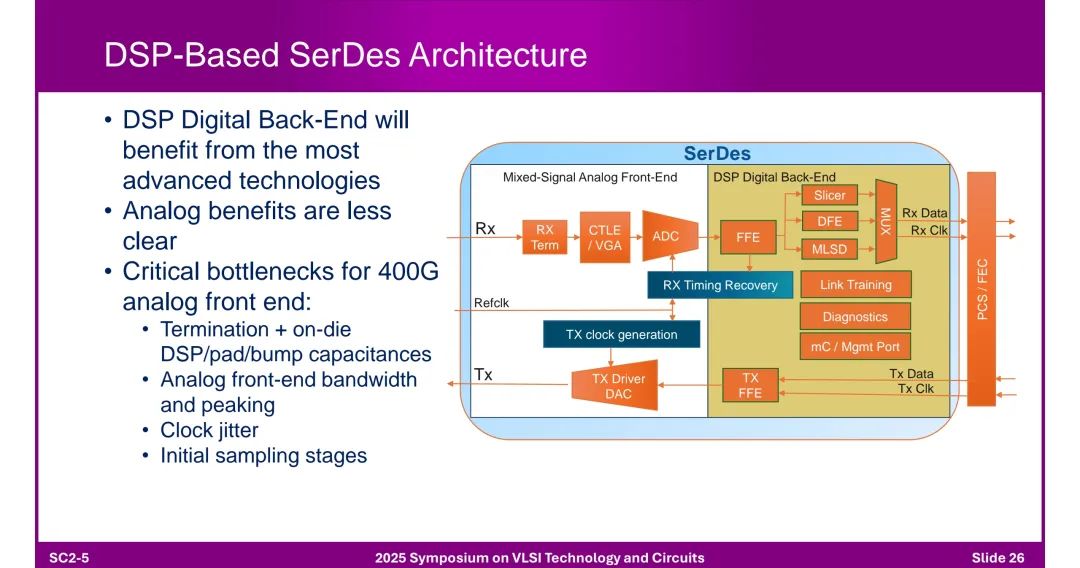

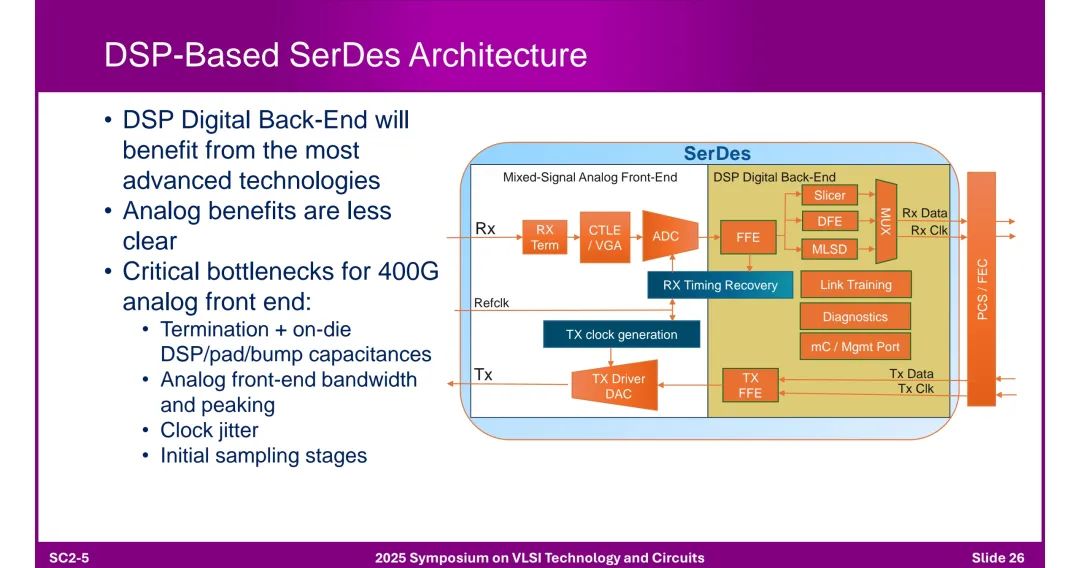

六、高速I/O电路设计与挑战 1. DSP-Based SerDes架构

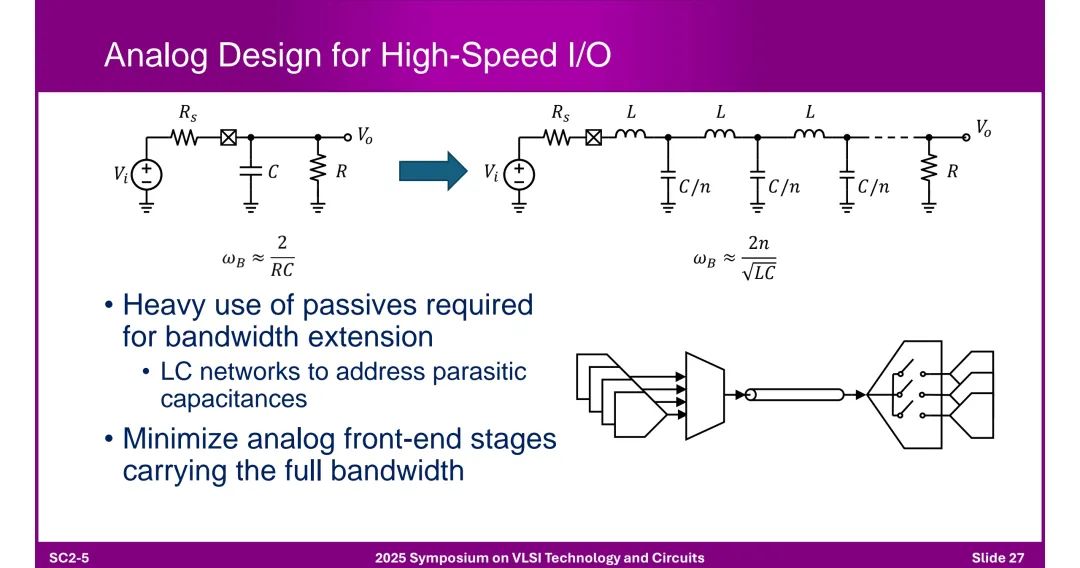

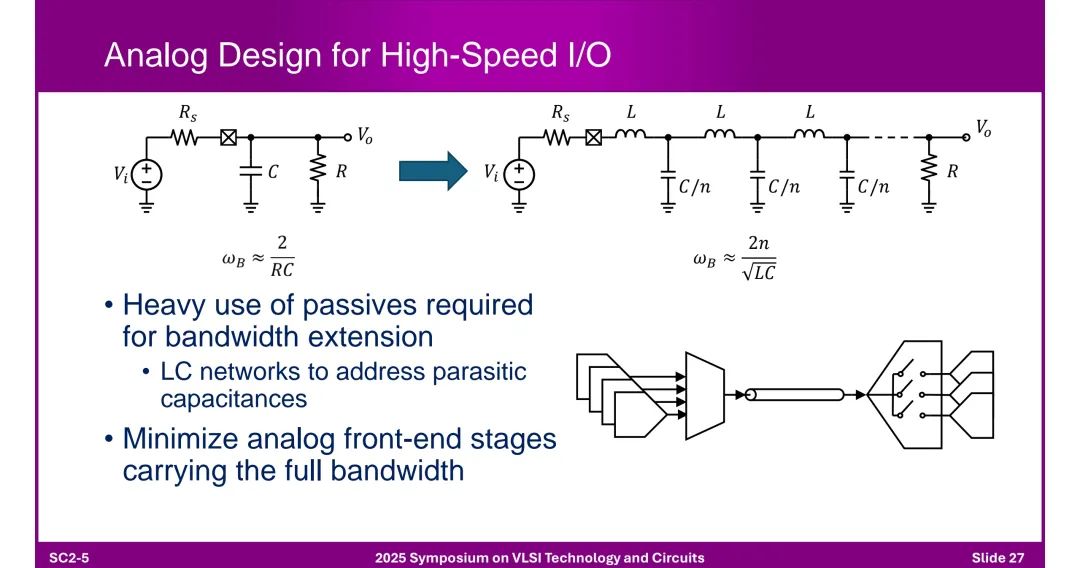

◆ 结构组成: - 模拟前端(Mixed-Signal AFE):含CTLE(连续时间线性均衡器)、FFE(前馈均衡器)、ADC等。 - 数字后端(DSP):负责时序恢复、FEC(前向纠错)、链路训练等,受益于先进工艺节点。 ◆ 瓶颈:400G模拟前端面临终端电容、带宽限制、时钟抖动等问题。 2. 模拟设计关键技术

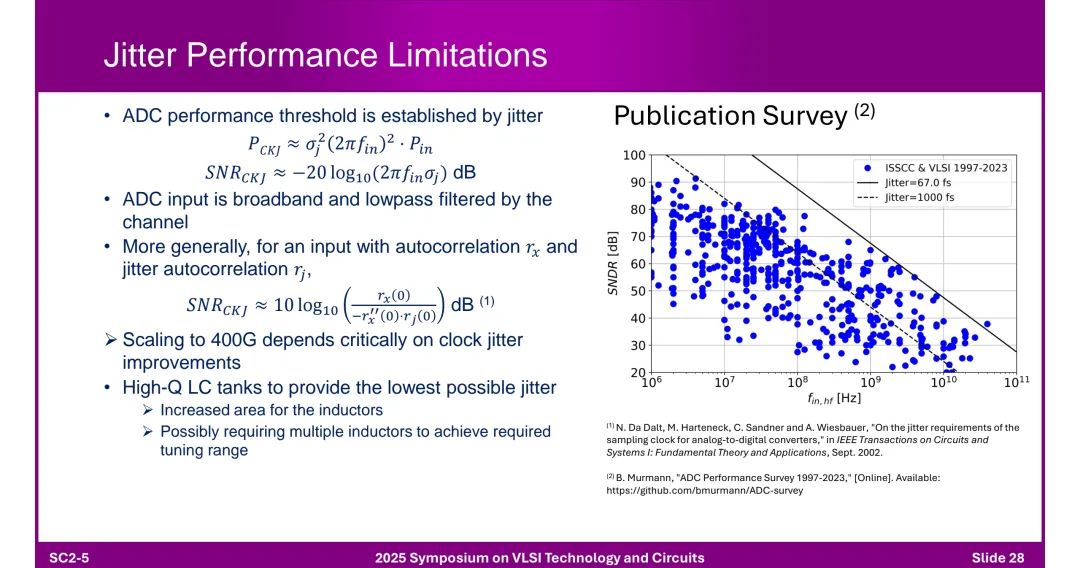

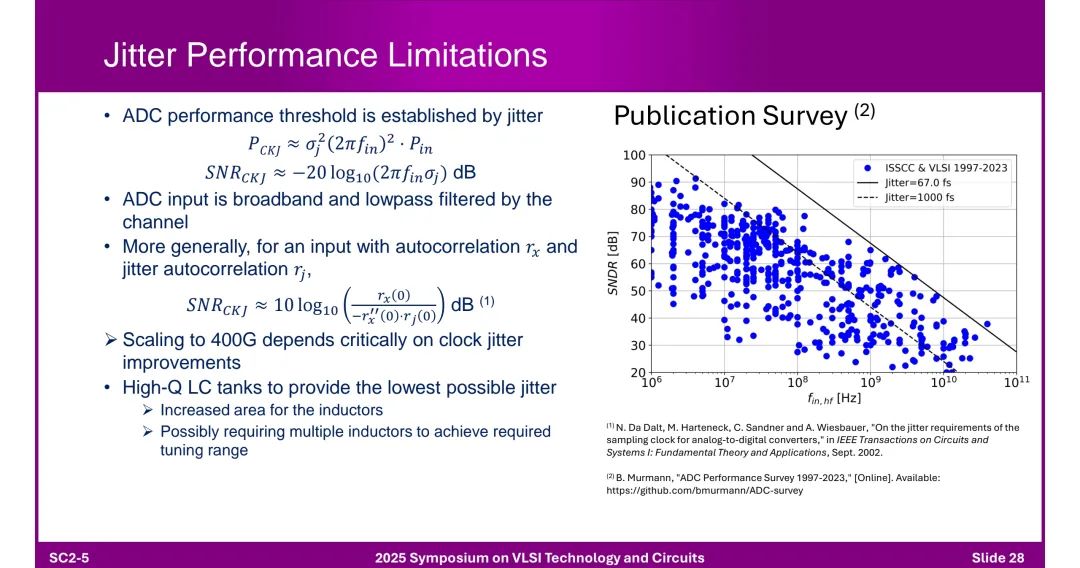

◆ 带宽扩展:依赖LC网络抑制寄生电容。 ◆ 抖动性能:时钟抖动直接影响ADC性能,需通过高Q值LC谐振腔降低抖动(目前最佳水平达67 fs,1997-2023年从1000 fs大幅改进)。

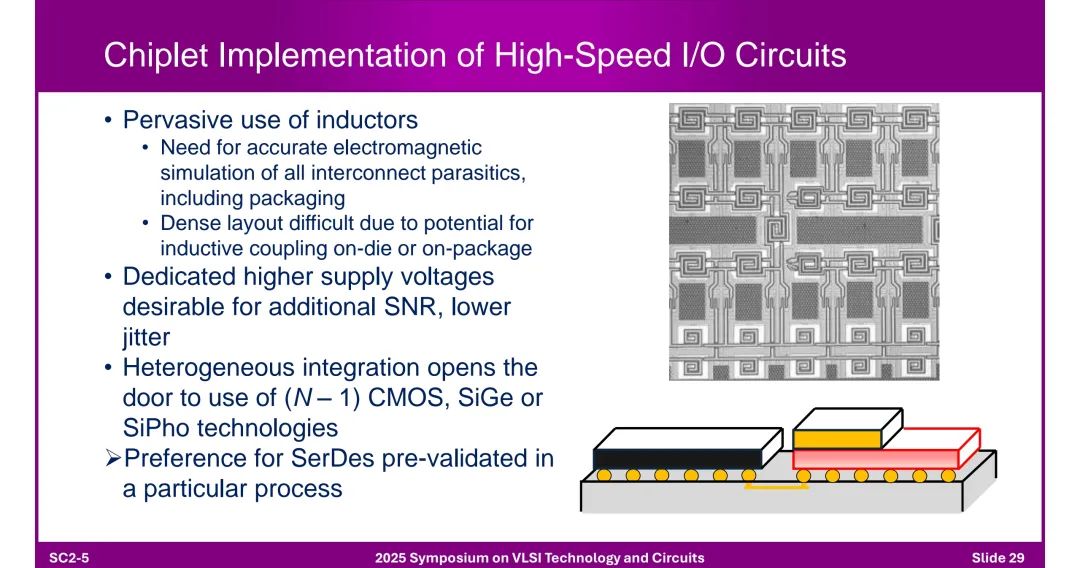

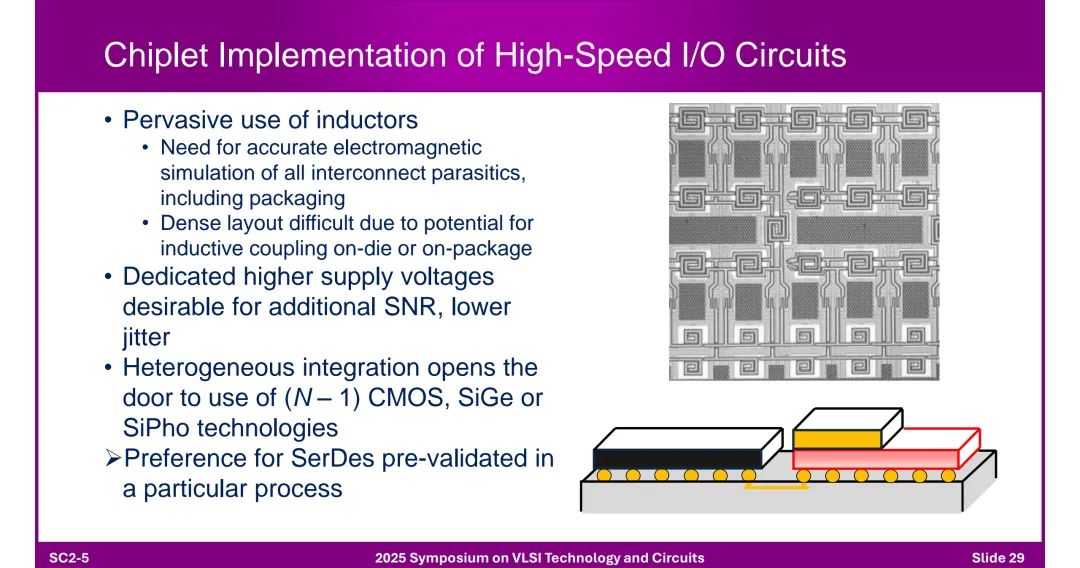

3. 芯粒实现的设计要点 ◆ 需精确仿真互连寄生参数(含封装),避免电感耦合;建议采用独立高电压供电提升SNR;可异构集成(如N-1代CMOS、SiGe、SiPho技术)。

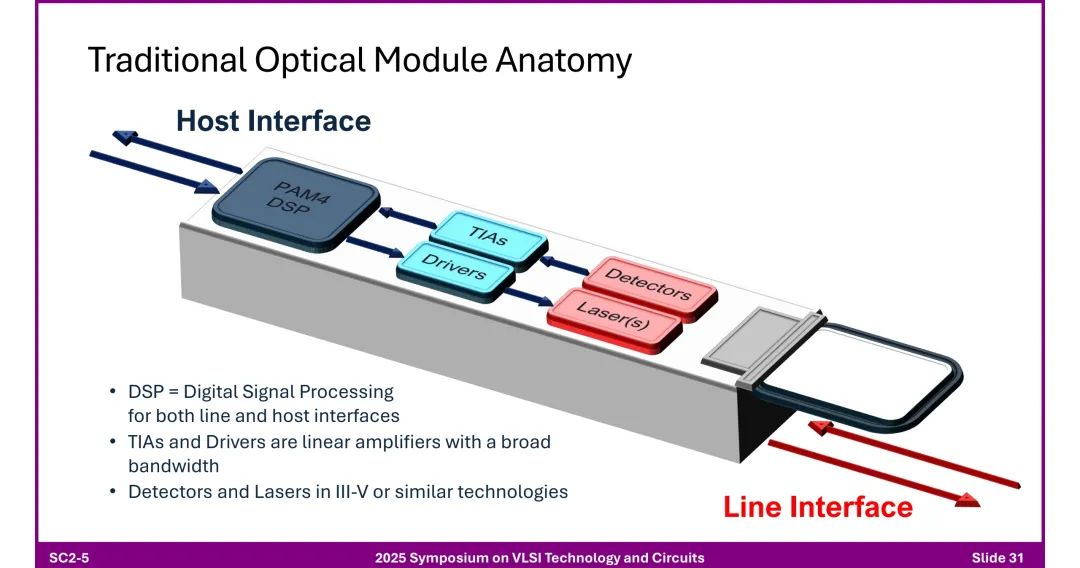

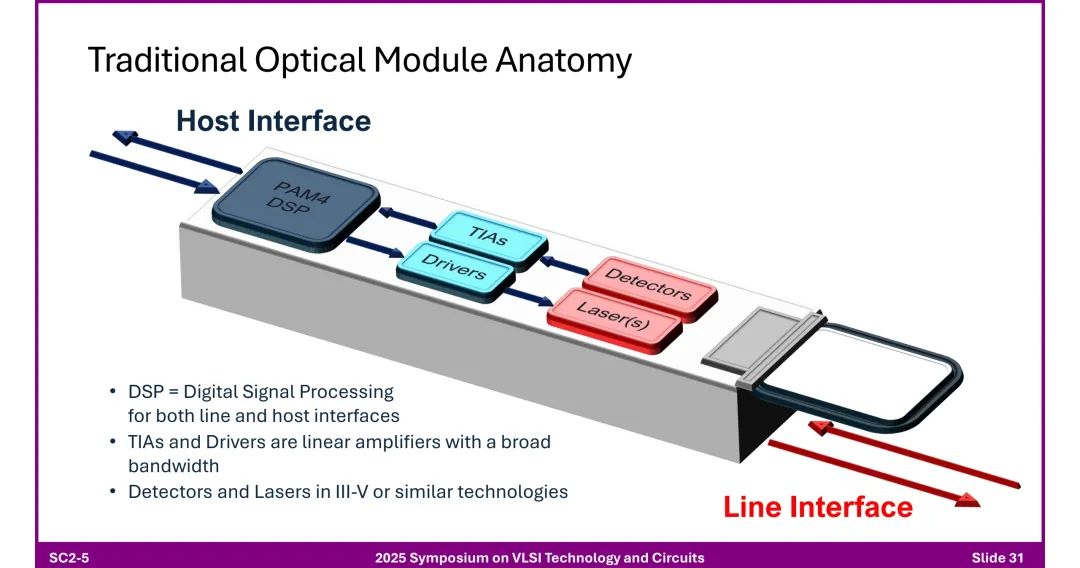

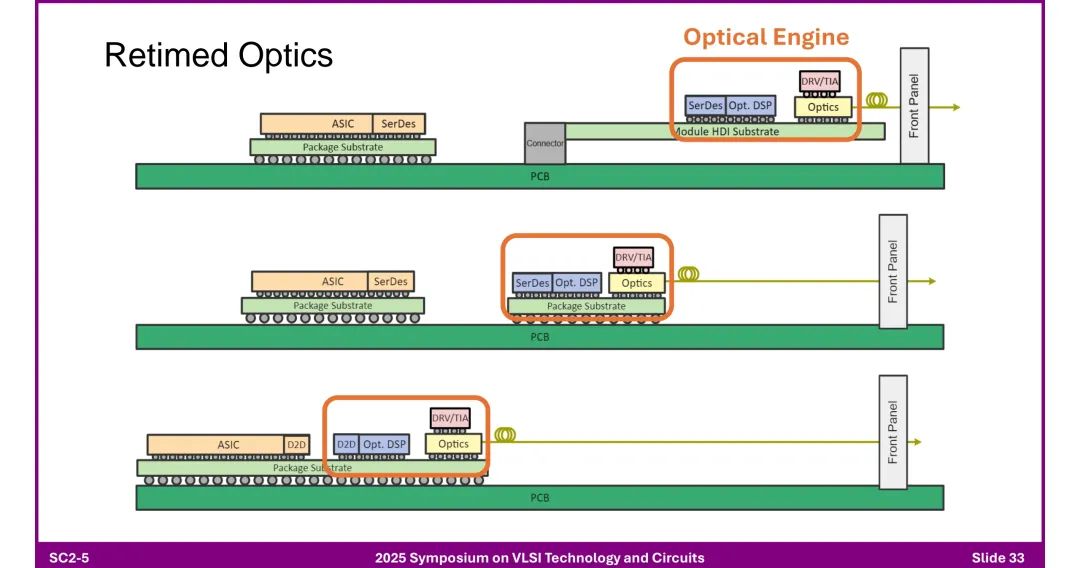

七、光模块的芯粒化与优化 1. 传统与新型光学模块 ◆ 传统模块:含DSP PAM4、驱动器、激光器(III-V材料)、TIAs(跨阻放大器),组件多、成本高。

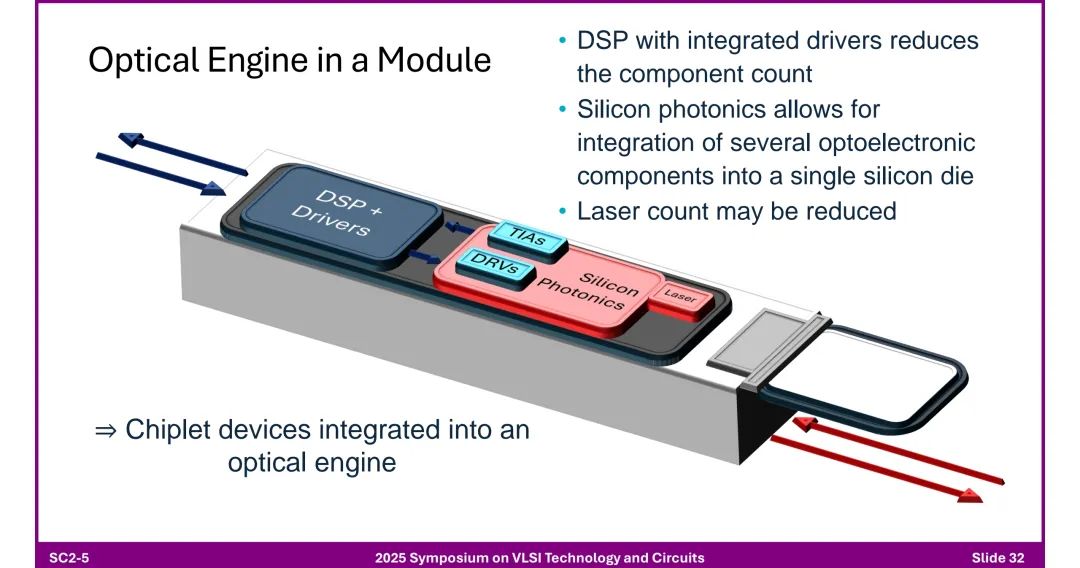

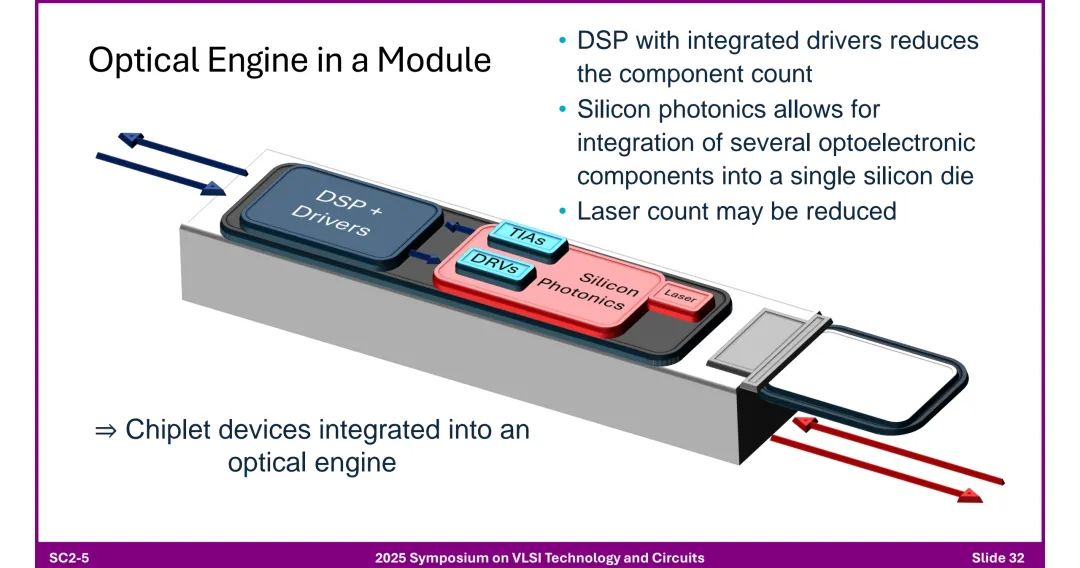

◆ 光学引擎:DSP集成驱动器,通过硅光子技术将光电器件集成到硅基芯片,减少激光器数量,支持芯粒化集成。

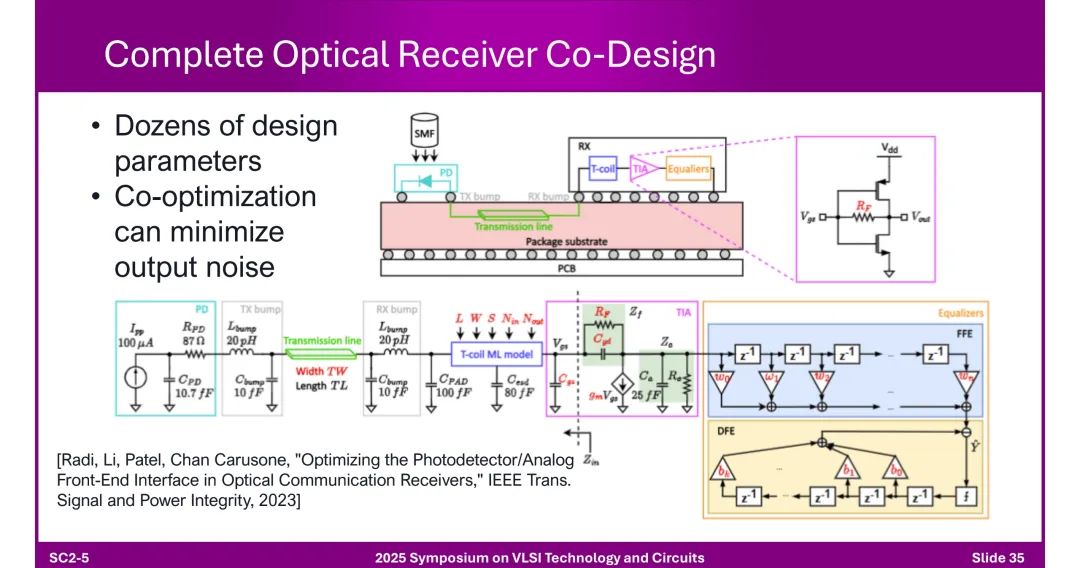

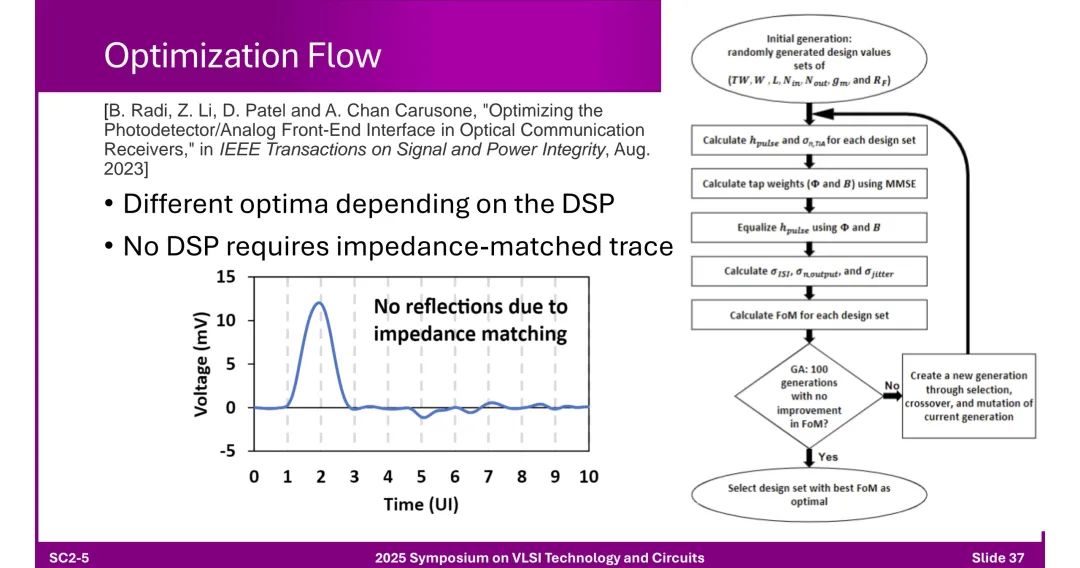

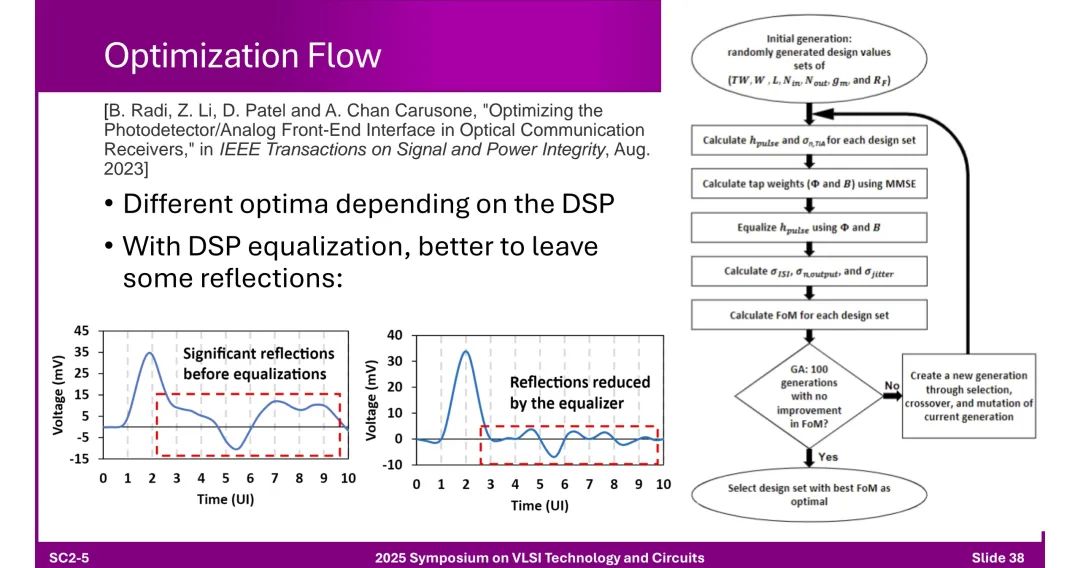

2. 优化流程 ◆ 接收机协同设计:需优化光电探测器(PD)、TIA、均衡器等数十个参数,通过MMSE(最小均方误差)算法调整抽头权重,降低输出噪声。

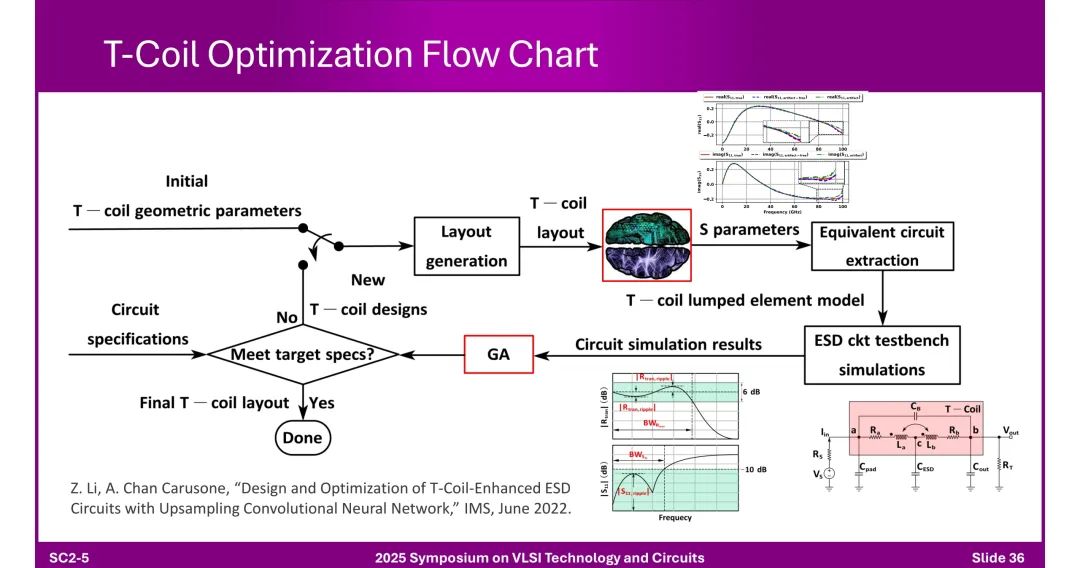

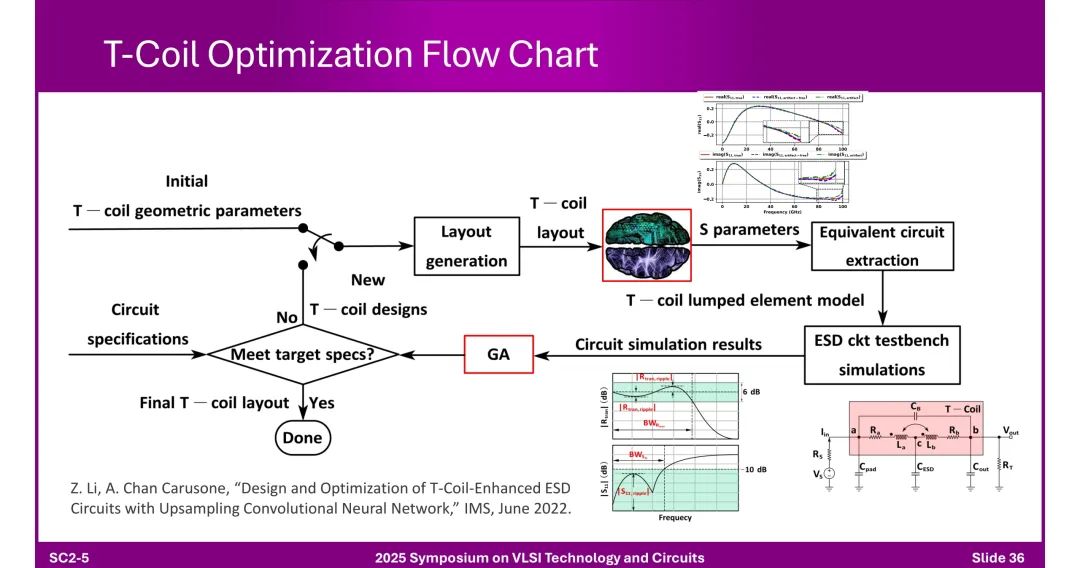

◆ T-Coil优化:通过几何参数调整、电磁仿真、遗传算法(GA)迭代,通过电感peaking实现带宽扩展与ESD防护平衡。

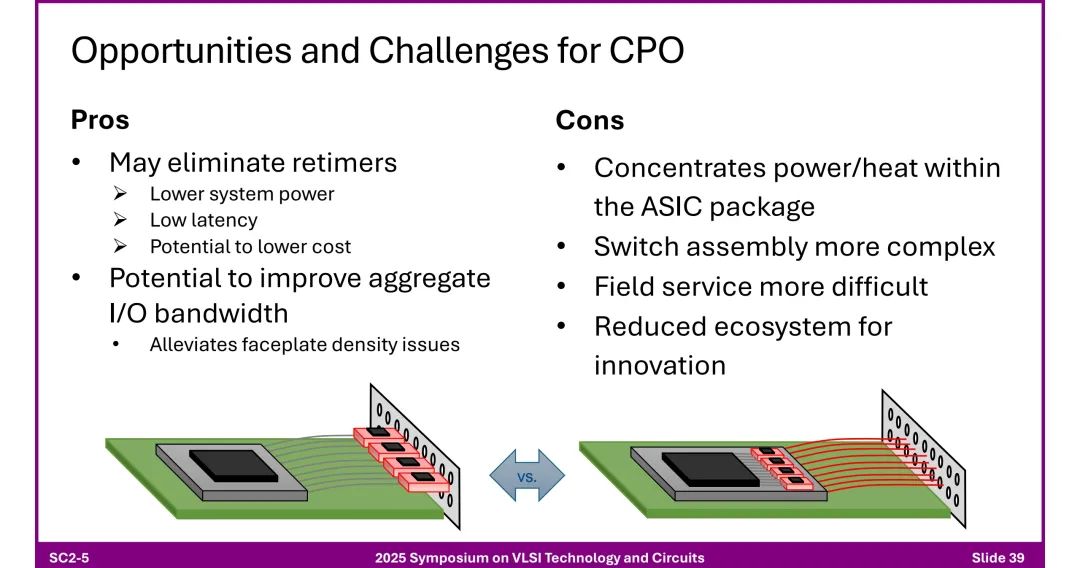

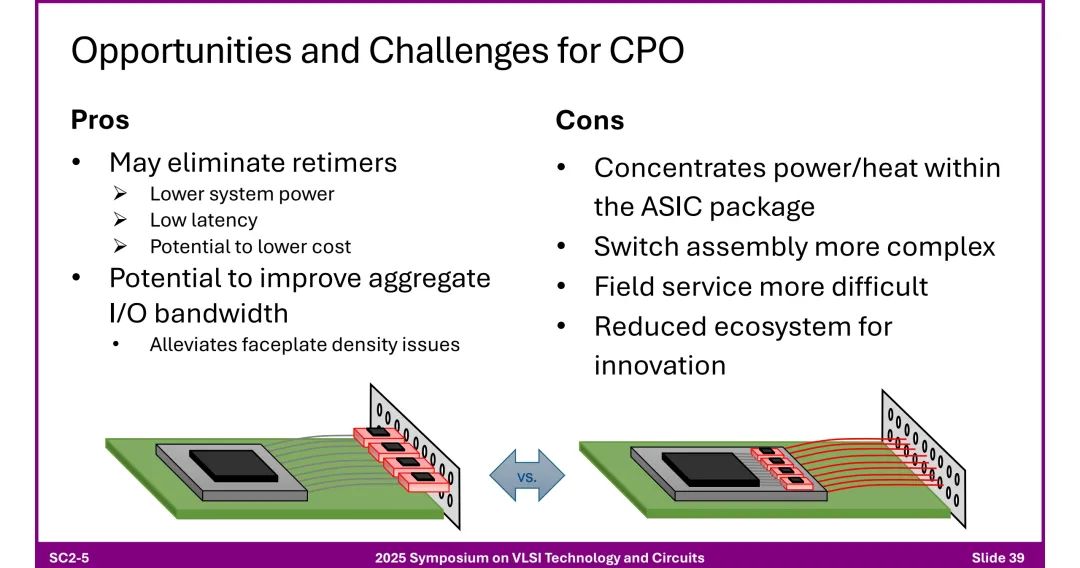

3. CPO的机遇与挑战

◆ 优势:消除重定时器、降低功耗、低延迟、提升带宽密度、缓解面板接口限制。 ◆ 挑战:封装内热量集中、组装复杂、现场维护困难、生态系统创新受限。

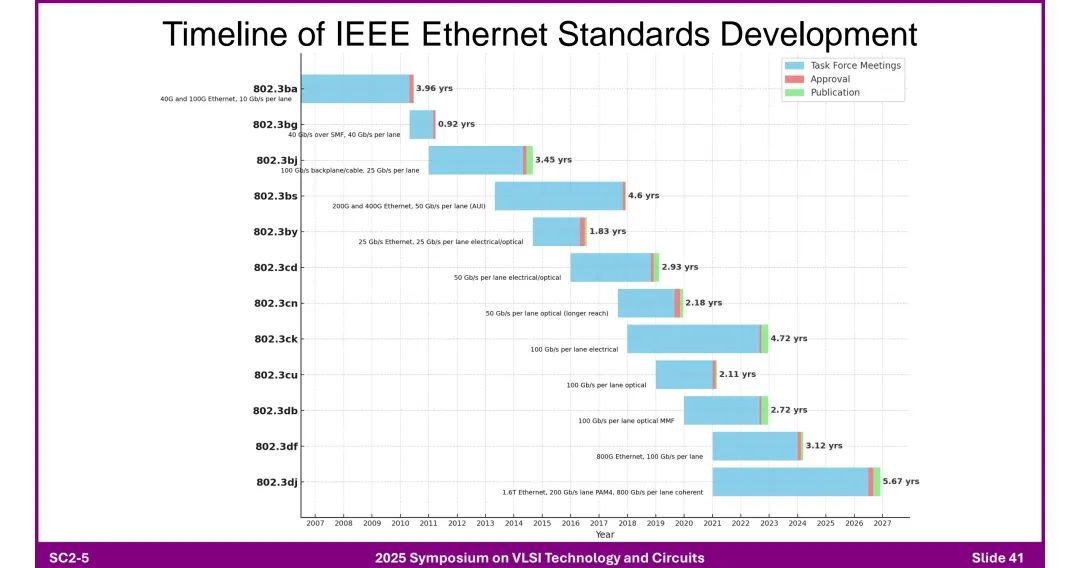

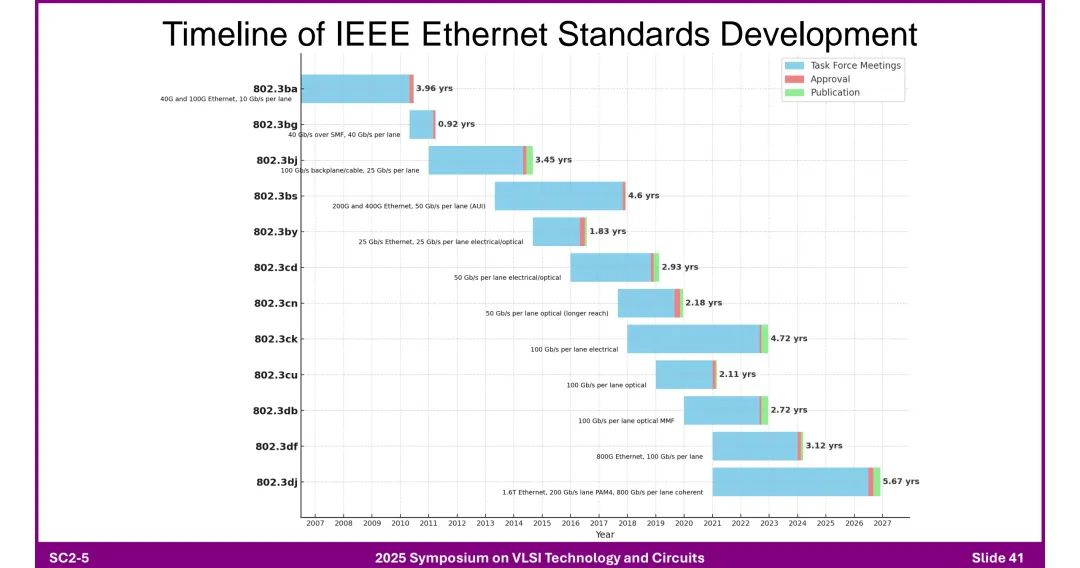

八、连接标准的演进时间线 1. IEEE以太网标准

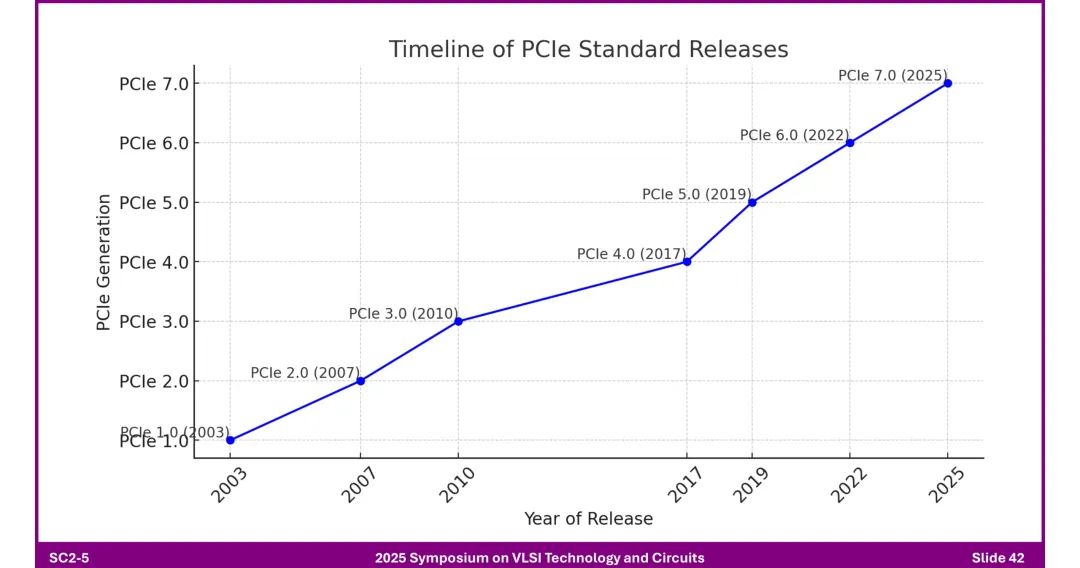

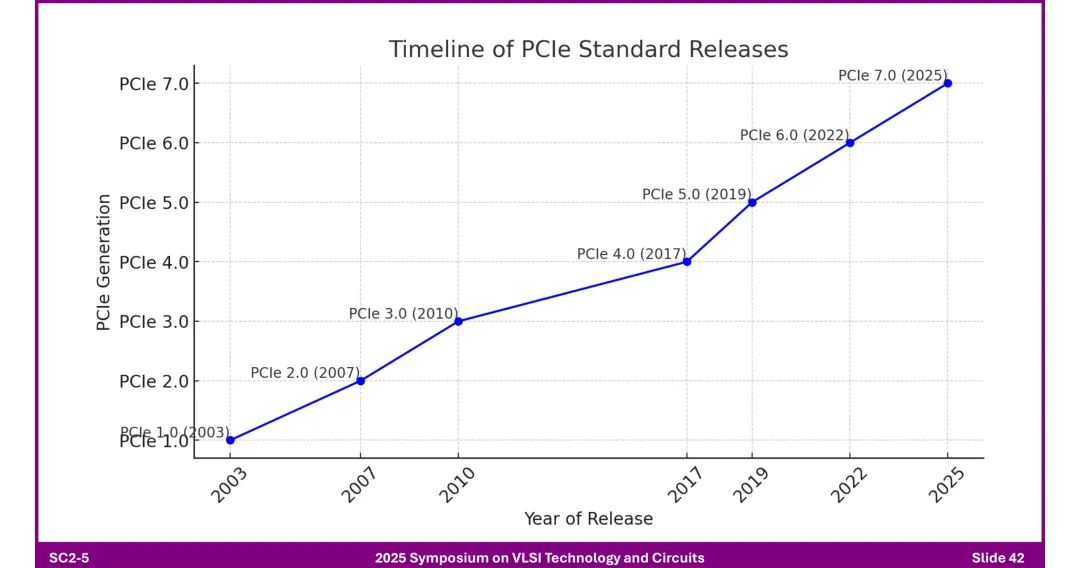

2. PCIe标准

◆ 发布节奏:每代协议速率翻倍,但开发周期(3年)滞后于AI硬件12个月升级节奏。

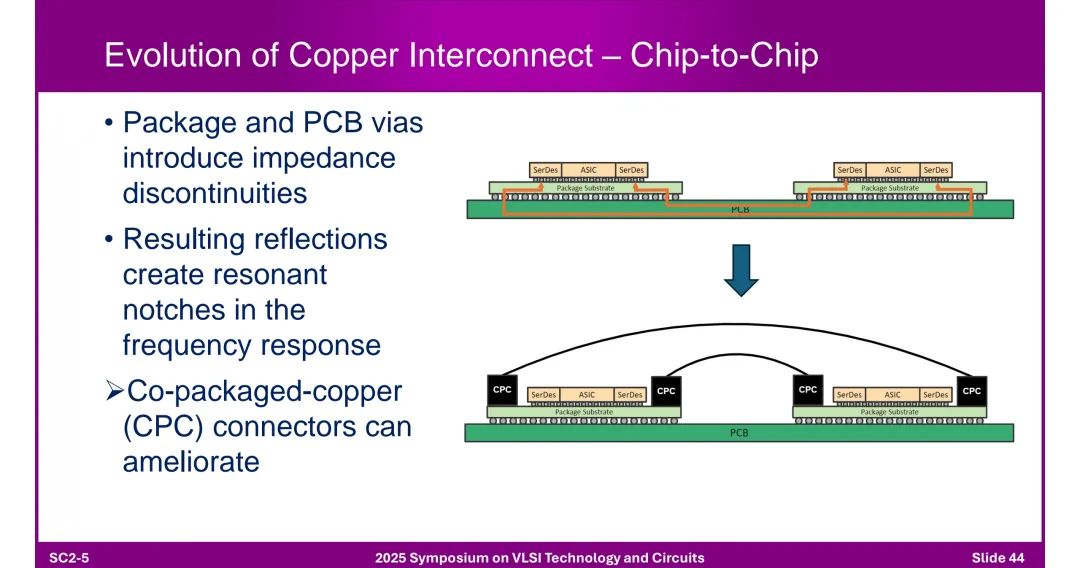

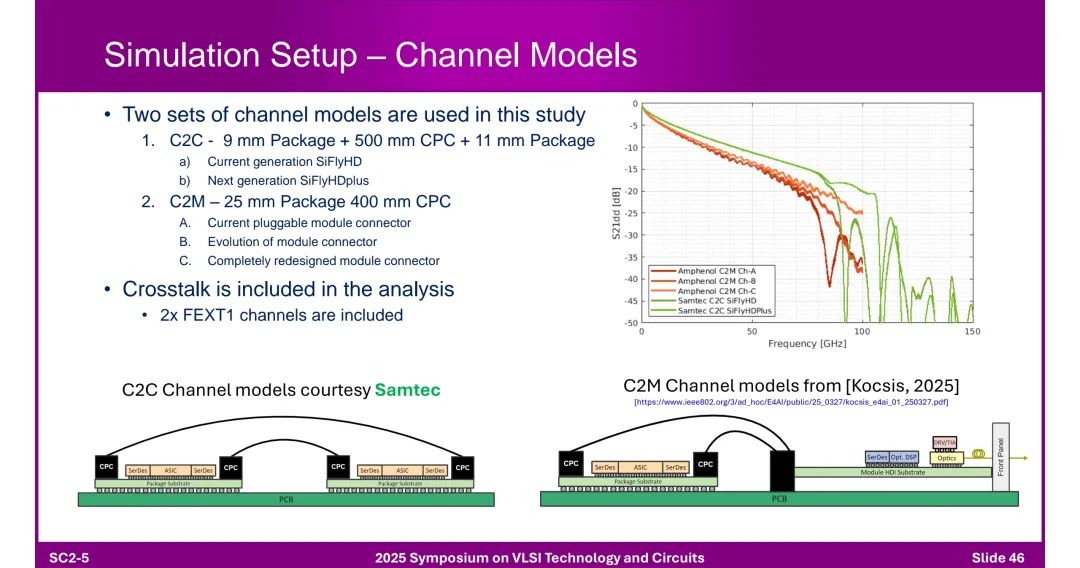

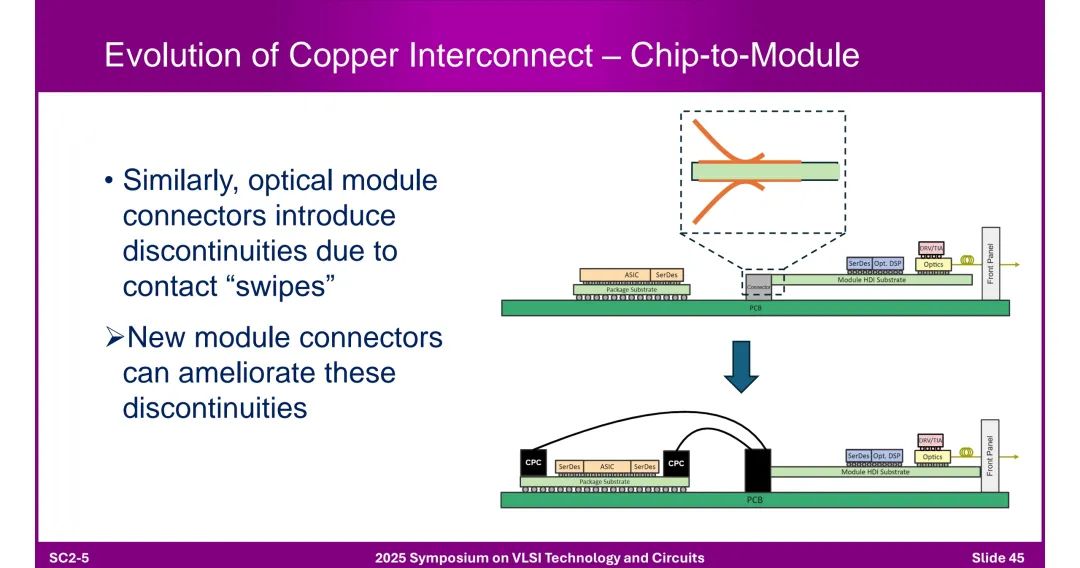

九、铜互连与高速电气/光学可行性 1. 铜互连的演进 ◆ 芯片到芯片(C2C):封装和PCB过孔导致阻抗不连续,共封装铜(CPC)连接器可改善,仿真模型涵盖9mm封装+500mm CPC+11mm封装场景。

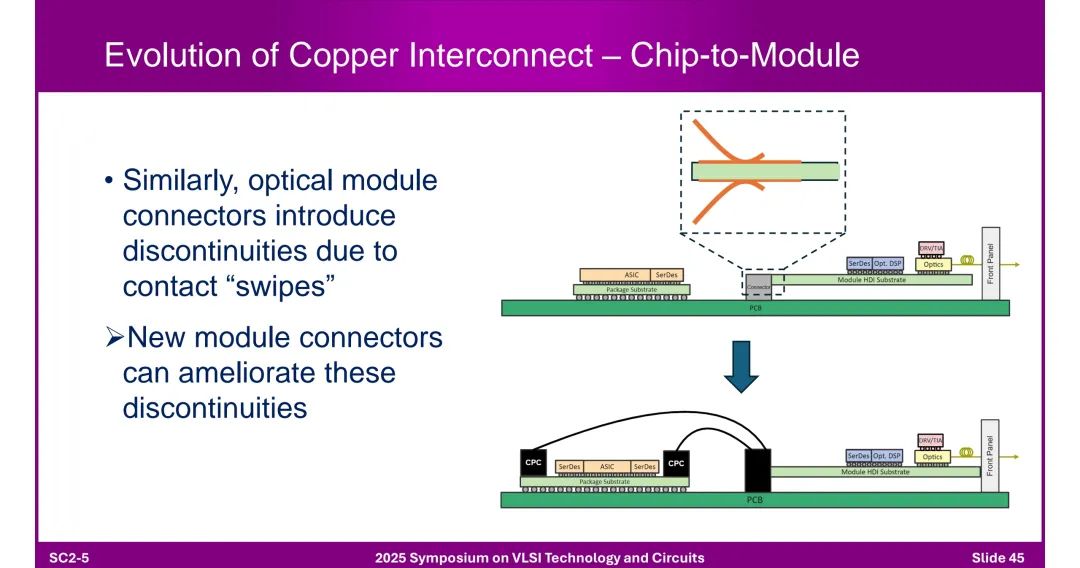

◆ 芯片到模块(C2M):连接器接触“swipes”引入不连续,需通过新型连接器设计缓解。

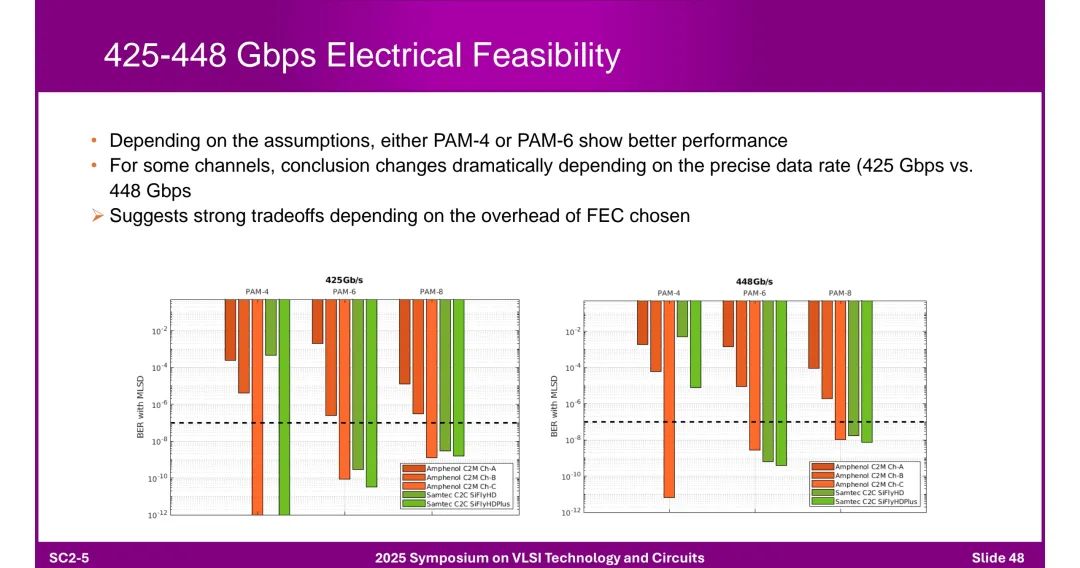

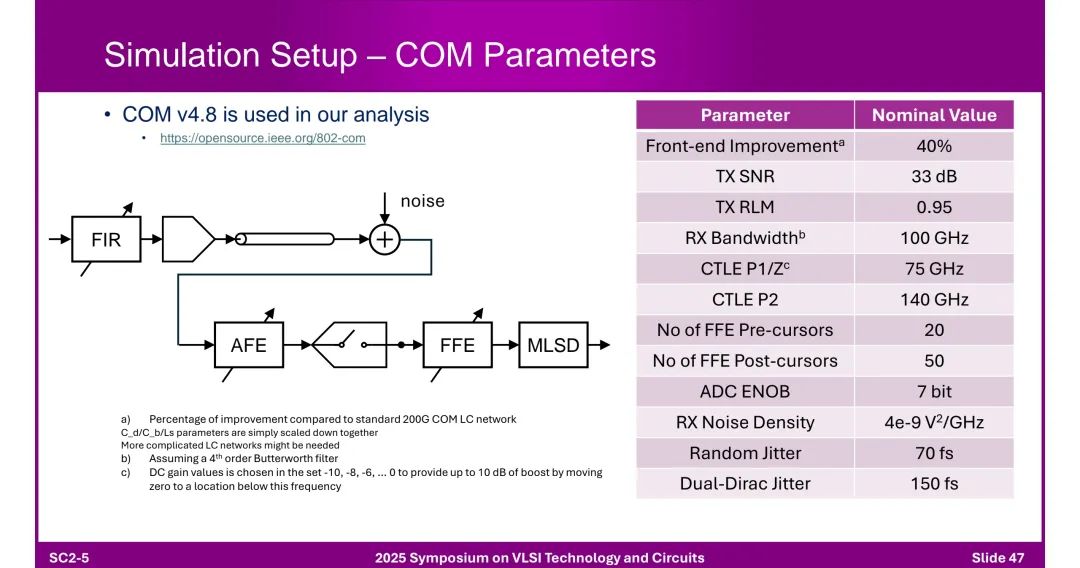

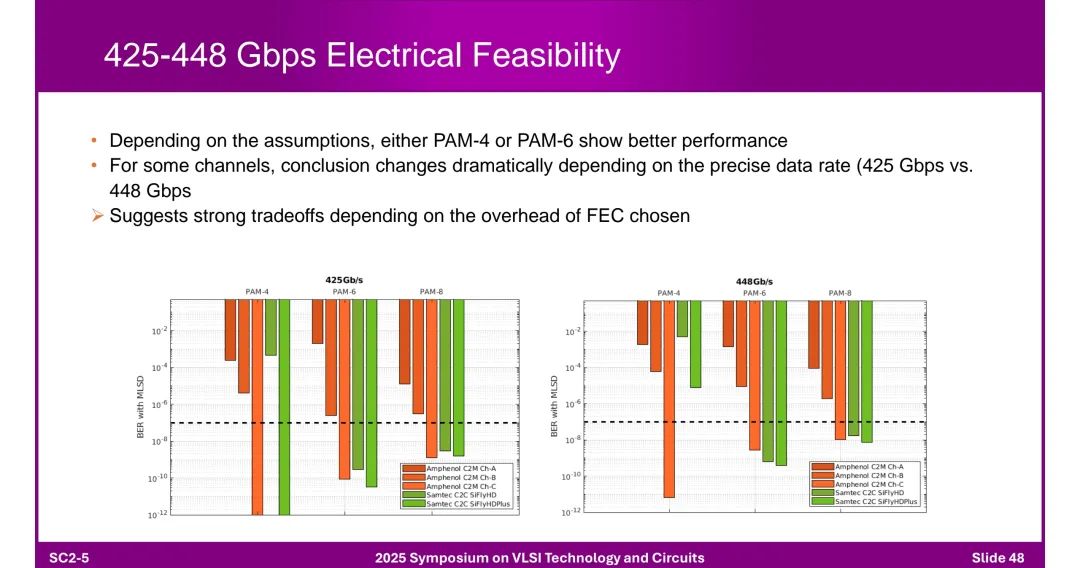

2. 400G+电传输可行性

◆ 调制方式对比:PAM-4与PAM-6/8性能受数据速率(425 Gbps vs 448 Gbps)和FEC开销影响,需根据场景权衡。 3. 光学传输突破

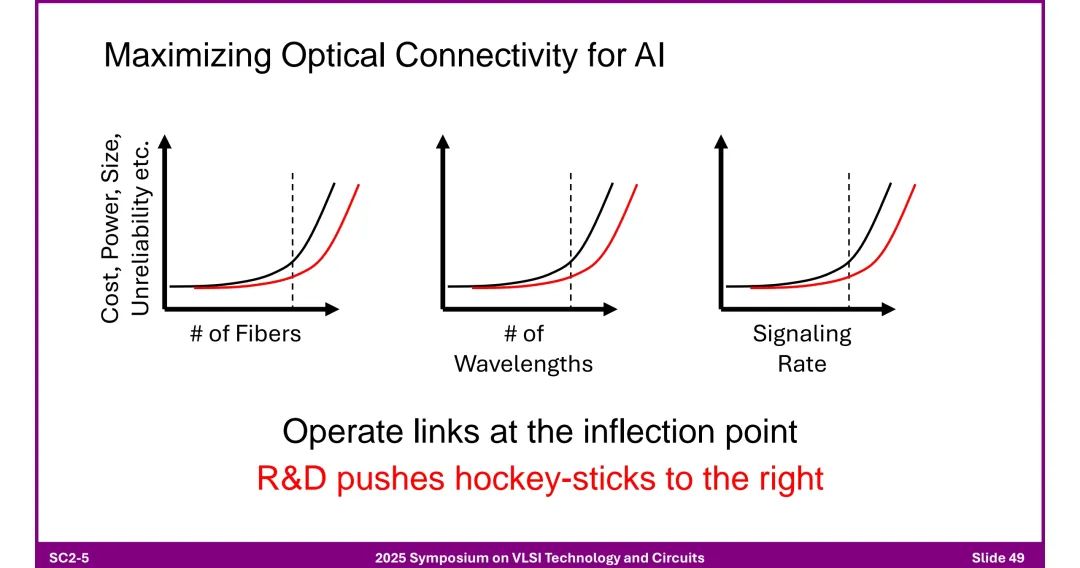

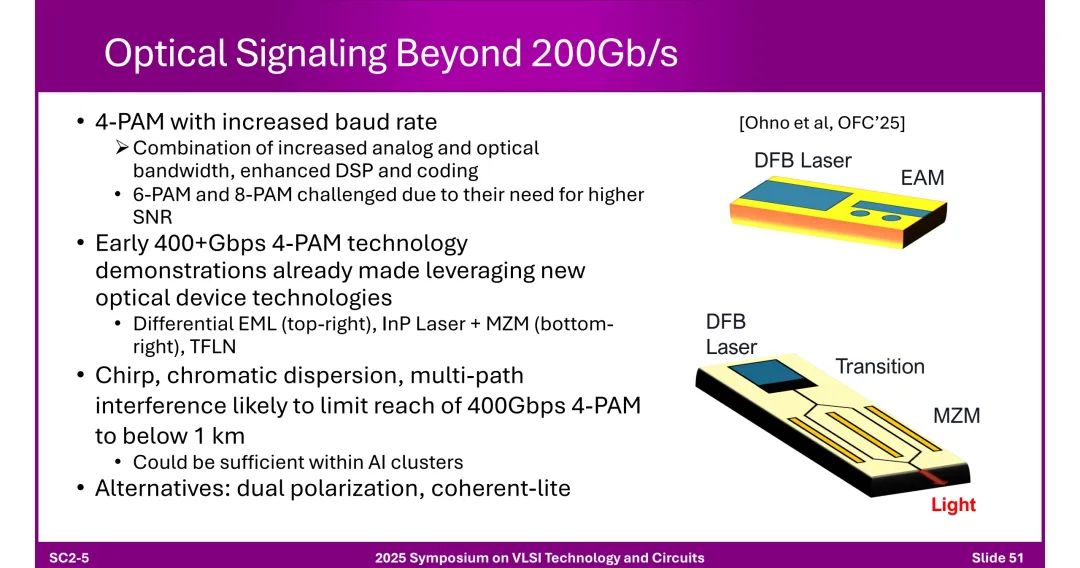

◆ 200Gb/s以上技术:PAM4通过提升波特率、优化DSP实现,已有400+Gbps演示(采用差分EML、InP激光器+MZM等),但受色散限制,传输距离<1km(满足AI集群内需求)。 ◆ 潜在替代方案:双偏振、简化相干传输技术。

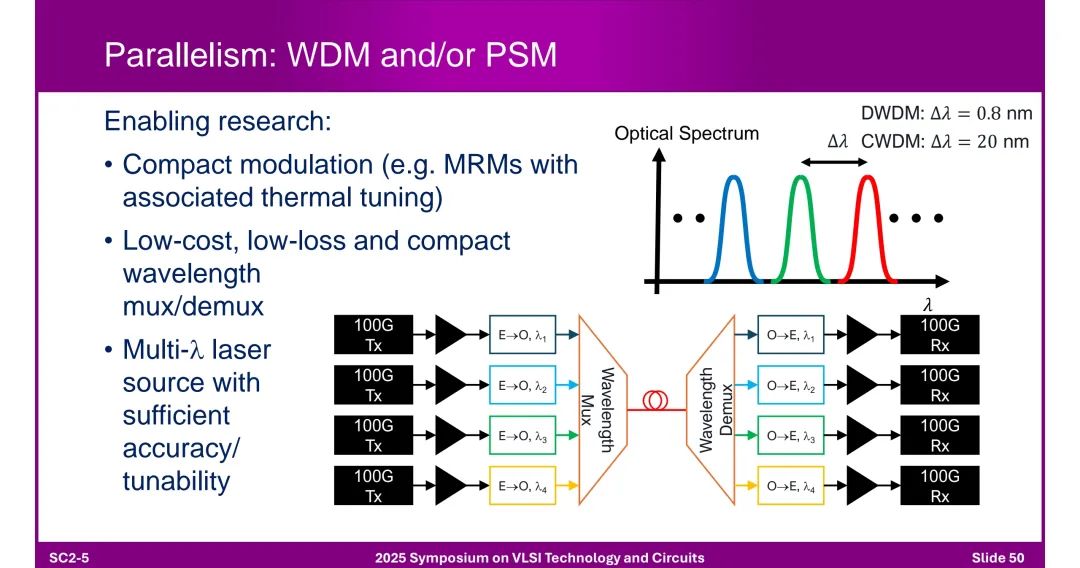

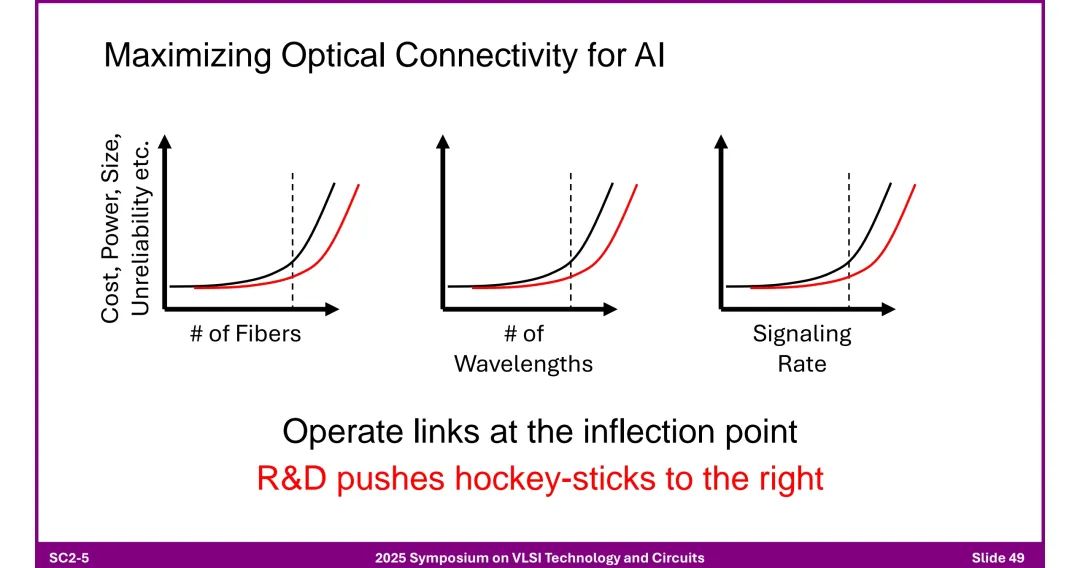

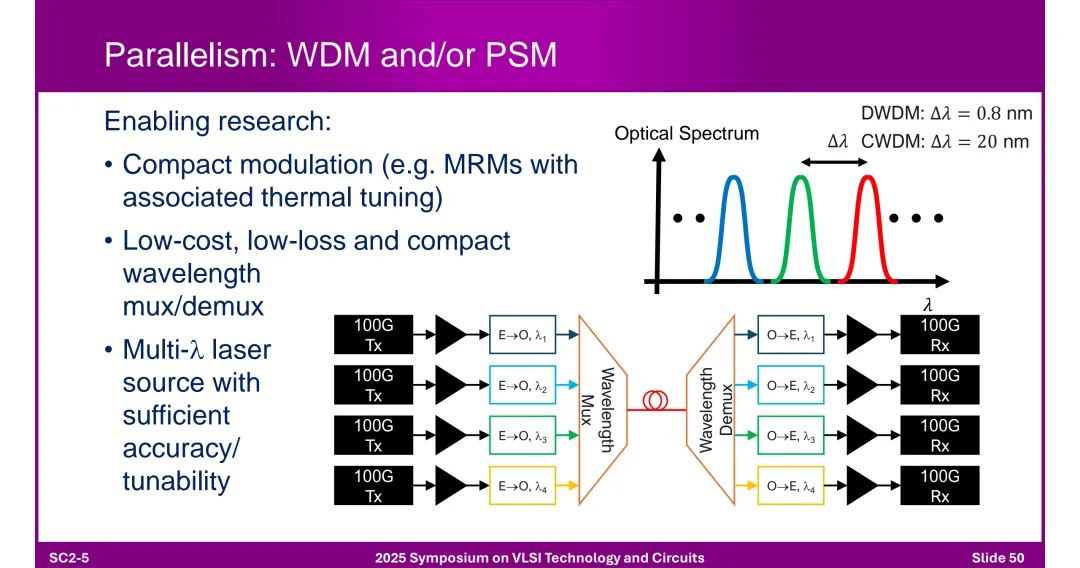

◆ 并行技术:WDM(波分复用,DWDM Δλ=0.8nm,CWDM Δλ=20nm)和PSM(并行单模)提升带宽,需低损耗波长复用器、可调谐多波长激光器支持。

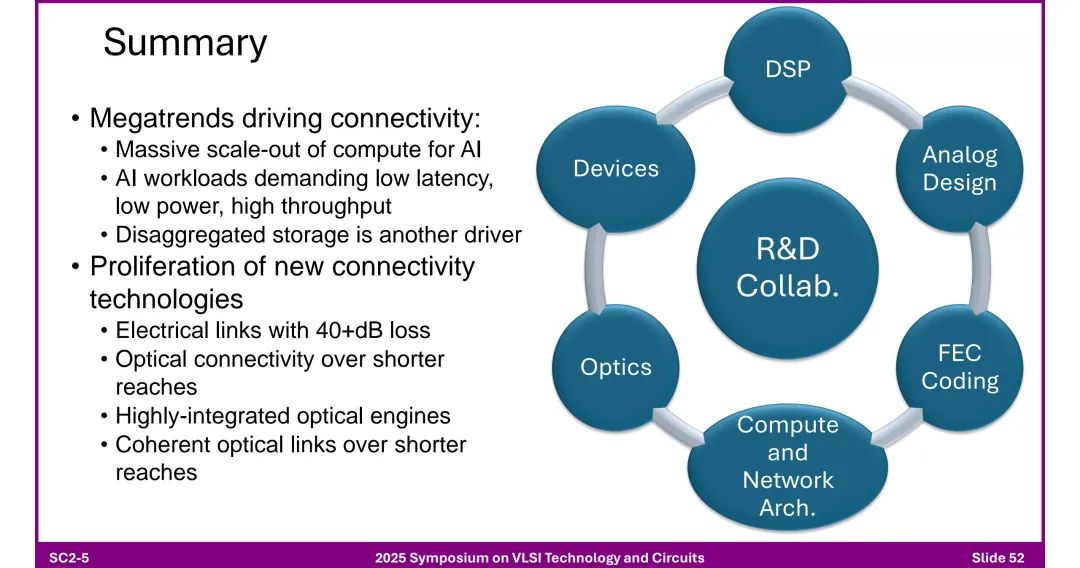

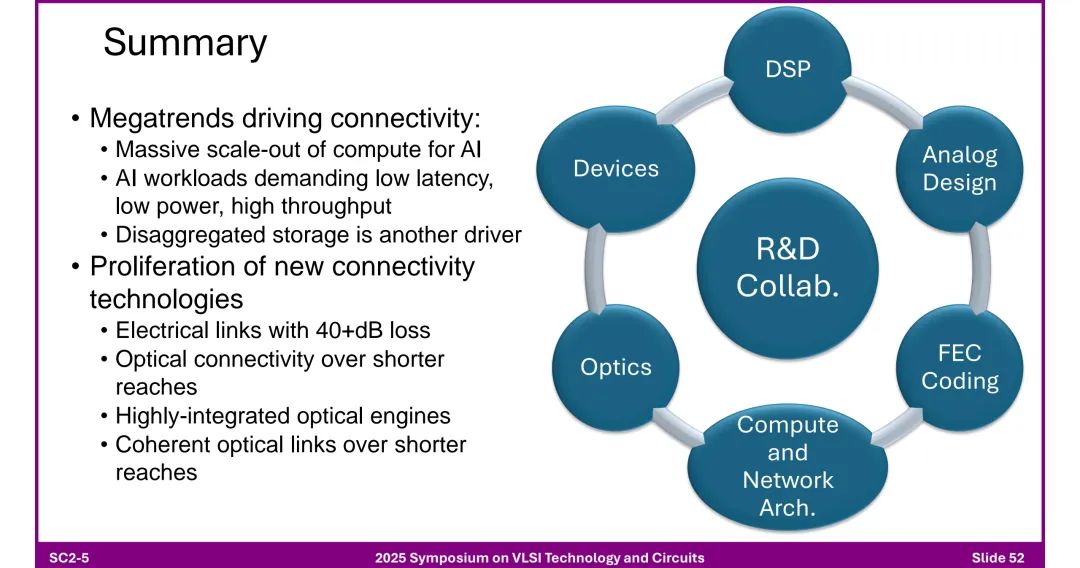

十、总结与未来方向

1. 核心驱动因素 - AI计算大规模扩展、低延迟/低功耗/高吞吐量需求、分布式存储普及。 2. 关键技术趋势 - 电气链路:支持40+dB损耗,依赖先进均衡与调制技术。 - 光学链路:向短距离渗透,集成光引擎与芯粒,相干技术下沉。 - 架构创新:芯粒异构集成、3D堆叠、CPO成为主流。 3. 研发协作需求 - 需跨领域协同(DSP、模拟设计、光学、封装、编码、网络架构等),推动技术突破以匹配AI算力增长速度。

完整slides如下:

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-07-29,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读