Broadcom报告:以太网重构 AI 分布式计算架构

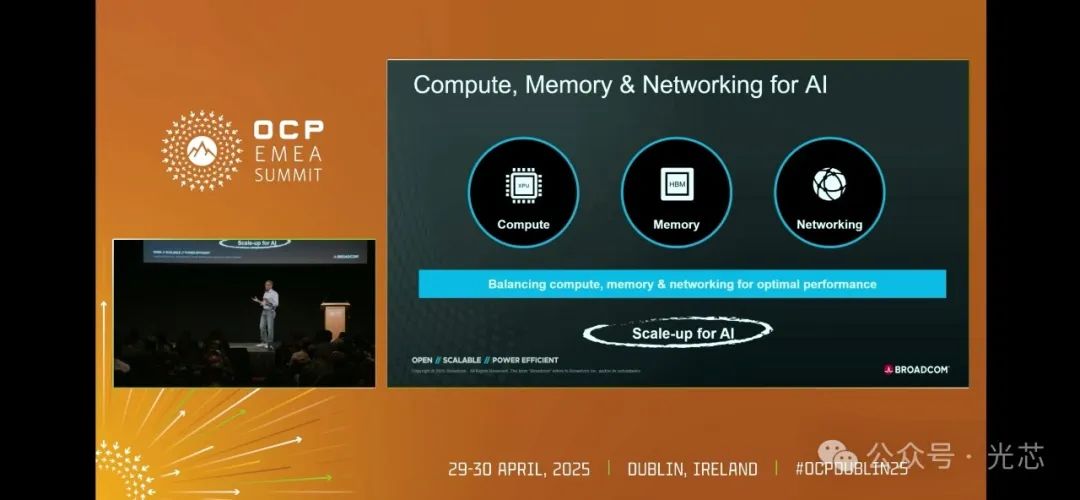

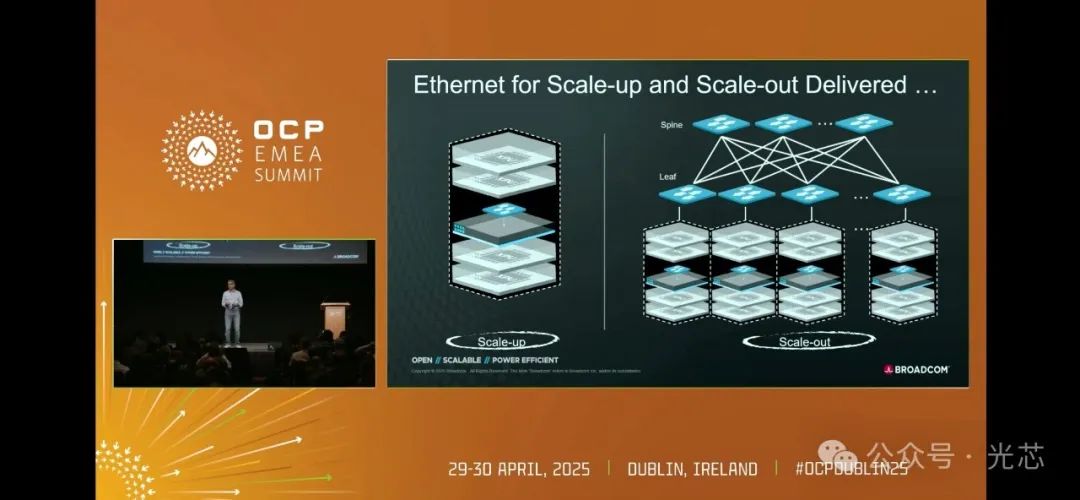

在2025 OCP EMEA Summit上,Broadcom高级副总裁兼核心交换事业部总经理Ram Velaga发表了题为Balancing Compute, Memory and Networking for AI的主题演讲,深入阐释了以太网在构建超大规模 AI 系统中的核心作用。随着 AI 计算需求呈指数级增长(未来数年部署的算力规模较过去提升一个数量级,功耗达数十亿千瓦),分布式计算架构的资源平衡问题 —— 计算、内存与网络的协同效率 —— 成为技术突破的关键。以太网凭借其天生的可扩展性、弹性与开放性,正从 “跨机架扩展”(Scale Out)向 “机架内扩展”(Scale Up)领域全面渗透,重塑 AI 基础设施的技术路径。

一、AI 分布式计算的本质:资源平衡与互联挑战

AI 与机器学习本质上是分布式计算系统,单 GPU 已无法承载大规模训练任务,需通过互联技术将数千至数十万计算单元(XPU/GPU)虚拟为统一算力集群。这一过程中,计算 - 内存 - 网络资源的平衡决定系统效率:

- 内存墙困境当计算资源过剩而本地内存不足时,需远程调用其他节点内存,此时网络带宽成为瓶颈;

- 网络墙困境即使存在可用内存孤岛,若计算单元无法高效访问(如链路延迟、拥塞或可靠性问题),系统性能将大幅下降。

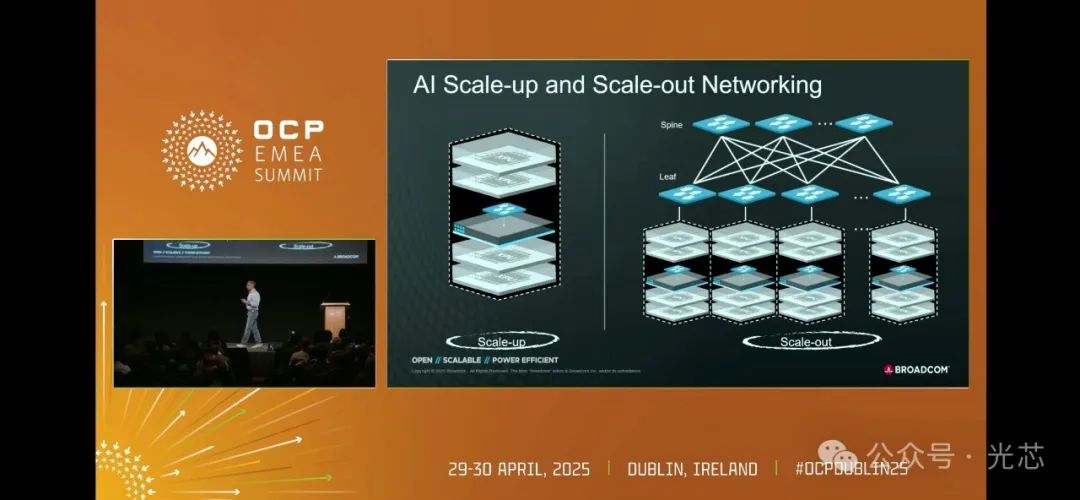

分布式系统的互联场景分为两类:

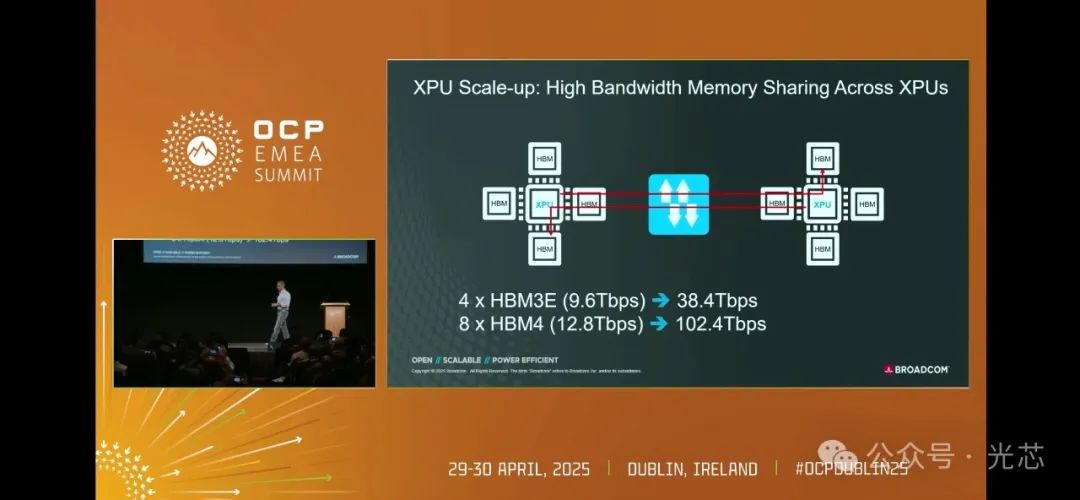

- Scale Up(机架内扩展)连接数十个计算单元(如 30-60 个 XPU),形成高密度计算节点,典型带宽需求从当前 40TB/s(4 个 HBM2)向未来 100TB/s(8 个 HBM4)演进;

- Scale Out(跨机架 / 数据中心扩展)连接数千至数十万个计算单元,覆盖数据中心内及跨地域部署,需解决大规模组网的可扩展性与成本问题。

二、以太网:从 Scale Out 到 Scale Up 的技术突围

过去,在讨论 “Scale Out” 时,很多人认为只能采用 Infiniband 技术。他们觉得如果不使用 Infiniband,系统性能就难以保证。但现实情况是,如今全球规模最大的十多个相关部署中,在 “Scale Out” 方面全部选择了以太网。这是因为以太网具备可扩展性、高弹性和开放性等显著优势。同样,在 “Scale Up” 方面,虽然目前有人认为应该使用 NVLink,尤其是那些销售大部分 GPU 的公司,他们的产品基本都支持 NVLink,所以坚持 “Scale Up” 必须使用 NVLink。然而,就像 Infiniband 逐渐被取代一样,未来以太网凭借自身优势,也能够并且将会在 “Scale Up” 中取代 NVLink。

以单个 XPU 的内存带宽需求为例,就能清晰地看到 “Scale Up” 对网络带宽的巨大需求。如今,每个 XPU 通常配备 4 个 HBM(高带宽内存),每个 HBM 与 XPU 连接的带宽大约为每秒 9.6TB,那么 4 个 HBM 的总带宽约为 40TB(此处为取整计算)。而下一代 XPU 将配备 HBM4,并且可能拥有多达 8 个 HBM,这样一来,每个 XPU 连接的内存总带宽将达到约 100TB。在一个包含两个 XPU 的系统中,如果 XPU A 的计算任务需要访问 XPU B 的内存,那么在未来就需要 100TB 的带宽,在当下也需要 40TB 的带宽来实现连接。如今,每年销售的 GPU/XPU 数量超过 500 万,即便只有 25%(实际上这个比例远不止如此)的设备采用 “Scale Up” 连接方式,考虑到每个 XPU 的带宽现在已经很高且未来还会不断增加,这就意味着需要大量的网络资源来满足如此高的带宽需求。

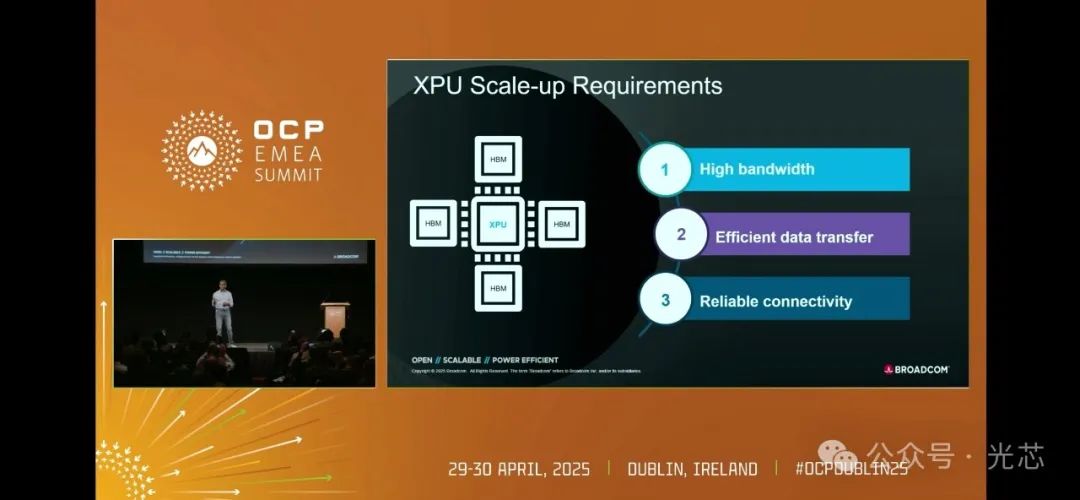

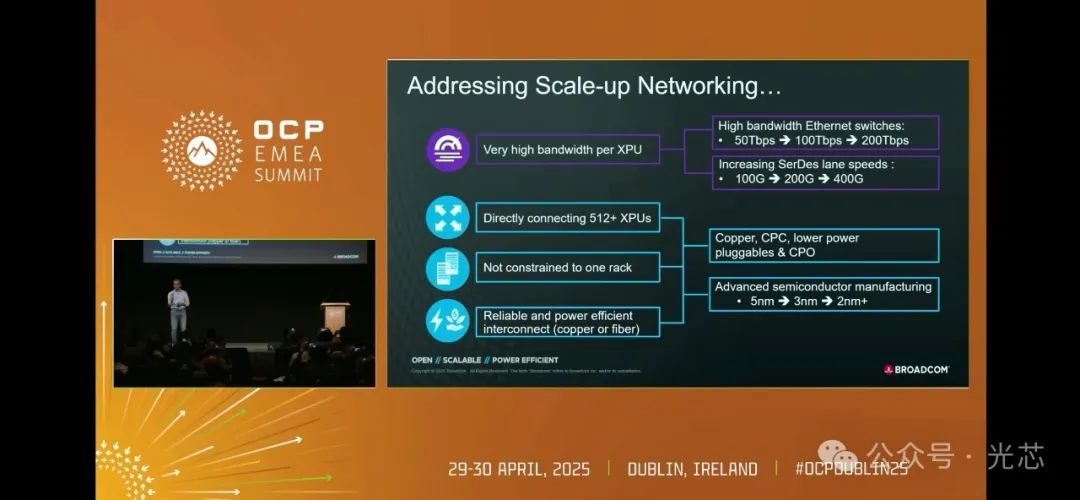

在解决 XPU 之间的互联问题时,有几个关键要点。首先是带宽,目前 50TB 的以太网交换机已经成为过去式,两三年前 50TB 的以太网交换机开始投入市场,很快 100TB 的以太网交换机也将问世,之后还会有几百 TB 的以太网交换机出现,并且以太网的速度在不断提升,链路速度从 50Gbps 提升到 100Gbps,再到 200Gbps。其次是高效的数据传输,当一个 XPU 访问另一个 XPU 上的内存时,每次传输数据块(如 64 字节),都不希望有过高的网络开销,这就要求数据传输必须高效。最后是数据传输的可靠性,当内存直接连接到 XPU 时,通常不容易出现内存访问故障,但当远程访问内存时,由于链路不理想等原因,可能会出现连接故障,所以必须确保连接的可靠性。

为了实现上述目标,还需要解决一系列相关问题。例如,在连接设备时,理想情况下会选择铜缆,因为铜缆成本最低且可靠性最高,但铜缆的传输距离有限。为了连接大量的 XPU,就需要突破铜缆的限制,借助一些光学新技术,如共封装光学、线性光学等,来解决相关问题。此外,无论是 XPU 还是以太网交换机,都在采用更为先进的制程工艺,从 5nm发展到 3nm,再到 2nm,以此来降低功耗,更好地满足实际需求。

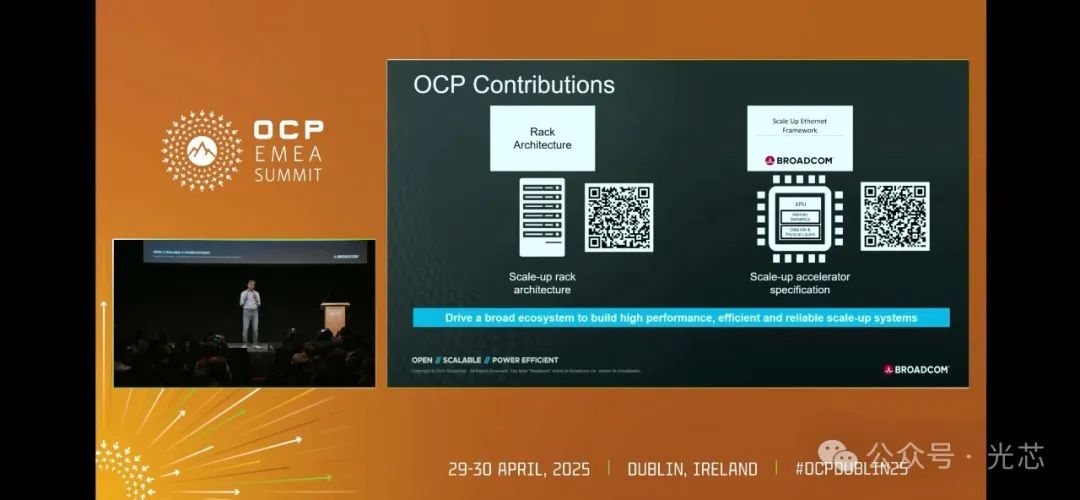

三、Broadcom的生态布局:标准化推动产业协同

Broadcom坚信未来这一领域将涉及价值数十亿美元的网络基础设施部署,需要整个生态系统共同努力。为此,Broadcom发布了两组规范,一组是关于机架级别的规范,另一组是针对 “Scale Up” 技术的规范。这些规范将提供给开放计算项目(OCP)社区,以便业内在此基础上开发产品,并且在未来进行创新和改进。

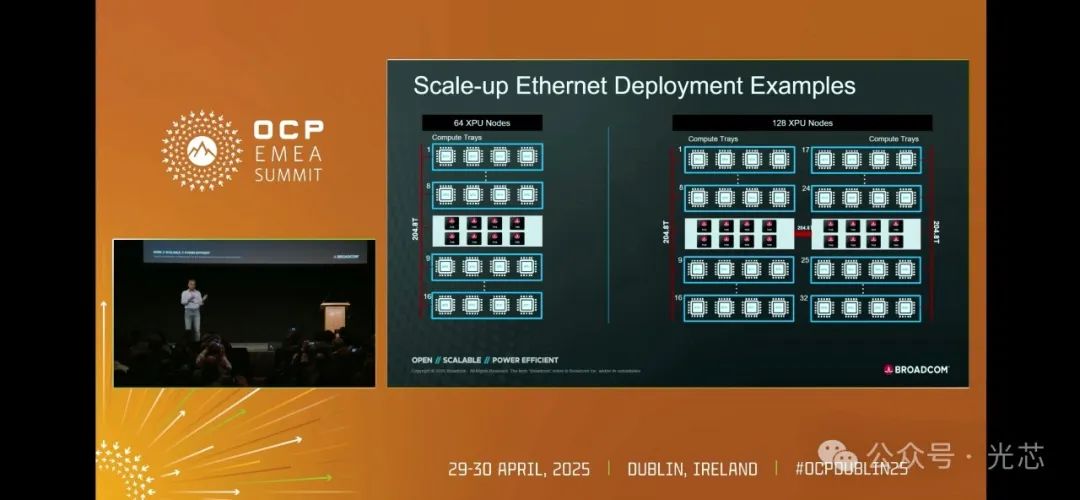

博通预计未来 3 - 6 个月会有大量相关成果和产品问世,这将使基于以太网的 “Scale Up” 在几个季度内就能够投入实际部署。从现在起两年后,有望看到单个机架或者多个机架组合,能够在 “Scale Up” 模式下连接 512 个以上的 XPU。

以太网在构建大规模 AI 系统中扮演着不可或缺的角色。在 “Scale Out” 和 “Scale Up” 方面,以太网都展现出了强大的优势和潜力。随着技术的不断发展和完善,以太网将为 AI 系统的构建提供更加坚实可靠的网络基础,推动 AI 技术迈向新的高度。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-05-07,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录