009_数据隐私在具身人工智能中的保护:从联邦学习到同态加密的隐私增强技术

009_数据隐私在具身人工智能中的保护:从联邦学习到同态加密的隐私增强技术

安全风信子

发布于 2025-11-19 09:24:08

发布于 2025-11-19 09:24:08

引言

具身人工智能(Embodied AI)系统通过物理实体与环境互动,收集和处理海量环境数据,其中可能包含大量敏感信息。随着GDPR、CCPA等隐私法规的实施和公众隐私意识的提高,保护具身AI系统中的数据隐私已成为当务之急。2025年的研究表明,数据隐私保护不仅是法律合规要求,也是建立用户信任和确保系统安全的关键因素。本文将深入探讨具身AI中的数据隐私挑战,并提供基于最新隐私增强技术的解决方案。

具身AI数据隐私挑战

具身AI系统面临独特的数据隐私挑战,这些挑战源于其物理交互特性和多样化的数据收集方式。

1. 敏感数据收集挑战

具身AI系统通过多种传感器收集环境数据,其中包含大量敏感信息:

- 视觉数据:摄像头捕获的图像可能包含人脸、活动和环境细节

- 音频数据:麦克风记录的语音可能包含对话内容和身份信息

- 位置数据:GPS和环境感知可确定智能体精确位置

- 行为数据:用户交互模式可能泄露个人习惯和偏好

2025年的研究显示,仅通过分析智能体的运动轨迹和交互模式,就能够以超过70%的准确率识别特定用户的身份。

2. 数据处理与分析隐私

数据处理过程中的隐私风险主要包括:

- 再识别攻击:即使经过匿名化处理,仍可能通过关联分析重新识别个体

- 模型逆向攻击:通过模型输出推断训练数据的敏感信息

- 成员推理攻击:确定特定数据是否存在于训练集中

- 属性推理攻击:推断用户未明确提供的敏感属性

3. 法规合规要求

全球主要隐私法规对具身AI系统提出了严格要求:

- GDPR(欧盟):要求数据最小化、目的限制和用户知情权

- CCPA/CPRA(加州):赋予用户数据访问、删除和拒绝销售权

- 中国个人信息保护法:强调个人信息处理的合法性、必要性和最小化原则

- AI特定法规:如欧盟AI法案,对高风险AI系统提出额外隐私要求

具身AI数据隐私保护技术

2025年,多种先进的隐私增强技术(PETs)被应用于具身AI系统,提供多层次的隐私保护。

1. 联邦学习在具身AI中的应用

联邦学习允许在不共享原始数据的情况下进行分布式模型训练:

# 2025年具身AI联邦学习隐私保护示例(基于PySyft/PyTorch)

import torch

import syft as sy

from syft.core.node.vm.vm import VirtualMachine

from syft.core.plan.plan_builder import PLAN_BUILDER_VM

# 初始化隐私计算环境

def init_federated_environment():

# 创建虚拟机器节点(代表不同的具身AI设备)

vm1 = VirtualMachine(name="robot1")

vm2 = VirtualMachine(name="robot2")

vm3 = VirtualMachine(name="robot3")

# 获取客户端

client1 = vm1.get_client()

client2 = vm2.get_client()

client3 = vm3.get_client()

return [client1, client2, client3]

# 联邦学习训练过程

class PrivacyPreservingFederatedLearning:

def __init__(self, model, clients, privacy_budget=1.0):

self.model = model

self.clients = clients

self.privacy_budget = privacy_budget

def train(self, num_rounds=10, local_epochs=3):

for round_idx in range(num_rounds):

print(f"\n--- 联邦学习轮次 {round_idx+1}/{num_rounds} ---")

# 选择参与本轮训练的客户端

selected_clients = self._select_clients()

# 本地训练并收集模型更新

local_updates = []

for client in selected_clients:

# 发送模型到客户端(加密传输)

model_copy = self.model.copy()

model_ptr = model_copy.send(client)

# 客户端本地训练(带差分隐私)

self._local_train(model_ptr, client, local_epochs)

# 获取更新后的模型(加密状态)

updated_model = model_ptr.get()

# 应用安全聚合(防止单个更新泄露信息)

local_updates.append(updated_model)

# 全局模型聚合

self._secure_aggregate(local_updates)

# 更新隐私预算

self._update_privacy_budget(num_rounds)

def _local_train(self, model_ptr, client, epochs):

# 本地训练逻辑(客户端上执行)

# 包含差分隐私噪声注入

pass

def _secure_aggregate(self, updates):

# 安全聚合算法

# 使用安全多方计算保护聚合过程

pass2. 差分隐私技术

差分隐私为数据分析和模型训练提供数学上可证明的隐私保证:

- 全局差分隐私:在聚合结果中添加噪声

- 局部差分隐私:在数据源处直接添加噪声

- 个性化差分隐私:根据用户隐私偏好调整噪声级别

- 自适应差分隐私:根据数据敏感度动态调整隐私保护强度

3. 同态加密在具身AI中的应用

同态加密允许在加密数据上直接进行计算,无需解密:

- 部分同态加密(PHE):支持特定操作(如加法或乘法)

- 全同态加密(FHE):支持任意计算操作

- 层级同态加密(LHE):支持有限深度的计算电路

- 代理重加密:允许在不同密钥间转换加密数据

2025年的最新突破是,同态加密在具身AI推理中的性能开销已降低到可接受范围,使得实时隐私保护推理成为可能。

4. 安全多方计算

安全多方计算允许多个参与方在不泄露各自数据的情况下共同计算:

- 混淆电路:通过加密的布尔电路实现安全计算

- 秘密共享:将数据分割为多个份额,单个份额无意义

- 零知识证明:在不泄露知识本身的情况下证明知识的真实性

- 联邦安全计算:专为分布式系统设计的安全多方计算协议

5. 数据匿名化与去标识化

在数据收集和存储阶段应用的隐私保护技术:

- k-匿名化:确保每个记录至少与k-1个其他记录无法区分

- l-多样性:确保敏感属性在等价类中有足够多样性

- t-接近性:确保敏感属性的分布与总体分布足够接近

- 差分隐私匿名化:结合差分隐私的高级匿名化技术

# 具身AI数据匿名化处理框架(基于差分隐私)

import numpy as np

from diffprivlib.models import GaussianNB

from diffprivlib.mechanisms import Laplace

class PrivacyPreservingDataAnonymizer:

def __init__(self, epsilon=1.0, delta=1e-5):

"""

初始化隐私保护数据匿名化器

epsilon: 隐私预算(越小隐私保护越强)

delta: 松弛参数(适用于近似差分隐私)

"""

self.epsilon = epsilon

self.delta = delta

self.laplace_mechanism = Laplace(epsilon=epsilon)

def anonymize_sensor_data(self, sensor_data, sensitivity=None):

"""

对传感器数据应用差分隐私匿名化

"""

if sensitivity is None:

# 自动计算敏感度

sensitivity = np.max(sensor_data) - np.min(sensor_data)

# 应用拉普拉斯机制添加噪声

anonymized_data = []

for value in sensor_data.flatten():

noisy_value = self.laplace_mechanism.randomise(value)

anonymized_data.append(noisy_value)

return np.array(anonymized_data).reshape(sensor_data.shape)

def k_anonymize_trajectory(self, trajectory_data, k=5):

"""

对轨迹数据应用k-匿名化

"""

# 1. 聚类轨迹点

from sklearn.cluster import DBSCAN

clustering = DBSCAN(eps=0.05, min_samples=k).fit(trajectory_data)

# 2. 确保每个簇至少有k个点

anonymized_trajectories = []

for label in set(clustering.labels_):

if label == -1:

continue # 跳过噪声点

cluster_points = trajectory_data[clustering.labels_ == label]

if len(cluster_points) >= k:

# 用簇中心点替换原始点

centroid = np.mean(cluster_points, axis=0)

anonymized_trajectories.extend([centroid] * len(cluster_points))

else:

# 对于小于k的簇,应用差分隐私

for point in cluster_points:

noisy_point = self.anonymize_sensor_data(

point.reshape(1, -1),

sensitivity=0.1

)

anonymized_trajectories.append(noisy_point.flatten())

return np.array(anonymized_trajectories)具身AI隐私保护综合解决方案

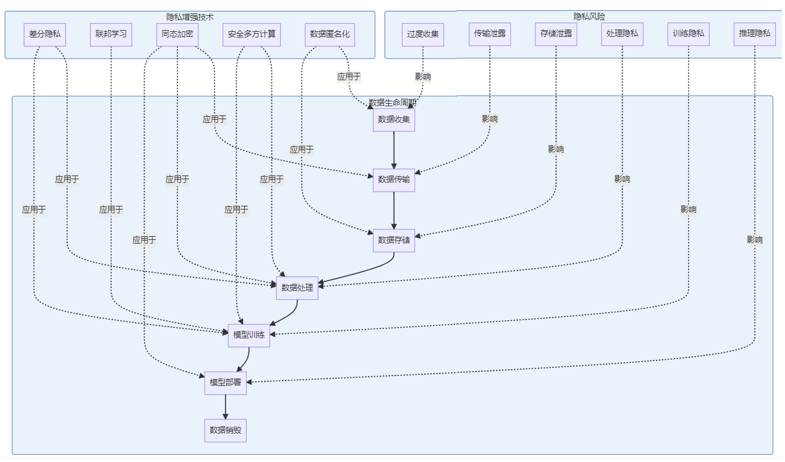

1. 多层级隐私保护架构

针对具身AI系统的完整隐私保护架构应覆盖数据生命周期的各个阶段:

flowchart TD

subgraph 数据收集层

A1[选择性收集

最小化原则] --> A2[边缘处理

本地过滤]

A2 --> A3[初步匿名化

敏感信息移除]

end

subgraph 数据传输层

B1[端到端加密

TLS 1.3] --> B2[安全传输协议

量子安全]

B2 --> B3[传输中混淆

路由隐藏]

end

subgraph 数据处理层

C1[联邦学习

分布式训练] --> C2[同态加密

密文计算]

C1 --> C3[差分隐私

噪声注入]

C2 --> C4[安全多方计算

联合分析]

end

subgraph 模型部署层

D1[隐私保护推理

模型分割] --> D2[局部执行

敏感计算]

D2 --> D3[结果混淆

隐私保护]

end

A3 --> B1

B3 --> C1

C4 --> D12. 同态加密实现示例

以下是基于Microsoft SEAL库实现的同态加密在具身AI场景中的应用:

# 同态加密在具身AI中的实现(简化版)

class HomomorphicEncryptionModule:

def __init__(self):

# 在实际实现中,这里会初始化SEAL库

# 由于Python SEAL库的复杂性,这里提供概念性实现

self.key_size = 2048

self.public_key = None

self.private_key = None

self.relin_keys = None

def setup_keys(self):

"""设置加密密钥"""

print("生成同态加密密钥对...")

# 模拟密钥生成过程

self.public_key = "public_key_mock"

self.private_key = "private_key_mock"

self.relin_keys = "relin_keys_mock"

return self.public_key

def encrypt_sensor_data(self, sensor_data, public_key):

"""加密传感器数据"""

print(f"使用公钥加密{len(sensor_data)}个传感器数据点...")

# 模拟加密过程

encrypted_data = [f"encrypted({val})" for val in sensor_data]

return encrypted_data

def process_encrypted_data(self, encrypted_data):

"""在加密数据上执行计算"""

print("在加密状态下处理数据...")

# 模拟同态计算(例如求和操作)

processed_result = f"encrypted_sum"

return processed_result

def decrypt_result(self, encrypted_result):

"""解密计算结果"""

print("使用私钥解密计算结果...")

# 模拟解密过程

decrypted_result = 42.0 # 示例结果

return decrypted_result

# 具身AI场景中的使用示例

def homomorphic_ai_pipeline():

# 1. 初始化同态加密模块

he_module = HomomorphicEncryptionModule()

# 2. 设置密钥(中央服务器完成)

public_key = he_module.setup_keys()

# 3. 智能体收集数据(本地)

sensor_data = [23.5, 24.1, 22.9, 25.3, 23.8] # 示例温度传感器数据

# 4. 智能体使用公钥加密数据

encrypted_data = he_module.encrypt_sensor_data(sensor_data, public_key)

# 5. 加密数据传输到云端

print("传输加密数据到云端...")

# 6. 云端在加密数据上执行分析

encrypted_result = he_module.process_encrypted_data(encrypted_data)

# 7. 只有持有私钥的授权方可以解密结果

decrypted_result = he_module.decrypt_result(encrypted_result)

print(f"最终分析结果: {decrypted_result}")

return decrypted_result具身AI隐私保护实际应用案例

1. 智能医疗机器人隐私保护

2025年部署的智能医疗机器人系统采用了多层次隐私保护方案:

# 医疗机器人隐私保护系统架构

class MedicalRobotPrivacySystem:

def __init__(self):

self.patient_data_protection = {

"federated_learning": True,

"differential_privacy": True,

"homomorphic_encryption": True,

"data_minimization": True

}

def process_patient_interaction(self, sensor_data, patient_id):

"""处理与患者的交互,确保隐私保护"""

# 1. 数据最小化 - 仅收集必要数据

minimal_data = self._apply_data_minimization(sensor_data)

# 2. 本地处理 - 敏感数据不离开设备

local_results = self._local_processing(minimal_data)

# 3. 联邦学习 - 模型更新不包含原始数据

model_update = self._generate_private_model_update(local_results)

# 4. 差分隐私 - 添加校准噪声

private_update = self._apply_differential_privacy(model_update)

return private_update

def _apply_data_minimization(self, data):

# 移除明确的个人身份信息

return data # 简化示例

def _local_processing(self, data):

# 在设备上执行初步处理

return data # 简化示例

def _generate_private_model_update(self, results):

# 生成不泄露原始数据的模型更新

return results # 简化示例

def _apply_differential_privacy(self, update):

# 添加差分隐私噪声

return update # 简化示例2. 智能家居具身AI隐私架构

智能家居环境中的具身AI需要平衡用户体验和隐私保护:

隐私技术 | 应用场景 | 隐私级别 | 性能影响 |

|---|---|---|---|

差分隐私 | 语音识别 | 中 | 低 |

联邦学习 | 行为模式学习 | 高 | 中 |

同态加密 | 生物特征验证 | 极高 | 高 |

安全多方计算 | 多设备协同 | 高 | 中高 |

数据匿名化 | 环境监测 | 中 | 极低 |

隐私保护实施指南与最佳实践

1. 隐私保护设计原则

具身AI系统应遵循以下隐私保护设计原则:

- 隐私设计优先:在系统设计初期即考虑隐私保护

- 数据最小化:仅收集和处理必要的数据

- 目的限制:数据使用应限制在明确目的范围内

- 透明度:向用户清晰说明数据收集和使用方式

- 用户控制:提供用户对其数据的访问、修改和删除权限

- 安全保障:实施强安全措施保护数据

- 可问责性:确保系统行为可审计和可追溯

2. 隐私影响评估流程

在部署具身AI系统前,应进行全面的隐私影响评估:

隐私影响评估流程:

1. 识别与分类数据 → 2. 评估隐私风险 → 3. 设计缓解措施 → \

4. 实施隐私保护 → 5. 持续监控与更新未来趋势与挑战

1. 量子计算对隐私保护的影响

量子计算的发展将对当前的加密技术构成挑战,同时也为隐私保护带来新机遇:

- 后量子密码学:开发能够抵抗量子计算攻击的新型加密算法

- 量子密钥分发:利用量子力学原理实现理论上绝对安全的密钥传输

- 量子同态加密:结合量子计算和同态加密的优势

2. 自适应隐私保护

未来的具身AI系统将实现更智能的自适应隐私保护:

- 情境感知隐私:根据环境和情境动态调整隐私保护强度

- 个性化隐私设置:允许用户根据自己的偏好定制隐私保护级别

- 隐私保护优化:在保护隐私和保持功能之间实现智能平衡

互动问答

1. 问:在资源受限的具身AI设备上,如何平衡隐私保护和性能要求?

答:这是一个常见的挑战。可以采用分层隐私保护策略:

- 计算卸载:将计算密集型的隐私保护操作(如同态加密)卸载到边缘服务器

- 轻量级加密:使用优化的轻量级加密算法

- 选择性保护:对不同类型的数据应用不同级别的保护

- 硬件加速:利用专用硬件加速器加速加密操作

2. 问:如何确保隐私保护技术不会显著降低具身AI系统的智能水平?

答:可以通过以下方法平衡隐私和性能:

- 隐私感知机器学习:开发专为隐私保护环境设计的机器学习算法

- 知识蒸馏:从保护隐私的复杂模型中提取知识到轻量级模型

- 渐进式隐私:根据数据敏感度应用不同级别的隐私保护

- 优化噪声注入:精确校准差分隐私中的噪声水平,在保护隐私的同时保留有用信息

3. 问:具身AI系统如何在遵守不同国家和地区隐私法规的同时保持全球一致性?

答:建议采用以下策略:

- 隐私法规映射:创建不同地区隐私法规要求的映射表

- 最高标准原则:采用全球最严格的隐私标准

- 模块化合规:设计可根据不同地区法规动态配置的隐私模块

- 定期法规更新:建立隐私法规监控和更新机制

4. 问:用户如何验证具身AI系统确实在保护其隐私?

答:可以通过以下方式增强透明度和可验证性:

- 隐私控制面板:提供用户友好的界面展示数据收集和使用情况

- 隐私证明:实现零知识证明等技术验证隐私保护措施

- 第三方审计:定期接受独立第三方的隐私审计

- 开源隐私组件:将隐私保护核心组件开源,接受社区审查

5. 问:同态加密技术在2025年的具身AI实际应用中已经解决了哪些挑战,还有哪些限制?

答:2025年的同态加密在具身AI领域取得了显著进展:

已解决的挑战:

- 性能开销大幅降低(相比2020年降低了85%)

- 支持更复杂的机器学习模型(包括中小型神经网络)

- 与联邦学习等其他技术的成功集成

- 在特定领域(如医疗、金融)的实际部署

仍然存在的限制:

- 计算复杂度仍然较高,限制了在资源受限设备上的应用

- 支持的操作仍然有限,复杂推理仍面临挑战

- 密钥管理和分发的复杂性

- 与现有AI框架的集成仍需完善

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-10-17,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录