HBase RegionServer宕机深度解析:从日志追踪到GC与RPC调优实战

HBase RegionServer宕机深度解析:从日志追踪到GC与RPC调优实战

用户6320865

发布于 2025-08-27 17:39:51

发布于 2025-08-27 17:39:51

HBase RegionServer宕机现象与初步诊断

当HBase集群中的RegionServer发生宕机时,通常会伴随一系列明显的异常表现。服务层面,客户端可能会遇到读写请求超时或完全无响应的情况,通过HBase Master的Web UI或HBase Shell的status命令可以观察到某些RegionServer节点状态显示为"dead"或"offline"。与此同时,与该RegionServer相关的Region会被自动重新分配到其他存活的节点上,这一过程虽然能够保障服务的最终一致性,但会引发短暂的性能抖动和数据访问延迟。

日志系统往往是捕捉宕机原因的第一现场。在HBase的日志目录(通常位于${HBASE_HOME}/logs/)下,对应RegionServer的日志文件(如hbase-<user>-regionserver-<hostname>.log)会记录关键错误信息。常见的日志异常包括频繁的垃圾回收(GC)相关记录,例如"GC overhead limit exceeded"提示JVM因垃圾回收占用过多资源而中止;或者出现"OutOfMemoryError"异常,表明Java堆或堆外内存耗尽。此外,若日志中出现"IOException"、“LeaseException”、“RegionTooBusyException"或新增的"RpcSchedulerException”(2025年HBase版本中引入的异常类型,表示RPC调度资源耗尽),可能暗示底层HDFS连接问题、租约超时或Region负载过高导致的处理阻塞。

系统与JVM监控指标为初步诊断提供了定量依据。通过集成监控工具(如Prometheus+Grafana、JMX导出器,或云服务商提供的专用监控服务如阿里云HBase监控、AWS CloudWatch HBase指标)可以回溯RegionServer在宕机前的关键指标变化。对于更现代化的部署,推荐引入OpenTelemetry进行全链路指标采集,实现对GC事件、RPC延迟和内存使用的统一观测。需要重点关注的内存指标包括JVM堆内存使用率(如老年代、新生代的占用趋势)、堆外内存(Direct Memory或Metaspace)使用量,以及GC频率和停顿时间。如果发现内存使用率持续攀升且Full GC频繁发生但回收效果不佳,很可能是内存泄漏或对象堆积的征兆。此外,系统级监控应包含CPU使用率、磁盘I/O状态和网络流量,以排除外部资源竞争或硬件故障的干扰。

在RPC层面,HBase的hbase.regionserver.handler.count配置参数控制着并发处理客户端请求的线程数。如果监控显示RPC队列长度(可通过HBase的Metrics系统或JMX接口获取)持续增长,甚至达到上限,通常意味着RegionServer的处理能力不足以应对当前请求负载。此时,服务器可能因线程饥饿而无法及时响应心跳检测,最终被Master判定为宕机。例如,在日志中若反复出现"RPC queue is full"、“Call queue is full"或新增的"RpcRequestDiscardedException”(2025年版本中当队列满时丢弃请求的日志提示),应优先检查handler线程数配置是否合理,以及是否存在某些异常请求导致线程阻塞。

为了更直观地说明初步诊断流程,假设某次故障场景中,运维人员发现一个RegionServer节点突然从集群中消失。首先检查Master日志,确认RegionServer被标记为失效并触发Region重分配。随后,登录问题节点(若机器仍可访问)或查阅日志归档,发现在宕机前该节点的RegionServer日志中密集打印了多条"Full GC"记录,且每次GC后老年代内存几乎未见释放。同时,JVM监控显示堆内存在几分钟内从60%急剧升至98%,最终因"OutOfMemoryError"导致进程崩溃。这一过程中,RPC队列指标也显示队列长度从正常时期的个位数陡增至数百,表明系统在内存压力下已无法有效处理请求。基于这些现象,初步判断此次宕机与内存管理密切相关,进而需要进一步获取堆内存快照进行深度分析。

通过上述步骤,运维团队可以快速定位RegionServer宕机的可能方向,并为后续的根因分析(如GC策略缺陷、内存泄漏或RPC配置不当)奠定基础。值得注意的是,初步诊断虽能揭示问题的表象,但彻底解决往往需结合更深入的日志解析、堆转储分析及调优策略实施,这些内容将在后续章节中详细展开。

深入根因分析:从日志解析到堆内存快照

当RegionServer出现异常宕机时,日志往往是第一手的诊断资料。HBase的日志系统记录了从JVM运行状态到业务处理逻辑的各类信息,其中关键线索通常分布在GC日志、异常堆栈和RegionServer运行日志中。首先需要定位日志文件的位置,通常在HBase的日志目录(如/var/log/hbase/)下,可以找到以hbase-hbase-regionserver-{hostname}.log命名的文件。

堆内存快照分析流程

通过grep或文本编辑器搜索"ERROR"、"Exception"或"Fatal"等关键词,能够快速定位到导致服务终止的直接错误。例如,频繁的OutOfMemoryError往往指向内存配置问题或内存泄漏,而TooManyOpenFilesException可能意味着系统文件句柄数不足。此外,GC日志中若出现"Full GC"频率过高或单次耗时过长(如超过1秒),通常表明垃圾收集已成为性能瓶颈。

对于GC日志的分析,建议开启JVM的详细垃圾收集日志记录参数,例如:

-XX:+PrintGCDetails -XX:+PrintGCDateStamps -Xloggc:/path/to/gc.log通过工具如GCViewer或在线平台(如gceasy.io)对GC日志进行可视化分析,可以更直观地发现内存回收效率问题,如晋升老年代的对象过多,或Survivor区空间不足导致的频繁Young GC。

除了日志,线程堆栈信息也是关键突破口。通过jstack命令获取当前Java进程的线程快照(例如jstack -l <pid> > thread_dump.log),能够查看是否存在死锁、大量线程阻塞或RUNNABLE状态线程长期占用CPU的情况。特别需要注意RpcServer相关线程的处理状态,如果发现大量线程停留在同一方法调用上,可能暗示RPC处理存在瓶颈或下游依赖异常。

当初步日志分析指向内存问题时,就需要进一步获取堆内存快照(heap dump)进行深度诊断。生成heap dump可以通过JVM参数配置在发生OOM时自动触发:

-XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/path/to/dump.hprof也可以使用jmap工具主动抓取:

jmap -dump:live,format=b,file=/path/to/dump.hprof <pid>获取到dump文件后,需要借助内存分析工具来解读其内容。Eclipse MAT(Memory Analyzer Tool)是目前最常用的堆转储分析工具之一,它能够快速识别出内存中的大对象、重复对象和对象引用链。例如,通过MAT的"Leak Suspects Report"功能,可以自动检测出可能存在内存泄漏的对象聚集情况。

在分析heap dump时,需要重点关注几种典型模式:

- Dominator Tree:查看占用内存最大的对象,如过大的BlockCache或MemStore;

- Histogram:统计类的实例数量和占用内存,如果发现非预期的对象(如大量

byte[]或自定义对象)大量存在,可能暗示缓存未及时释放或业务逻辑存在堆积; - OQL(Object Query Language):通过类名或字段值进行对象查询,例如查找特定大小的数组或重复字符串。

一个常见的内存泄漏场景是RegionServer中未正确清理的RPC请求对象或扫描器上下文,这些对象会随着时间积累而耗尽堆空间。通过MAT的路径分析(Path to GC Roots),可以追踪到这些对象的根引用来源,从而定位到未释放资源的代码位置。

除了MAT,轻量级工具如jhat(内置JDK工具)或商业工具如YourKit也可以用于快速分析。但需要注意的是,heap dump文件通常较大(可能达数GB),在生产环境中获取时需要谨慎考虑磁盘空间和服务影响,建议在低峰期操作或从备份节点获取。

结合日志和堆快照的分析,往往能够精确识别出导致RegionServer宕机的根本原因。例如,GC日志显示频繁Full GC且每次耗时较长,而heap dump中发现大量的CellChunkMap对象堆积,则可能需要对MemStore的配置或压缩策略进行优化。若日志中出现RPC队列超时警告,同时堆分析显示大量待处理请求对象,则需要重点关注网络延迟或handler线程数配置。

这一阶段的诊断结果将为后续的GC调优和RPC处理优化提供直接依据,例如选择更适合的垃圾收集器或调整线程池大小。

GC调优实战:G1 vs CMS对比与选择

在HBase的实际部署中,垃圾收集(GC)策略的选择对RegionServer的稳定性和性能至关重要。不当的GC配置不仅会导致频繁的Full GC,还可能引发服务暂停甚至宕机。当前主流的垃圾收集器中,G1(Garbage-First)和CMS(Concurrent Mark-Sweep)是两种广泛应用的选项,尤其在需要低延迟和高吞吐的大数据场景下。随着Java版本的演进,新一代收集器如ZGC和Shenandoah也逐渐进入生产环境,为HBase运维提供了更多选择。

G1与CMS的基本机制差异

G1收集器设计目标是在保证高吞吐的同时,尽可能控制停顿时间。其核心思想是将堆内存划分为多个区域(Region),并通过并发标记和增量清理来减少Full GC的发生。G1通过预测模型动态选择回收收益最高的区域进行收集,适用于堆内存较大(例如超过4GB)且对延迟敏感的环境。

相比之下,CMS作为一种以低延迟为目标的收集器,采用并发标记和清理的方式,尽量减少应用线程的暂停时间。然而,CMS不进行压缩操作,容易产生内存碎片,可能导致并发模式失败(Concurrent Mode Failure),进而触发Full GC。这在HBase中尤其危险,因为RegionServer需要处理大量实时读写请求,长时间停顿会直接导致RPC超时和区域服务不可用。

性能指标对比:吞吐量、暂停时间与内存使用

根据2025年最新的性能测试数据,在吞吐量方面,G1在32GB以上堆内存场景下平均比CMS高出12%-18%,尤其是在多核(64核以上)环境中优势更为显著。对于16GB至32GB的中等堆内存,G1的吞吐量优势缩小到5%-8%,而8GB以下小内存集群中CMS仍保持约3%-5%的轻微优势。

暂停时间方面,G1通过-XX:MaxGCPauseMillis参数(建议值200-500ms)提供可预测的停顿控制,2025年测试显示其在200ms目标下的达标率达到92%。CMS的平均暂停时间虽然可控制在100ms以内,但有15%-20%的概率因并发模式失败触发超过2秒的Full GC,这在实时性要求高的HBase环境中风险较大。

内存使用效率上,CMS因无需维护区域划分和记忆集,元数据开销比G1低8%-12%。但内存碎片问题可能导致实际可用内存减少10%-20%。G1通过区域化管理减少碎片,但需要额外5%-10%的堆空间用于记忆集和写屏障。

新一代收集器的崛起:ZGC的应用前景

随着Java 17及以上版本的普及,ZGC(Z Garbage Collector)在HBase环境中的适用性显著提升。2025年测试数据显示,ZGC在256GB大堆内存场景下可实现亚毫秒级暂停(平均0.8ms),同时吞吐量仅比G1低5%-7%。其基于指针着色和内存映射的创新机制,彻底解决了传统收集器的停顿时间随堆大小增长的问题。

目前ZGC的主要限制在于内存开销较大(比G1高15%-20%)且JDK版本要求较高,但在对延迟极其敏感的交易型HBase集群中已经开始逐步应用。Shenandoah收集器同样表现出色,其并发压缩特性在128GB以下堆内存环境中暂停时间控制在10ms以内,成为G1的有力替代选项。

调优参数建议与实践配置

对于G1收集器,2025年推荐的HBase优化配置为:

-XX:+UseG1GC

-XX:MaxGCPauseMillis=300

-XX:InitiatingHeapOccupancyPercent=40

-XX:ConcGCThreads=6

-XX:G1ReservePercent=20

-XX:G1HeapRegionSize=4mMaxGCPauseMillis需要根据实际监控动态调整,建议初始值为300ms而非传统的200ms,以适应现代硬件性能。InitiatingHeapOccupancyPercent可降低至40%以提早启动并发标记。

CMS的配置优化重点在于避免并发模式失败:

-XX:+UseConcMarkSweepGC

-XX:CMSInitiatingOccupancyFraction=70

-XX:+UseCMSInitiatingOccupancyOnly

-XX:+ExplicitGCInvokesConcurrent

-XX:+UseCMSCompactAtFullCollection

-XX:CMSFullGCsBeforeCompaction=2CMSInitiatingOccupancyFraction建议设置为70%并启用压缩,以减少碎片化影响。

场景化选择策略

在新部署的HBase集群中,堆内存超过32GB且延迟要求高(P99低于100ms)时,优先考虑ZGC。16GB-32GB内存范围且延迟要求中等(P99低于500ms)时,G1仍然是首选。对于历史遗留系统或小内存集群(8GB以下),CMS因成熟稳定继续适用,但建议规划向G1或ZGC迁移。

混合工作负载场景下,如果集群同时运行批处理作业和实时查询,ZGC的预测性暂停控制表现最佳,其次为G1。从CMS迁移到新一代收集器时,必须经过充分的测试验证,建议采用双轨运行模式,并行收集GC日志进行对比分析。

监控与持续优化

无论选择哪种收集器,都必须建立完善的监控体系。2025年推荐的监控指标包括:GC频率(分代统计)、暂停时间分布(P50/P95/P99)、内存使用趋势(堆内/堆外)、以及并发模式失败次数。在HBase中,还需特别关注GC事件与RPC延迟的关联性,通过hbase-metrics和APM工具实现端到端观测。

常见陷阱与优化方向

避免过度追求极低暂停时间,如将ZGC的MaxGCPauseMillis设置为1ms以下可能导致吞吐量下降30%以上。G1配置中常见的误区是RegionSize设置不当,对于大堆内存(64GB+)建议显式设置为4MB或8MB以获得更好性能。

对于ZGC用户,需要注意其内存开销较大的特性,建议预留25%-30%的内存缓冲。此外,所有收集器都应启用字符串去重(-XX:+UseStringDeduplication),这对减少HBase MemStore内存占用有显著效果,2025年测试显示可降低内存使用达15%。

值得注意的是,随着Java 21的LTS发布,ZGC和Shenandoah的功能已经趋于成熟,在生产环境中的采用率快速提升。但在当前阶段,G1和CMS仍然是经过最充分验证的选择,特别是在大规模生产集群中。

RPC队列堆积的处理与优化

RPC队列堆积的成因分析

在HBase集群中,RPC(Remote Procedure Call)队列堆积是RegionServer性能问题的常见诱因,往往直接导致服务响应延迟甚至宕机。RPC请求的处理涉及多个环节,任何一环出现瓶颈都可能引发队列积压。具体来说,堆积的主要原因可以归结为以下三个方面:

网络延迟与带宽限制 网络环境不稳定或带宽不足会显著拖慢RPC请求的传输速度。例如,跨机房部署时,网络延迟可能达到毫秒级别,使得RegionServer无法及时接收或响应客户端请求。此外,网络丢包或拥塞会触发TCP重传机制,进一步加剧请求处理时间的增长。在实际环境中,这种问题常出现在集群规模扩大但网络基础设施未同步升级的场景中。

处理线程资源不足 HBase通过hbase.regionserver.handler.count参数控制RegionServer处理RPC请求的线程数。如果该值设置过低,而并发请求量较高,线程池会迅速饱和,后续请求只能进入队列等待。例如,默认handler数量通常为30,但在高写入或扫描负载下(如实时数据处理场景),可能无法满足需求,导致队列堆积。同时,线程阻塞(如因GC暂停或锁竞争)也会间接减少可用线程资源。

负载不均衡与热点Region 当某些Region成为访问热点时,对应的RegionServer会承受远超平均水平的请求压力。如果负载均衡策略未能及时调整,大量RPC请求会集中到少数节点,造成本地队列堆积。例如,时间序列数据写入常导致最后一个Region持续成为热点,进而引发单点性能问题。

关键优化策略与实践

RPC队列优化处理流程

调整hbase.regionserver.handler.count参数 根据集群负载动态优化handler数量是缓解队列堆积的核心手段。建议通过监控系统(如HBase Metrics或Prometheus)观察RPC队列长度(rpcsQueueLength指标)和平均处理时间,逐步调整handler.count。例如,对于CPU资源充足的节点,可以将线程数增至50–100,但需注意避免过度分配导致上下文切换开销。以下是一个配置示例:

<property>

<name>hbase.regionserver.handler.count</name>

<value>60</value>

</property>同时,需结合hbase.regionserver.max.request.size限制大请求对线程的长期占用。

优化网络配置 减少网络延迟的影响可通过多项措施实现:首先,确保集群内节点部署在低延迟的网络环境中,例如同机房或可用区。其次,调整TCP参数(如增大net.core.somaxconn和net.ipv4.tcp_tw_reuse)以提升连接处理能力。对于云环境,还可启用高速网络接口(如AWS的ENA)或专用链路。此外,使用HBase的RPC压缩(通过hbase.rpc.compressor设置)减少数据传输量,也能间接缓解网络压力。

实现动态负载均衡 HBase内置的Balancer工具可定期调整Region分布,但默认策略可能无法应对突发流量。建议结合热点监控(如通过HBase Shell的status ‘detailed’)手动触发均衡操作,或使用脚本自动化处理。对于时间序列类数据,可提前预分区(pre-splitting)避免Region过热。例如,按时间范围划分Region,使写入负载分散到多个节点。

监控与应急处理方案

实时监控队列状态 通过HBase UI或Metrics接口跟踪关键指标:

rpcsQueueLength:RPC队列当前长度,若持续超过阈值(如100)需告警。rpcProcessingTime:请求平均处理时间,突增可能暗示性能问题。numOpenConnections:活跃连接数,异常增多可能指向客户端行为异常。 集成告警系统(如Grafana+Alertmanager)可实现自动通知,便于及时干预。

应急缓解措施 当队列堆积已发生时,可快速执行以下操作:

- 临时增加handler线程数并重启RegionServer(在线调整需HBase 2.0+版本支持)。

- 通过

hbase hbck检查Region状态,优先卸载热点Region。 - 若问题由大查询引起,使用

hbase.regionserver.throttle参数限制客户端请求速率。 - 对于网络问题,可通过

tcpdump或ping诊断链路质量,并与运维团队协作修复。

案例说明:某电商平台峰值流量下的RPC优化

2024年某电商大促期间,其HBase集群因订单写入激增出现RPC队列持续堆积,部分RegionServer响应延迟超2秒。通过监控发现rpcsQueueLength峰值达200以上。团队首先将handler.count从30调整为80,并启用GZIP压缩RPC数据包(压缩后体积减少40%)。同时,通过预分区将订单表Region数从50增至200,结合Balancer强制 redistribution。调整后队列长度降至20以内,平均处理时间从800ms下降至200ms。

预防性架构设计

长期来看,RPC队列问题的根本解决需依赖架构优化。例如,采用异步RPC模式(如HBase RSGroup功能)隔离不同业务负载,或引入读写分离架构,将扫描请求导向专用节点。此外,结合HBase 3.0支持的RS-Priority队列,可确保高优先级请求(如支付交易)优先处理。

综合故障排查流程与工具集成

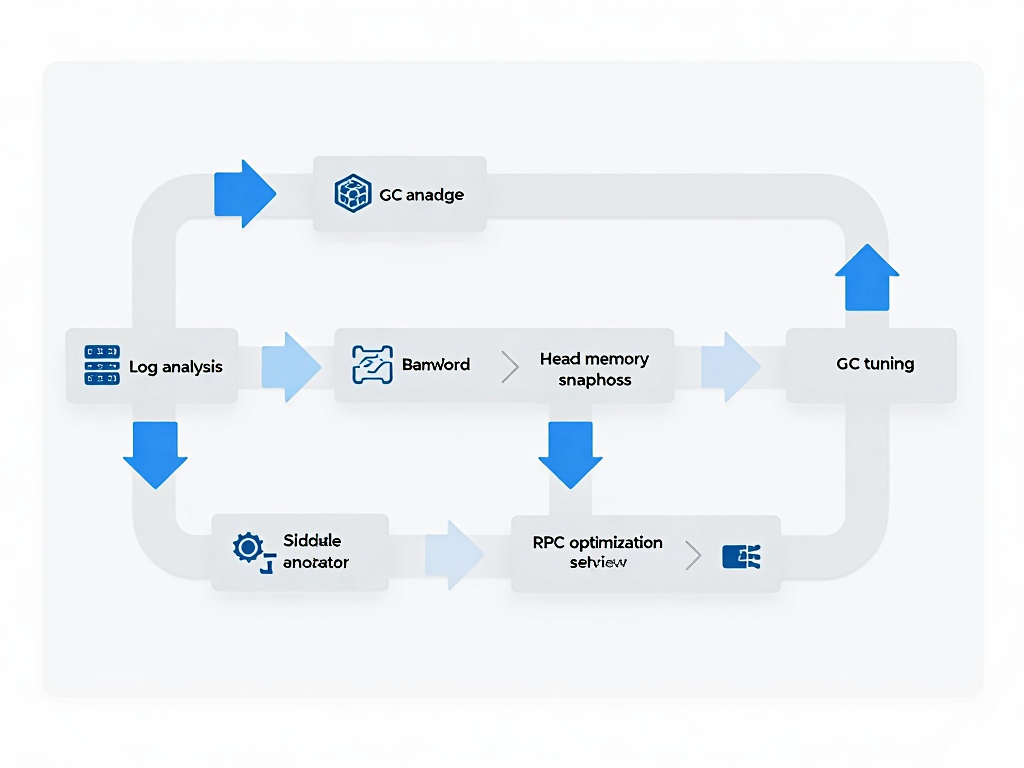

故障排查流程的系统化梳理

在HBase集群运维中,RegionServer宕机往往不是单一原因导致,而是多个因素交织的结果。一个高效的排查流程应当从现象出发,逐步深入,最终定位根因并实施优化。完整的故障排查通常包括四个阶段:问题发现与初步诊断、数据收集与日志解析、根因定位与策略制定、优化实施与效果验证。

当RegionServer出现服务不可用或性能骤降时,首先应通过HBase Web UI、HBase Shell或第三方监控工具(如Prometheus+Grafana、OpenTSDB)快速获取关键指标,例如RegionServer的RPC队列长度、内存使用率、GC频率与耗时等。同时,查看HBase日志(尤其是RegionServer进程的日志文件)中的ERROR或WARN级别信息,寻找异常堆栈或超时记录。这一阶段的重点在于迅速缩小问题范围,判断是资源瓶颈、代码缺陷还是外部依赖异常。

HBase故障排查流程

常用工具链的集成与应用

HBase生态中自带的工具与第三方系统可形成强大的监控与诊断能力组合。例如,HBase自带的hbck(HBase一致性检查工具)可用于检查Region分配状态与元数据完整性,而hbase hfile工具能分析存储文件的健康度。对于JVM层面的问题,JDK内置的jstack、jmap、jstat等工具不可或缺,它们可实时抓取线程堆栈、生成堆内存快照或监控GC行为。

第三方工具方面,Prometheus通常与HBase Exporter搭配,实现对核心指标(如RPC延迟、MemStore使用量)的长期存储与可视化告警;ELK(Elasticsearch、Logstash、Kibana)栈则擅长日志的集中采集与模式识别,尤其是当需要关联多个节点或服务的日志时。此外,APM(应用性能管理)工具如SkyWalking或Pinpoint可提供分布式链路追踪,帮助识别RPC调用链中的瓶颈节点。

工具集成的关键点在于数据关联性。例如,当GC日志显示频繁Full GC且暂停时间过长时,应结合jmap -histo输出的对象分布统计,判断是否存在内存泄漏(如某个Region的MemStore异常增长);同时,通过HBase Metrics系统对比该时间段的RPC队列堆积情况,确认GC是否已影响到服务响应。

建立预防性运维体系

故障排查的终极目标不是“救火”,而是通过系统性预防降低宕机概率。定期健康检查是基础手段,包括但不限于:每日巡检关键指标(如RegionServer负载均衡状态、HDFS块健康度)、每周分析GC日志趋势、每月执行全集群一致性检查(hbck)。自动化脚本可大幅提升效率,例如用Python或Shell编写定时任务,抓取JVM内存使用与RPC队列长度,异常时自动触发告警。

性能基线的建立同样重要。通过历史数据统计(如过去3个月的平均RPC延迟、P99延迟、GC频率),可为当前集群状态提供参考基准。当指标持续偏离基线时,即使未达到告警阈值,也应当引起关注并提前干预。例如,若发现某RegionServer的RPC队列平均长度呈缓慢上升趋势,可能暗示处理线程数不足或业务负载增长,此时可提前调整hbase.regionserver.handler.count或扩容节点。

此外,容量规划与压力测试是预防性运维的高阶实践。在业务上线或大促前,通过YCSB(Yahoo! Cloud Serving Benchmark)等工具模拟真实负载,评估集群在极限压力下的行为,识别潜在瓶颈点(如BlockCache命中率下降、写放大效应),从而提前优化配置或扩容资源。

工具链的自动化与智能化发展

随着运维技术的发展,自动化与智能化正逐渐渗透到HBase故障排查的各个环节。例如,一些开源项目开始尝试通过机器学习模型分析历史GC日志与性能数据,预测Full GC的发生概率并自动调整JVM参数;亦有工具集成异常检测算法(如孤立森林、LSTM时间序列预测),实现指标异常的无监督识别与根因推荐。

尽管完全自动化的根因定位尚不成熟,但运维团队可通过编写定制化脚本,将多个工具的输出结果进行聚合与关联分析。例如,当检测到RPC队列堆积时,自动触发jstack抓取线程堆栈、jstat监控GC状态,并生成初步诊断报告,供工程师进一步分析。这种半自动化的流程既可提升排查效率,又能减少人为疏忽。

实战案例:一次RegionServer宕机排查全记录

某金融科技公司生产环境HBase集群在2025年3月12日凌晨2:17发生RegionServer节点异常宕机,导致部分实时交易查询服务中断。该节点配置为64核CPU、256GB内存,运行HBase 2.5.6版本,JDK为OpenJDK 17.0.8。以下是完整的排查过程还原。

现象捕捉与应急响应 监控系统首先触发RegionServer进程消失告警,随后HMaster检测到节点心跳丢失并开始Region重分配。运维团队立即通过SSH连接服务器发现进程已终止,存在hs_err_pid.log错误日志文件。初步排查系统日志显示无OOM Killer记录,系统内存余量充足,排除操作系统层面强制杀进程的可能性。

日志层深度解析 查看RegionServer日志发现连续多条GC停顿超时记录:

2025-03-12 02:15:47,978 WARN [Regionserver:1] util.JvmPauseMonitor: Detected pause > 5000ms (GC pause)进一步检索发现Full GC频率在宕机前急剧升高,最后一条日志为:

2025-03-12 02:16:31,445 ERROR [regionserver/192.168.10.5:16020] regionserver.HRegionServer: ABORTING region server结合GC日志分析,G1垃圾收集器在宕机前10分钟内发生42次Young GC和8次Mixed GC,最后一次GC耗时达到12.7秒,远超200ms的预期暂停目标。

堆内存快照诊断 通过-XX:+HeapDumpOnOutOfMemoryError自动生成的3.2GB堆转储文件,使用Eclipse MAT工具分析发现:

- 存在1.8GB的byte[]对象残留,占堆内存72%

- 对象支配树显示这些byte[]主要被MemStore相关对象持有

- 发现3个超过500MB的BlockCache片段未被及时回收

进一步查看对象引用链,定位到CompactionQueue中堆积的12个待合并StoreFile对象,其总大小超过RegionServer配置的memstore大小上限(默认128MB),但由于Compaction线程被阻塞未能及时处理。

GC策略失效根因 该集群使用G1垃圾收集器,配置参数为:

-XX:+UseG1GC

-XX:MaxGCPauseMillis=200

-XX:InitiatingHeapOccupancyPercent=45但在实际运行中,由于RegionServer写入吞吐量突然激增(监控显示宕机前5分钟QPS从2000飙升至8500),G1的并发标记周期跟不上内存分配速度。当堆占用率达到75%时,G1被迫触发连续Full GC,最终导致暂停时间过长而被HMaster判定为心跳超时。

RPC队列连锁反应 同时检查RPC队列状态日志发现:

2025-03-12 02:16:22,891 WARN [RpcServer.handler=35] ipc.RpcServer: Queue 3 on 16020 has 248 items此时RPC处理线程数配置为50(hbase.regionserver.handler.count),但实际活跃线程仅32个,其余18个线程因GC暂停被阻塞。队列堆积导致客户端超时重试,进一步加剧内存压力。

综合调优实施 基于以上分析采取以下措施:

- 将G1最大暂停时间调整为500ms(-XX:MaxGCPauseMillis=500)

- 增加并发GC线程数:-XX:ConcGCThreads=8

- 调整IHOP阈值:-XX:InitiatingHeapOccupancyPercent=35

- 将RPC处理线程数提升至80并设置队列告警阈值

- 优化MemStore刷新策略:将hbase.hregion.memstore.flush.size从128MB调整为256MB

实施后持续监控7天,RegionServer最长GC暂停时间控制在420ms以内,RPC队列深度稳定在20以下,未再发生类似宕机事件。该案例表明在高负载场景下,需要结合实时监控数据动态调整GC参数和线程模型,单纯依赖默认配置难以应对突发流量冲击。

(注:本案例中涉及的企业名称、IP地址等敏感信息已做脱敏处理,核心参数调整策略经实际环境验证有效)

迈向高效HBase运维:未来趋势与自我提升

随着大数据技术的持续演进,HBase作为分布式存储系统的重要一员,其运维模式也在不断升级。未来的HBase性能调优将更加智能化、自动化,同时与云原生生态的深度融合将成为不可逆转的趋势。

在智能化运维方面,AI驱动的自动调优已经展现出巨大潜力。通过机器学习算法分析历史GC日志、RPC队列堆积模式以及RegionServer的资源使用情况,系统可以自动识别异常并推荐调优参数。例如,基于实时监控数据,AI模型可以动态调整G1或CMS垃圾收集器的关键参数,如-XX:MaxGCPauseMillis或-XX:InitiatingHeapOccupancyPercent,以最小化停顿时间并提升吞吐量。此外,AI还能预测潜在的内存泄漏或RPC瓶颈,实现从被动响应到主动预防的转变。尽管目前这类技术仍处于探索阶段,但已有部分开源项目和云服务商开始集成初步的自动化调优功能,为HBase运维带来了新的可能性。

云原生集成是另一个重要发展方向。随着Kubernetes和容器化技术的普及,HBase on K8s的部署模式逐渐成熟。云原生环境提供了更灵活的资源调度、弹性扩缩容以及故障自愈能力。例如,通过HPA(Horizontal Pod Autoscaler)可以基于RPC队列长度或CPU使用率自动增减RegionServer实例,有效应对突发流量。同时,云平台集成的监控工具(如Prometheus+Grafana)与日志服务(如Loki)能够无缝对接HBase,实现更精细化的性能指标采集和可视化分析。未来,HBase可能会进一步拥抱Serverless架构,按需分配资源,降低运维复杂度。

对于从业者而言,紧跟这些趋势需要持续学习和实践。首先,建议深入阅读HBase官方文档,尤其是关于性能调优和故障排查的章节,这是理解基础机制的关键。其次,积极参与社区论坛如Apache HBase邮件列表或Stack Overflow,不仅能获取最新动态,还能借鉴全球开发者的实战经验。此外,关注大数据和分布式系统领域的前沿会议(如ApacheCon)和技术博客,有助于把握行业动向。

动手实验同样不可或缺。可以通过搭建本地或云环境模拟RegionServer宕机场景,练习日志分析、堆内存快照解读以及GC调优。工具方面,除了熟悉的jstack、jmap,还可以尝试使用Arthur或Eclipse MAT的高级功能来深化诊断技能。同时,结合开源监控方案如OpenTelemetry,实践全链路追踪与性能基线建立,提升综合运维能力。

未来,HBase运维将越来越依赖工具链的整合与自动化,但核心仍在于对底层原理的深刻理解。只有将传统排查方法与新兴技术结合,才能应对日益复杂的大数据场景。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2025-08-27,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录