Higress AI 智能搜索服务添加福利群:解决AI开发者的「MCP实战痛点」

Higress AI 智能搜索服务添加福利群:解决AI开发者的「MCP实战痛点」 github

github一个模型上下文协议(MCP)服务器,它提供了一个AI搜索工具,借助Higress ai - search功能,通过来自各种搜索引擎的实时搜索结果来增强AI模型的响应能力。

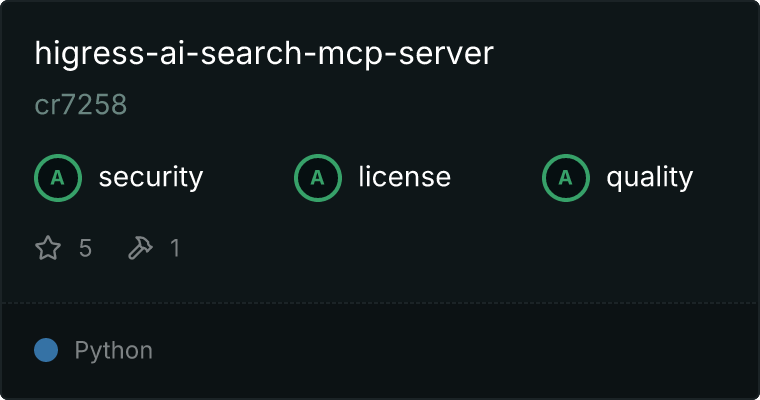

By cr7258

详情内容

Higress AI搜索MCP服务器

概述

这是一个模型上下文协议(MCP)服务器,通过Higress的ai-search功能,提供AI搜索工具,利用来自各种搜索引擎的实时搜索结果来增强AI模型的响应能力。

演示

Cline

https://github.com/user-attachments/assets/60a06d99-a46c-40fc-b156-793e395542bb

Claude Desktop

https://github.com/user-attachments/assets/5c9e639f-c21c-4738-ad71-1a88cc0bcb46

功能

- 互联网搜索:Google、Bing、Quark - 用于获取通用网络信息

- 学术搜索:Arxiv - 用于获取科学论文和研究资料

- 内部知识搜索

前提条件

配置

该服务器可以通过环境变量进行配置:

HIGRESS_URL(可选):Higress服务的URL(默认:http://localhost:8080/v1/chat/completions)MODEL(必需):用于生成响应的LLM模型INTERNAL_KNOWLEDGE_BASES(可选):内部知识库的描述

选项1:使用uvx

使用uvx会自动从PyPI安装包,无需在本地克隆仓库。

{

"mcpServers": {

"higress-ai-search-mcp-server": {

"command": "uvx",

"args": [

"higress-ai-search-mcp-server"

],

"env": {

"HIGRESS_URL": "http://localhost:8080/v1/chat/completions",

"MODEL": "qwen-turbo",

"INTERNAL_KNOWLEDGE_BASES": "员工手册,公司政策,内部流程文档"

}

}

}

}

选项2:使用uv进行本地开发

使用uv需要在本地克隆仓库,并指定源代码路径。

{

"mcpServers": {

"higress-ai-search-mcp-server": {

"command": "uv",

"args": [

"--directory",

"path/to/src/higress-ai-search-mcp-server",

"run",

"higress-ai-search-mcp-server"

],

"env": {

"HIGRESS_URL": "http://localhost:8080/v1/chat/completions",

"MODEL": "qwen-turbo",

"INTERNAL_KNOWLEDGE_BASES": "员工手册,公司政策,内部流程文档"

}

}

}

}

许可证

本项目采用MIT许可证 - 详情请参阅LICENSE文件。