如何对脸进行预处理?

如何对脸进行预处理?

提问于 2017-03-22 01:18:49

我正在尝试写一个脸对齐器作为预处理步骤,然后再把我的脸输入神经网络。我(使用Python)通过dlib实现了Vahid Kazemi和Josephine Sullivan回归树集合来预测人脸地标性估计,发现了人脸的地标。我尝试了几种不同的转换,但都没有用。这是我的基本管道:

- 在图像中查找人脸,并裁剪图像,使其只具有该脸: face_detector = dlib.get_frontal_face_detector() detected_face =face_detector(图像) w,h= 160 #,以便facenet可以将其用于detected_face中的face_rect:#第一次裁剪脸部左= face_rect.left()顶部= face_rect.top()右= face_rect.right()底部= face_rect.bottom() new_face_rect = dlib.rectangle(0,0,右左,右),cropped_image =imagetop:底部,左:右,:.copy() #获取脸的姿势pose_landmarks = face_pose_predictor(cropped_image,new_face_rect)

- 查找地标(

get_landmark_points返回一个68x2数组 地标= get_landmark_points(pose_landmarks,N_LANDMARKS,dlib_point=False) - 定义一些

src和dst点: top_of_nose = landmarks27 left_eye = landmarks36 right_eye = landmarks45 bottom_lip = landmarks57 src = top_of_nose,left_eye,right_eye,bottom_lip dst = [np.int(0.5 * w),np.int(h/3),\ np.int(0.3 * w),np.int(h / 3),\ np.int(0.7 * w),np.int(h / 3),np.int(h/3),\ np.int(0.5 * w),np.int(h * (2.0/3))] - 估计变换,并对其余的地标进行变换。 np.reshape(cv2.transform(np.expand_dims(landmarks,=cv2. transformed_crop =cv2. cv2.warpAffine(cropped_image,transform,(w,h)) #获取变换后的地标transformed_landmarks =cropped_image 1,\ transform),(N_LANDMARKS,2).astype(np.float32)#添加边界点transformed_landmarks = np.append(transformed_landmarks,boundary_points,轴= 0)

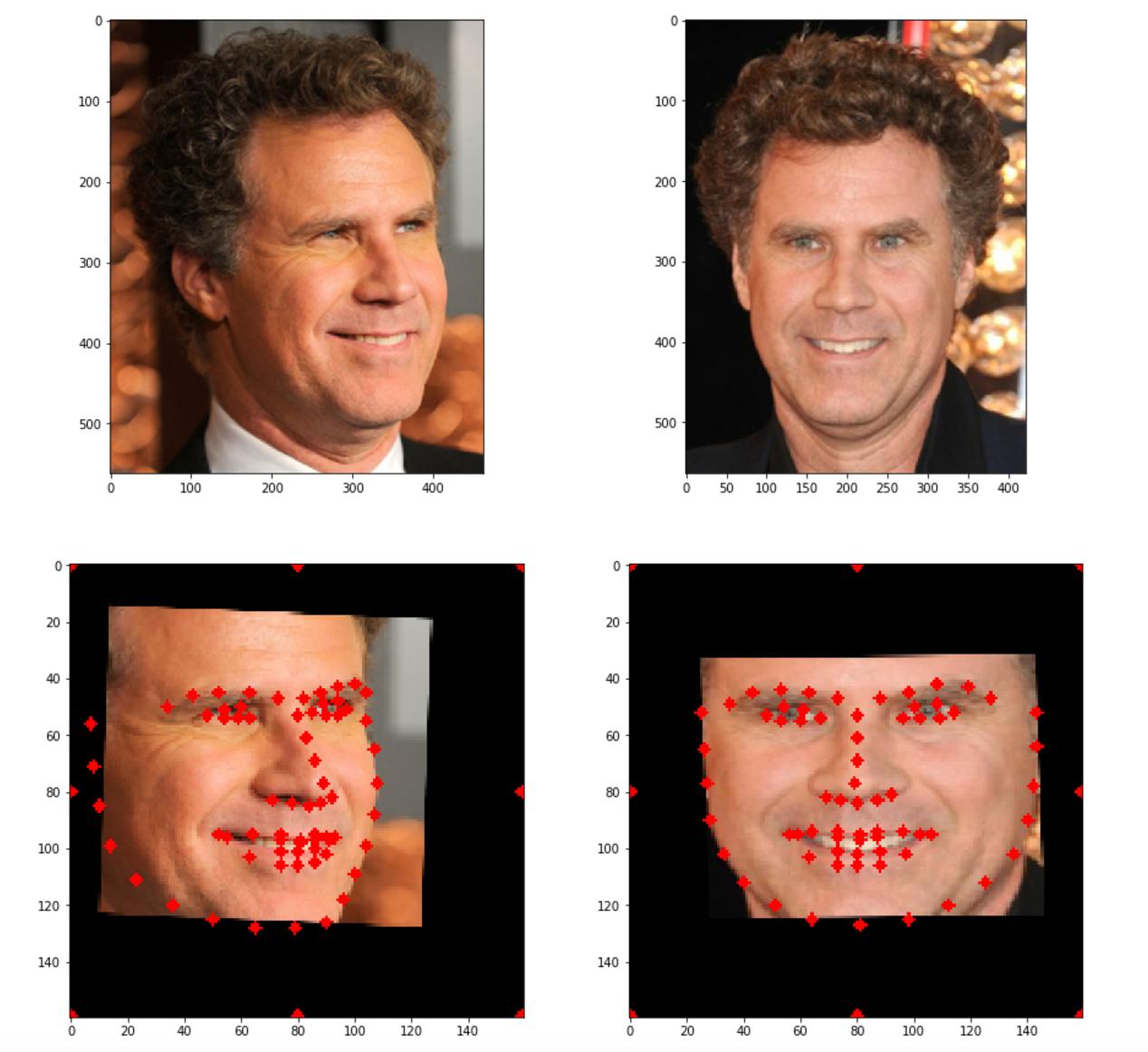

以下是2幅图像的输入和输出:

虽然它是一种工作,但并不完美,因为虽然眼睛和嘴唇是相同的高度在这两张图像,他们的x位置是不同的。我想知道是否有什么方法来改进它,还是我使用了错误的技术?如果有人给我指明正确的方向,那会很有帮助的,谢谢!

回答 1

Stack Overflow用户

发布于 2020-09-08 07:54:05

deepface封装了dlib和许多其他面部检测器,并提供了开箱即用的功能。只需调用检测面部功能。

#!pip install deepface

from deepface import DeepFace

import matplotlib.pyplot as plt

backend = 'dlib' opencv, ssd, dlib or mtcnn

img = DeepFace.detectFace("img.jpg", detector_backend = backend)

plt.imshow(img); plt.show()页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/42941079

复制相关文章

相似问题