使用场景

自建 K8s 日志采集功能是为用户提供的非腾讯云 Kubernetes 集群内的日志采集工具,可以将集群内服务或集群节点特定路径文件的日志发送至 腾讯云日志服务 CLS。日志采集功能适用于需要对 Kubernetes 集群内服务日志进行存储和分析的用户。

日志采集功能需要为每个集群手动开启并配置采集规则。日志采集功能开启后,日志采集 Agent 会在集群内以 DaemonSet 的形式运行,并根据用户通过日志采集规则配置的采集源、CLS 日志主题和日志解析方式,从采集源进行日志采集,将日志内容发送到日志消费端。您可根据以下操作开启日志采集功能。

前提条件

在自建 K8s 集群上安装部署好采集器 LogListener,安装 LogListener 请参见 自建 K8s 集群安装 LogListener。

配置好相应的日志上报权限,权限配置请参见 使用自建 K8s 上传数据。

操作步骤

步骤1:选择集群

1. 登录 日志服务控制台。

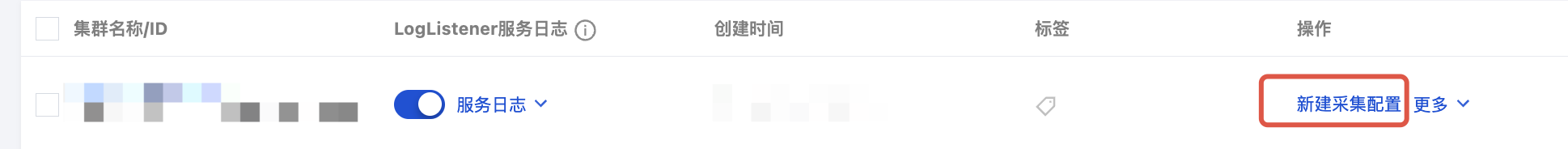

2. 在左侧导航栏中,单击容器集群管理,进入容器集群管理页面。

3. 在页面右上角选中自建 K8s 集群。

4. 若您已完成 自建 K8s 集群安装 LogListener,CLS 将会自动在您安装时指定的 CLS 地域下,创建一个集群。

5. 单击右侧新建采集配置, 进入集群日志采集配置流程。

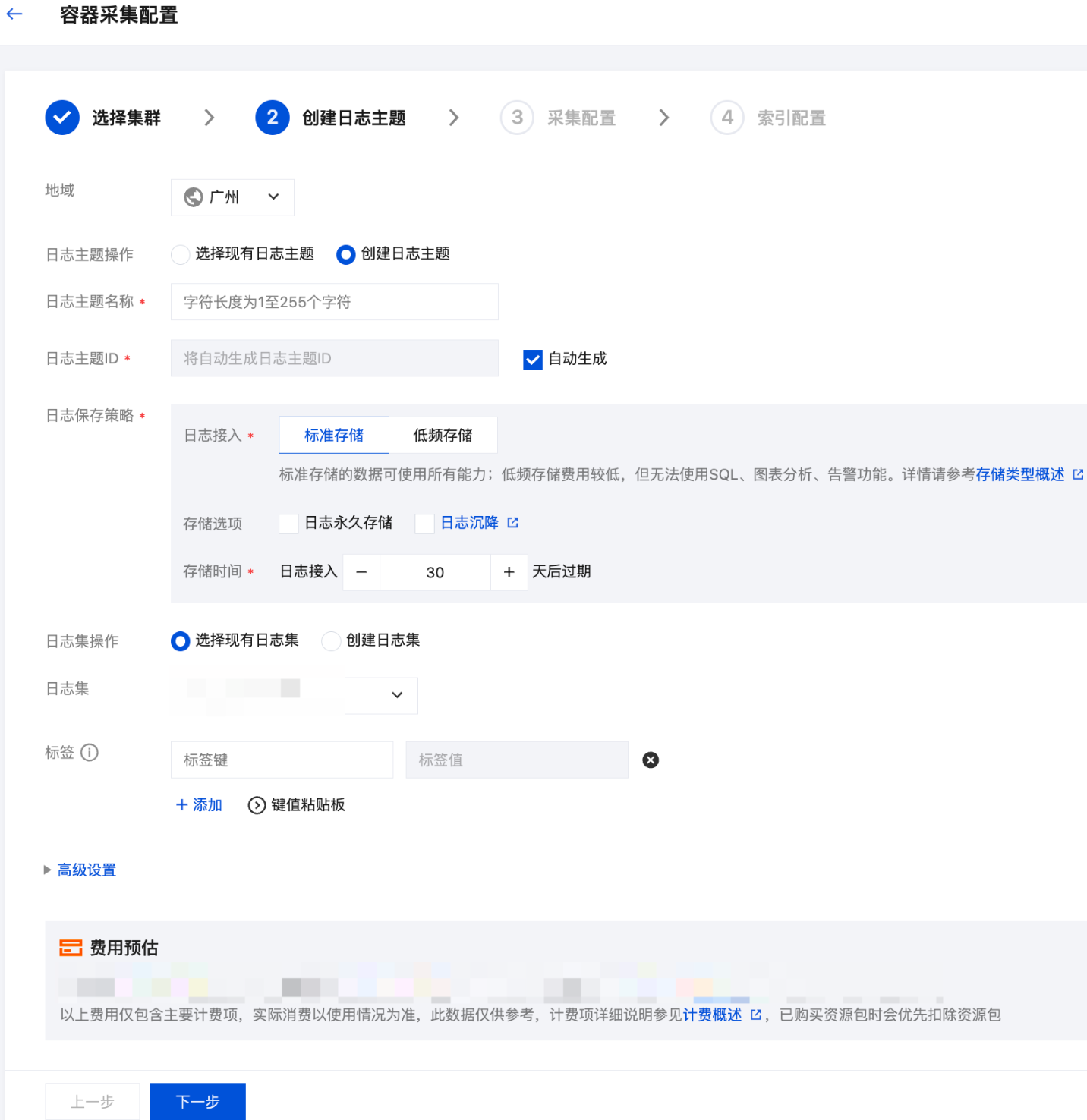

步骤2:配置日志主题

步骤3:配置采集规则

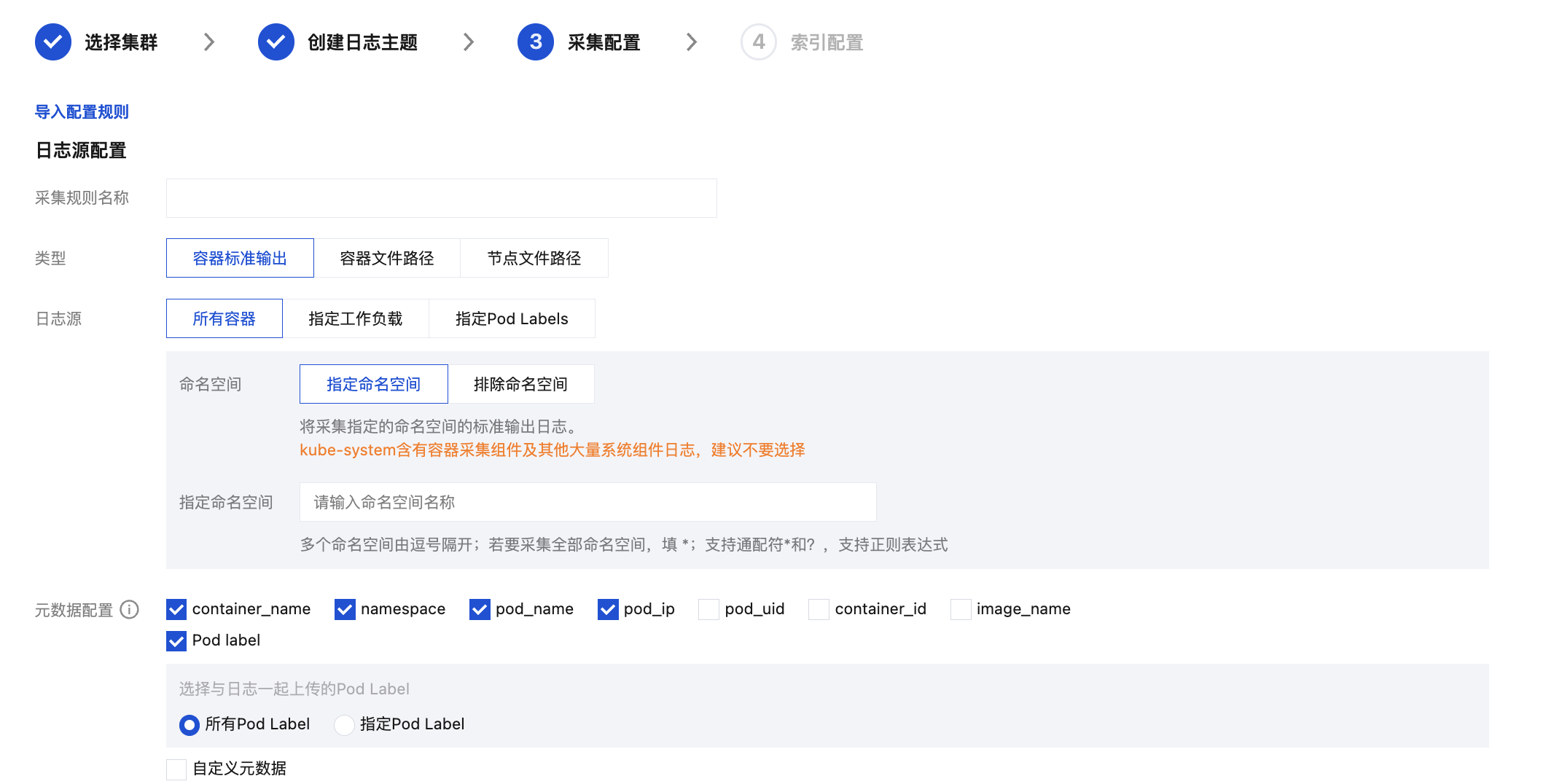

完成日志主题的配置后,单击下一步进入采集配置即可配置采集规则,配置信息如下:

日志源配置:

采集规则名称:您可以自定义日志采集规则名称。

采集类型:目前采集类型支持容器标准输出、容器文件路径和节点文件路径。

支持所有容器、指定工作负载、指定 Pod Labels 三种方式指定容器标准输出的采集日志源。

所有容器:代表采集指定命名空间下的所有容器中的标准输出日志,如下图所示:

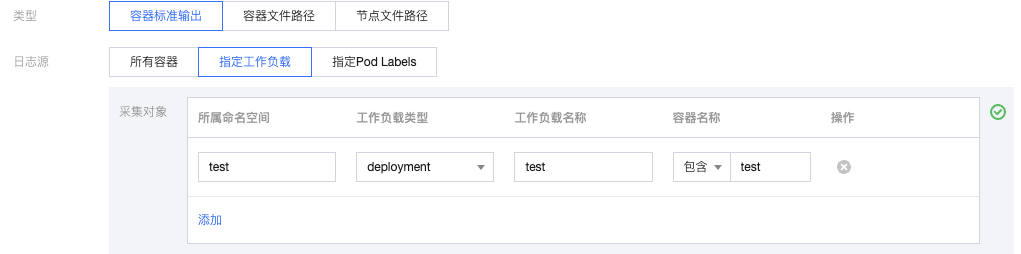

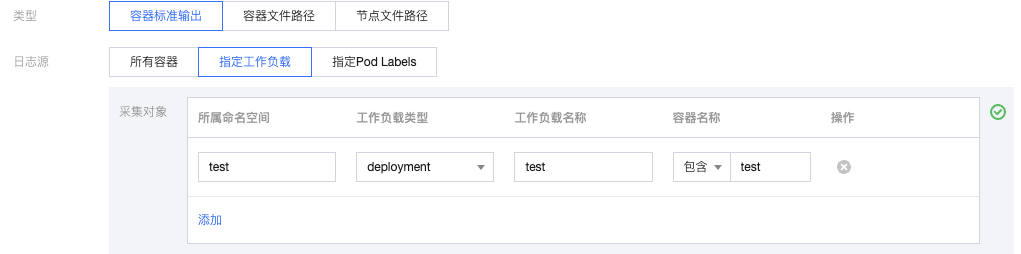

指定工作负载:代表采集指定命名空间下,指定工作负载中,指定容器的标准输出日志,如下图所示:

指定 Pod Labels:代表采集指定命名空间下,所有带有指定 Pod Label 的容器中的标准输出日志,如下图所示:

注意:

“容器文件路径” 不能为软链接,否则会导致软链接的实际路径在采集器的容器内不存在,采集日志失败。

支持指定工作负载、指定 Pod Labels 两种方式指定容器文件路径的采集日志源。

指定工作负载:代表采集指定命名空间下、指定工作负载中、指定容器中的容器文件路径,如下图所示:

指定 Pod Labels:代表采集指定命名空间下,所有带有指定 Pod Label 的容器中的容器文件路径,如下图所示:

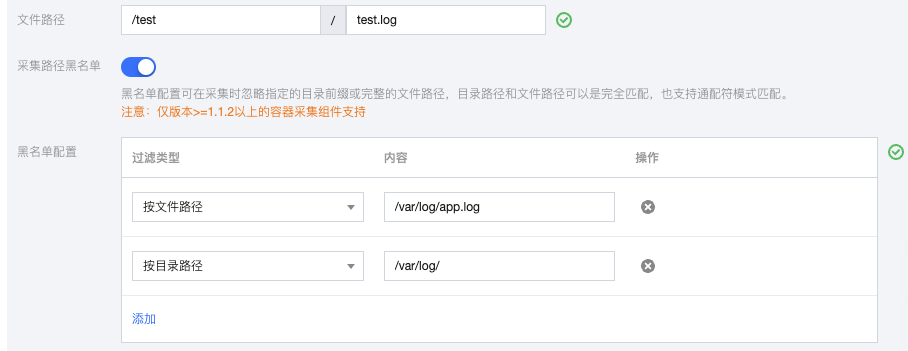

容器文件路径由日志目录与文件名组成,日志目录前缀以 / 开头,文件名以非 / 开头,前缀和文件名均支持使用通配符 ? 和 *,不支持逗号。/**/代表日志采集组件将监听所填前缀目录下所有层级中匹配的日志文件。多文件路径之间为或关系。例如:当容器文件路径为

/opt/logs/*.log,可以指定目录前缀为 /opt/logs,文件名为 *.log的日志。注意:

仅版本1.1.12及以上的容器采集组件支持多采集路径。

仅升级至1.1.12及以上版本后创建的采集配置支持定义多采集路径。

版本1.1.12以下创建的采集配置在升级至1.1.12后不支持配置多采集路径,需重新创建采集配置。

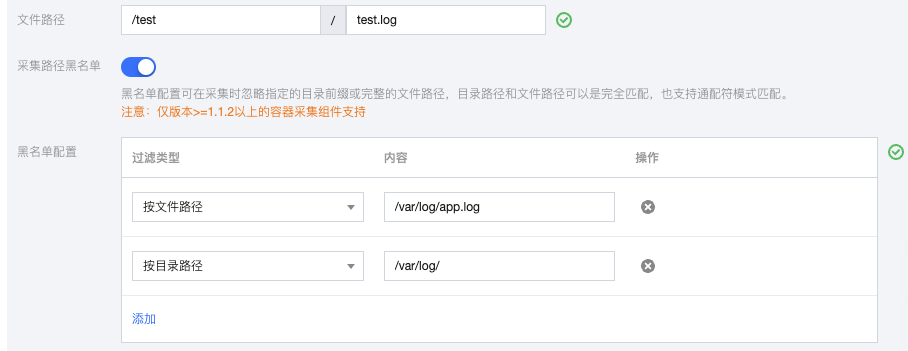

采集路径黑名单。 开启后可在采集时忽略指定的目录路径或完整的文件路径。目录路径和文件路径可以是完全匹配,也支持通配符模式匹配。

采集黑名单分为两类过滤类型,且可以同时使用:

文件路径:采集路径下,需要忽略采集的完整文件路径,支持通配符*或?,支持**路径模糊匹配。

目录路径:采集路径下,需要忽略采集的目录前缀,支持通配符*或?,支持**路径模糊匹配。

注意:

需要容器日志采集组件1.1.2及以上版本。

采集黑名单是在采集路径下进行排除,因此无论是文件路径模式,还是目录路径模式,其指定路径要求为采集路径的子集。

节点文件路径由日志目录与文件名组成,日志目录前缀以 / 开头,文件名以非 / 开头,前缀和文件名均支持使用通配符 ? 和 *,不支持逗号。/**/代表日志采集组件将监听所填前缀目录下所有层级中匹配的日志文件。多文件路径之间为或关系。例如:当节点文件路径为

/opt/logs/*.log,可以指定目录前缀为 /opt/logs,文件名为 *.log的日志。注意:

仅版本1.1.12及以上的采集组件支持多采集路径。

仅升级至1.1.12及以上版本后创建的采集配置支持定义多采集路径。

版本1.1.12以下创建的采集配置在升级至1.1.12后不支持配置多采集路径,需重新创建采集配置。

采集路径黑名单。 开启后可在采集时忽略指定的目录路径或完整的文件路径。目录路径和文件路径可以是完全匹配,也支持通配符模式匹配。

采集黑名单分为两类过滤类型,且可以同时使用:

文件路径:采集路径下,需要忽略采集的完整文件路径,支持通配符*或?,支持**路径模糊匹配。

目录路径:采集路径下,需要忽略采集的目录前缀,支持通配符*或?,支持**路径模糊匹配。

注意:

需要容器日志采集组件1.1.2及以上版本。

采集黑名单是在采集路径下进行排除,因此无论是文件路径模式,还是目录路径模式,其指定路径要求为采集路径的子集。

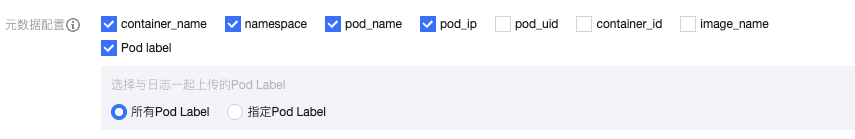

元数据配置:

字段名 | 含义 |

container_id | 日志所属的容器 ID。 |

container_name | 日志所属的容器名称。 |

image_name | 日志所属容器的镜像名称 IP。 |

namespace | 日志所属 pod 的 namespace。 |

pod_uid | 日志所属 pod 的 UID。 |

pod_name | 日志所属 pod 的名字。 |

pod_ip | 日志所属 pod 的 IP 地址。 |

pod_lable_{label name} | 日志所属 pod 的 label(例如一个 pod 带有两个 label:app=nginx,env=prod,则在上传的日志会附带两个 metedata:pod_label_app:nginx,pod_label_env:prod)。 |

说明:

如果想采集部分 podlabel,需要手动输入想要的 label key (可以输入多个,每输入一个以回车结束),命中的话会采集。

解析规则配置:

采集策略。您可以选择全量或者增量。

全量:全量采集指从日志文件的开头开始采集。

增量:增量采集指只采集文件内新增的内容

编码模式:支持 UTF-8和 GBK。

提取模式:支持多种类型的提取模式,详情如下:

单行全文日志是指一行日志内容为一条完整的日志。日志服务在采集的时候,将使用换行符 \\n 来作为一条日志的结束符。为了统一结构化管理,每条日志都会存在一个默认的键值__CONTENT__,但日志数据本身不再进行日志结构化处理,也不会提取日志字段,日志属性的时间项由日志采集的时间决定。

假设一条日志原始数据为:

Tue Jan 22 12:08:15 CST 2019 Installed: libjpeg-turbo-static-1.2.90-6.el7.x86_64

采集到日志服务的数据为:

__CONTENT__:Tue Jan 22 12:08:15 CST 2019 Installed: libjpeg-turbo-static-1.2.90-6.el7.x86_64

多行全文日志是指一条完整的日志数据可能跨占多行(例如 Java stacktrace)。在这种情况下,以换行符 \\n 为日志的结束标识符就显得有些不合理,为了能让日志系统明确区分开每条日志,采用首行正则的方式进行匹配,当某行日志匹配上预先设置的正则表达式,就认为是一条日志的开头,而下一个行首出现作为该条日志的结束标识符.

多行全文也会设置一个默认的键值__CONTENT__,但日志数据本身不再进行日志结构化处理,也不会提取日志字段,日志属性的时间项由日志采集的时间决定。

假设一条多行日志原始数据为:

2019-12-15 17:13:06,043 [main] ERROR com.test.logging.FooFactory:java.lang.NullPointerExceptionat com.test.logging.FooFactory.createFoo(FooFactory.java:15)at com.test.logging.FooFactoryTest.test(FooFactoryTest.java:11)

首行正则表达式为如下:

\\d{4}-\\d{2}-\\d{2}\\s\\d{2}:\\d{2}:\\d{2},\\d{3}\\s.+

采集到日志服务的数据为:

__CONTENT__:2019-12-15 17:13:06,043 [main] ERROR com.test.logging.FooFactory:\\njava.lang.NullPointerException\\n at com.test.logging.FooFactory.createFoo(FooFactory.java:15)\\n at com.test.logging.FooFactoryTest.test(FooFactoryTest.java:11)

单行完全正则格式通常用来处理结构化的日志,指将一条完整日志按正则方式提取多个 key-value 的日志解析模式。

假设一条日志原始数据为:

10.135.46.111 - - [22/Jan/2019:19:19:30 +0800] "GET /my/course/1 HTTP/1.1" 127.0.0.1 200 782 9703 "http://127.0.0.1/course/explore?filter%5Btype%5D=all&filter%5Bprice%5D=all&filter%5BcurrentLevelId%5D=all&orderBy=studentNum" "Mozilla/5.0 (Windows NT 10.0; WOW64; rv:64.0) Gecko/20100101 Firefox/64.0" 0.354 0.354

配置的正则表达式为如下:

(\\S+)[^\\[]+(\\[[^:]+:\\d+:\\d+:\\d+\\s\\S+)\\s"(\\w+)\\s(\\S+)\\s([^"]+)"\\s(\\S+)\\s(\\d+)\\s(\\d+)\\s(\\d+)\\s"([^"]+)"\\s"([^"]+)"\\s+(\\S+)\\s(\\S+).*

采集到日志服务的数据为:

body_bytes_sent: 9703http_host: 127.0.0.1http_protocol: HTTP/1.1http_referer: http://127.0.0.1/course/explore?filter%5Btype%5D=all&filter%5Bprice%5D=all&filter%5BcurrentLevelId%5D=all&orderBy=studentNumhttp_user_agent: Mozilla/5.0 (Windows NT 10.0; WOW64; rv:64.0) Gecko/20100101 Firefox/64.0remote_addr: 10.135.46.111request_length: 782request_method: GETrequest_time: 0.354request_url: /my/course/1status: 200time_local: [22/Jan/2019:19:19:30 +0800]upstream_response_time: 0.354

假设您的一条日志原始数据为:

[2018-10-01T10:30:01,000] [INFO] java.lang.Exception: exception happenedat TestPrintStackTrace.f(TestPrintStackTrace.java:3)at TestPrintStackTrace.g(TestPrintStackTrace.java:7)at TestPrintStackTrace.main(TestPrintStackTrace.java:16)

行首正则表达式为:

\\[\\d+-\\d+-\\w+:\\d+:\\d+,\\d+]\\s\\[\\w+]\\s.*

配置的自定义正则表达式为:

\\[(\\d+-\\d+-\\w+:\\d+:\\d+,\\d+)\\]\\s\\[(\\w+)\\]\\s(.*)

系统根据

()捕获组提取对应的 key-value 后,您可以自定义每组的 key 名称如下所示:time: 2018-10-01T10:30:01,000`level: INFO`msg:java.lang.Exception: exception happenedat TestPrintStackTrace.f(TestPrintStackTrace.java:3)at TestPrintStackTrace.g(TestPrintStackTrace.java:7)at TestPrintStackTrace.main(TestPrintStackTrace.java:16)

假设您的一条 JSON 日志原始数据为:

{"remote_ip":"10.135.46.111","time_local":"22/Jan/2019:19:19:34 +0800","body_sent":23,"responsetime":0.232,"upstreamtime":"0.232","upstreamhost":"unix:/tmp/php-cgi.sock","http_host":"127.0.0.1","method":"POST","url":"/event/dispatch","request":"POST /event/dispatch HTTP/1.1","xff":"-","referer":"http://127.0.0.1/my/course/4","agent":"Mozilla/5.0 (Windows NT 10.0; WOW64; rv:64.0) Gecko/20100101 Firefox/64.0","response_code":"200"}

经过日志服务结构化处理后,该条日志将变为如下:

agent: Mozilla/5.0 (Windows NT 10.0; WOW64; rv:64.0) Gecko/20100101 Firefox/64.0body_sent: 23http_host: 127.0.0.1method: POSTreferer: http://127.0.0.1/my/course/4remote_ip: 10.135.46.111request: POST /event/dispatch HTTP/1.1response_code: 200responsetime: 0.232time_local: 22/Jan/2019:19:19:34 +0800upstreamhost: unix:/tmp/php-cgi.sockupstreamtime: 0.232url: /event/dispatchxff: -

假设您的一条日志原始数据为:

10.20.20.10 - ::: [Tue Jan 22 14:49:45 CST 2019 +0800] ::: GET /online/sample HTTP/1.1 ::: 127.0.0.1 ::: 200 ::: 647 ::: 35 ::: http://127.0.0.1/

当日志解析的分隔符指定为

:::,该条日志会被分割成八个字段,并为这八个字段定义唯一的 key,如下所示:IP: 10.20.20.10 -bytes: 35host: 127.0.0.1length: 647referer: http://127.0.0.1/request: GET /online/sample HTTP/1.1status: 200time: [Tue Jan 22 14:49:45 CST 2019 +0800]

假设您的一条日志的原始数据为:

1571394459,http://127.0.0.1/my/course/4|10.135.46.111|200,status:DEAD,

自定义插件内容如下:

{"processors": [{"type": "processor_split_delimiter","detail": {"Delimiter": ",","ExtractKeys": [ "time", "msg1","msg2"]},"processors": [{"type": "processor_timeformat","detail": {"KeepSource": true,"TimeFormat": "%s","SourceKey": "time"}},{"type": "processor_split_delimiter","detail": {"KeepSource": false,"Delimiter": "|","SourceKey": "msg1","ExtractKeys": [ "submsg1","submsg2","submsg3"]},"processors": []},{"type": "processor_split_key_value","detail": {"KeepSource": false,"Delimiter": ":","SourceKey": "msg2"}}]}]}

经过日志服务结构化处理后,该条日志将变为如下:

time: 1571394459submsg1: http://127.0.0.1/my/course/4submsg2: 10.135.46.111submsg3: 200status: DEAD

过滤器:LogListener 仅采集符合过滤器规则的日志,Key 支持完全匹配,过滤规则支持正则匹配,如仅采集

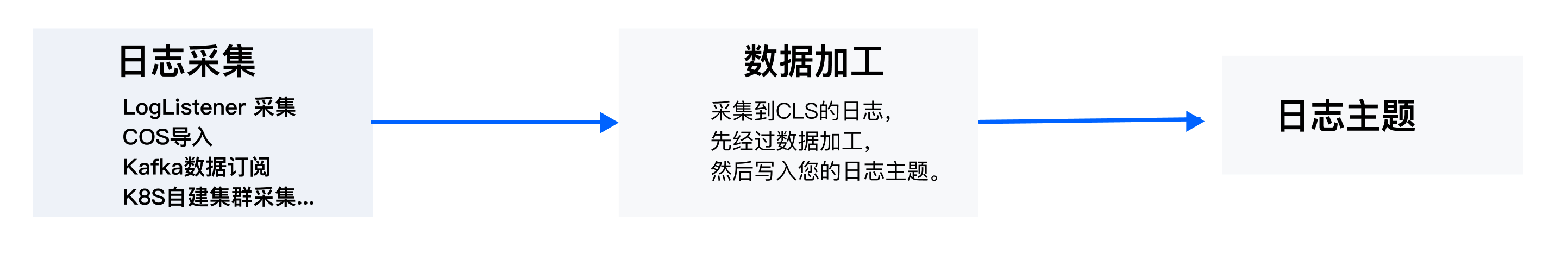

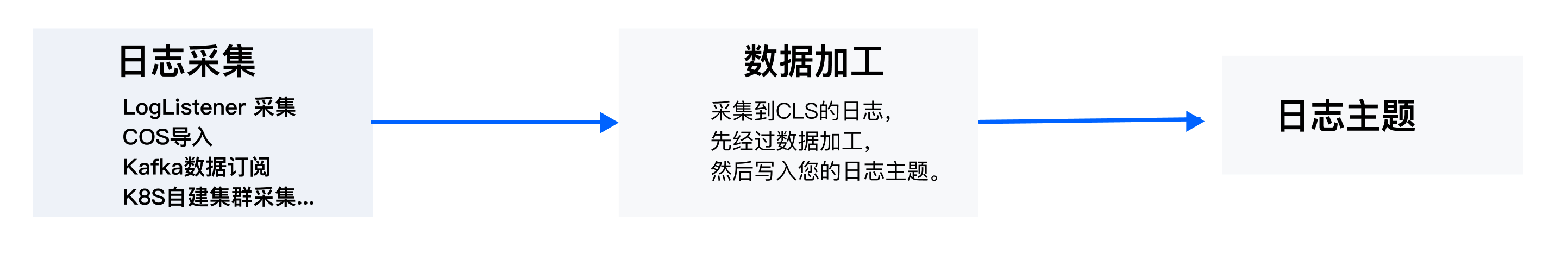

ErrorCode = 404 的日志。您可以根据需求开启过滤器并配置规则。数据加工

步骤4:配置索引

完成采集规则配置后, 单击下一步进入索引配置,在配置页面中建议直接使用推荐配置,完成索引的自动配置。

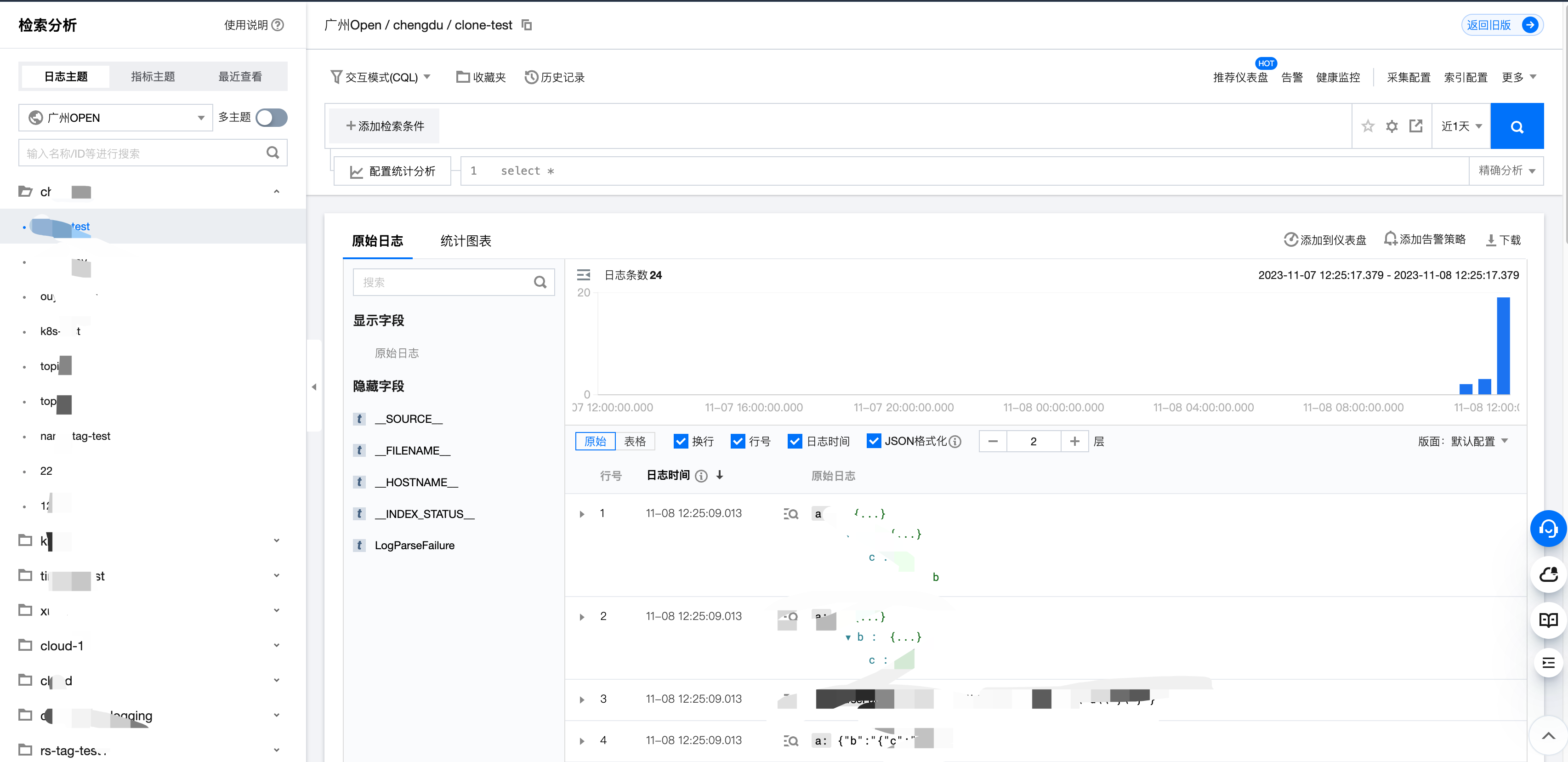

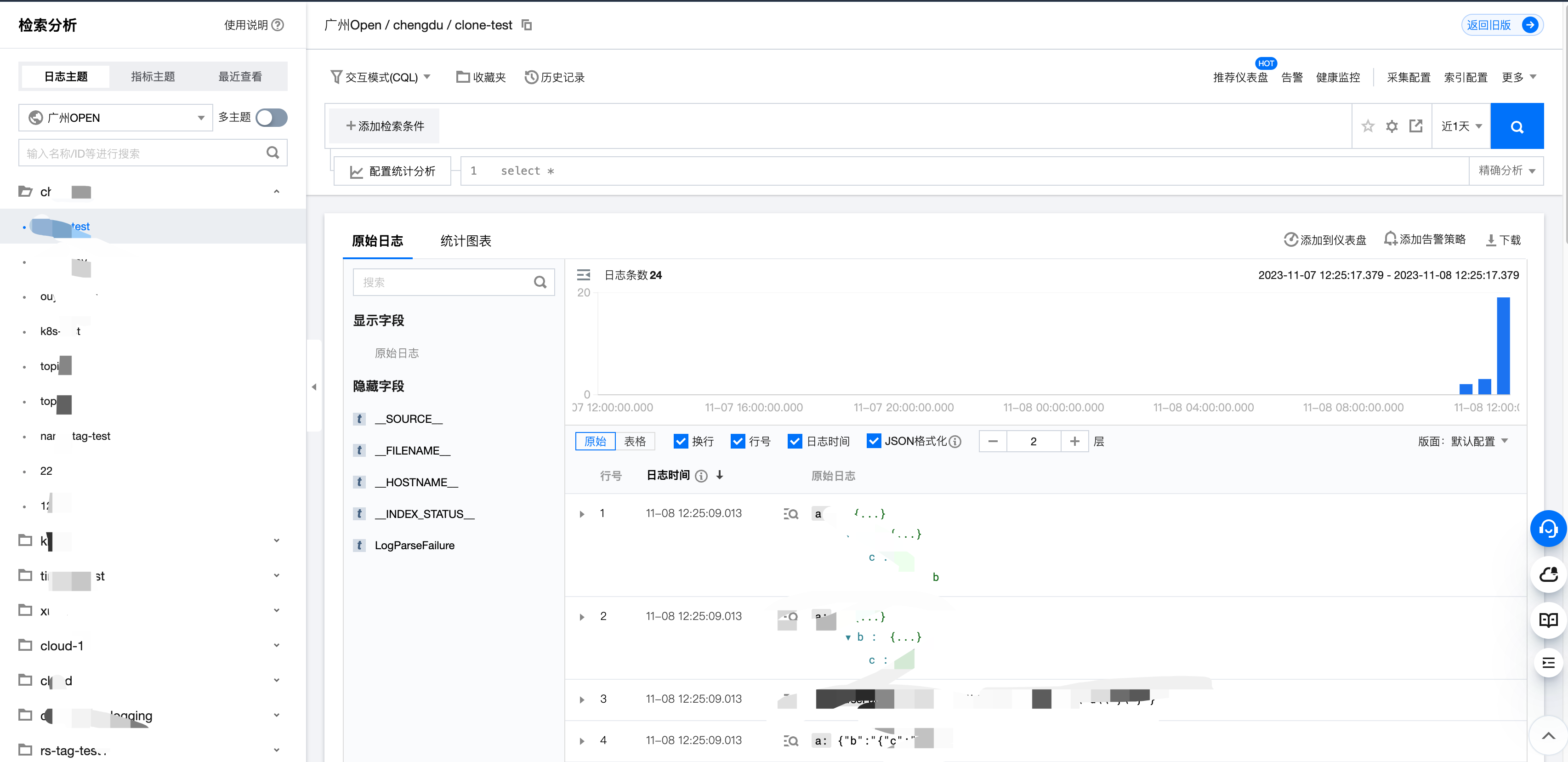

步骤5:检索日志