操作场景

腾讯云高性能应用服务 HAI 是为开发者量身打造的澎湃算力平台。无需复杂配置,便可享受即开即用的 GPU 云服务体验。HAI 的 ChatGLM3-6B 应用,预装了支持 ChatGLM3-6B 模型运行的全部环境依赖。

部署示例

本次将通过简单的示例代码,用

transfomers库加载预装的 ChatGLM3-6B 模型并进行文本生成,体验将 ChatGLM3-6B 集成到您自己的代码工作流。步骤1:释放显存

1. 登录 高性能应用服务控制台。

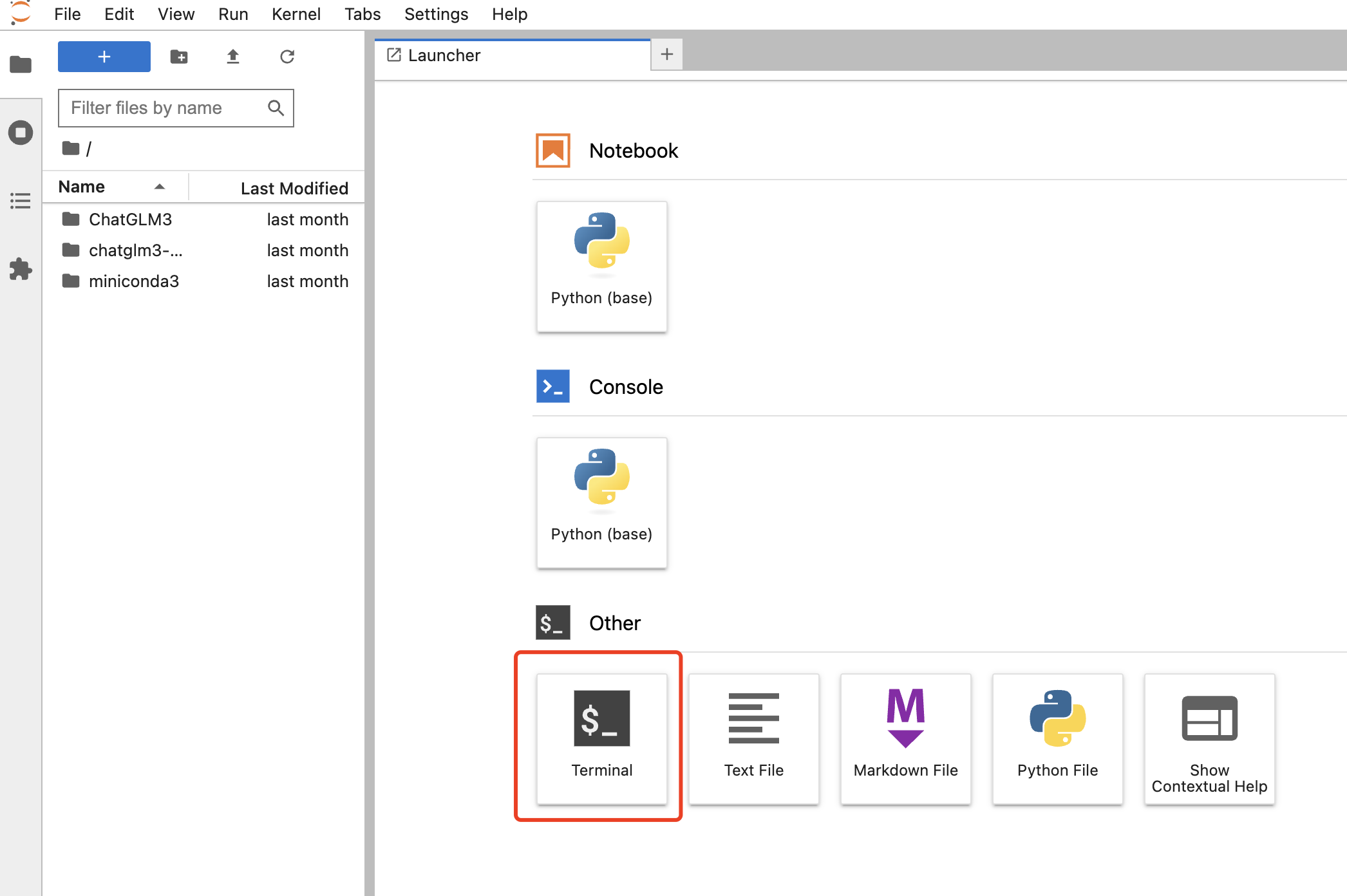

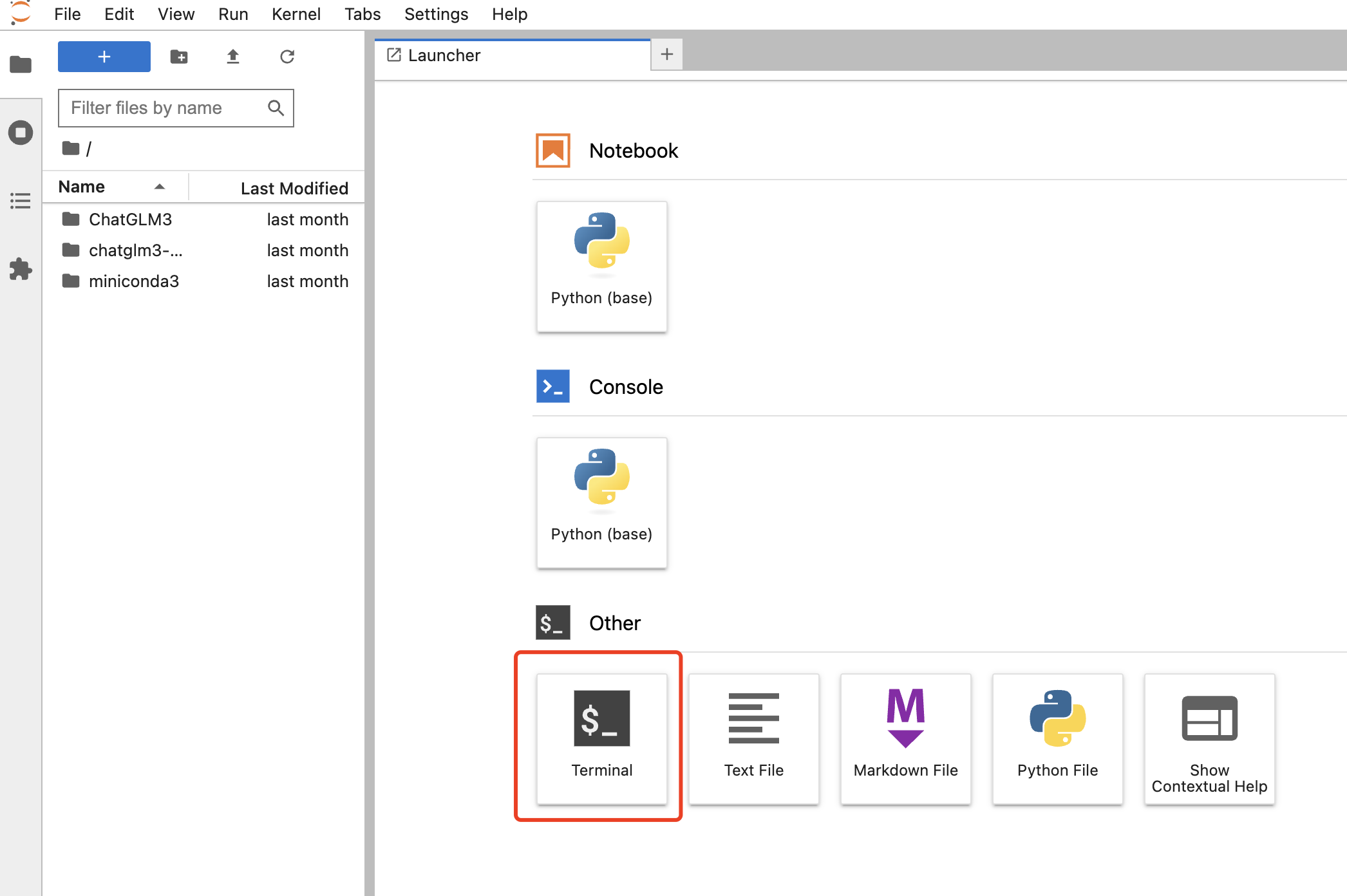

2. 在算力管理页中选择算力连接 > JupyterLab 。

3. 进入 JupyterLab ,打开终端,参见 手动中断与重启 Gradio WebUI 服务,中断 Gradio WebUI 以释放显存。

步骤2:部署实例代码

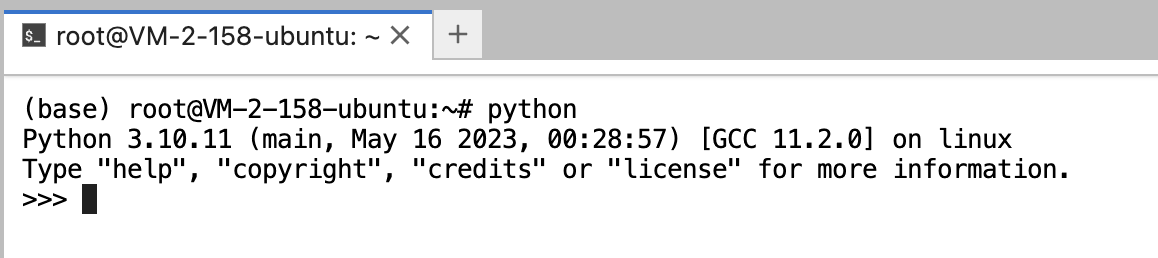

1. 在终端输入

python,进入 python 命令行。

2. 从

transformers库导入AutoModelForCausalLM和AutoTokenizer模块。>>> from transformers import AutoModelForCausalLM, AutoTokenizer

3. 导入本地预装的 ChatGLM3-6B 模型和模型分词器,模型路径为

/root/chatglm3-6b-model。>>> model = AutoModelForCausalLM.from_pretrained("/root/chatglm3-6b-model", device_map="auto", trust_remote_code=True).to("cuda")>>> tokenizer = AutoTokenizer.from_pretrained("/root/chatglm3-6b-model", padding_side="left", trust_remote_code=True)

4. 设置输入的文本,并获取文本生成的结果。

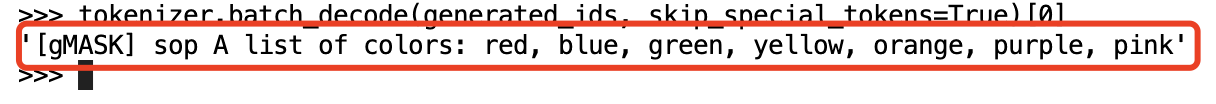

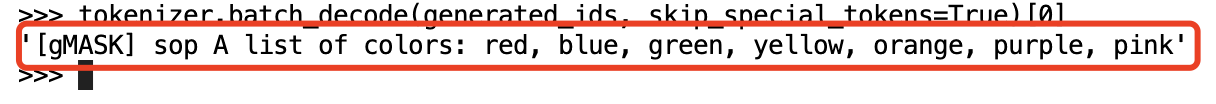

>>> model_inputs = tokenizer(["A list of colors: red, blue"], return_tensors="pt").to("cuda")>>> generated_ids = model.generate(**model_inputs)>>> tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

得到的如下输出。