多模态大语言模型框架:攻克电影配音难题,多数据集指标显著超越现有最优方法!

多模态大语言模型框架:攻克电影配音难题,多数据集指标显著超越现有最优方法!

AIGC 先锋科技

发布于 2025-05-22 11:23:23

发布于 2025-05-22 11:23:23

当前电影配音技术能够根据给定的语音 Prompt 生成所需的语音,确保语音与视觉的良好同步,同时准确传达意图中的情感。然而,在电影配音中,诸如适应不同配音风格、有效处理对话、旁白和独白等关键方面,以及理解说话者的年龄和性别等细微细节,尚未得到充分研究。为应对这一挑战,作者提出了一种多模态大语言模型框架。 首先,该框架利用多模态思维链(Chain-of-Thought, CoT)推理方法对视觉输入进行理解,以掌握配音风格和细粒度属性。其次,通过受多模态条件指导的大规模语音生成模型生成高质量的配音。此外,作者还开发了一个带有CoT标注的电影配音数据集。 评估结果表明,在多个数据集上,该框架的性能优于现有最优方法。具体而言,在V2CAnimation数据集的配音设置2.0中,SPK-SIM和EMO-SIM指标从82.48%提升至89.74%,66.24%提升至78.88%; 在Grid数据集的配音设置2.0中,LSE-D和MCD-SL指标从14.79降至14.63,5.24降至4.74;在CoT-Movie-Dubbing数据集的初始推理设置中,与现有最优模型相比,SPK-SIM指标从64.03提升至83.42,WER指标从52.69%降至23.20%。

1. 引言

配音涉及为视频中的对话添加正确的人类声音,确保与角色的唇部动作同步,并传达场景中的情感。它在电影、电视、动画和游戏中发挥着至关重要的作用,增强了沉浸感,并有效传达情感和氛围。现有的配音方法可以分为两类,这两类都专注于学习不同风格的关键先验信息以生成高质量的声音。第一类专注于学习有效的说话人风格表示[7, 15, 23, 60]。第二类旨在利用给定视频输入的视觉信息来学习适当的韵律[15, 25, 37, 70]。然而,这些先验信息的准确性不足以满足现实场景中电影配音的需求。例如,针对不同类型(如对话、旁白和独白)以及细粒度属性(如期望的年龄和性别)的自适应配音尚未得到充分研究[17, 25]。

随着具有逐步推理能力的大型语言推理模型 [2, 19, 47, 49, 52, 64] 以及通过思维链 CoT 增强推理能力以解释视觉信息的方法的快速发展,多模态语言模型 MLLM 在多模态推理和理解任务中越来越展现出其潜力, MLLM中推理能力的这些进步为准确提供配音类型和细粒度属性带来了希望。

因此,作者提出了一种用于高质量电影配音的多模态大语言模型,该模型能够有效理解配音风格和细粒度属性。首先,通过多模态思维链学习,训练多模态大语言模型以提高其推理能力,使其能更好地理解从视频输入中获取的配音类型(对话、旁白、独白)和细粒度属性。其次,使用多模态条件设计了控制机制,训练大型多模态语音生成模型。第三,作者创建了一个标注了逐步推理指令的CoT多模态电影配音数据集。

2. 相关工作

2.1. 视觉语音克隆

当前先进的配音技术通过整合视觉和文本信息显著提升了语音与视频同步性及情感表达。部分研究聚焦于改进说话人身份以处理多说话人场景[14, 16, 17, 69]。例如Speaker2Dub[69]通过可学习的风格仿射变换将预训练GE2E提取的说话人嵌入引入音素编码器和梅尔频谱图解码器,而StyleDubber[17]提出了一种具有音素和语句层级的多尺度风格 Adapter 以强化说话人特征。此外,一些研究尝试结合视觉表征以增强韵律表现力[14, 25, 37, 70]。例如HPMDubbing[14]是一种分层配音方法,将声学细节与视觉信息(唇部动作、面部区域和场景)相连接:为改善上下文韵律,MCDubber[70]将建模目标从单句扩展至前后句,融入更多上下文视频场景。尽管说话人身份和韵律建模已获关注,现有工作仍存在唇部同步差和情感表达呆板的问题,这在配音中是不可接受的。

2.2. 流程匹配语音生成

流匹配[41]是一种无需模拟的方法,用于训练连续归一化流(CNFs)[8]模型,这些模型能够模拟任意概率路径并捕获由扩散过程[59]表示的概率轨迹。由于其高采样速度和生成质量的优势,流匹配在语音生成[21, 36, 45]领域引起了广泛关注。

最近,MatchaTTS[45]和DiTTo-TTS[38]引入了最优传输条件流匹配(OT-CFM)用于训练,该技术基于常微分方程(ODE)的解码器来提高梅尔频谱图的保真度。此外,F5TTS[9]利用扩散Transformer与ConvNeXt V2[63]来更好地处理文本-语音对齐问题,从而在情境学习过程中取得更好的效果。然而,这些工作在TTS领域存在局限性,无法应用于V2C任务。因此,作者研究了将MLLM推理模型与TTS技术结合应用于V2C任务的方法。

2.3. 思维链推理

视觉推理要求模型具备视觉感知能力和High-Level认知能力[34, 44]。已有多种任务被用于评估视觉语言模型(VLMs)的视觉推理能力,包括要求模型回答视觉内容和文本问题的视觉问答(VQA)[32, 40],以及要求模型判断文本描述与视觉内容一致性的视觉蕴涵[1, 12, 58]等。随着大语言模型(LLMs)的发展,视觉语言模型利用LLMs的先进推理能力来解释视觉任务[42, 67]。

一些视觉语言模型通过优化视觉编码策略[22, 26, 31, 42, 68, 72]来生成以认知为中心的视觉 Token ,从而增强视觉推理能力。随着具有逐步思考能力的大型语言推理模型的快速发展[2, 19, 47-49, 52, 64],视觉语言任务通过逐步推理被研究应用于多种多模态大语言模型。然而,逐步推理机制在电影配音领域尚未得到充分研究,因此,作者提出了DeepDubbber,一种具有内部多模态思维链推理指导的电影配音模型。

3. 方法

3.1. 概述

给定一个无声视频片段 、相应的字幕 P 以及生成完整配音视频的目标,所提出的模型(DeepDubber)旨在借助 MLLM 生成与视频匹配的语音 ,确保上下文和韵律的相关性,并保持语音与视频的同步性。该模型可形式化为如下:

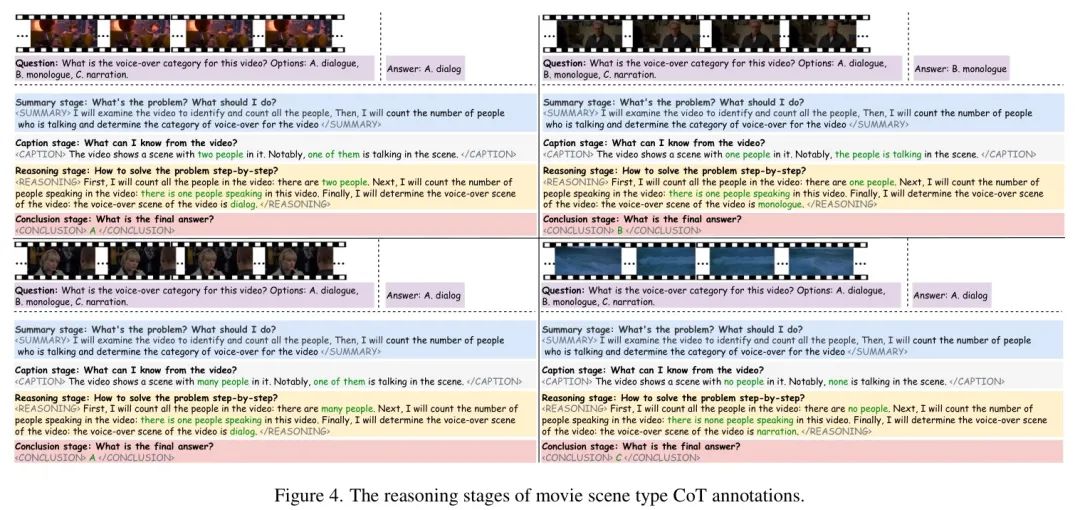

DeepDubber由两个建模阶段组成:i) 通过情境学习和混合偏好优化进行多模态推理和理解。ii) 语音生成阶段:该阶段采用基于条件DiT的语音生成器。

3.2. 基于MLLM的多模态思维链学习

3.2.1. 阶段1.1:通过监督学习训练多模态思维链

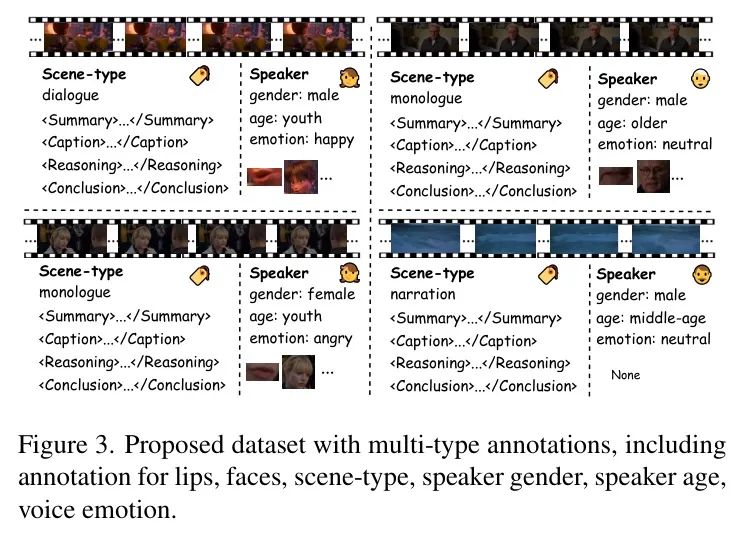

DeepDubber的核心功能是从视觉流中提取对配音过程至关重要的关键语义特征。这些特征包括场景类型、说话者性别、说话者年龄和说话者情绪,这些特征逐步推理,如图4所示。受MLLM(如VLMs[42,62,65])成功的启发,作者利用多模态指令微调来增强CoT推理,从而提高电影配音的质量。CoT推理过程如下所述:

其中 表示输入的视频片段,Instruct 表示提供给推理过程的第 个指令, 是表示使用 MLLM 进行多模态 CoT 推理的第 步的函数, 和 是推理过程中的中间输出,其中 CCoT 是第一次 CoT 推理的结果,而 是通过问答(QA)步骤获得的。

为优化模型的响应生成,其中 表示执行CoT推理和问答的多模态大语言模型, 是输入的视频片段,CoTinstruction和 分别是指导CoT推理和问答过程的指令,Response是模型生成的输出,D表示训练数据集的分布,Oresponse表示需要优化的模型参数, 是衡量模型预测响应与真实响应Responsegt之间差异的损失函数。这种方法确保MLLM能够有效对多模态输入进行推理,通过结构化的逐步推理促进高质量的字幕制作。

3.2.2. 阶段1.2:通过强化学习训练多模态思维链

奖励是决定RL优化方向的训练信号来源。为了训练CoT-MLLM,作者采用基于规则的奖励系统,如Deepseek-R1 [19],该系统主要由两种类型的奖励组成:准确率奖励和格式奖励。作者采用格式奖励模型,强制模型将其推理过程置于、<CAPTION

/CAPTION>、和<CONCLUSION

标签之间。作者使用混合偏好优化(MPO)[62]方法来学习成对响应之间的相对偏好,并增强MLLM在不同指令下的推理能力。混合偏好优化进一步提升了多模态CoT推理的能力。训练目标是如下所示。

训练目标。MPO目标结合了三个损失分量和F&O奖励:偏好损失、质量损失、生成损失、格式损失和准确率损失。总损失公式表述为:

其中 表示每个损失的权重。作者使用DPO [55] 处理偏好损失,使用BCO [10] 处理质量损失。这三个损失项的详细表示如下:

偏好损失。DPO [55] 损失在不依赖奖励模型的情况下,对所选响应与被拒绝响应之间的相对偏好进行建模。损失函数为:

其中 是KL惩罚系数, 是用户 Query , 是选择的回复, 是拒绝的回复,而 是从 初始化的策略模型。质量损失。BCO [10] 损失使用二元分类器测量单个回复的绝对质量。总损失为:

所选择和舍弃的损失项为:

并且 是为了稳定训练而引入的奖励偏移。

生成损失。SFT损失有助于模型学习生成期望的响应。损失定义为:

格式奖励。格式损失有助于模型学习生成期望的格式。损失定义为:

:格式是否正确,:模型预测格式正确的概率。

结果奖励。准确率损失有助于模型学习生成期望的答案。损失定义为:

: 答案是否正确, : 模型预测格式正确的概率。

3.3. 多条件语音生成

3.3.1. 语音生成基础预训练

在DeepDubber的第二阶段,作者首先训练基础语音生成模型。为了优化这一过程,作者旨在通过最小化复合条件流匹配(CFM)损失来学习参数。作者采用了与F5-TTS [9]相同的架构,该架构以扩散Transformer(DiT)作为 Backbone 。该模型使用CFM目标 [41]进行训练,以输出向量场,其定义为:

其中 表示时间 时的概率路径, 是为 指定的矢量场, 是对应训练数据的随机变量, 表示训练数据的分布。通过优化 ,模型学习生成与视觉和文本线索同步的高质量语音,确保自然且符合上下文的配音效果。

3.3.2. 基于多条件调优的语音生成

接下来,在ControlNet-transformer调优阶段,视频帧以及一条指令被作为输入输入到MLLM模型中。随后,视频特征序列和视频理解结论被结合并传递到语音生成模型中。在此背景下,提供的结论有助于指导V2S生成过程,如图2的2.2阶段所示。所提出的语音生成模型以脚本、静音视频、视频理解结论以及可选的参考语音作为输入,生成视频对齐的语音上下文序列,这可以描述为:

生成器

其中 是 的组合,,表示场景类型条件 、说话人性别条件 、说话人年龄条件 和说话人情绪条件 。这些条件被组合并由编码器 [56] 进行编码。 表示从输入视频帧中提取的视觉特征,这些特征由 CLIP [53] 进行编码。作者实现了一种交叉注意力机制,以促进理解结论特征 和视觉特征 的整合。此外, 表示嵌入的脚本。此外,作者添加了时长相似度损失 来约束时长的连贯性,其描述如下:

最终的损失函数构建如下:

在训练阶段,视觉条件 、视频理解结论条件 和视频脚本条件 各以 的概率设置为 。将无分类器引导从脚本条件扩展到视觉输入和视觉理解,可提升条件控制精度和语音质量。引导尺度 、 和 分别对应视频片段、视频结论和视频相关脚本,用于衡量采样结果与条件之间的对齐程度。受 [33] 启发,推理阶段的改进速度估计如下:

4. 实验

4.1. 数据集

Emilia [24]是一个包含六种语言的综合性多语种语音生成数据集,总时长为101,654小时。该数据集中英语部分约46,800小时,用于训练作者的基础语音合成模型。

V2C-Animation [6] 是一个专门用于动画电影配音的专用数据集,包含来自26部电影的10,217个片段,具有同步的文本、语音和视频。该数据集分为60%用于训练,10%用于验证,30%用于测试。

GRID是一个用于多说话人配音的配音基准[18]。整个数据集包含33个说话人,每个说话人有1000个短英语样本。所有参与者均在录音棚中录制,背景统一。训练数据和测试数据数量分别为32,670和3280。

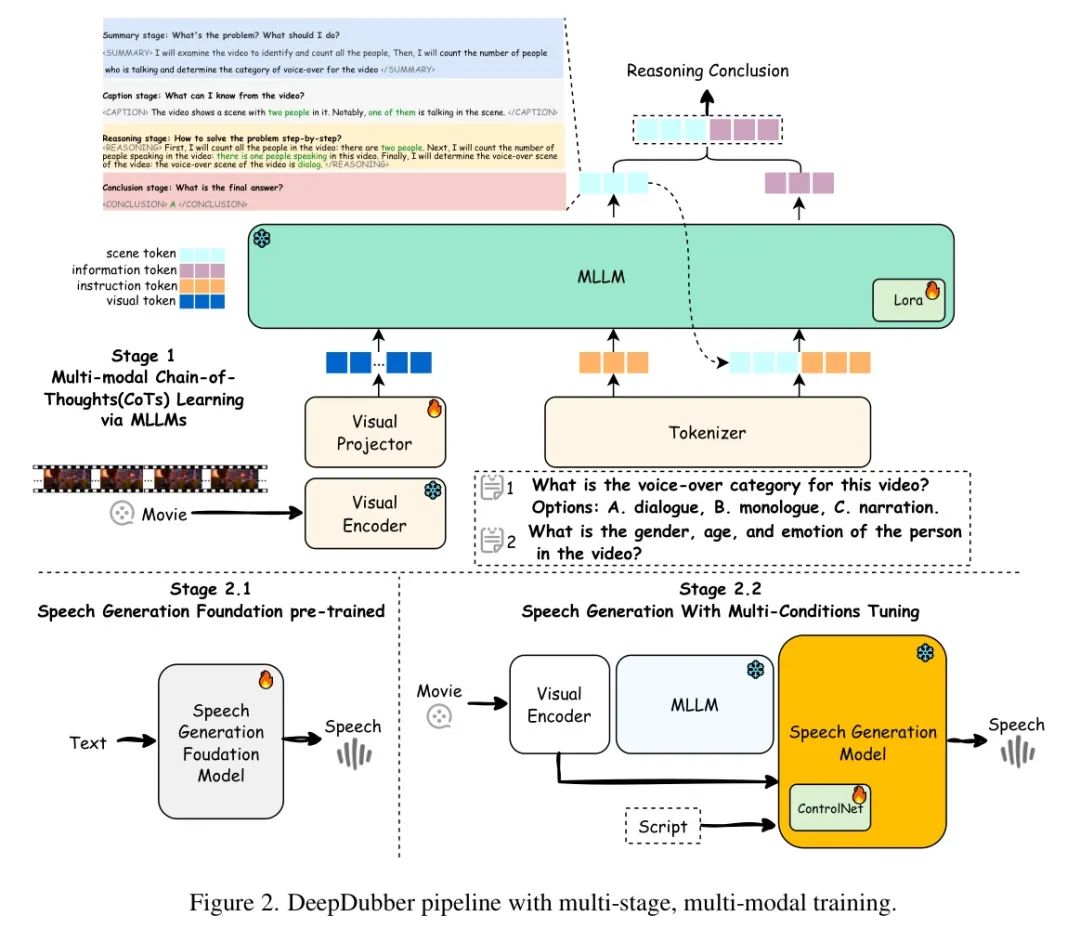

思维链电影配音数据集。作者构建了一个7.2小时的多模态思维链电影配音数据集,用于生成高质量和准确的电影配音。基于思维链推理和思维链式指导[65],作者利用专业的标注团队对以下数据集进行标注。作者开发了一个思维链推理框架,以指导后续的电影配音任务,如图3和图4所示。具体而言,作者设计了一个带视频输入的逐步指令过程,以实现高效和准确的电影场景类型分类。如图4所示,

提供了整个场景的High-Level概述,而描述了视频中的角色。在阶段,推理过程分为四个步骤:

第一步 计算视频中的人数。第二步 判断视频中的人是否在说话。第三步 判断电影是否包含对话、旁白或独白。

步骤4 结论并给出答案

然后<CONCLUSION /CONCLUSION>阶段给出最终答案。每个阶段由模型自行启动,无需外部 Prompt 工程框架或额外 Prompt 。具体而言,作者向模型提供四对特殊标签,这些标签分别对应于总结响应方法、描述相关图像内容、进行推理以及准备最终答案。所提出的数据集包含两部分

难度等级: (1) 等级-1,视频中有人说话,包括7,276个视频片段用于训练和1,100个视频片段用于测试。 (2) 等级-2,视频中动物说话,包括3,486个视频片段用于训练和388个视频片段用于测试。值得注意的是,由于OpenAI的微调政策,所有等级-1的视频片段已被过滤,目前仅保留328个视频片段用于等级-2的训练。

基于预训练的SyncNet模型[13]。在主观评价方面,作者进行人类对自然度(NMOS)和相似度(SMOS)的均值意见分数(MOS)评价,采用1至5分的评分标准,并给出95%置信区间。遵循[69]的方法,参与者对每个测试集中随机选取的30个语音样本的配音质量进行评价。

4.2. 评估指标

作者使用客观和主观指标进行评估。为评估发音准确性,作者采用Whisper-V3 [54]作为语音识别模型,并使用单词错误率(WER)进行评估。音色一致性通过说话人编码器余弦相似度(SPK-SIM)[17]进行评估。作者还计算了梅尔倒谱失真动态时间规整(MCD)和语音长度方差(MCD-SL)[3],以评估频谱和长度差异。情感相似度(EMO-SIM)通过语音情感识别模型 [66]进行评估。为与视频同步,作者在Grid基准上使用唇同步误差距离(LSE-D)和唇同步误差置信度(LSE-C)指标。

4.3. 基准测试结果

作者将llm-DeepDubber-V1_2503与一个TTS模型[9]以及三个最近提出的视频配音模型进行比较。HPMDubbing[14]引入了一种情感韵律 Adapter ,能够实现说话者情感的细粒度对齐。另一方面,StyleDubber[17]设计了一种多模态音素级风格 Adapter ,根据面部表情生成风格化的语音音调。Speaker2Dubber[69]结合了角色情感、音素韵律和唇部运动,以确保配音过程中韵律和时长的整体一致性。

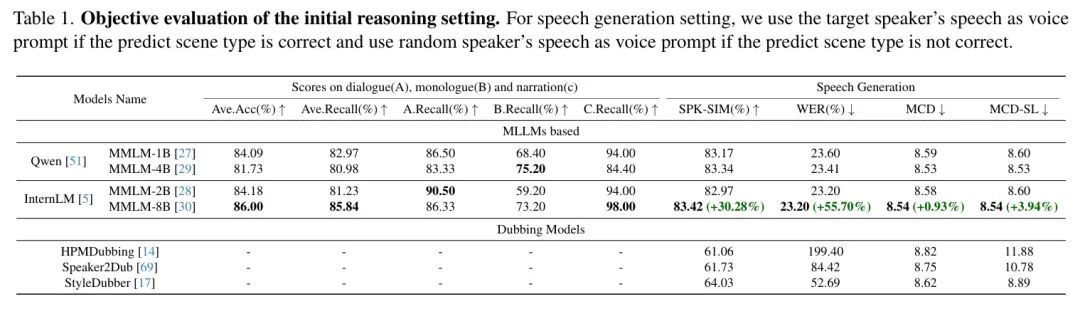

电影场景类型推理与语音生成结果。如表1所示,MMLM-8B在电影场景类型分类的所有基准测试中均取得了优异的性能。llm-DeepDubber-V1_2503在SPKSIM、WER和MCD/MCD-SL上优于SOTA配音方法(StyleDubber和Speaker2Dub)。具体而言,SPK-SIM从64.03%提升至70.83%,WER从52.69%下降至27.68%。此外,如图3所示,MMLM-8B保持了具有竞争力的性能,略低于GPT-4o [46]。这些结果表明,作者多模态推理阶段的有效性在提升多模态电影配音性能方面发挥了作用。

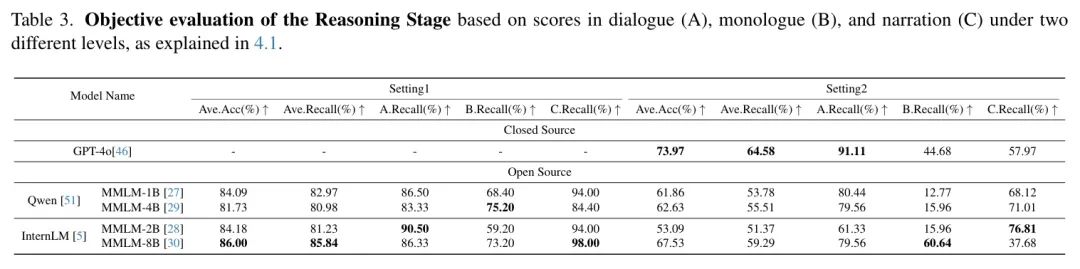

表3. 基于对话(A)、独白(B)和叙述(C)在两个不同水平下的推理阶段客观评估得分,如4.1所述

V2C-Animation基准测试结果。如表3所示,与现有最优模型[14, 17, 69]相比,在作者的相同设置[69]下,llm-DeepDubber-V1_2503在各项评估指标上均取得了改进。llm-DeepDubber-V1_2503在所有指标上均实现了最佳性能。具体而言,SPK-SIM从79.81%提升至83.30%,EMO-SIM从59.71%提升至64.93%,MCD从9.11降至8.80,WER从26.48%降至24.71%。这表明llm-DeepDubber-V1_2503在发音准确性和语音时长一致性方面均实现了性能提升。

在GRID基准测试上的结果。如表4所示,llm-DeepDubber-V1_2503在GRID基准测试上实现了与当前最先进模型[69]相同的评估方法下最佳唇同步性能,该性能从14.79下降到14.63。MCD也从4.95下降到4.73。与V2C-Animation不同,GRID中的样本是在录音棚环境中录制的,不涉及夸张的韵律变化或背景噪声。因此,所有对比方法在GRID上的WER(词错误率)通常优于V2C-Animation。如表4所示,llm-DeepDubber-V1_2503在GRID基准测试上实现了最佳唇同步性能。此外,llm-DeepDubber-V1_2503在WER方面也取得了具有竞争力的结果,略低于最佳微调F5-TTS模型、Speaker2Dub和StyleDubber。然而,这些模型的WER结果(分别为11.94%、12.11%和11.97%)超过了真实WER结果(13.67%),表明其可懂度已达到可接受水平。

人类范围

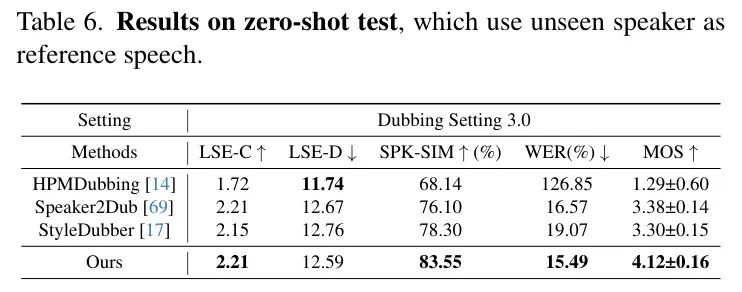

零样本测试结果。如表6所示,该设置使用未见过说话人的语音作为参考语音来衡量配音模型的泛化能力[69]。在此,作者使用来自GRID的语音作为参考语音来衡量V2C。作者在相同的评估设置下,与最先进模型[69]一起比较LSE-C/D、SPK-SIM和WER,以及主观评价。如表6所示,llm-DeepDubber-V1_2503在SPK-SIM和WER方面均优于StyleDubber和Speaker2Dub。具体而言,SIP-SIM从78.30%提高到83.55%,WER从16.57%降低到15.49%。此外,所llm-DeepDubber-V1_2503在语音-视觉同步方面(参见LSE-C和LSE-D)仍保持具有竞争力的性能,略低于HPMDubbing。

4.4. 消融实验

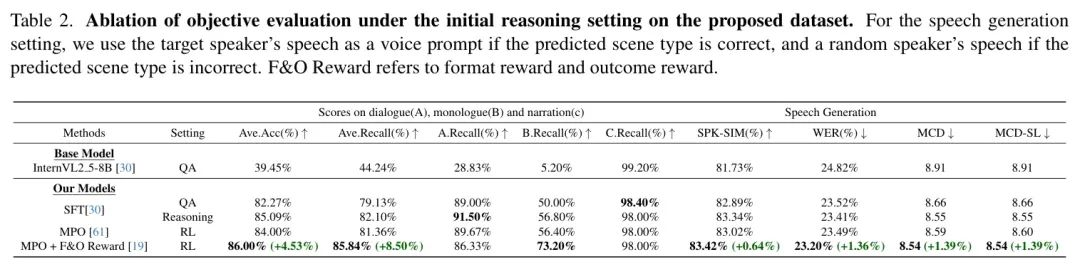

推理阶段的消融实验。为了比较SFT、MPO和带有F&O奖励的MPO对提升多模态推理能力的影响,作者使用构建的CoT和QA对作为训练数据来微调InternVL2-8B。如表2所示,结果表明,使用带有F&O奖励的MPO训练的模型始终优于使用Zeroshot、SFT和MPO训练的模型。例如,带有F&O奖励的MPO训练模型在电影场景推理基准测试中达到了的acc,比SFT(QA)训练模型高出。此外,带有F&O奖励的MPO训练模型在每个类别的召回率上也表现更好。

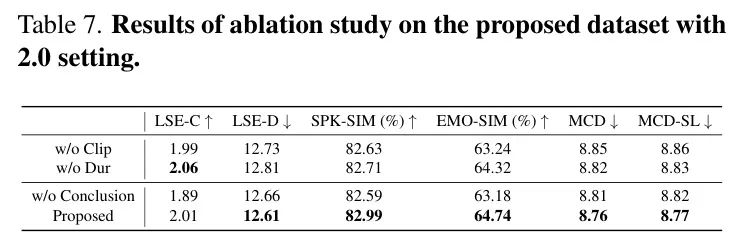

语音生成消融实验。表7中的消融结果表明每个条件都对整体性能有所贡献。移除视频片段控制会导致所有指标显著下降,突显其在语音视频对齐中的重要性。添加视频理解结论控制可以提高SPK-SIM和EMO-SIM。此外,移除时长预测器导致LSE-D性能下降最大,强调学习时长 Level 的连续性对于同步语音和视频至关重要。此外,在MMLM结论条件下,SPK-SIM和EMO-SIM分别提高了0.4%和1.56%,证明了多模态推理阶段在提升多模态电影配音性能方面的有效性。

5. 结论

在本文中,作者提出了一种多阶段、多模态的大型语言框架,该框架由两阶段模型和相应的多阶段训练策略组成,旨在提升电影配音中的初始推理能力。此外,作者还创建了一个带有思维链标注的对应电影配音数据集。

在评估中,结果表明与现有最优方法相比,在多种数据集上均取得了性能提升。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2025-05-21,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录