使用 HAI 一键上云部署 Deepseek-R1 大模型

原创背景

DeepSeek-R1 是中国人工智能初创企业 DeepSeek 推出的一款以“推理”能力为核心的开源大语言模型。它不仅在数学、编程和自然语言推理等任务上表现出色,而且在开发成本和运算效率上远低于欧美同类产品,成为业界关注的焦点。

快速使用

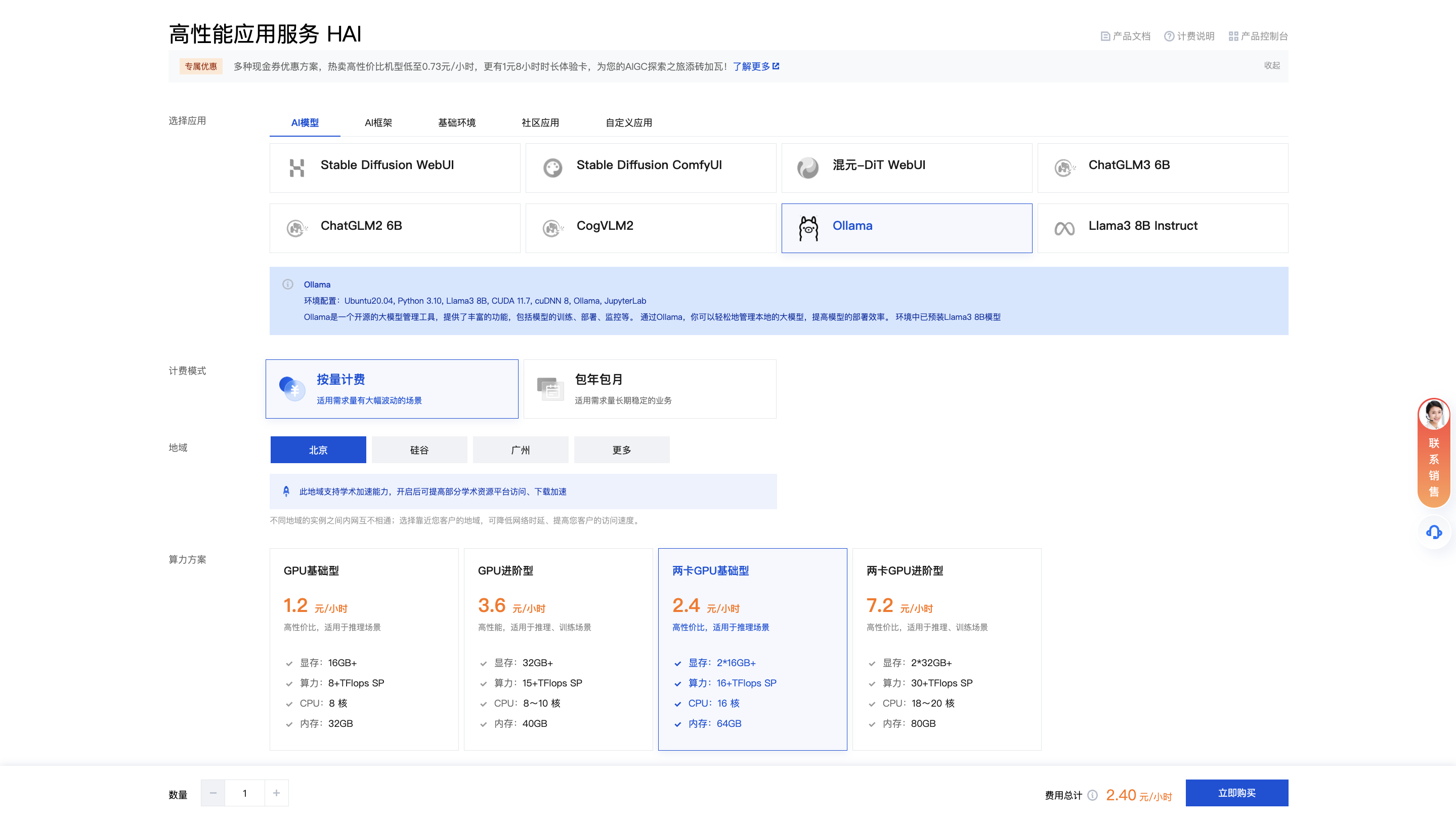

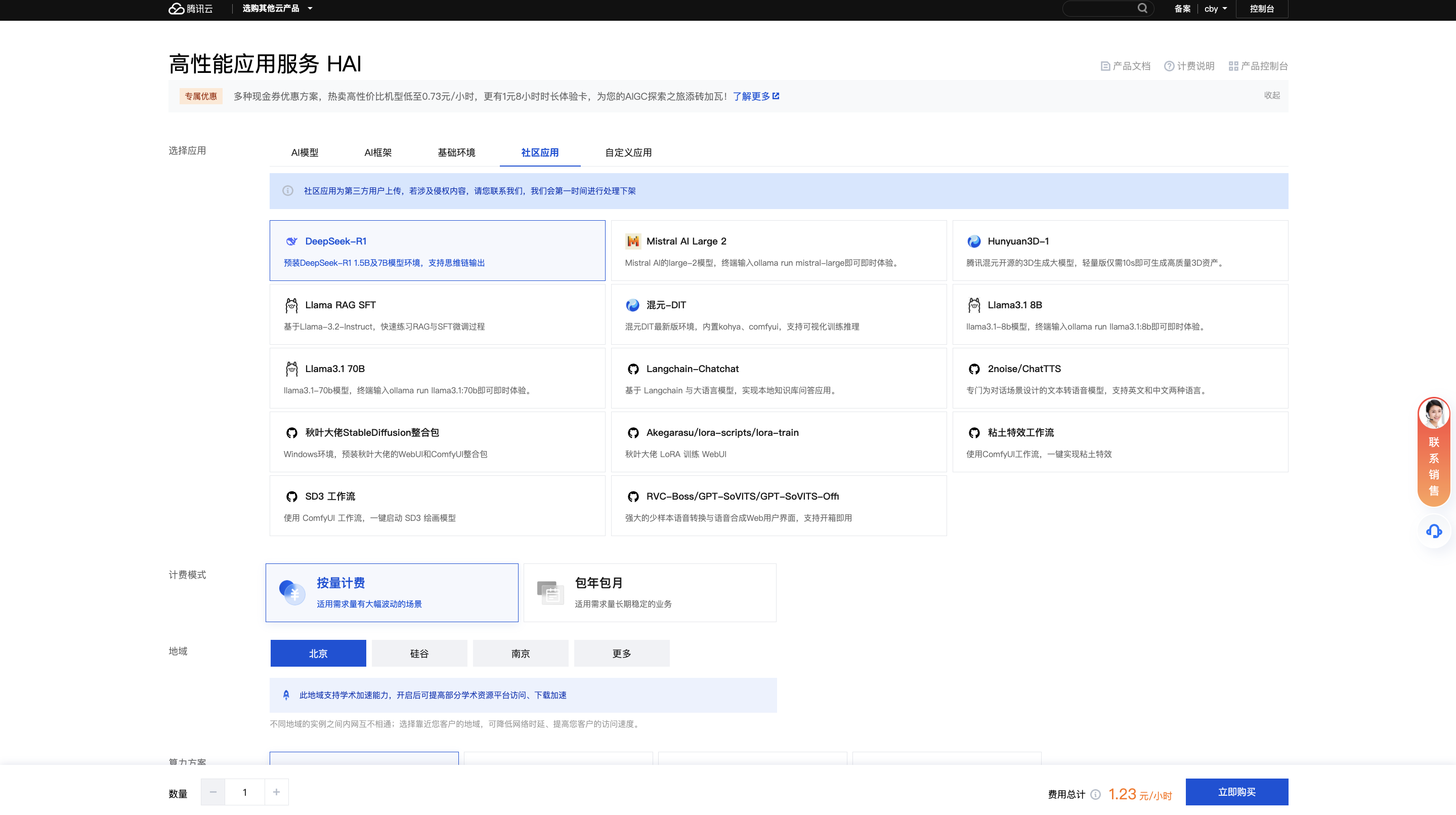

在 HAI 的购买页(https://buy.cloud.tencent.com/hai)中选择Ollama环境。Ollama是一个开源的大模型管理工具,提供了丰富的功能,包括模型的训练、部署、监控等。

我这里选择了俩张 GPU 卡的环境。选好之后点击“立即购买”即可。 腾讯云的 HAI 每台实例免费提供500GB流量包,默认10Mbps带宽。

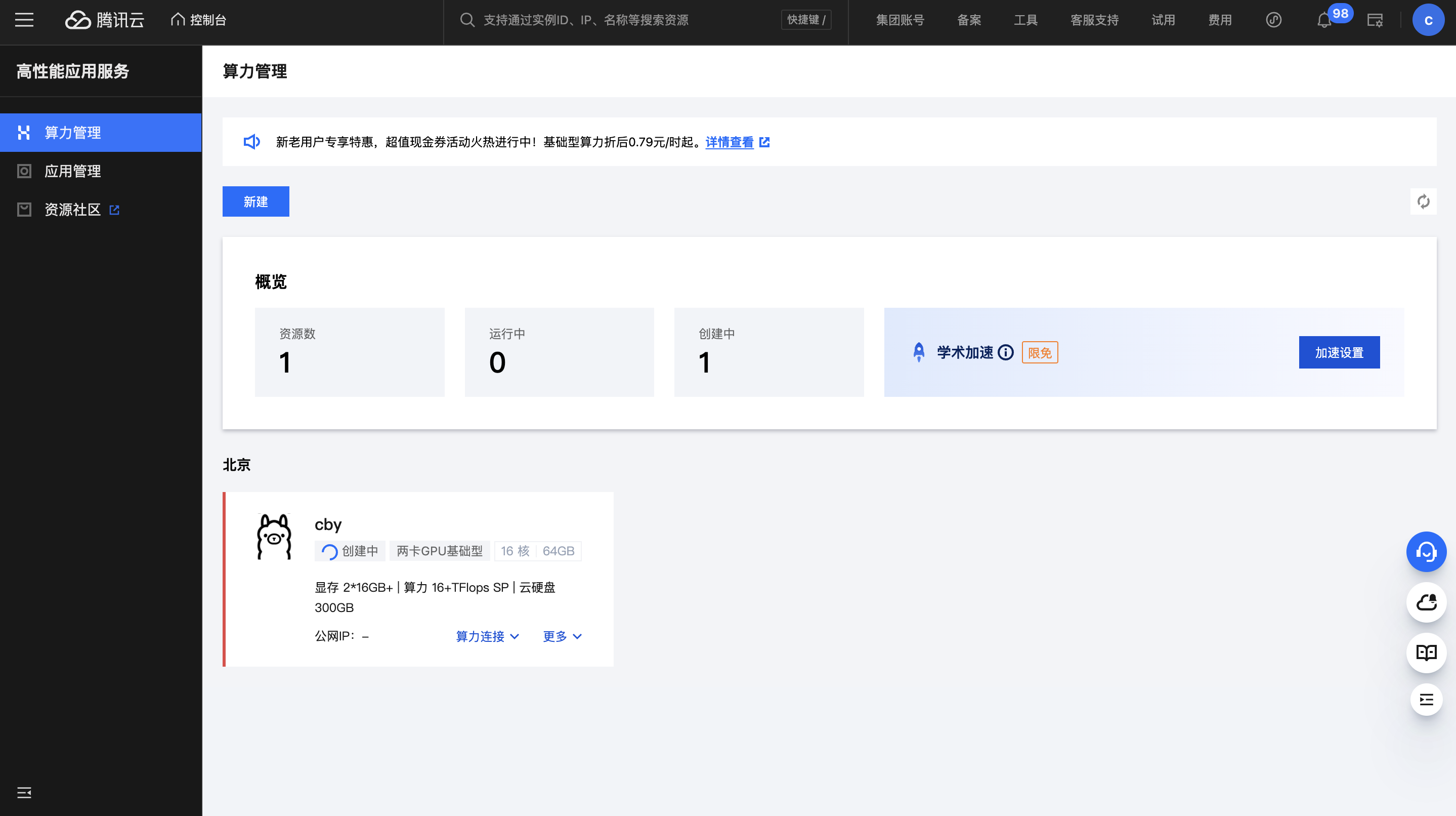

等待环境创建完毕即可。

登录环境

在创建完毕后,可以修改一下 root 密码。

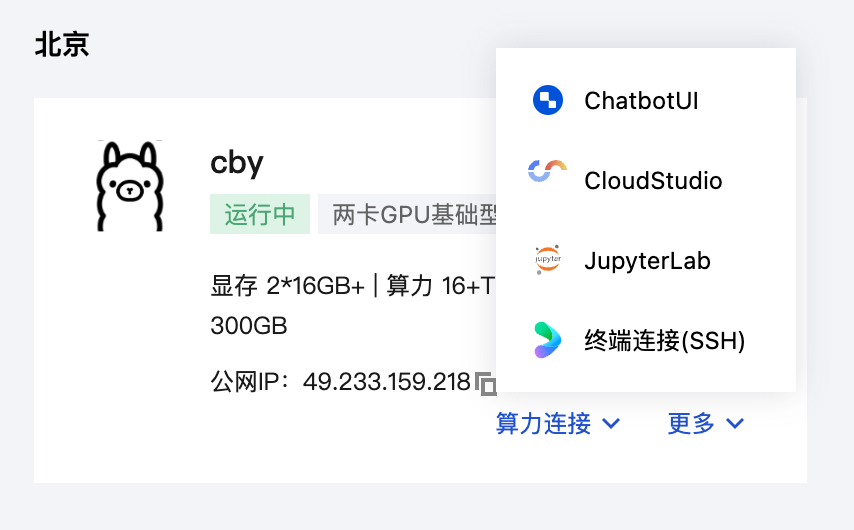

这时就可以通过 ssh 去进行链接,这里有公网地址,你也可以通过公网地址访问,也可以通过腾讯云自带的网页连接工具进行登录服务器环境。

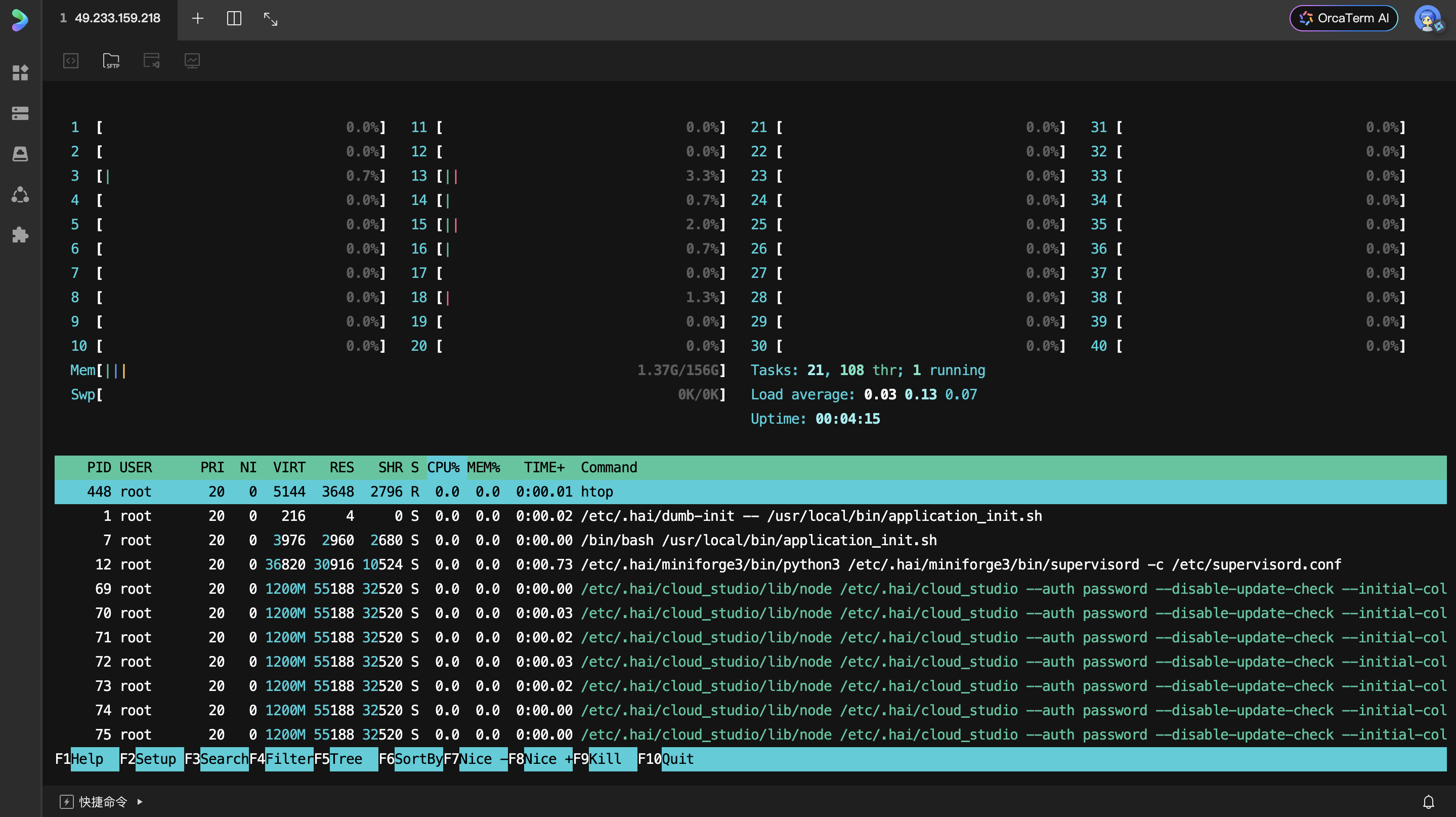

这里在登录之后,查看了一下配置,有 40C 156G 的环境。

运行其他参数的 DeepSeek

可以通过这些命令运行不同参数的大模型环境。

# 1.5B Qwen DeepSeek R1

# 所需空间大约 1.1G

ollama run deepseek-r1:1.5b

# 7B Qwen DeepSeek R1

# 所需空间大约 4.7G

ollama run deepseek-r1:7b

# 8B Llama DeepSeek R1

# 所需空间大约 4.9G

ollama run deepseek-r1:8b

# 14B Qwen DeepSeek R1

# 所需空间大约 9G

ollama run deepseek-r1:14b

# 32B Qwen DeepSeek R1

# 所需空间大约 20G

ollama run deepseek-r1:32b

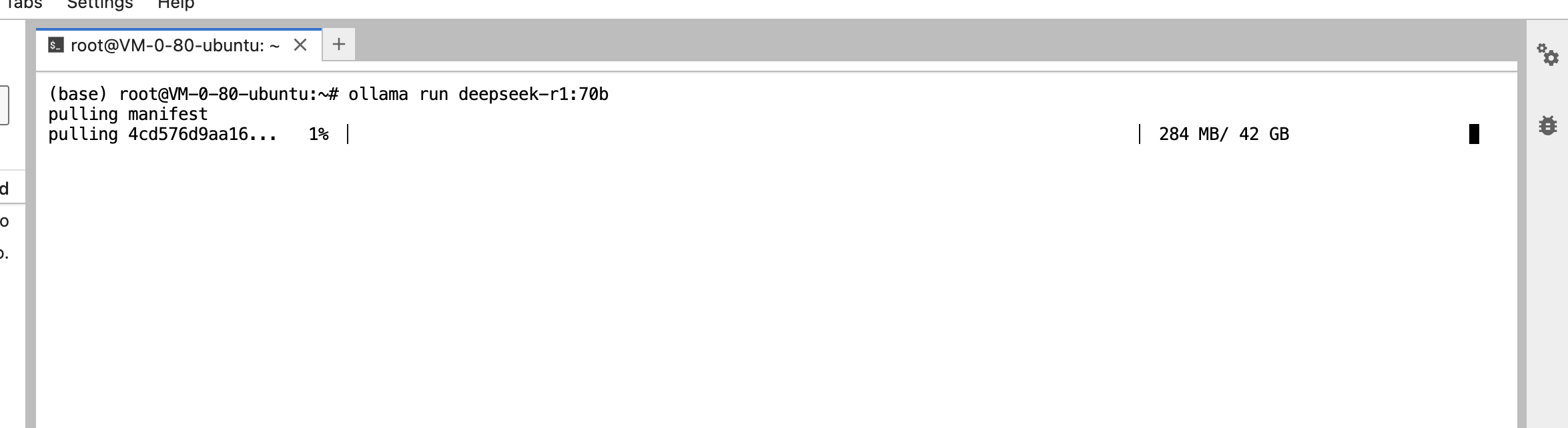

# 70B Llama DeepSeek R1

# 所需空间大约 43G

ollama run deepseek-r1:70b

# 671B Llama DeepSeek R1

# 所需空间大约 404G

ollama run deepseek-r1:671b使用社区模型

腾讯云的 HAI 自带了很多模型,也可以在“社区应用”中选择 DeepSeek 大模型,这样即可开箱即用。付款完成后即可直接使用,无需执行部署命令。

开箱即用

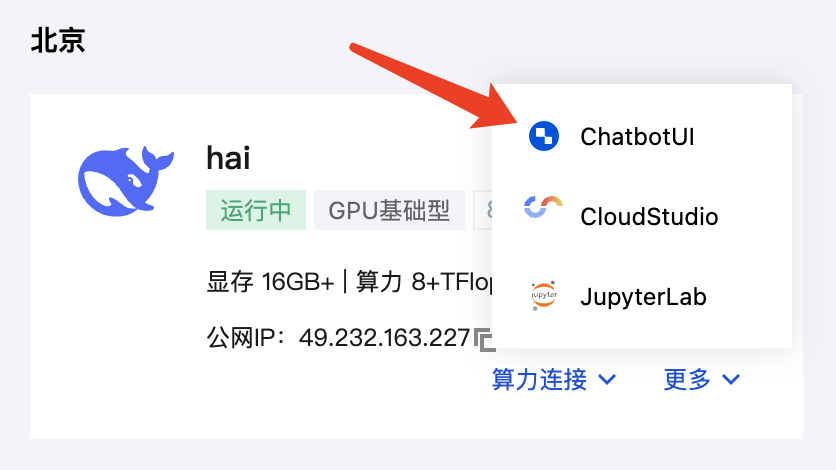

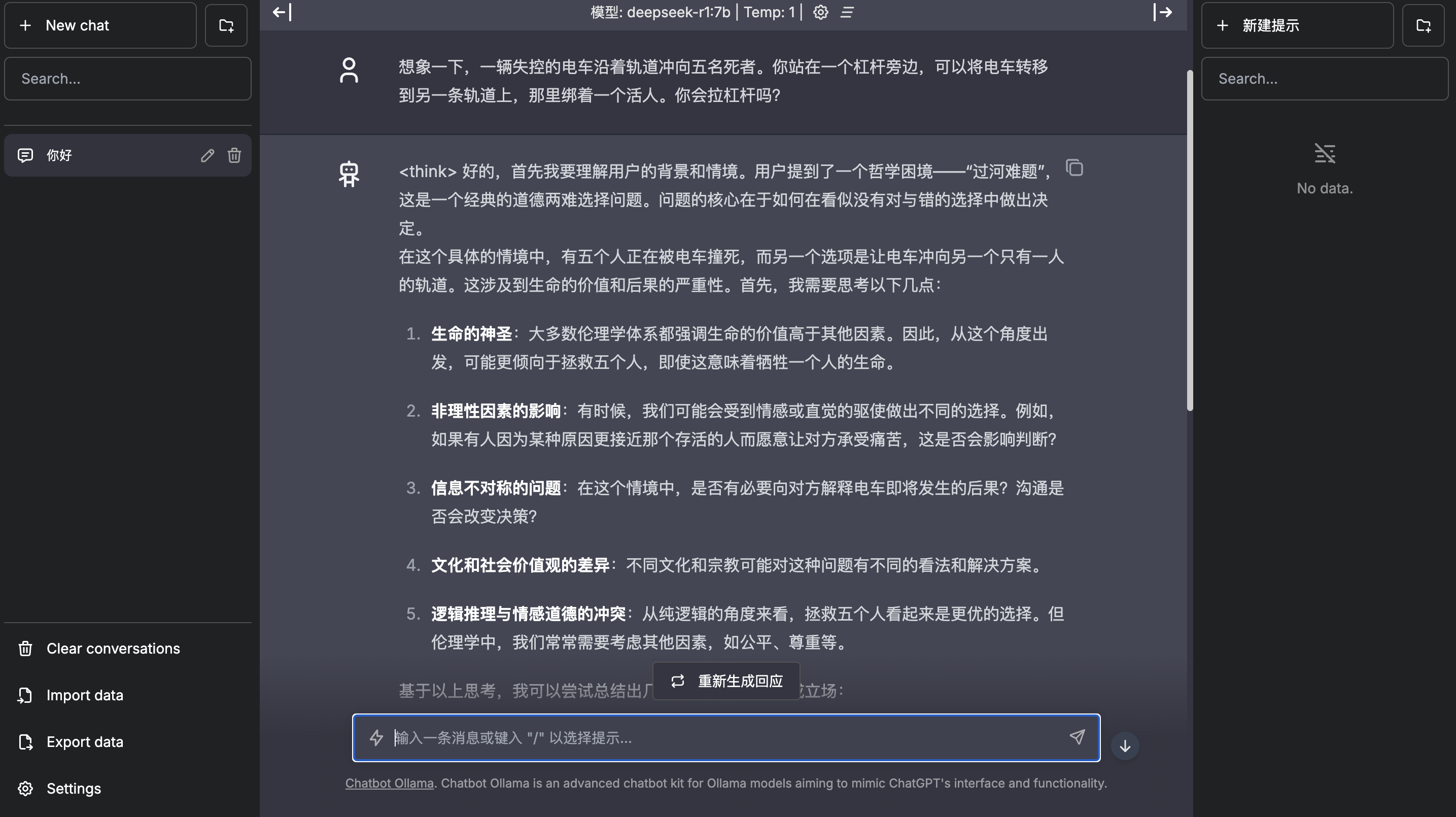

使用 ChatBotUI 链接即可

在这里直接提问即可使用模型进行回答问题

命令行登录

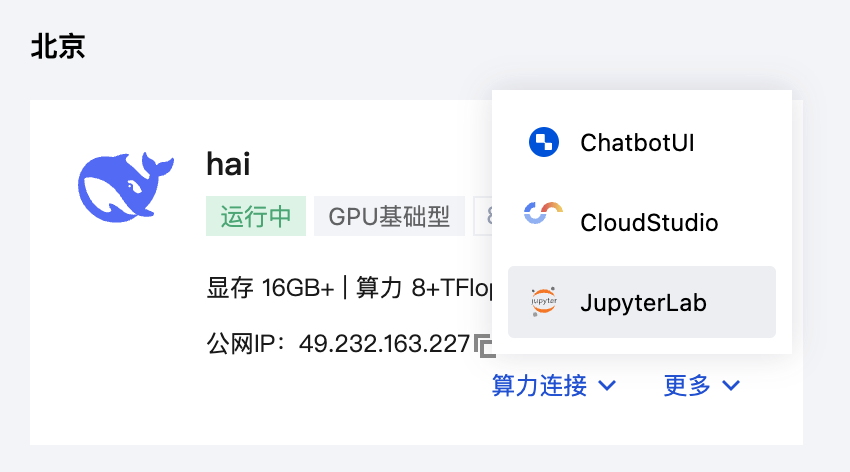

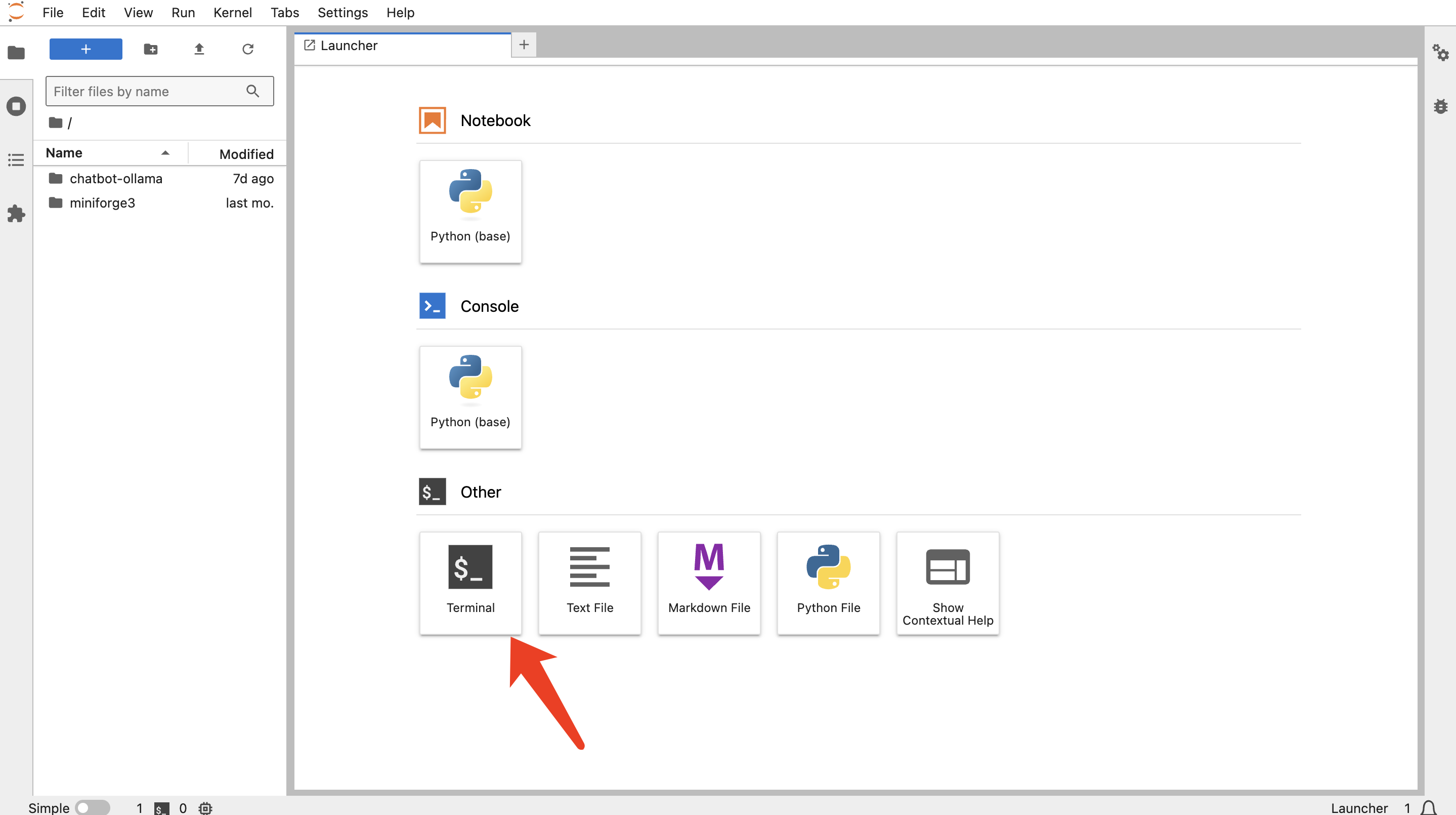

若自带的模型觉得不够用的话,也可以通过 JupyterLab 登录命令行执行相关命令。

执行您所需的命令即可。

关于

https://www.oiox.cn/index.php/start-page.html

CSDN、GitHub、51CTO、知乎、开源中国、思否、掘金、简书、华为云、阿里云、腾讯云、哔哩哔哩、今日头条、新浪微博、个人博客

全网可搜《小陈运维》

文章主要发布于微信公众号

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录